揭秘Hadoop分布式计算框架:原理、架构与高可用性

分布式计算框架Hadoop是Apache软件基金会开发的重要工具,用于大规模并行处理和分布式文件存储。其主要由Hadoop Common、Hadoop Distributed File System (HDFS) 和 MapReduce 架构组成。

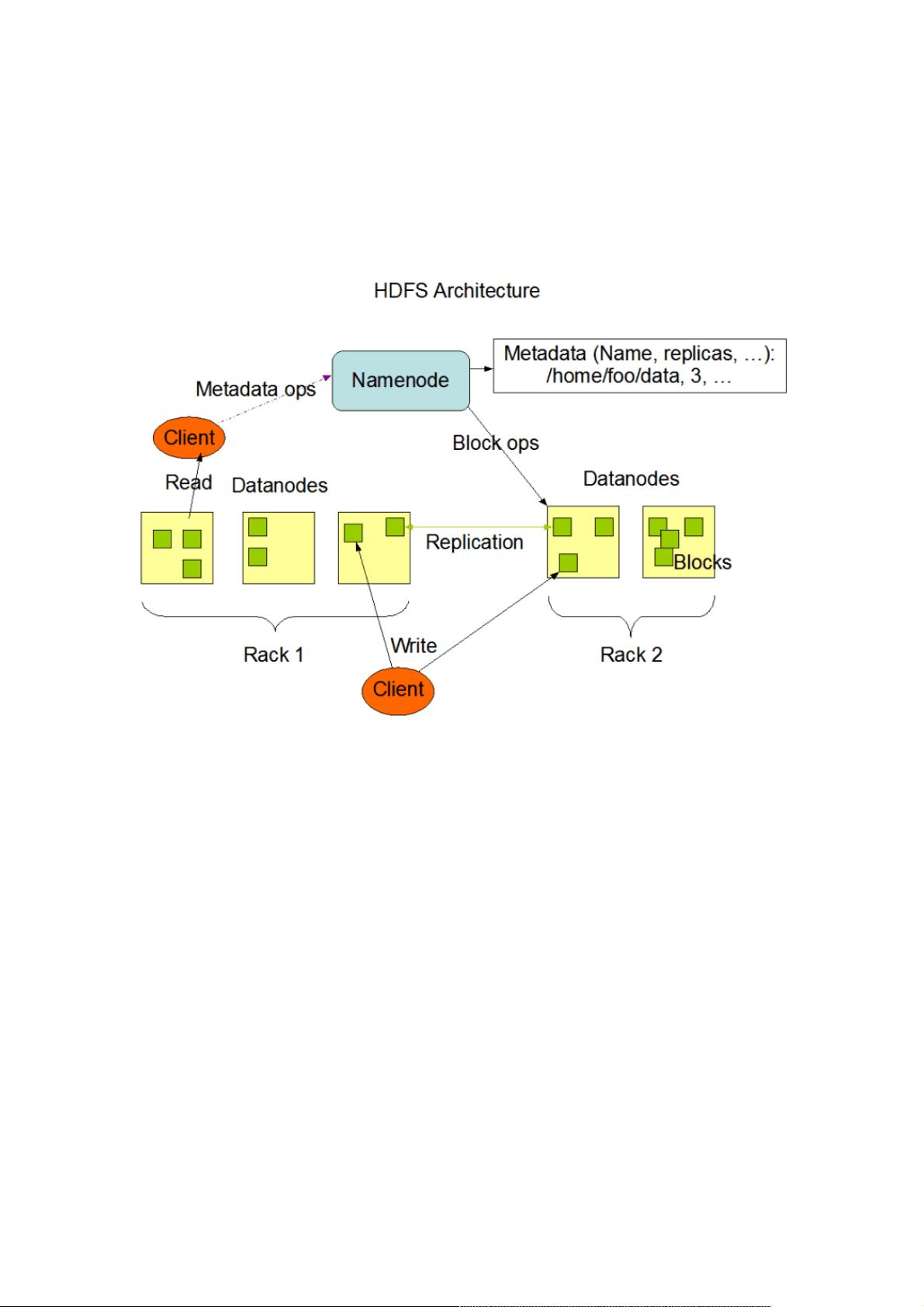

Hadoop Common是Hadoop的基础模块,提供了一套通用的库和服务,如I/O操作、加密、压缩等,使得开发者能够轻松地构建分布式应用程序。HDFS是Hadoop的核心组件,它是一个分布式文件系统,特别适合于存储大量数据和高吞吐量的应用场景。HDFS的设计基于master-slave架构,其中NameNode作为主节点,负责管理文件系统的元数据,如文件结构、block信息和DataNode位置,确保数据的一致性和可靠性。DataNode则是从属节点,负责实际的数据存储和处理,每个DataNode可以存储多个block块的副本,实现数据冗余和容错。

MapReduce是Hadoop的另一个关键组件,它是一种编程模型,允许用户编写处理大规模数据集的并行程序,通过将任务分解为一系列可独立执行的map和reduce阶段来简化编程。MapReduce确保了数据在分布式集群中的高效处理,即使数据分布在不同的节点上,也能进行有效的数据划分和合并。

HDFS的写入过程涉及Client向NameNode请求数据节点信息,将文件分割成block块并写入,而读取则通过NameNode获取block块信息和DataNode位置。为了提高数据可靠性,HDFS的每个block块都会创建多个副本,数量可以根据配置调整,这有助于在单个DataNode故障时仍能保证数据的完整性和可用性。

Hadoop分布式计算框架通过其高效的架构设计和组件协同,实现了大规模数据处理和存储,适用于各种大数据处理场景,如日志分析、搜索引擎、推荐系统等。学习和理解Hadoop原理及架构对于数据科学家、开发者和运维人员来说,都是非常重要的技能。

2018-02-26 上传

点击了解资源详情

2019-01-07 上传

2007-08-13 上传

2019-01-18 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情