EM算法详解:三硬币模型实战与隐变量处理

需积分: 0 4 浏览量

更新于2024-08-05

收藏 1.09MB PDF 举报

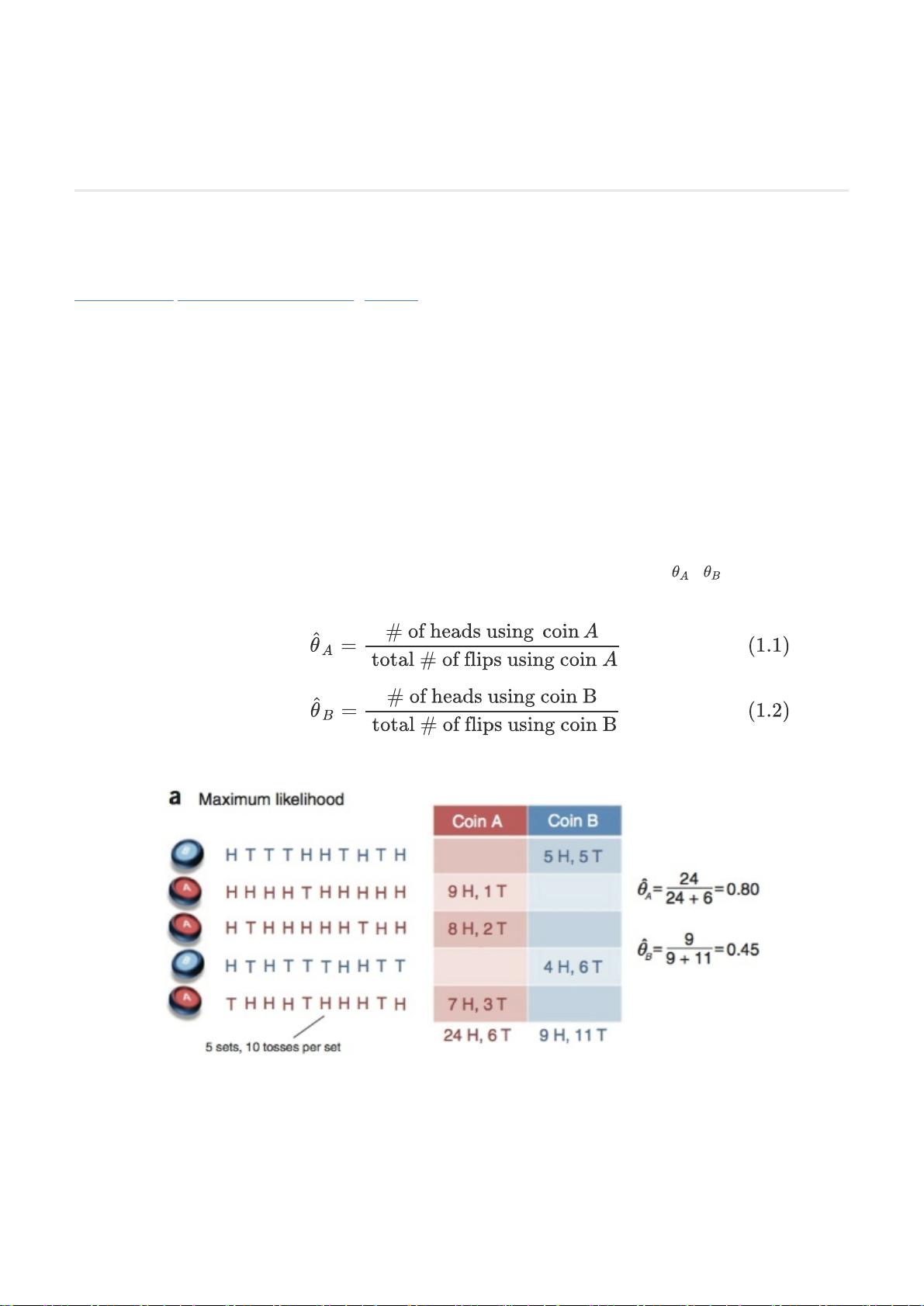

EM算法是一种在数据中存在隐变量时,通过迭代优化来估计参数的统计学方法,尤其适用于最大似然估计中的复杂问题。以三硬币模型为例,它描绘了两个硬币A和B,每次实验随机选择一枚硬币进行10次投掷,但观察结果中隐藏了选择硬币的信息。在完全数据情况下,我们能明确知道每轮投掷的是哪枚硬币,使用极大似然估计直接求解参数相对简单。然而,当这些选择信息成为隐变量时,即我们面对的是不完全数据,传统的极大似然估计就变得棘手。

EM算法的核心思想是分为两个步骤:E-Step和M-Step。在E-Step(期望步)中,基于当前的参数估计,我们计算出隐变量(例如每轮选择硬币的概率)的最佳概率分布。这一步相当于对观察数据进行条件概率的估计,尽管我们无法知道具体的选择,但可以通过观测数据来推测。

接着在M-Step(最大化步)中,我们不再关注单个隐变量的具体取值,而是考虑所有可能的情况,计算出观测结果对每个可能的隐变量状态下的概率期望。这个期望就是观测数据与隐变量概率分布结合后的数学期望,用于更新模型参数。这是一个迭代过程,新参数估计出来后,再次进行E-Step和M-Step,直至算法收敛,达到最优参数估计。

在数学推导过程中,通常会假设每个样本服从某种分布,并通过边缘概率分布的公式来简化问题。直接最大化似然函数(如二项分布的形式)由于涉及多个隐变量的联合分布,变得复杂。EM算法通过分解这个难题,逐步逼近全局最优解,展现了其在处理此类问题上的强大之处。

吴恩达在CS229课程中详细介绍了EM算法的原理、推导以及其实用性,特别是如何将这个理论应用于实际问题,如估计硬币A和B的正面朝上概率,即使在数据不完整的情况下也能找到有效解决方案。EM算法的精髓在于通过不断迭代,期望(E-Step)与最大化(M-Step)相结合,最终达到参数估计的全局最优。

139 浏览量

点击了解资源详情

203 浏览量

2024-03-11 上传

776 浏览量

107 浏览量

313 浏览量

749 浏览量

老光私享

- 粉丝: 880

最新资源

- Java面试深度解析:异常处理与内存机制

- J2EE开发实践指南:从正则到Spring AOP

- UML抽象概念解析与应用

- UML用户指南:建模语言参考手册

- ASP.NET编程必备:常用内置函数详解

- Windows CE .NET编程指南:中文版详解

- Oracle数据库操作手册:从8i到9i

- 8086/8088系统总线详解与时序分析

- TestDirector 8.2SP2 安装教程与注意事项

- 批处理教程:创建PPT示例与基本命令介绍

- WebLogic管理控制台详解与实践指南

- MyEclipse快速入门:JSP开发与Tomcat配置教程

- 深入理解XAML:Windows Vista的新界面语言

- AT89S51中文详细资料:低功耗高性能单片机

- FPGA VHDL设计:实现闹钟功能的电子钟实验

- **集团HRMS需求规格:高效架构与流程管理工具