互联网大厂大数据面试高频题:Linux与Hadoop命令详解

版权申诉

107 浏览量

更新于2024-07-05

收藏 2.65MB PDF 举报

本文档是一份针对大数据领域互联网大厂面试的高频问题及其答案汇总,内容涵盖Linux与Shell编程技能,以及Hadoop相关的技术知识。以下是详细解读:

1. **Linux & Shell命令基础**:

- `top`:用于实时监控系统资源使用情况,如内存和CPU使用率。

- `df -h`:查看磁盘分区的使用情况,包括总空间、已用空间和剩余空间。

- `iotop`:监控Linux系统中的I/O操作,通过`yum install iotop`安装。

- `iotop -o`:筛选出I/O密集型进程,以便优化性能。

- `netstat -tunlp | grep 端口号`:检查网络连接和端口占用状态。

- `uptime`:提供系统运行时间和负载平均值。

- `ps -aux`:显示当前所有用户的进程详细信息。

2. **Shell编程实战经验**:

- 使用Shell脚本进行任务自动化,如集群启动脚本、数据仓库的MySQL导入导出,以及内部数据迁移。

- 当需要杀死一个不知道进程号但知道其特征(如脚本名和参数)的进程时,可以通过`ps -ef | grep`筛选相关行,再结合`awk`和`xargs kill`执行杀进程操作。

- 单引号和双引号的区别:单引号不解析变量,双引号会解析变量;反引号`用于执行命令并获取其输出。

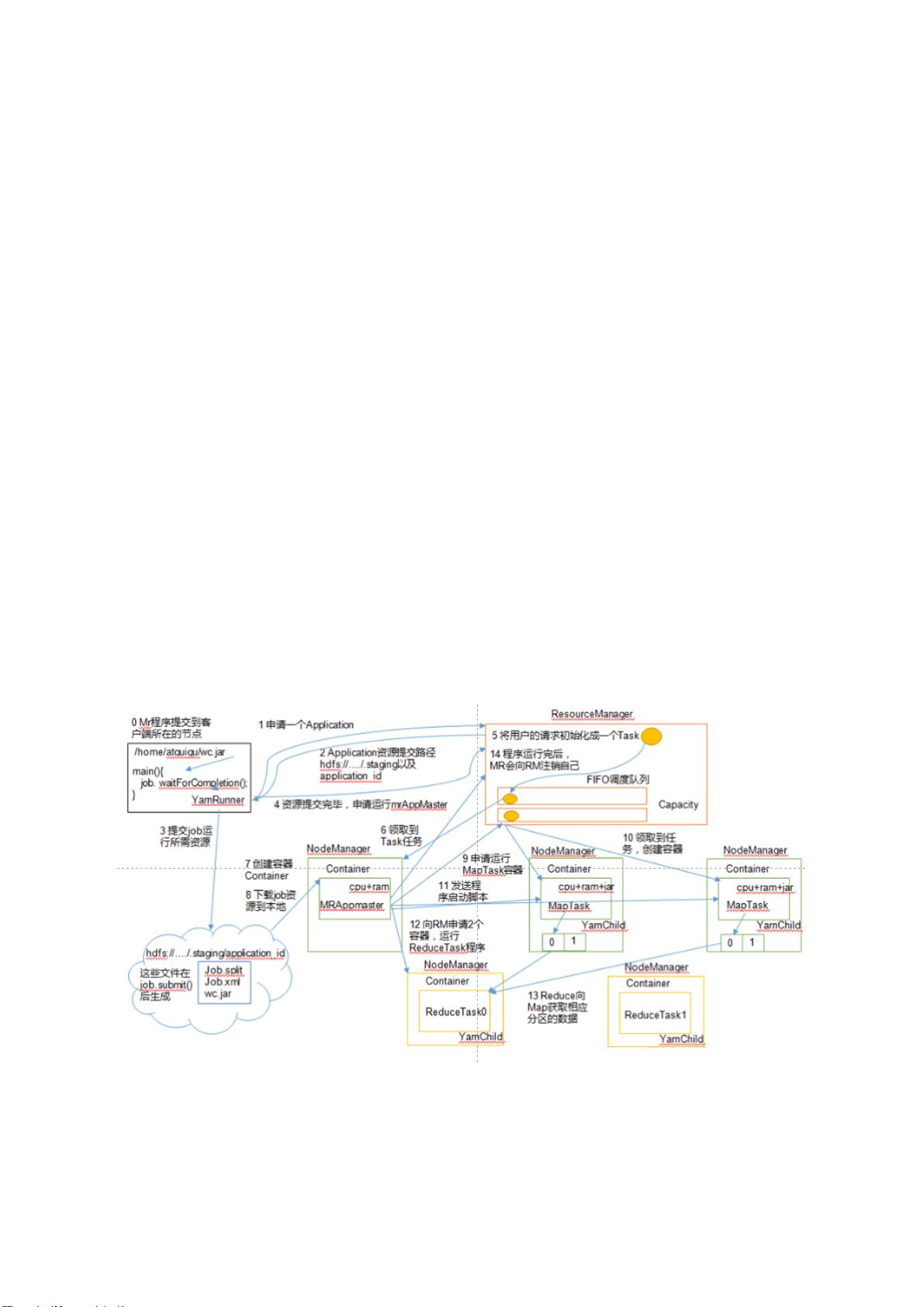

3. **Hadoop技术要点**:

- Hadoop常用端口号:HDFS(50070, 9870), MapReduce(8088, 8088), History Server(19888), Namenode/Jobtracker的客户端端口(9000, 8020)。

- 配置文件:Hadoop 2.x和3.x版本的`core-site.xml`, `hdfs-site.xml`, `mapred-site.xml`, `yarn-site.xml`有所不同。

- 集群搭建步骤包括安装JDK,配置核心文件,并简述了基础的Hadoop集群构建流程。

这份文档对求职者来说是宝贵的面试准备资料,它不仅测试了应聘者的实际操作能力和对Linux和Hadoop技术的理解,还考察了Shell编程的灵活性和问题解决能力。理解这些知识点不仅能提升面试表现,也能在日常工作中提高效率。

120 浏览量

522 浏览量

217 浏览量

2023-08-07 上传

2024-03-05 上传

智慧化智能化数字化方案

- 粉丝: 1596

- 资源: 1万+

最新资源

- win_udp:Windows网络udp框架服务器和侦听器

- 如何规划团队训练课程PPT

- torch_cluster-1.5.5-cp36-cp36m-linux_x86_64whl.zip

- 取Excel表格有数据单元格的起讫行列.rar

- zencharts:将 High Charts 库的强大功能与 Zendesk Developer API 相结合的小型应用程序

- wild-rydes:野生莱德

- Redosnap Launcher-crx插件

- CNN_for_brain_ventricles_segmentation:“个人3D脑图集”项目。 利用全卷积神经网络对大脑的CT数据进行分割

- 批量修改文件名.zip

- 取Excel表格有数据单元格的起讫行、列.rar

- html2text:用 Go 编写的 html 到文本转换器

- torch_scatter-2.0.4-cp37-cp37m-win_amd64whl.zip

- Email Notifier-crx插件

- yun-text:“云杯”景区声誉评价得分预测中第三个解决方案的DL部分

- milestoneproject2-memorygame:一种记忆游戏,要求用户匹配隐藏在牌组中的成对纸牌

- Android Binder通信案例