Hadoop在云计算中的大规模分布式处理探索

需积分: 9 75 浏览量

更新于2024-09-19

收藏 768KB PDF 举报

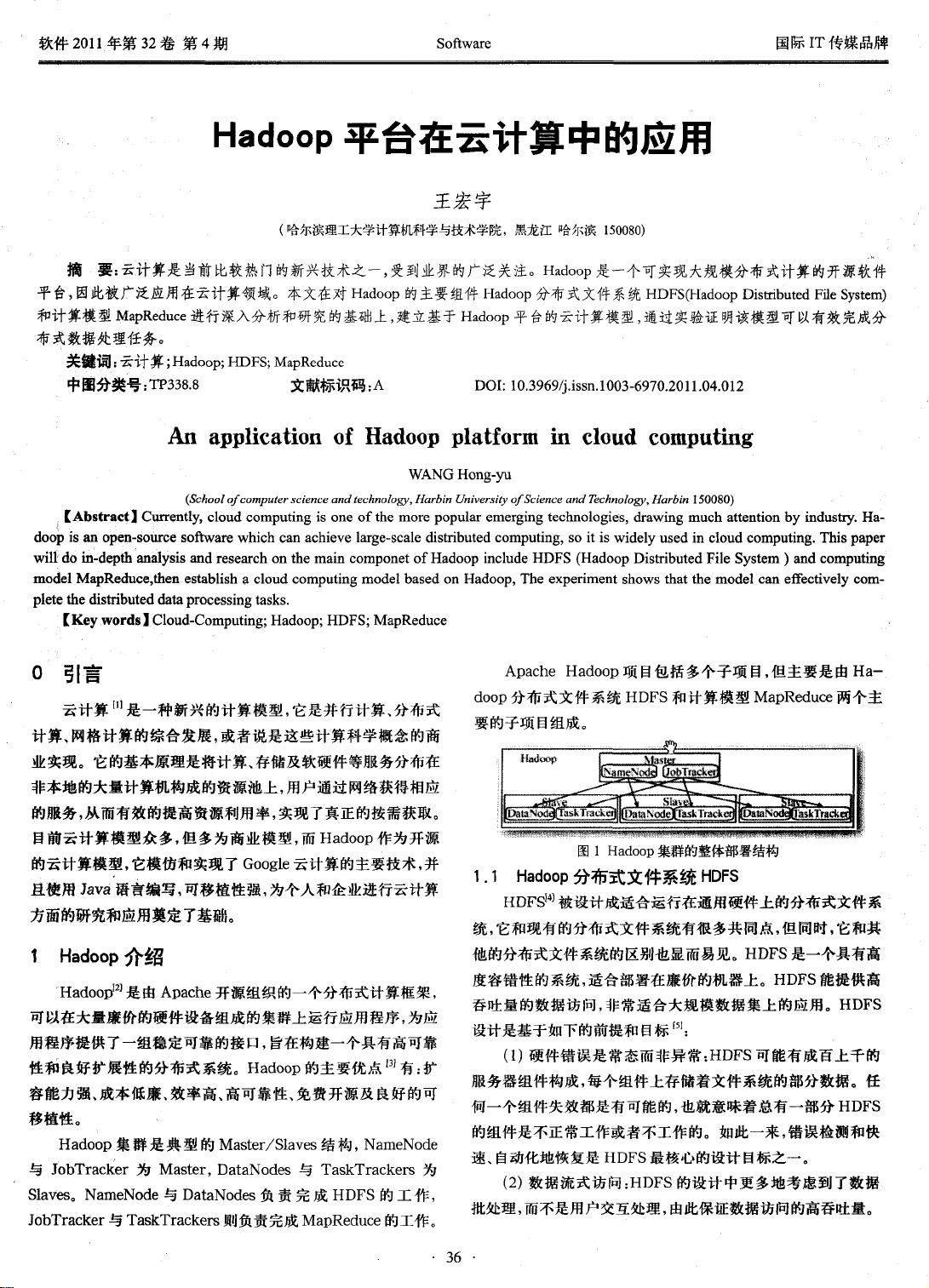

云计算作为当今信息技术领域的重要趋势,吸引了全球范围内的关注。Hadoop平台因其出色的性能和在大规模分布式计算方面的优势,已经成为云计算领域不可或缺的一部分。本文主要探讨了Hadoop平台在云计算中的具体应用,特别是其两个关键组件——Hadoop分布式文件系统(HDFS)和MapReduce计算模型。

HDFS是Hadoop的核心组成部分,它是一个高容错、高吞吐量的分布式文件系统,设计用于在大量廉价硬件上存储和管理大规模的数据集。HDFS通过将数据分割成多个块,并在不同的节点上复制这些块,实现了数据的分布式存储和访问,从而提高了系统的可靠性和可用性。这种设计使得Hadoop能够处理PB级别的数据,非常适合云计算环境中海量数据的存储和处理需求。

MapReduce是一种编程模型,用于在集群上并行执行数据处理任务。它将复杂的计算任务分解为一系列简单的Map和Reduce操作,分别在数据的分布节点上执行,然后通过网络将中间结果合并,最终得到最终结果。MapReduce模型非常适合处理那些可以分解为独立部分的计算问题,如数据挖掘、机器学习和数据分析等,是云计算中高效处理大规模数据的强大工具。

文章作者王宏宇首先对Hadoop的基本原理进行了深入剖析,然后构建了一个基于Hadoop平台的云计算模型,通过实际案例或实验验证了这个模型在分布式数据处理任务中的有效性。在这个模型中,HDFS提供了可靠的数据存储,而MapReduce则负责高效的并行计算。结合云计算的优势,如弹性的资源分配和按需付费模式,Hadoop平台在云计算环境中的应用极大地提升了数据处理效率和灵活性。

Hadoop平台在云计算中的应用是现代信息技术发展的一个重要里程碑,它通过HDFS和MapReduce的优势,解决了大数据处理中的诸多挑战,推动了云计算在企业级服务、数据分析、在线服务等多个领域的广泛应用。随着技术的不断进步和优化,Hadoop将继续发挥核心作用,促进云计算的发展和创新。

2022-04-07 上传

2021-07-18 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

liangxiao_2011

- 粉丝: 0

- 资源: 35

最新资源

- Fisher Iris Setosa数据的主成分分析及可视化- Matlab实现

- 深入理解JavaScript类与面向对象编程

- Argspect-0.0.1版本Python包发布与使用说明

- OpenNetAdmin v09.07.15 PHP项目源码下载

- 掌握Node.js: 构建高性能Web服务器与应用程序

- Matlab矢量绘图工具:polarG函数使用详解

- 实现Vue.js中PDF文件的签名显示功能

- 开源项目PSPSolver:资源约束调度问题求解器库

- 探索vwru系统:大众的虚拟现实招聘平台

- 深入理解cJSON:案例与源文件解析

- 多边形扩展算法在MATLAB中的应用与实现

- 用React类组件创建迷你待办事项列表指南

- Python库setuptools-58.5.3助力高效开发

- fmfiles工具:在MATLAB中查找丢失文件并列出错误

- 老枪二级域名系统PHP源码简易版发布

- 探索DOSGUI开源库:C/C++图形界面开发新篇章