EM算法详解:从基础到Gaussian混合模型与HMM应用

"这篇资料是关于EM算法的经典教程,涵盖了EM算法的基本原理及其在高斯混合模型和隐马尔可夫模型参数估计中的应用。由Jeff A. Bilmes撰写,来自国际计算机科学研究所和加州大学伯克利分校的计算机科学部门。"

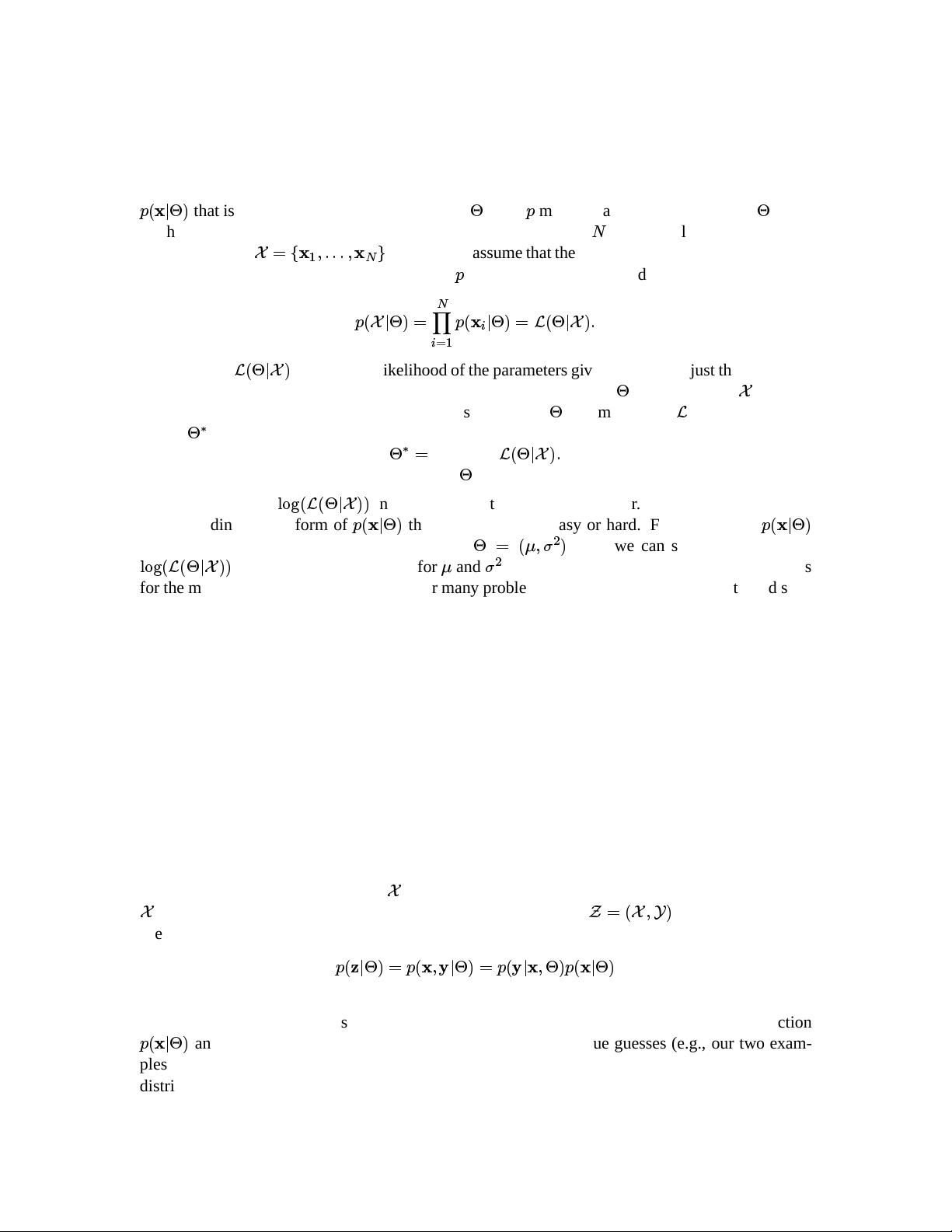

EM算法,全称期望最大化(Expectation-Maximization),是一种在数据不完整或存在隐藏变量的情况下求解最大似然估计问题的有效算法。在机器学习、统计学和信号处理等领域中,EM算法被广泛应用。

在最大似然估计中,目标是找到使得数据观测概率最大的模型参数。然而,当数据存在未观测变量时,直接最大化似然函数变得困难。EM算法通过迭代的方式,将这个问题分解为两个步骤:期望(E)步骤和最大化(M)步骤。

E步骤:在这个阶段,我们假设当前的参数值是已知的,并计算每个观测样本的后验概率,即隐藏变量给定观测数据的概率。这通常涉及到计算每个样本属于每个成分的概率,对于高斯混合模型来说,就是计算样本属于每个高斯分量的概率。

M步骤:在此阶段,我们使用E步骤得到的后验概率来更新模型参数。对于高斯混合模型,这意味着调整每个高斯分量的均值、方差和混合权重,以最大化包含隐藏变量信息的对数似然函数。对于隐马尔可夫模型(HMM),EM算法的具体形式是Baum-Welch算法,它会更新状态转移矩阵和观测概率。

在高斯混合模型中,EM算法可以有效地估计混合系数、高斯分量的均值和方差。对于离散HMM,它更新状态转移概率和发射概率;对于连续HMM,特别是使用高斯混合作为观察模型时,EM算法会调整高斯分量参数。

虽然这里没有提供详细的证明,但通常EM算法保证了在每次迭代后对数似然函数非减,因此在理论上能够达到局部最优解。实际应用中,可能会遇到局部最优、收敛速度慢等问题,可以通过初始化策略和早停条件来改善。

这篇经典教程深入浅出地介绍了EM算法,并通过实例详细解释了其在高斯混合模型和HMM中的应用,是理解并掌握这一重要算法的良好资源。

2008-10-20 上传

2023-12-01 上传

2023-11-28 上传

2023-12-14 上传

2024-05-23 上传

2023-09-27 上传

2023-06-11 上传

wkble

- 粉丝: 0

- 资源: 2

最新资源

- 构建Cadence PSpice仿真模型库教程

- VMware 10.0安装指南:步骤详解与网络、文件共享解决方案

- 中国互联网20周年必读:影响行业的100本经典书籍

- SQL Server 2000 Analysis Services的经典MDX查询示例

- VC6.0 MFC操作Excel教程:亲测Win7下的应用与保存技巧

- 使用Python NetworkX处理网络图

- 科技驱动:计算机控制技术的革新与应用

- MF-1型机器人硬件与robobasic编程详解

- ADC性能指标解析:超越位数、SNR和谐波

- 通用示波器改造为逻辑分析仪:0-1字符显示与电路设计

- C++实现TCP控制台客户端

- SOA架构下ESB在卷烟厂的信息整合与决策支持

- 三维人脸识别:技术进展与应用解析

- 单张人脸图像的眼镜边框自动去除方法

- C语言绘制图形:余弦曲线与正弦函数示例

- Matlab 文件操作入门:fopen、fclose、fprintf、fscanf 等函数使用详解