循环神经网络(RNN)入门

需积分: 9 48 浏览量

更新于2024-07-14

收藏 1.49MB PDF 举报

"这是关于RNN(循环神经网络)的介绍,包括其动机、基本结构、反向传播通过时间(BPTT)、基本RNN的问题、长短期记忆网络(LSTM)、GRU(门控循环单元)以及RNN在3D应用中的应用。"

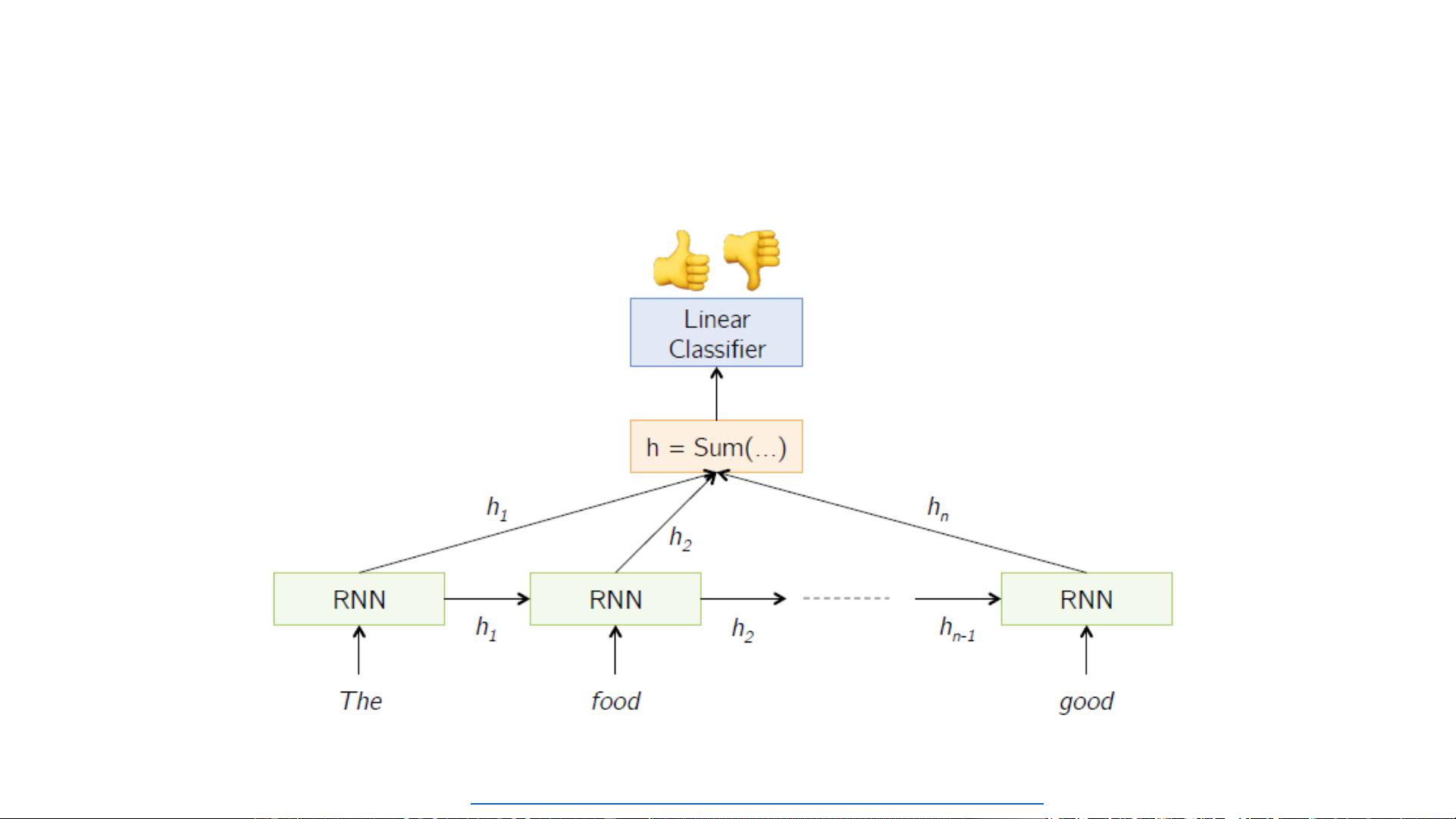

在机器学习领域,RNN是一种特殊类型的神经网络,它能够处理序列数据,因为其具有内部状态,可以捕获和存储先前输入的信息。这种能力使得RNN相对于传统的前馈神经网络(如ANN和CNN)有了独特的优势。前馈网络通常处理固定长度的输入和输出,但RNN能够适应不同长度的序列,这在理解句子、处理视频等任务中至关重要,例如语音识别或时间序列预测。

RNN的主要动机在于它们能够处理变长输入和输出的问题,这是传统的N-gram模型难以解决的。N-gram模型需要固定的上下文窗口,但在遇到比训练中更长的新样本时,效果会受限。RNN通过其循环结构解决了这个问题,允许信息随时间传递,使模型能够考虑更广泛的上下文。

基本的RNN由输入层、隐藏层和输出层组成。每个时间步长,当前的输入与上一时间步长的隐藏状态结合,通过激活函数(如sigmoid或tanh)更新隐藏状态。这个过程可以用数学公式表示,其中\( s_t \)是时间步长t的隐藏状态,\( x_t \)是输入,\( o_t \)是输出,\( g \)、\( U \)、\( V \)和\( W \)是权重矩阵,\( f \)是激活函数。通过反复将隐藏状态的更新公式代入输出公式,RNN可以将过去的信息传递到未来,这就是RNN能向前看任意数量的步长的原因。

然而,基本的RNN在处理长期依赖问题时会遇到“梯度消失”或“梯度爆炸”问题,导致模型难以学习远距离的依赖关系。为了解决这个问题,LSTM(长短期记忆)被提出。LSTM通过引入“门”机制,如输入门、遗忘门和输出门,来控制信息的流动,有效地解决了长距离依赖问题。LSTM的前向和后向传播过程复杂,但能更有效地保留和遗忘信息。

此外,GRU(门控循环单元)是LSTM的一种简化版本,同样具备控制信息流的能力,但结构更简洁。GRU合并了LSTM的输入门和遗忘门,用重置门和更新门来控制状态更新。

在3D应用中,RNN可以扩展用于处理三维数据,如多帧视频分析,通过捕捉时间维度上的序列信息,对视频进行理解或预测。

RNN及其变种,如LSTM和GRU,是处理序列数据的强大工具,广泛应用于自然语言处理、音频处理、时间序列预测等领域,弥补了传统模型在处理动态序列信息方面的不足。

2212 浏览量

186 浏览量

194 浏览量

2024-04-14 上传

674 浏览量

443 浏览量

点击了解资源详情

411 浏览量

qq_38604739

- 粉丝: 0

- 资源: 5

最新资源

- django-js-reverse:对Django的Javascript URL处理没有影响

- WWW:Výukovástránka万维网

- 桌面Internet浏览器的“阅读器模式”

- HTML5 canvas使用简单噪音算法模拟星球耀斑动画效果源码.zip

- php-7.4.11.zip

- DevBox2.0.0.4.rar

- kiyoshi:ⓦ专为创意发布者设计的Edgy WordPress主题

- test1_test1_test1-_test1._食堂周末预约_gulfixh_

- RandomPickerApp随机抽取器(MAC OS系统下直接解压可用)

- Blackboard-Browser

- buildhub:已弃用:Mozilla Build元数据服务

- Hider

- simple_image_tools_flutter:图片抖动应用的简单裁剪和水平调整

- tech-test-wk10-Makers

- Kotlin 实战项目练习

- integration-test-with-docker