ChatGPT模型架构与自然语言处理技术解析

19 浏览量

更新于2024-06-18

收藏 35.82MB PPTX 举报

介绍ChatGPT的发展历程、模型机理及发展前景

ChatGPT是一种基于深度学习的自然语言处理模型,它的发展历程可以追溯到2015年,当时OpenAI团队首次提出Transformer模型,用于机器翻译任务。自那以来,ChatGPT模型不断演进,变得越来越强大,能够处理越来越复杂的自然语言处理任务。

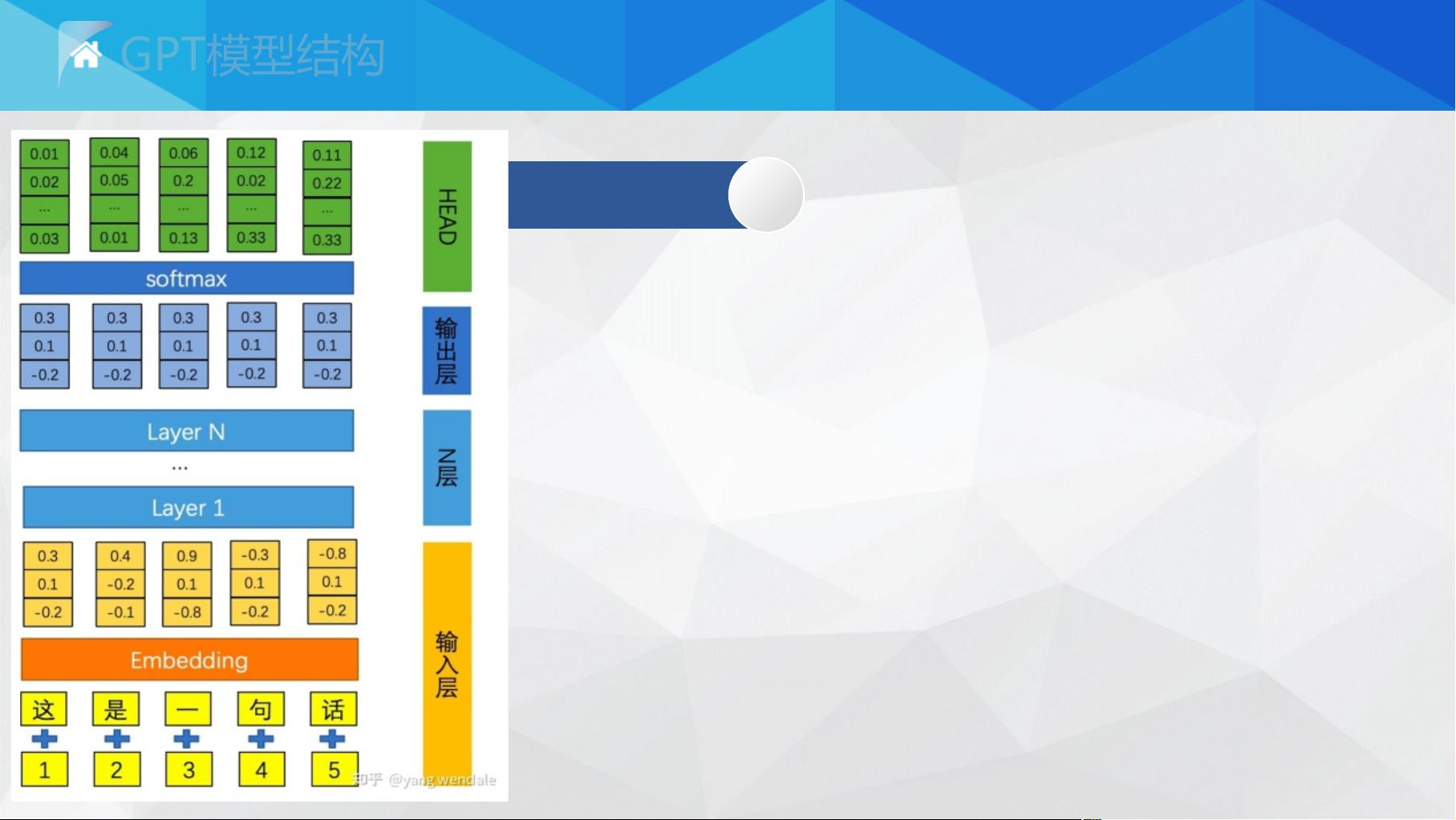

ChatGPT模型的核心组件是Transformerblock,它由Self-Attention机制、FeedForward神经网络和残差层组成。Self-Attention机制能够捕捉单词之间的语义关系,而FeedForward神经网络能够学习到词汇之间的复杂关系。残差层则能够保证梯度不至于过小,避免梯度消失。

在ChatGPT模型中,Tokenembedding是将文本序列分割成单个语言单位(tokens),然后将每个token转换为词向量的过程。这种嵌入表示可以用于训练深度学习模型,例如循环神经网络(RNN)和Transformer等,从而实现机器翻译、情感分析、文本摘要等更高级的NLP任务。

ChatGPT模型的发展历程可以分为三个阶段:GPT-1、GPT-2和GPT-3。GPT-1是第一个基于Transformer模型的语言模型,它能够生成高质量的文本,但具有明显的缺陷,如生成文本的长度有限。GPT-2是在GPT-1的基础上进行了改进,能够生成更长的文本,但仍然存在一些缺陷。GPT-3是最新的版本,能够生成更加自然、流畅的文本,且具有更强的语言理解能力。

ChatGPT模型的发展前景非常广阔,它能够应用于各种自然语言处理任务,如机器翻译、情感分析、文本摘要、问答系统等。此外,ChatGPT模型还能够应用于其他领域,如客服聊天机器人、自然语言生成、文本分类等。

ChatGPT模型是基于深度学习的自然语言处理模型,它的发展历程可以追溯到2015年,自那以来不断演进。ChatGPT模型的核心组件是Transformerblock,它由Self-Attention机制、FeedForward神经网络和残差层组成。ChatGPT模型的发展前景非常广阔,能够应用于各种自然语言处理任务和其他领域。

2023-04-01 上传

2023-10-26 上传

2023-06-02 上传

2023-05-15 上传

2023-05-15 上传

2023-06-08 上传

2023-05-13 上传

m0_60688831

- 粉丝: 102

- 资源: 7

最新资源

- 十种常见电感线圈电感量计算公式详解

- 军用车辆:CAN总线的集成与优势

- CAN总线在汽车智能换档系统中的作用与实现

- CAN总线数据超载问题及解决策略

- 汽车车身系统CAN总线设计与应用

- SAP企业需求深度剖析:财务会计与供应链的关键流程与改进策略

- CAN总线在发动机电控系统中的通信设计实践

- Spring与iBATIS整合:快速开发与比较分析

- CAN总线驱动的整车管理系统硬件设计详解

- CAN总线通讯智能节点设计与实现

- DSP实现电动汽车CAN总线通讯技术

- CAN协议网关设计:自动位速率检测与互连

- Xcode免证书调试iPad程序开发指南

- 分布式数据库查询优化算法探讨

- Win7安装VC++6.0完全指南:解决兼容性与Office冲突

- MFC实现学生信息管理系统:登录与数据库操作