Hadoop MapReducev1:JobTracker心跳处理流程解析

148 浏览量

更新于2024-08-26

收藏 154KB PDF 举报

"MapReduceV1:JobTracker处理Heartbeat流程分析"

MapReduce是Apache Hadoop的核心组件之一,用于大规模数据集的分布式计算。在Hadoop 1.x版本中,MapReduce的实现被称为MapReduce V1,其中JobTracker扮演着关键角色,负责任务调度、资源管理和监控TaskTracker的状态。本文将深入解析MapReduce V1中JobTracker如何处理TaskTracker的心跳(Heartbeat)消息。

JobTracker与TaskTracker之间的通信是通过InterTrackerProtocol协议完成的,这是一个远程过程调用(RPC)协议。TaskTracker会定期向JobTracker发送Heartbeat,报告其状态、可用资源以及任务进度。Heartbeat不仅是保持两者间通信的重要机制,也是JobTracker监控TaskTracker健康状况和进行任务调度的基础。

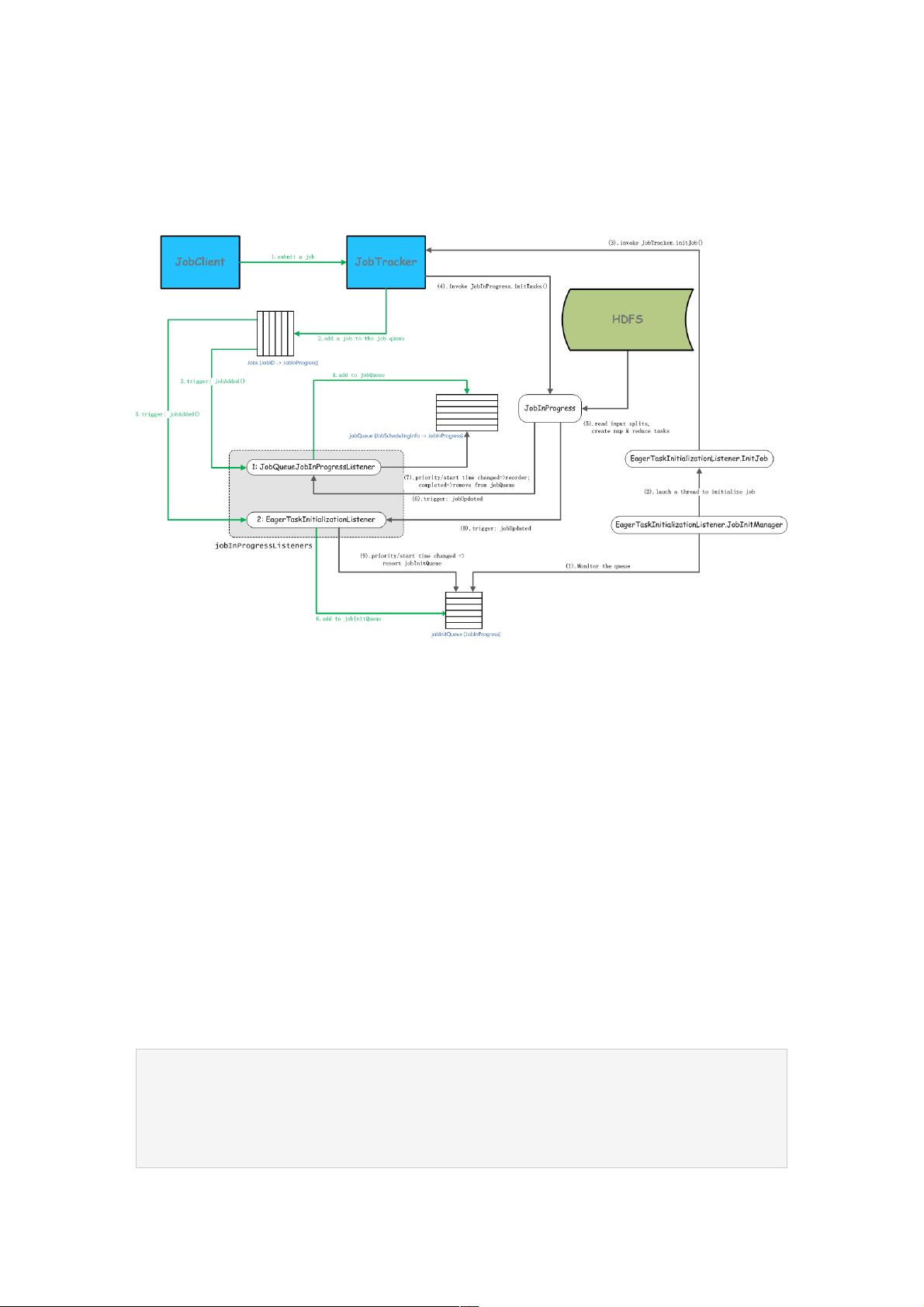

当JobTracker接收到Job提交时,它会按照以下步骤处理:

1. JobClient使用JobSubmissionProtocol协议向JobTracker发起RPC请求,调用submitJob方法提交Job。

2. JobTracker接收到Job后,创建一个JobInProgress对象,用于跟踪Job的整个生命周期,并将其存储在内部的jobs队列中。

3. JobTracker接着触发JobQueueJobInProgressListener,这是一个监听器接口,用于处理Job的调度信息。

4. JobQueueJobInProgressListener的jobAdded方法被调用,它会创建JobSchedulingInfo对象,这个对象包含了Job的调度信息,并将Job添加到jobQueue队列中,以便后续的调度决策。

5. JobTracker还会触发EagerTaskInitializationListener,这个监听器负责立即启动某些任务,以加快Job的初始化进程。

Heartbeat处理流程的重点在于JobTracker如何根据心跳消息更新Job和Task的状态,以及做出相应的调度决策。心跳消息中可能包含TaskTracker的资源报告、任务完成情况以及异常信息。JobTracker会根据这些信息更新内部状态,例如重新分配失败的任务,调整TaskTracker的负载平衡,或者对新提交的Job进行调度。

此外,JobTracker还需要监听Job队列中的事件,当Job状态发生变化时,如Job完成或失败,会触发一系列的Listener更新状态。这确保了系统能够快速响应Job的变化,从而维持整个集群的稳定运行。

总结来说,MapReduce V1中的JobTracker处理Heartbeat流程是一个复杂而精细的过程,涉及到多个组件的协作和一系列的监听器回调。这一机制确保了Hadoop集群能有效地管理任务,优化资源分配,并及时响应各种事件,以实现高效的大规模数据处理。然而,由于JobTracker的集中式设计,存在单点故障问题,这也是后来Hadoop 2.x引入YARN的原因,通过分离资源管理和作业调度,提高了系统的可扩展性和可靠性。

152 浏览量

201 浏览量

201 浏览量

193 浏览量

点击了解资源详情

106 浏览量

195 浏览量

点击了解资源详情

2021-06-29 上传

weixin_38739837

- 粉丝: 2

最新资源

- VC MFC实现视图切分的对话框小程序

- Dependency Walker 2.2.6000 x64版发布,轻松检测依赖

- 伊斯坦布尔宠物学校:专业小狗训练与服从培训服务

- DNW串口调试工具:嵌入式系统的绝配

- TeeChart绘图控件:VC平台下的强大2D/3D绘图解决方案

- VC实现FIR与IIR滤波器及FFT、DFT算法代码解析

- ASP.NET 版 QQ 开放平台 SDK 使用指南

- Kinect v2跌倒检测源码函数解析与交流

- 简易坐标转换器CRX插件发布-支持台湾本岛坐标系统

- C#实现网络配置管理工具(源码解析与使用)

- T50打印机驱动在WIN7系统下的完美安装指南

- PLSQL Developer 64位解压版配置教程与instantclient_12_2使用

- Java实现的简易多人聊天工具(附完整源码)

- mvd_win4分子模拟对接:个人工作学习的利器

- 个人静态网站作品HTML模板分享

- Angular个人仪表盘开发与构建流程指南