深度学习中的过拟合、梯度消失与RNN深入理解

140 浏览量

更新于2024-08-30

收藏 236KB PDF 举报

"过拟合、梯度消失、RNN进阶"

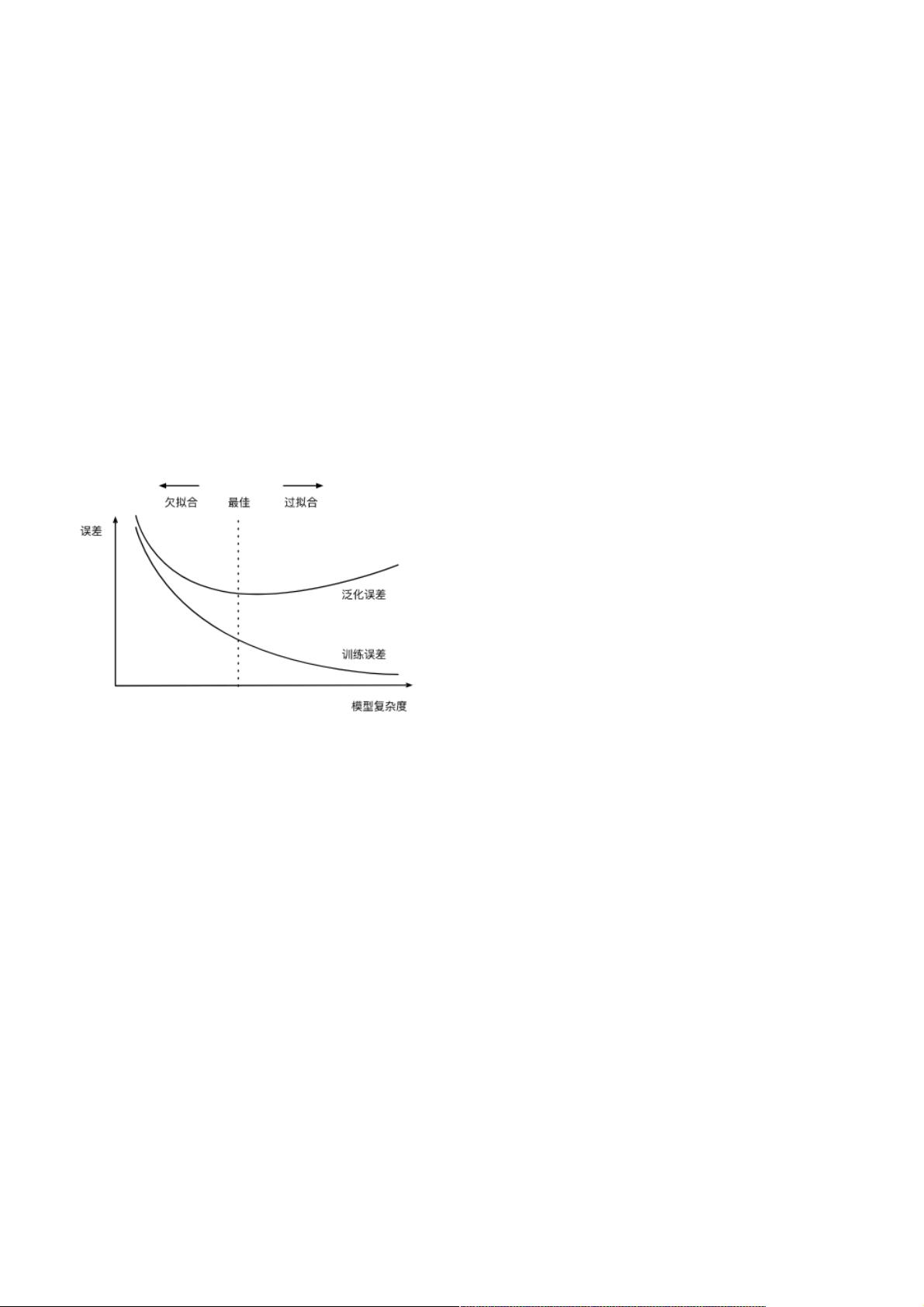

在机器学习和深度学习领域,过拟合和欠拟合是两个常见的概念,它们关乎模型的泛化能力。过拟合指的是模型在训练数据上表现优异,但在未见过的测试数据上表现糟糕,这通常是因为模型过于复杂,过度学习了训练数据中的噪声和细节。欠拟合则是模型无法很好地捕捉训练数据的规律,导致训练误差较高。这两种情况可以通过调整模型复杂度和增加训练数据来改善。损失函数是衡量模型性能的关键工具,如均方误差适用于线性回归,而交叉熵损失函数常用于softmax回归。

验证集是用于在模型训练过程中评估模型性能的独立数据集,不参与模型的训练过程,用于防止模型在训练数据上过拟合。K折交叉验证是一种有效的数据利用策略,尤其在数据量有限的情况下,它可以更有效地估计模型的泛化性能。

过拟合的解决方法包括权重衰减(等价于L2范数正则化)和丢弃法。权重衰减通过在损失函数中添加L2范数惩罚项,抑制权重过大,防止模型过于复杂。丢弃法则是在训练过程中随机忽略一部分神经元,增加模型的鲁棒性。

梯度消失和梯度爆炸是深度神经网络中常见的问题,尤其是对于循环神经网络(RNN)而言。梯度消失意味着深层网络中反向传播的梯度变得极小,导致深层节点的权重更新缓慢;梯度爆炸则相反,梯度值变得过大,可能导致权重的不稳定。随机初始化模型参数有助于避免这种问题,确保每个神经元在前向传播时有独立的响应,并在反向传播时获得不同的梯度更新。

循环神经网络(RNN)是一种能处理序列数据的神经网络结构,但由于其长期依赖的问题,常常遇到梯度消失的挑战。为了解决这个问题,后来发展出了长短期记忆网络(LSTM)和门控循环单元(GRU),它们引入了门控机制,更好地保存和控制信息流,从而缓解了梯度消失问题。

环境因素如协变量偏移、标签偏移和概念偏移是现实世界中影响模型性能的常见问题。这些偏移可能导致模型在新的环境中表现不佳,需要持续的数据收集和模型更新以适应不断变化的环境条件。

理解和解决过拟合、梯度消失以及RNN的相关问题对于构建有效的深度学习模型至关重要。通过合理选择模型复杂度、应用正则化技术、优化初始化策略,以及采用先进的RNN变体,我们可以提升模型的泛化能力和稳定性能。

232 浏览量

221 浏览量

188 浏览量

439 浏览量

2021-01-20 上传

335 浏览量

3027 浏览量

935 浏览量

点击了解资源详情

weixin_38744435

- 粉丝: 373

最新资源

- Visual C# 2008初学者教程:微软官方指南

- Weblogic服务器基础配置:工作目录与DB2数据源设置

- FusionCharts详尽教程:创建动态图表与应用指南

- Java变压器模式详解:适配与组合的静态结构模式

- Java实现网页动态统计曲线发布

- iBATIS DataMapper 2.0 开发者指南

- 精通Transact-SQL编程:高级技巧与实战指南

- PKCS#12标准详解:个人信息交换语法

- C#编程:DateTime与常用函数详解

- Python PIL 图像处理快速入门指南

- 编译原理习题解析:变量表与文法规则

- 智能卡应用设计与编程指南:Wolfgang Rankl 著

- HTTP状态码详解:从400到505的错误信息解读

- Java Servlet 2.5 规范详解

- JSTL 1.1官方文档:Java Server Pages标准标签库详解

- FastReport3.0程序员手册:设计与运行报表指南