Seq2Seq模型解析:从N对1到同步序列标注

需积分: 0 158 浏览量

更新于2024-08-05

收藏 939KB PDF 举报

本文主要介绍了Seq2Seq模型在机器学习和深度学习中的应用,包括N对1、1对N、N对N以及N对M四种类型的Seq2Seq模型,并结合RNN进行了简单说明。

Seq2Seq模型是机器学习和深度学习领域中用于处理序列到序列转化的一种模型框架。这种模型能够将一个输入序列转换成一个目标序列,广泛应用于各种任务,如文本分类、图像生成文本、序列标注和机器翻译。

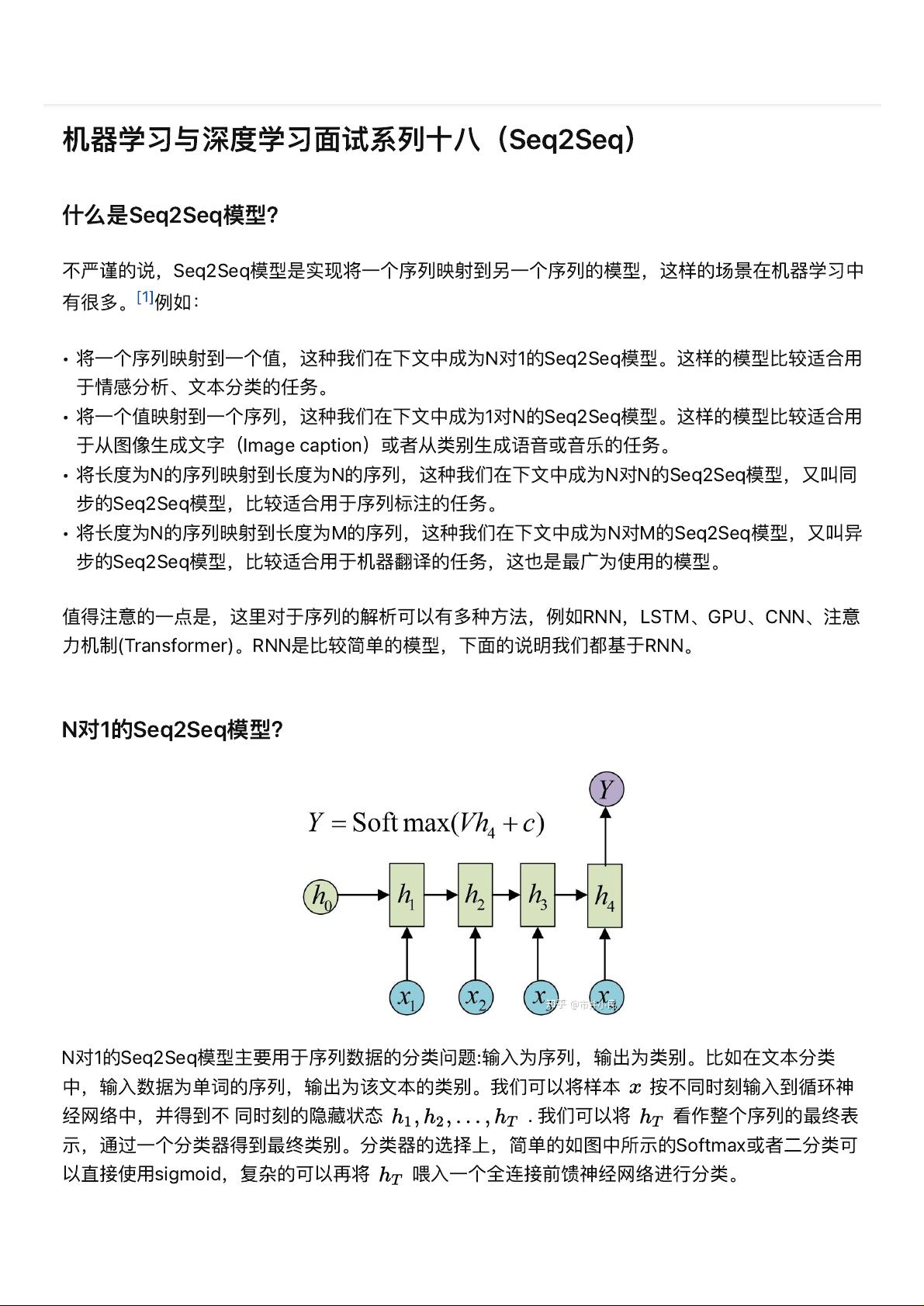

1. N对1的Seq2Seq模型:这种模型适用于序列数据的分类问题。输入是一个序列,输出是一个类别。例如,在文本分类任务中,输入是单词序列,输出是文本所属的类别。通常,使用RNN来处理时间序列数据,最后时刻的隐藏状态被视为整个序列的表示,通过一个分类器(如Softmax或Sigmoid)来确定最终类别。此外,还可以使用所有隐藏状态的平均值作为分类的输入。

2. 1对N的Seq2Seq模型:在这种模型中,输入是单个值,而输出是一个序列。例如,图像生成文本任务,输入是图像的特征向量,输出是描述图像的一段文字。这种模型可以设计成在每个时间步骤都将输入信息传递,以产生连续的输出序列。

3. N对N的Seq2Seq模型,也称为同步的Seq2Seq模型,适合序列标注任务。输入和输出序列长度相同,每个时间步既有输入也有输出。在词性标注等任务中,模型会为输入序列的每个元素分配一个标签,使得输入和输出序列的长度保持一致。

4. N对M的Seq2Seq模型,又称异步的Seq2Seq模型,主要用于机器翻译。输入序列和输出序列的长度可能不同,模型需要适应两个序列长度的变化。在翻译任务中,输入是源语言的句子,输出是目标语言的对应翻译。

在实际应用中,Seq2Seq模型可以采用不同的结构和组件,如RNN(循环神经网络)、LSTM(长短时记忆网络)、GRU(门控循环单元)或者是更先进的Transformer模型,后者引入了注意力机制,显著提升了模型处理长序列的能力和效率。

总结来说,Seq2Seq模型是序列数据处理的核心工具,其变体广泛应用于自然语言处理、计算机视觉等多个领域,展示了强大的序列建模和转换能力。随着技术的发展,这些模型的性能和应用范围将持续扩大。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-01-07 上传

2024-05-31 上传

2021-02-04 上传

2021-01-06 上传

2024-08-12 上传