深度欺骗:精确计算深度神经网络鲁棒性的简单方法

需积分: 18 131 浏览量

更新于2024-08-26

收藏 4.69MB PDF 举报

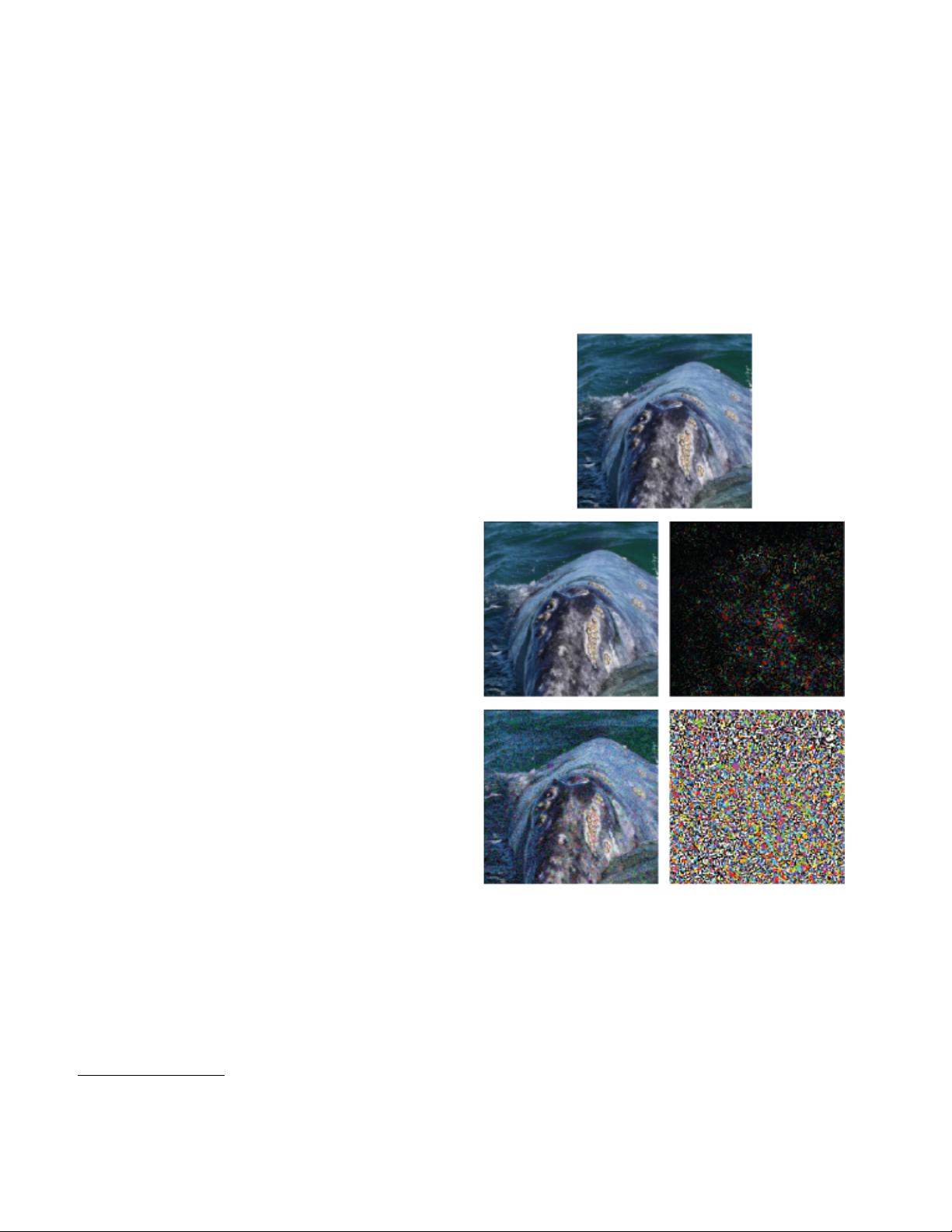

DeepFool算法是一种针对深度神经网络的简单而精确的方法,旨在识别并计算深度模型对图像输入的敏感性,即它们对微小、精心设计的扰动的不稳定性。随着深度学习在图像分类任务中的显著成就,研究人员已经发现这些复杂的网络结构对于输入的细微变化非常敏感,这被称为对抗性攻击。

当前,尽管深度神经网络的脆弱性是一个重要的研究领域,但缺乏一种有效且准确的方法来量化大规模数据集上现代深度分类器的鲁棒性。DeepFool算法填补了这一空白,它提供了一种高效的方式来生成那些能够欺骗深度网络的扰动,从而评估模型的防御能力。这种方法的主要目标是生成最小的扰动,使得原本被正确分类的样本在经过这种扰动后被误分类。

论文的核心内容包括以下几个关键点:

1. **背景与动机**:

深度学习模型的广泛应用伴随着对其鲁棒性的关注。由于深度网络对微小扰动的敏感性,确保其在实际环境中的稳健性成为亟待解决的问题。

2. **算法介绍**:

DeepFool基于优化理论,通过线性化逼近方法找到一个最小的扰动向量,这个向量使网络决策边界与原始样本之间的距离最小,从而导致预测错误。算法流程简洁,不需要大量的计算资源。

3. **优势与比较**:

相比于现有的对抗性攻击方法,如Fast Gradient Sign Method (FGSM)或Iterative Fast Gradient Sign Method (I-FGSM),DeepFool具有更高的准确性和效率。实验结果显示,DeepFool能更准确地生成对抗样本,并提高模型的鲁棒性评估的可靠性。

4. **实验结果**:

通过一系列详细的实验,DeepFool在计算对抗性扰动任务上表现出色,不仅能够在较小的扰动下诱导误分类,而且在大规模数据集上也展示出稳定性和准确性。

5. **实际应用与影响**:

这项工作不仅有助于理解和改进深度学习模型的防御机制,也为安全相关的领域(如网络安全、自动驾驶等)提供了评估模型鲁棒性的实用工具。

DeepFool算法作为深度学习领域的一个里程碑,它不仅揭示了深度模型的内在弱点,还提出了一种强大的工具来衡量和提升模型的抗攻击能力,这对于保护深度学习系统免受恶意攻击具有重要意义。

2021-08-19 上传

2019-03-03 上传

2023-05-27 上传

2023-05-27 上传

2023-04-01 上传

2023-02-26 上传

2023-04-02 上传

2023-11-20 上传

m0_50638822

- 粉丝: 0

- 资源: 5

最新资源

- BottleJS快速入门:演示JavaScript依赖注入优势

- vConsole插件使用教程:输出与复制日志文件

- Node.js v12.7.0版本发布 - 适合高性能Web服务器与网络应用

- Android中实现图片的双指和双击缩放功能

- Anum Pinki英语至乌尔都语开源词典:23000词汇会话

- 三菱电机SLIMDIP智能功率模块在变频洗衣机的应用分析

- 用JavaScript实现的剪刀石头布游戏指南

- Node.js v12.22.1版发布 - 跨平台JavaScript环境新选择

- Infix修复发布:探索新的中缀处理方式

- 罕见疾病酶替代疗法药物非临床研究指导原则报告

- Node.js v10.20.0 版本发布,性能卓越的服务器端JavaScript

- hap-java-client:Java实现的HAP客户端库解析

- Shreyas Satish的GitHub博客自动化静态站点技术解析

- vtomole个人博客网站建设与维护经验分享

- MEAN.JS全栈解决方案:打造MongoDB、Express、AngularJS和Node.js应用

- 东南大学网络空间安全学院复试代码解析