Hadoop源代码深度解析:分布式云计算核心技术剖析

版权申诉

64 浏览量

更新于2024-07-03

收藏 1.7MB DOC 举报

Hadoop源代码分析是一个深入研究Apache Hadoop项目的重要文档,它着重于Google的核心竞争技术在分布式云计算领域的应用和开源社区的响应。Hadoop源自Google的五个关键技术:Google Cluster(分布式计算平台)、Chubby(分布式锁服务)、GFS(Google文件系统)、BigTable(分布式数据存储系统)和MapReduce(大规模数据处理模型)。在Apache上,这些技术分别被Hadoop项目所吸收并进行了扩展:

1. Chubby被替换为ZooKeeper,后者成为Hadoop中管理分布式环境中的节点状态和协调服务的关键组件。

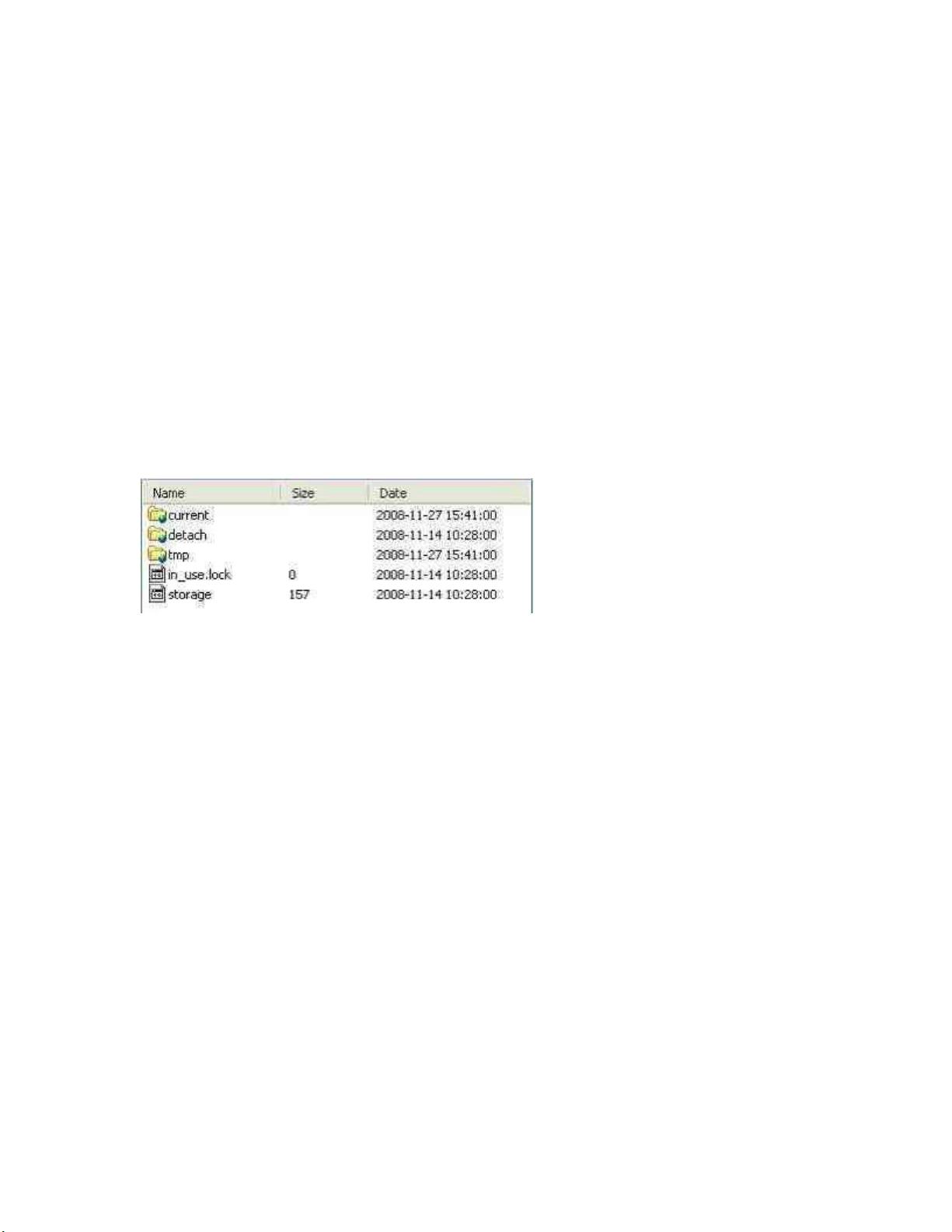

2. GFS演变成Hadoop Distributed File System (HDFS),作为分布式文件系统的基础,支持大规模的数据存储和访问。

3. BigTable的开源版本是HBase,主要应用于NoSQL数据库场景,提供高吞吐量和扩展性。

4. MapReduce的核心概念在Hadoop中得以保留,并在此基础上发展出了更广泛的分布式计算框架。

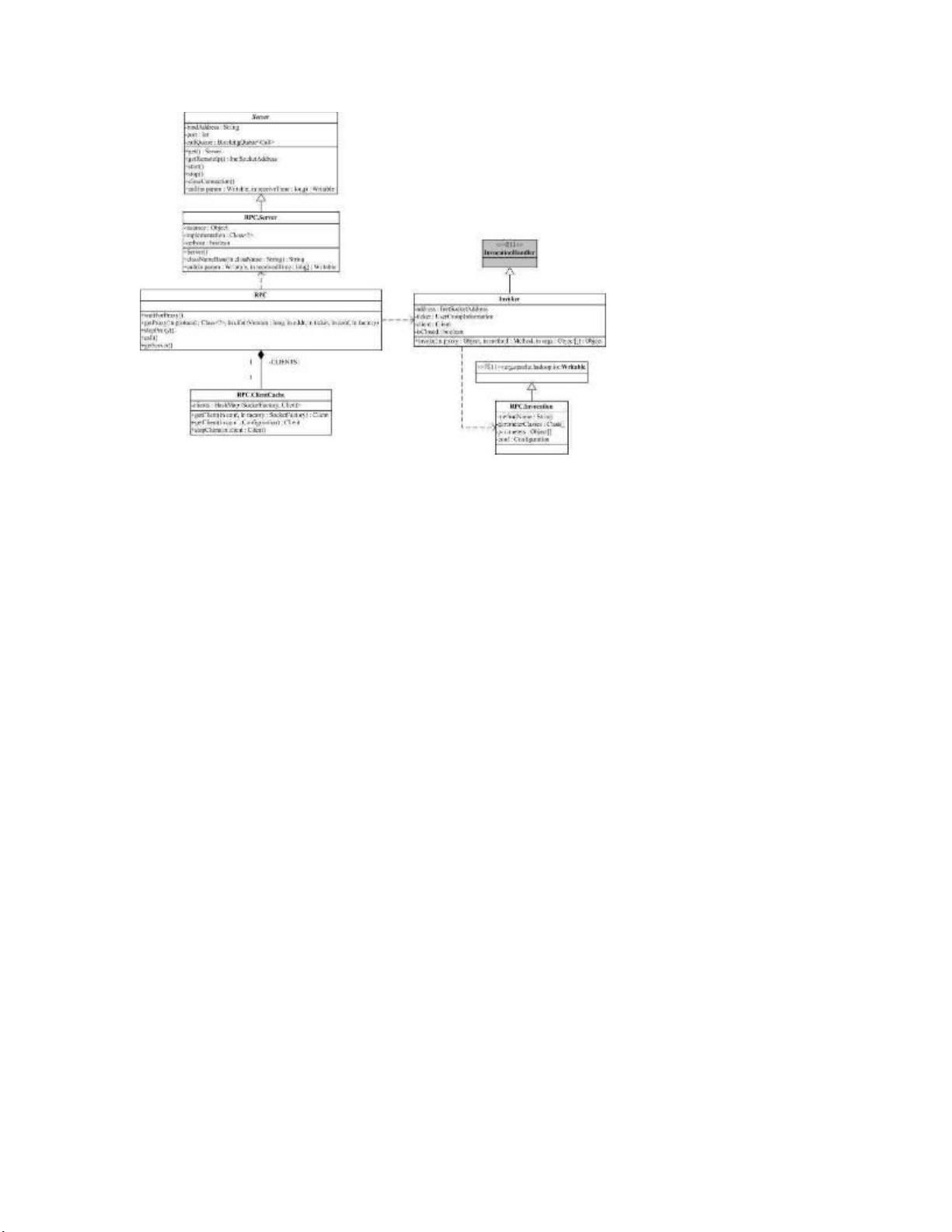

Hadoop的顶层包图展示了其复杂的设计结构,其中核心模块集中在蓝色部分,包括HDFS、MapReduce框架以及相关的工具包如Hadoop工具(Hadoop Tool),如DistCp用于数据复制和Archiver等。HDFS的API设计使得它可以跨越本地文件系统和云存储,导致包间的依赖关系错综复杂,形成了一种蜘蛛网式的架构。例如,配置管理模块(conf)依赖于文件系统(fs)包,因为配置文件的读取涉及文件操作,而文件系统功能在fs包中被抽象出来。

在分析Hadoop源代码时,开发者需要关注这些关键组件的实现原理,如分布式文件系统的高效复制机制、数据块的分布和存储策略,以及MapReduce的工作流程和数据划分算法。同时,理解如何利用Hadoop进行大数据处理,包括数据输入输出、任务调度、容错处理等也是至关重要的。Hadoop的生态系统还包括其他的开源项目,如Facebook的Hive,用于数据分析和ETL(提取、转换、加载)操作。

通过深入分析Hadoop源代码,开发者不仅可以掌握分布式计算技术的精髓,还能为实际项目开发和优化提供有价值的参考,从而在大数据处理领域取得成功。

2021-09-06 上传

2020-01-19 上传

2024-04-22 上传

2024-04-30 上传

2024-03-27 上传

2023-12-03 上传

2023-09-11 上传

2023-07-08 上传

2023-06-03 上传

产品经理自我修养

- 粉丝: 236

- 资源: 7718

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能