递归神经网络解析:训练与优化策略探索

167 浏览量

更新于2024-08-27

收藏 377KB PDF 举报

"深入探究递归神经网络:大牛级的训练和优化如何修成?"

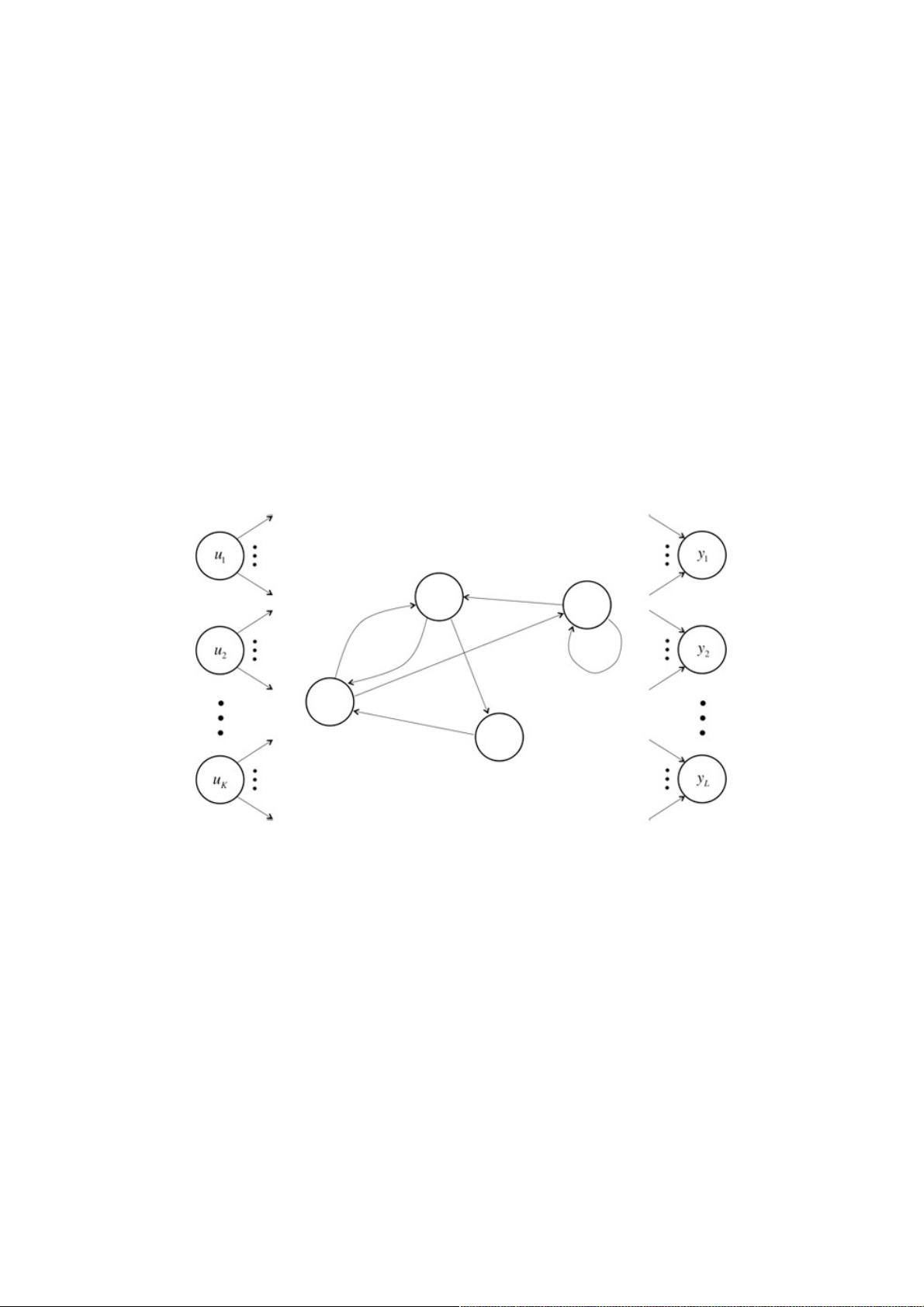

递归神经网络(RNN)是深度学习领域中一种特殊的神经网络结构,旨在处理序列数据,如时间序列或文本数据。与传统的前馈神经网络(FNN)相比,RNN通过引入定向循环,使得信息可以在网络中向前和向后传递,从而能够捕捉到序列中的长期依赖关系。

在FNN中,信息从输入层经过隐藏层直接流向输出层,这种单向传播方式限制了网络处理动态变化或序列数据的能力。然而,RNN允许信息在隐藏层内部循环,每个时间步的输出不仅依赖于当前的输入,还依赖于前面时间步的状态,这使得RNN能记忆之前的上下文信息,对序列中的顺序关系进行建模。

RNN的结构包括输入单元、隐藏单元和输出单元。输入单元接收序列数据,隐藏单元负责存储和处理信息,而输出单元根据隐藏单元的状态生成序列的对应输出。隐藏单元的状态在每个时间步都会更新,这个更新过程通常通过一个称为长短期记忆(LSTM)或门控循环单元(GRU)的机制来控制,以解决传统RNN中梯度消失或梯度爆炸的问题。

在训练RNN时,由于存在循环结构,反向传播算法会变得更加复杂。传统的反向传播算法不能有效地处理这种循环结构,导致训练困难。为了解决这个问题,研究人员发展出了诸如教师强制(teacher forcing)、门控机制(gates)以及变种模型,如双向RNN(Bidirectional RNN)和堆叠RNN(Stacked RNN),以增强RNN的学习能力和泛化性能。

优化RNN的过程通常涉及到调整超参数、使用更高级的优化算法(如Adam或RMSprop)、正则化策略(如权重衰减)以及处理序列数据的不同策略,比如截断反向传播(truncated backpropagation through time, BPTT)。此外,为了应对训练中的梯度消失问题,有时会采用更深层次的RNN结构,或者结合注意力机制(Attention Mechanism)来提高模型对序列不同部分的关注程度。

RNN已经在自然语言处理(NLP)、语音识别、机器翻译、音乐生成等多个领域取得了显著的成果。例如,LSTM模型在语言建模和文本生成方面表现出色,能够理解和生成复杂的语言结构。而GRU则因其相对简单的结构和接近LSTM的表现,成为许多应用的首选。

递归神经网络通过其独特的循环结构和一系列优化技术,成为了处理序列数据的强大工具。虽然训练和优化RNN仍面临挑战,但持续的研究和创新正在不断推动这一领域的进步。

134 浏览量

507 浏览量

1496 浏览量

839 浏览量

314 浏览量

954 浏览量

1177 浏览量

885 浏览量

695 浏览量

weixin_38621897

- 粉丝: 6

最新资源

- 微信小程序项目源码分享与解析

- Android中Handler与子线程实现计时方法

- AntiFreeze:永不卡死的高效任务管理器

- DPS系统7.05版本发布:全面升级的统计分析软件

- 记忆卡游戏:HTML制作的互动记忆练习工具

- 易语言实现EXCEL数据与MYSQL数据库交互操作教程

- 掌握数据科学核心技能的哈佛专业证书课程

- C#实现仿Windows记事本功能及特色工具集成

- 全面覆盖BAT Java面试题及详解

- H5音乐播放器模板开发:一站式网页音乐体验

- rcsslogplayer-15.1.0版本发布:全新的日志播放器

- 邮件服务库SendGrid、PostMark、MailGun和Mandrill使用教程

- perseid博客引擎:使用Meteor打造的早期原型

- 创建干净简洁的投资组合网站:mike.lastorbit.co的Jekyll主题指南

- LM2596双路稳压电源设计与完整AD工程资料

- FunPlane打飞机小游戏开发体验分享