Hadoop HDFS知识精要:设计与概念解析

180 浏览量

更新于2024-08-27

收藏 293KB PDF 举报

"本文总结了HDFS的关键知识点,包括HDFS的定义、设计原则、数据块概念、节点类型、HDFS联邦以及高可用性特性。"

HDFS,全称Hadoop分布式文件系统,是一种大规模分布式存储系统,专为处理大规模数据而设计。它以流式数据访问模式存储超大文件,适应于商业硬件环境,允许文件跨越多台计算机存储。然而,HDFS并不适合需要低延迟数据访问、存储大量小文件或支持多用户写入和随意修改文件的场景。

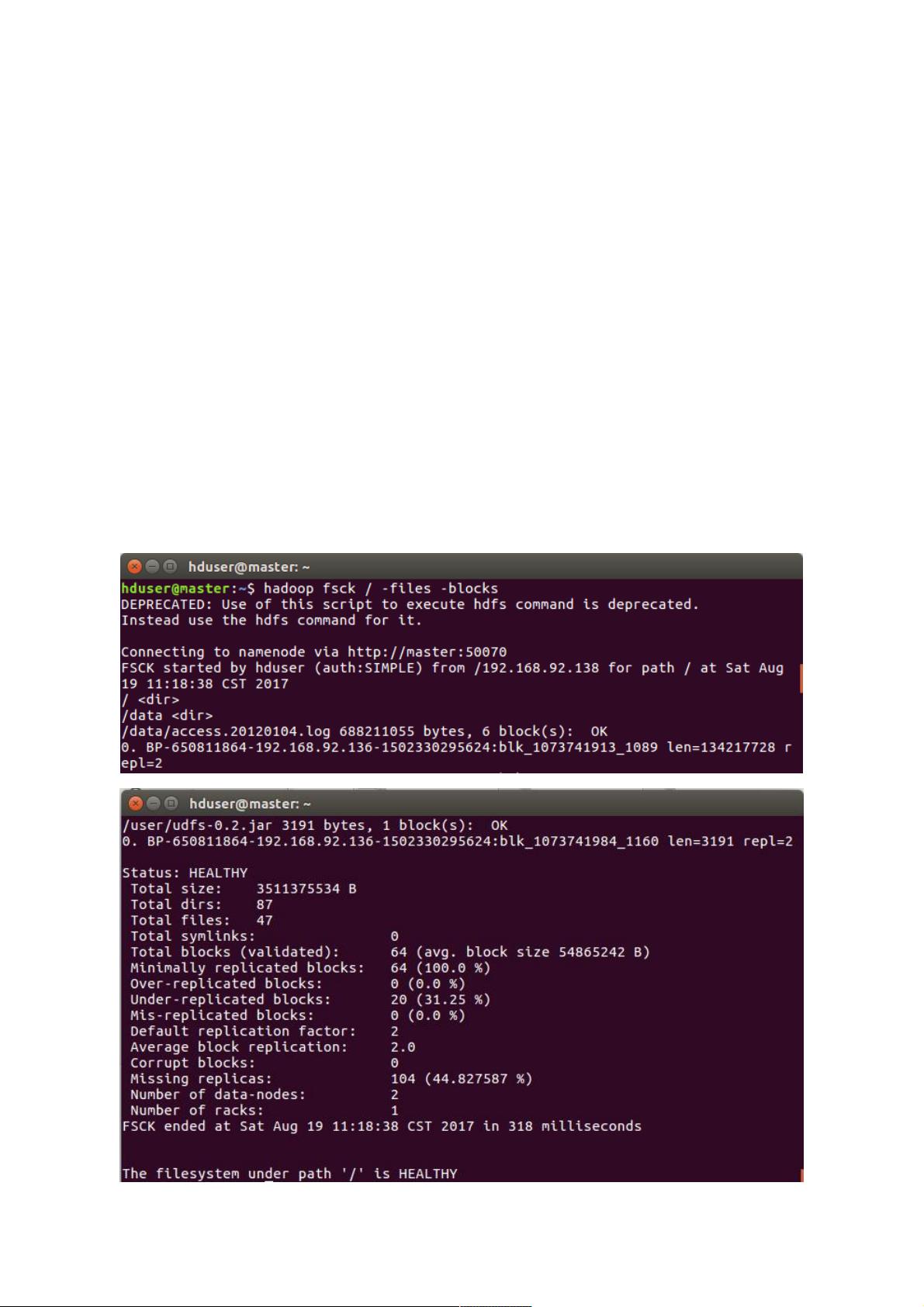

HDFS的核心设计之一是数据块。文件被分割成固定大小的数据块,默认为64MB,便于在集群中的不同节点间分散存储。这种设计提高了存储效率,允许文件超过单个磁盘容量,并且支持数据冗余备份,增强了系统的容错性和可用性。用户可以通过HDFS命令行工具查看文件的数据块信息。

HDFS的运行依赖于三种核心节点:Namenode、Datanode和SecondaryNamenode。Namenode是整个文件系统的元数据管理者,它存储文件系统命名空间和数据块映射信息。Datanode是实际存储数据的地方,它们向Namenode报告存储的块信息,并按需提供数据读写服务。SecondaryNamenode并非备用的Namenode,而是协助主Namenode定期保存元数据快照,防止数据丢失。

为了提高可扩展性和可用性,HDFS引入了Federation(联邦)机制。在HDFS联邦中,多个Namenode各自管理文件系统命名空间的一部分,每个Namenode负责一部分文件和数据块,这降低了单一Namenode的压力,增强了系统的整体性能。

HDFS的高可用性(HA)特性是通过设置一对活动-备用的Namenode实现的。正常情况下,活动Namenode处理所有客户端请求,而备用Namenode处于监控状态。一旦活动Namenode出现故障,备用Namenode能快速接管,确保服务的连续性,从而避免了单点故障的问题。

HDFS是大数据处理的重要基础设施,其设计理念和特性使得它能够高效、可靠地处理海量数据,是Hadoop生态系统中的关键组成部分。理解HDFS的工作原理对于开发、管理和优化大规模数据处理系统至关重要。

5123 浏览量

2024-12-15 上传

101 浏览量

119 浏览量

2023-09-16 上传

2022-11-24 上传

2022-11-24 上传

2022-11-24 上传

weixin_38586942

- 粉丝: 4

- 资源: 878