等保2.0三级与1.0对比:四大安全领域详解

等保2.0与1.0在网络安全等级保护中的差异主要体现在基本要求通用要求技术部分的结构调整和控制点的具体要求上。从三级等保的角度来看,变化尤为显著。

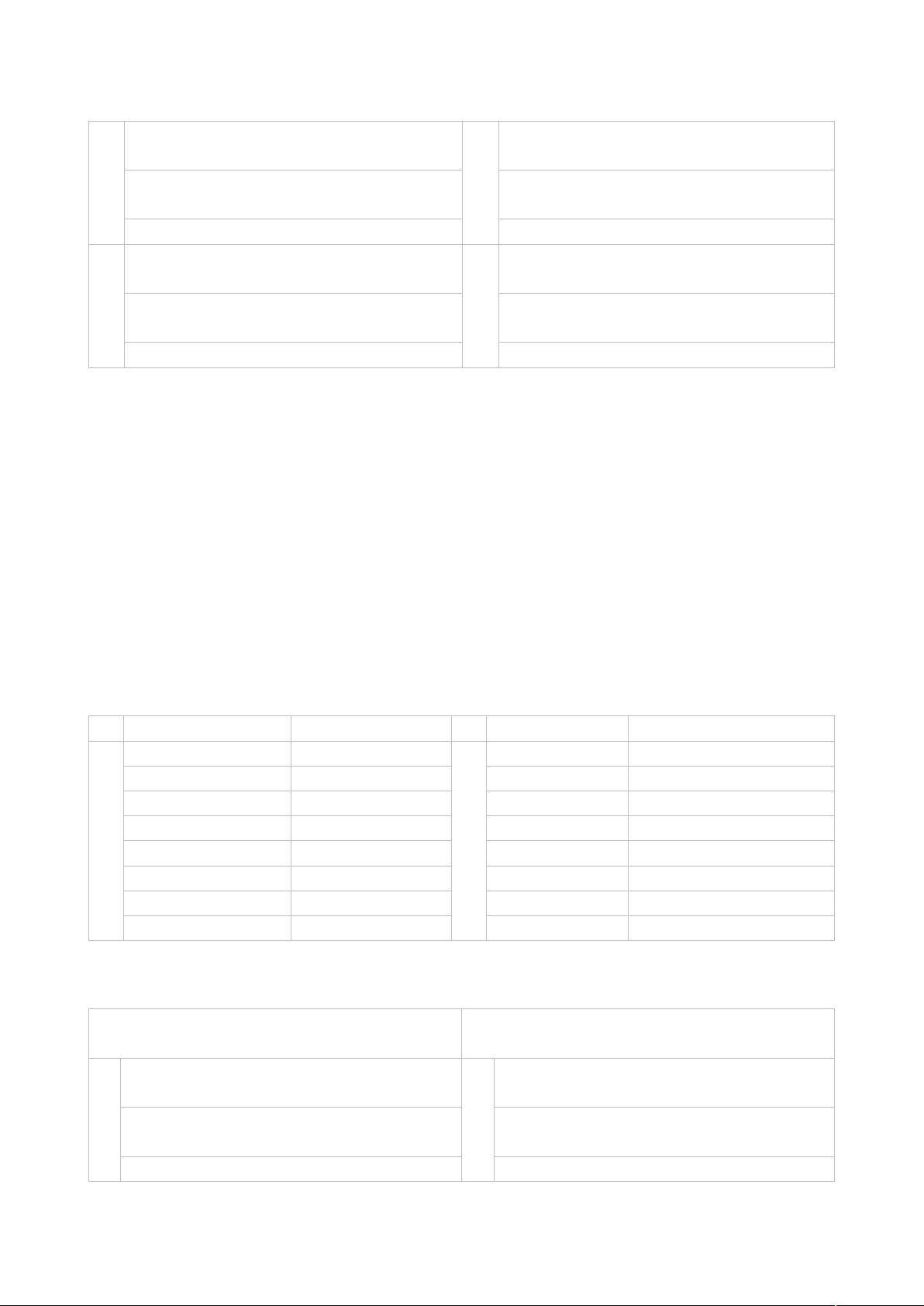

首先,等保2.0将原有的五个层面(物理安全、网络安全、主机安全、应用安全、数据安全)整合为四个部分:物理和环境安全、网络和通信安全、设备和计算安全、应用和数据安全。这样的调整使得安全要求更加聚焦,避免了重复和冗余,提升了管理效率。

1. 物理和环境安全:虽然控制点的数量从32项减少到22项,但对机房设施的要求保持不变,强调物理位置选择、物理访问控制等关键要素,确保基础设施的安全稳定。

2. 网络和通信安全:新标准减少了结构安全、边界完整性检查、网络设备防护这三个控制点,但新增了网络架构、通信传输、边界防护和集中管控。例如,部分原本在结构安全中的要求被纳入网络架构,通信完整性和保密性则整合到了通信传输中,边界防护和访问控制的要求也有所调整。

3. 设备和计算安全:主机安全中的剩余信息保护被删除,扩展到了网络设备和安全设备的保护范围,共26项要求,更加全面地覆盖了IT设备的安全保障。

4. 应用和数据安全:合并了原有应用安全和数据安全及备份恢复,减少了通信完整性、通信保密性和抗抵赖的控制点,同时增加了个人信息保护,强化了数据保护和用户隐私的重视。通信完整性和保密性现在归于网络和通信安全的通信传输部分。

总体来说,等保2.0三级标准在保证原有安全要求的基础上,更加注重系统整体和细分层面的综合防护,旨在提升网络安全防护的精细化和有效性。企业进行等保2.0升级时,不仅需要关注控制点数量的变化,更需深入理解每个层面的新要求,确保网络安全管理体系的适应性和实用性。

1100 浏览量

336 浏览量

569 浏览量

2024-10-19 上传

136 浏览量

146 浏览量

2023-06-11 上传

黯夜飞影

- 粉丝: 1

- 资源: 5

最新资源

- Google+C++编程风格指南.pdf

- red hat linux 命令

- MinGW的使用指南

- 不要害怕指针.pdf

- 安装 Integration Services

- 杜比 AC-3音频编码技术

- 蓝牙联网五子棋对战游戏分析

- Modeling Our World

- Java蓝牙无线通讯技术API

- 单片机开发40实例(汇编跟C相互对照 完整电路图)

- Java In a nutshell

- 信息系统分析与设计课程设计

- RequisitePro使用简介

- The Object Primer 2nd Edition

- SimDriveline User's Guide

- SGH-i728_QSG_CH_Rev.1.0_080321