逻辑回归详解:分类利器,优点与正则化

需积分: 0 191 浏览量

更新于2024-08-05

收藏 708KB PDF 举报

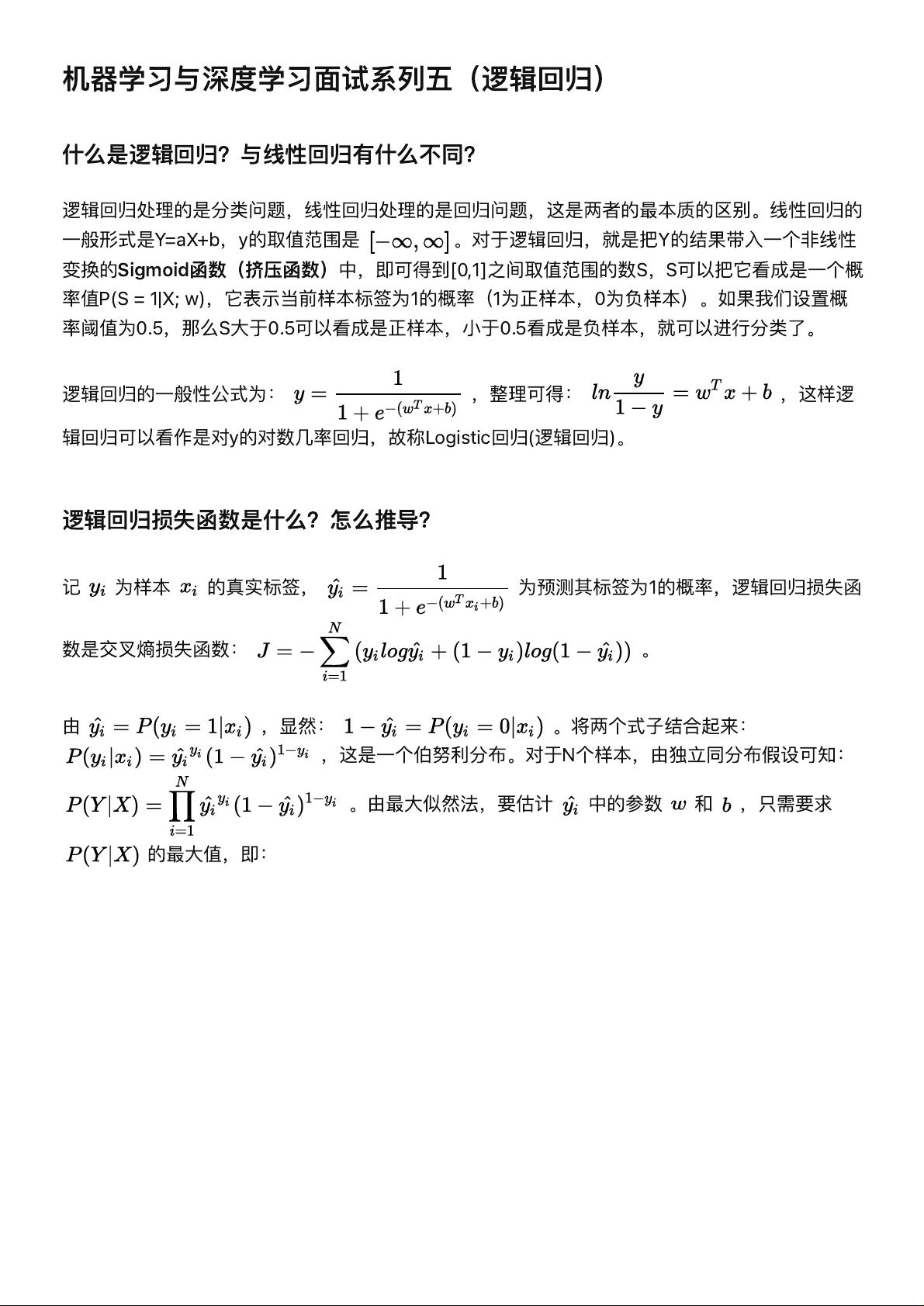

逻辑回归是机器学习领域中一种用于解决分类问题的统计模型,它在许多场景下表现出良好的性能。与线性回归的主要区别在于处理任务的性质:线性回归关注连续变量的预测,而逻辑回归则专注于二分类问题,将连续的输出通过Sigmoid函数映射到[0,1]的概率空间,从而实现类别判断。

逻辑回归的公式表达了一种对数几率回归的思想,通过输入特征x和权重w计算预测概率P(S=1|X;w)。损失函数采用交叉熵损失,即伯努利分布的负对数似然,这个函数在最大化似然估计时用于估计模型参数。优化过程通常使用梯度下降等优化算法,使得损失函数最小化。

逻辑回归的优点包括:

1. **强健的线性关系**:它对线性关系较强的数据表现良好,能够捕捉到简单的决策边界。

2. **抗噪声能力**:由于概率输出,逻辑回归能够更好地处理数据中的噪声,即使存在不准确或缺失的数据点,依然能给出相对可靠的预测。

3. **计算效率**:相比于复杂的深度学习模型,逻辑回归的训练速度较快,适合处理大规模数据集。

4. **概率输出**:逻辑回归不仅能做出0或1的硬判决,还能提供预测结果的概率,这对于排序任务(ranking model)很有用。

正则化是逻辑回归防止过拟合的重要手段,主要有L1和L2正则化。L1正则化通过添加权重绝对值的惩罚项,鼓励模型产生稀疏解;L2正则化则通过平方和惩罚,使权重向量趋向于零但不为零,有助于保持模型参数的稳定。

特征离散化是逻辑回归中的一个重要实践,它可以提高模型的鲁棒性,减少异常值的影响,并帮助模型在处理非连续特征时更好地理解和建模。例如,将年龄这一连续特征转化为离散区间,可以使模型对年龄变化更敏感,同时也降低了模型复杂性,减小过拟合的风险。

对于多分类问题,逻辑回归可以扩展为多项逻辑回归(Softmax Regression),通过softmax函数将输出转换为多个类别的概率分布,从而支持多类别分类。这表明逻辑回归并非只能局限于二分类,而是可以通过适当的变形适用于不同的分类场景。

2021-09-30 上传

2022-08-03 上传

点击了解资源详情

2023-07-14 上传

2022-08-03 上传

2017-09-26 上传

2021-02-04 上传

2022-01-11 上传

点击了解资源详情

宝贝的麻麻

- 粉丝: 40

- 资源: 294

最新资源

- 开源通讯录备份系统项目,易于复刻与扩展

- 探索NX二次开发:UF_DRF_ask_id_symbol_geometry函数详解

- Vuex使用教程:详细资料包解析与实践

- 汉印A300蓝牙打印机安卓App开发教程与资源

- kkFileView 4.4.0-beta版:Windows下的解压缩文件预览器

- ChatGPT对战Bard:一场AI的深度测评与比较

- 稳定版MySQL连接Java的驱动包MySQL Connector/J 5.1.38发布

- Zabbix监控系统离线安装包下载指南

- JavaScript Promise代码解析与应用

- 基于JAVA和SQL的离散数学题库管理系统开发与应用

- 竞赛项目申报系统:SpringBoot与Vue.js结合毕业设计

- JAVA+SQL打造离散数学题库管理系统:源代码与文档全览

- C#代码实现装箱与转换的详细解析

- 利用ChatGPT深入了解行业的快速方法论

- C语言链表操作实战解析与代码示例

- 大学生选修选课系统设计与实现:源码及数据库架构