点云处理详解:PointNet++深度学习框架

需积分: 0 100 浏览量

更新于2024-06-20

收藏 2.33MB PDF 举报

"PointNet++总结"

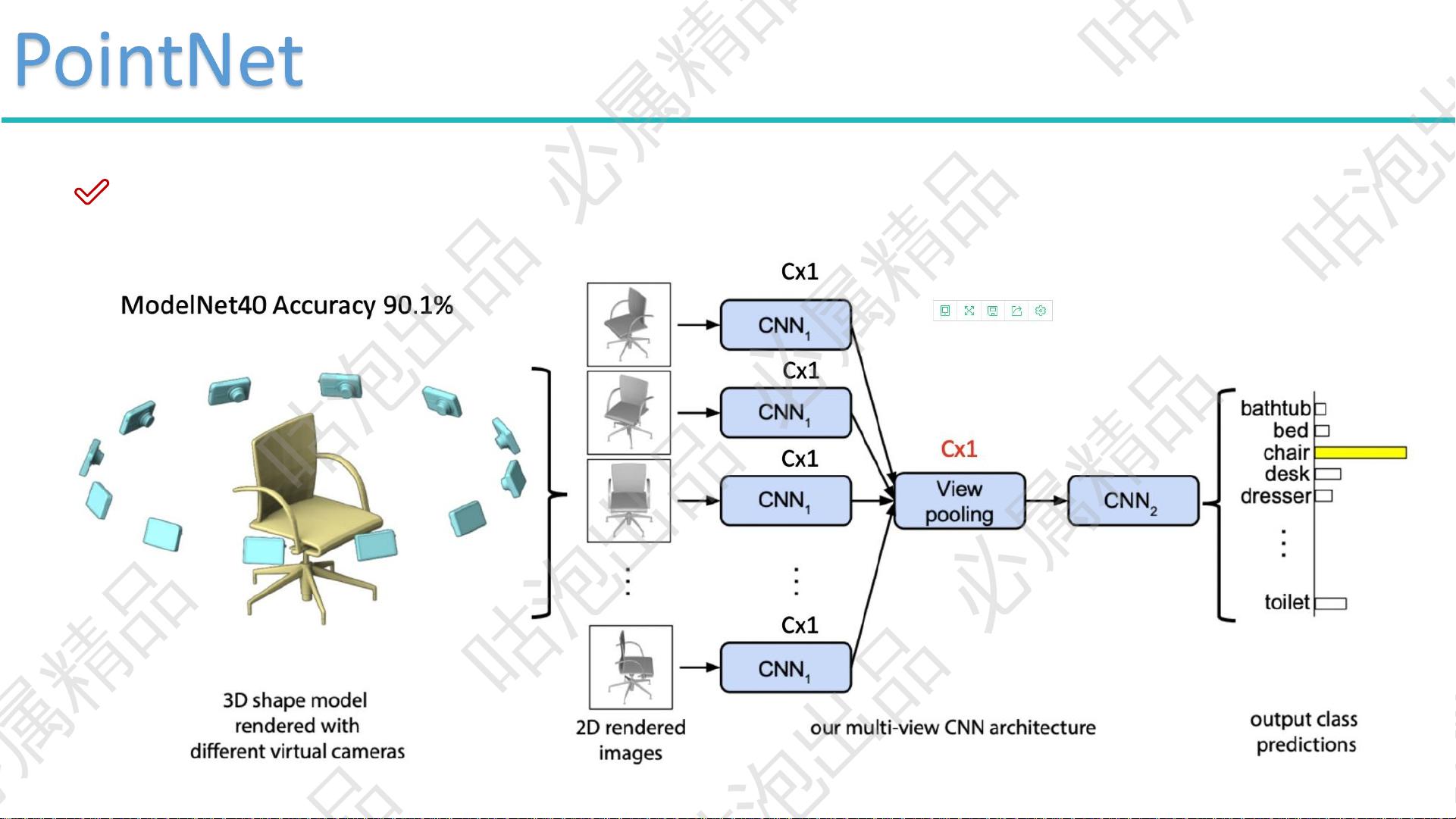

点云数据处理在3D计算机视觉和机器学习领域中扮演着关键角色。PointNet++是一种针对3D点云数据的深度学习框架,它扩展了原始的PointNet设计,旨在更好地捕捉局部结构并进行特征学习。本文将对PointNet++的关键概念和应用进行深入探讨。

首先,3D数据通常由传感器如激光雷达或RGB-D相机扫描获取,形成无序的点云数据。这种数据的特点是无序性和近密远疏的特性,即点的位置排列没有固定顺序,且由于扫描和观察角度的影响,靠近传感器的点密度较高,远离的点密度较低。由于这些特性,传统的基于图像的卷积神经网络(CNN)无法直接应用于点云数据。

PointNet++的设计目标是解决点云数据的无序性和非结构化问题,同时保持模型的置换不变性。PointNet的基本出发点是利用最大值池化(Max Pooling)操作来实现这种不变性,但这种方法可能会丢失大量的局部信息。为了解决这个问题,PointNet++引入了多尺度分组(Multi-Scale Grouping,MSG)和递归神经网络(Recursive Neural Network,RNN)结构。

多尺度分组策略允许模型在不同尺度上对邻域内的点进行聚类,从而捕捉到不同范围的局部特征。通过递归地应用这一过程,PointNet++可以逐级构建更复杂的特征表示,从而保留更多的局部细节。在每一层,每个点的特征不仅来自自身,还来自其邻域内其他点的特征,这样的设计有助于保留更多原始数据的丰富信息。

在点的特征学习过程中,PointNet++首先对每个点进行高维映射,如将每个3D坐标点映射到1024维的空间。然后,通过Max Pooling操作在每个点的邻域内选取最大特征,形成一个局部特征向量。这个过程被重复执行,形成多级的特征表示,使得模型能够捕捉到从局部到全局的不同层次的上下文信息。

PointNet++在多种3D任务中表现出色,包括分类、部件分割和场景分割。在场景分割任务中,模型需要预测每个点所属的类别,而在部件分割任务中,模型则需识别物体的各个部分。通用网络架构允许PointNet++灵活适应这些不同的任务需求。

PointNet++通过创新的点云处理方法,克服了点云数据的挑战,实现了有效的特征学习。这一框架不仅在学术界受到广泛关注,也在实际应用中展现出强大的潜力,如自动驾驶、3D重建和虚拟现实等领域。对于希望深入理解3D深度学习的开发者和研究人员来说,掌握PointNet++的原理和应用是非常有价值的。

2022-07-25 上传

2018-12-26 上传

2021-10-18 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

Huangqc.

- 粉丝: 0

- 资源: 1

最新资源

- StarModAPI: StarMade 模组开发的Java API工具包

- PHP疫情上报管理系统开发与数据库实现详解

- 中秋节特献:明月祝福Flash动画素材

- Java GUI界面RPi-kee_Pilot:RPi-kee专用控制工具

- 电脑端APK信息提取工具APK Messenger功能介绍

- 探索矩阵连乘算法在C++中的应用

- Airflow教程:入门到工作流程创建

- MIP在Matlab中实现黑白图像处理的开源解决方案

- 图像切割感知分组框架:Matlab中的PG-framework实现

- 计算机科学中的经典算法与应用场景解析

- MiniZinc 编译器:高效解决离散优化问题

- MATLAB工具用于测量静态接触角的开源代码解析

- Python网络服务器项目合作指南

- 使用Matlab实现基础水族馆鱼类跟踪的代码解析

- vagga:基于Rust的用户空间容器化开发工具

- PPAP: 多语言支持的PHP邮政地址解析器项目