使用多线程实现HTTP并发爬虫的策略解析

"文档讲述了如何使用多线程实现HTTP并发请求,主要应用于网络爬虫的高效数据抓取。通过创建待下载和已下载URL的集合,利用C#的HttpWebRequest和HttpWebResponse类进行HTTP请求和响应,并通过控制并发数量来提高下载效率。"

在进行网络爬虫开发时,多线程HTTP并发请求是一种常见的优化策略,可以显著提升数据抓取速度。本文档详细介绍了如何实现这一策略。

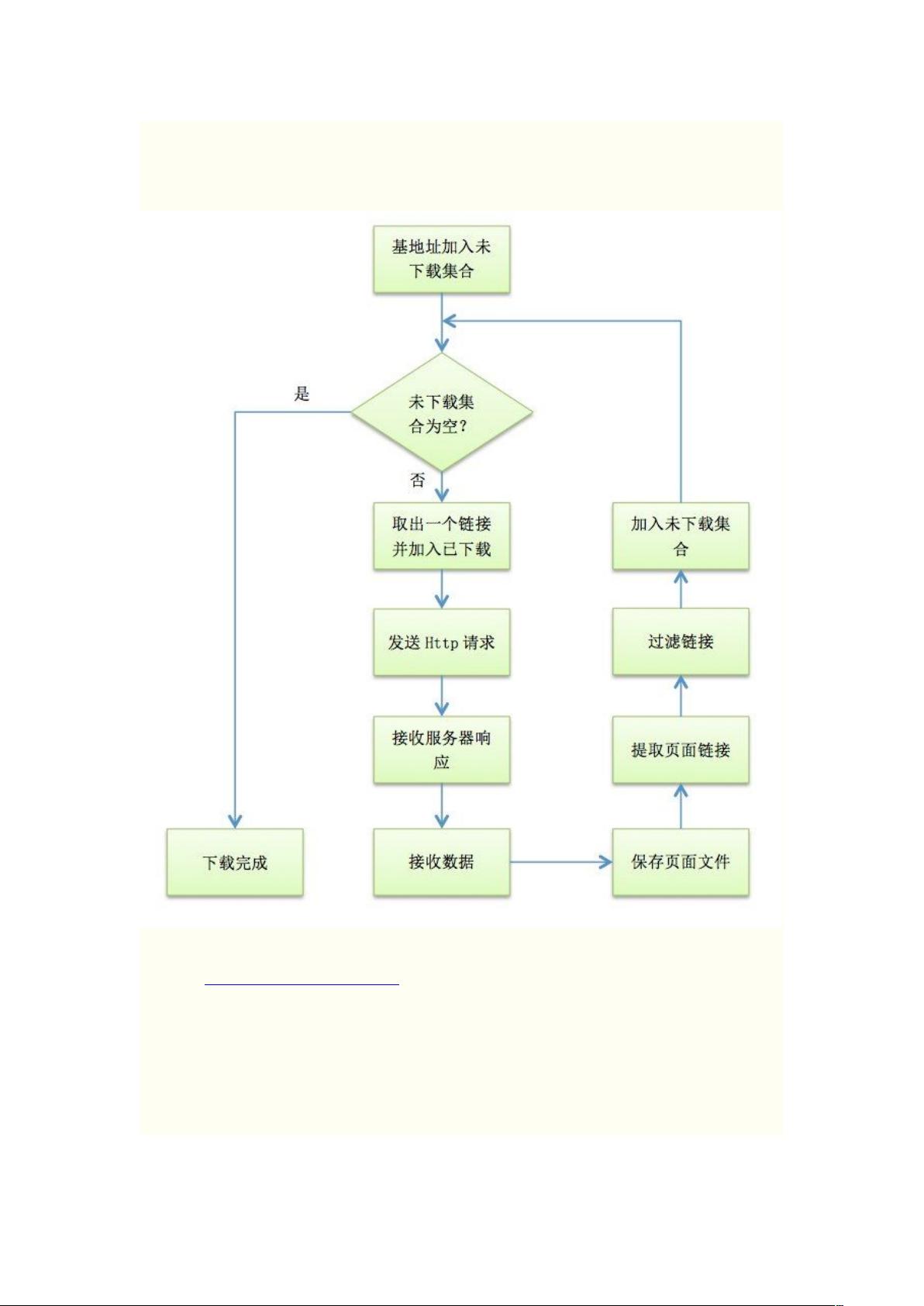

首先,爬虫的工作流程通常包括以下几个步骤:

1. 初始化:设定起始URL(种子URL)和需要跟踪的URL集合。

2. 下载与解析:使用HTTP请求获取页面内容,然后解析HTML或其他格式的数据,提取出新的链接。

3. URL管理:将新发现的URL添加到待下载集合,同时避免重复下载,可以使用Dictionary来存储URL及其深度信息。

4. 并发下载:通过多线程或异步请求,同时处理多个URL,提高下载效率。

5. 循环迭代:持续检查待下载集合,直到所有URL都被处理。

在C#中,`HttpWebRequest`和`HttpWebResponse`是用于发送HTTP请求和接收响应的类。为了实现并发请求,可以创建多个工作实例,每个实例对应一个逻辑工作线程。这些实例通过异步请求方法来并发下载资源,以减少等待时间。文档中使用了一个名为 `_reqsBusy` 的布尔数组来标记工作实例的状态,当一个实例完成任务后,将其标记为“空闲”,并调用 `DispatchWork` 函数重新分配任务。

并发控制的关键在于平衡资源利用率和系统负载。例如,文档中设置了一个固定的工作实例数量 `_reqCount`,通过循环检查哪些实例当前是空闲的,并分配新的URL请求。当一个工作实例完成HTTP请求后,对应的 `_reqsBusy[i]` 设置为 `false`,然后再次调用 `DispatchWork` 分配新的URL,确保并发下载的执行。

在实际应用中,可以根据服务器的限制和网络状况动态调整并发数。此外,还需要考虑异常处理、重试机制以及速率控制,以确保爬虫的稳定性和对目标网站的影响最小化。

多线程HTTP并发请求是网络爬虫高效运作的关键技术之一,它能有效提高数据抓取速度,但同时也需要谨慎处理并发控制和资源管理,以防止对目标服务器造成过大的压力。

2018-12-22 上传

2020-12-23 上传

2010-05-29 上传

2010-08-12 上传

2021-11-23 上传

2022-07-09 上传

2021-10-07 上传

2021-10-10 上传

whs8316

- 粉丝: 1

- 资源: 22

最新资源

- Fisher Iris Setosa数据的主成分分析及可视化- Matlab实现

- 深入理解JavaScript类与面向对象编程

- Argspect-0.0.1版本Python包发布与使用说明

- OpenNetAdmin v09.07.15 PHP项目源码下载

- 掌握Node.js: 构建高性能Web服务器与应用程序

- Matlab矢量绘图工具:polarG函数使用详解

- 实现Vue.js中PDF文件的签名显示功能

- 开源项目PSPSolver:资源约束调度问题求解器库

- 探索vwru系统:大众的虚拟现实招聘平台

- 深入理解cJSON:案例与源文件解析

- 多边形扩展算法在MATLAB中的应用与实现

- 用React类组件创建迷你待办事项列表指南

- Python库setuptools-58.5.3助力高效开发

- fmfiles工具:在MATLAB中查找丢失文件并列出错误

- 老枪二级域名系统PHP源码简易版发布

- 探索DOSGUI开源库:C/C++图形界面开发新篇章