TensorRT深度优化:8bit量化与语义分割实战

需积分: 50 125 浏览量

更新于2024-07-18

1

收藏 1.29MB PDF 举报

本篇文章主要探讨了TensorRT在深度学习推理加速中的应用,特别是在8位量化(INT8)语义分割领域的实践。作者Joohoon Lee和Chethan Ningaraju针对自动驾驶场景中的语义分割任务,选择了Cityscapes数据集进行研究。Cityscapes是一个专门用于评估自动驾驶车辆对城市街景理解能力的数据集,包含19种不同的类别,如道路、建筑物等。

文章首先介绍了语义分割的基本概念,即通过将图像中的像素分为属于同一对象类别的簇。马丁·托马(Martin Thoma)在其关于语义分割的调查报告中对此进行了详细的阐述。在实际应用中,作者着重考虑了NVIDIA的OpenRoadNet,这可能是他们构建和优化模型的基础。

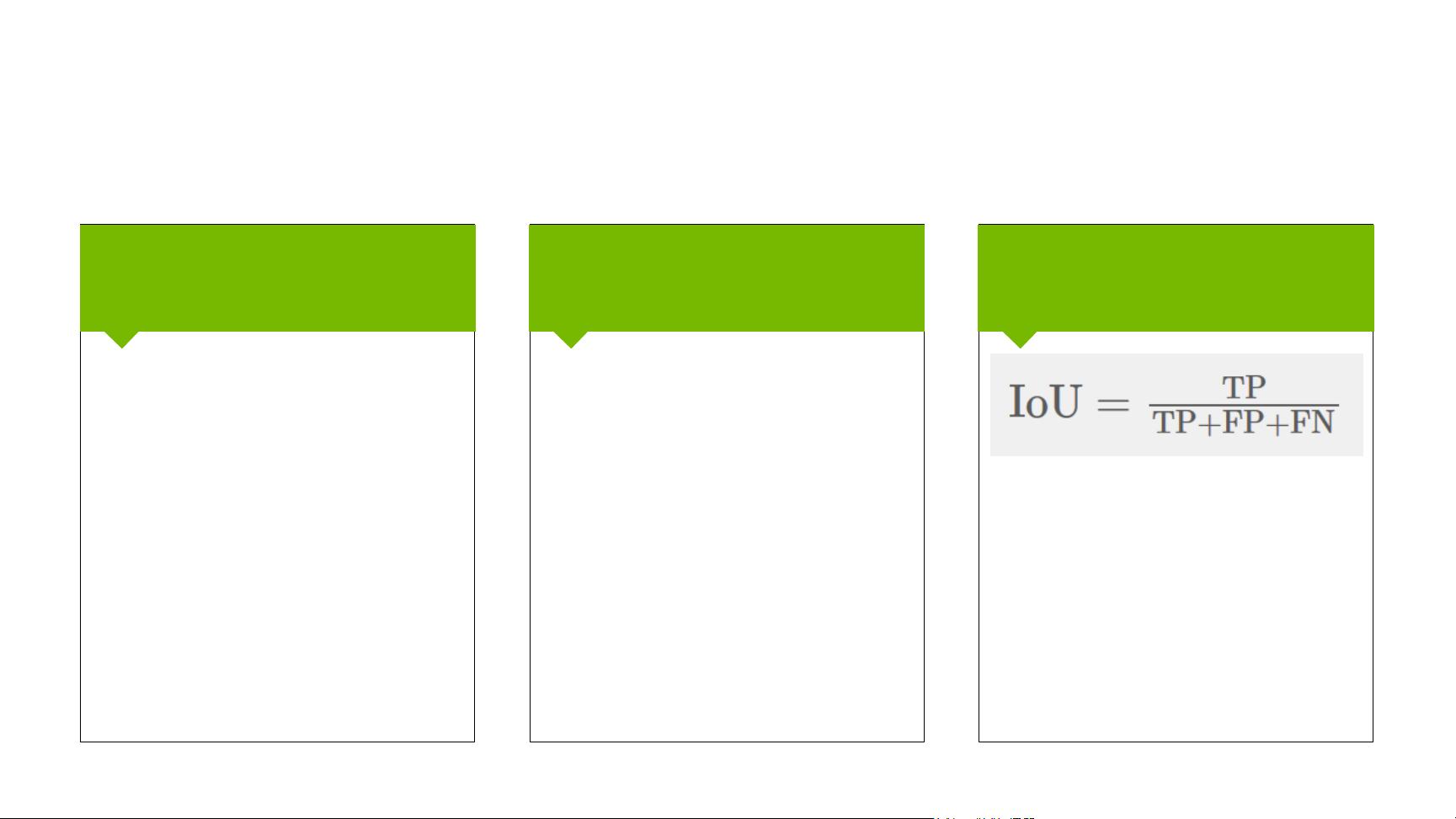

接下来,文章将焦点转移到TensorRT上,这是一种由NVIDIA开发的高性能深度学习推理优化工具。文章分两个部分详细讨论了TensorRT的部署:首先是全精度(FP32)部署,它通常在计算资源充足的情况下使用浮点数,能够提供较高的精度;然后是INT8部署,通过量化技术降低内存占用和计算成本,实现更高效的推理性能。

在介绍TensorRT的INT8部署时,文章可能涉及如何将预训练的FCN变体网络( Fully Convolutional Networks,一种常用于语义分割的架构)转换为TensorRT兼容的模型,以及如何利用Caffe和CUDA的深度学习库进行性能测试,尤其是在NVIDIA的Drive PX 2平台上。

文章最后还可能包括了使用TensorRT进行INT8量化后,与使用Caffe和CUDNN的传统方法在性能上的比较,以及基本的背景信息和动手操作环节,让读者了解如何在实际项目中有效地利用TensorRT来提高自动驾驶语义分割的推理速度和能效。

这篇文章深入浅出地讲解了如何利用TensorRT的Python API在汽车领域进行8位量化语义分割,提供了丰富的案例研究和实用技巧,对于希望在实际应用中提升深度学习推理效率的开发者和技术人员具有很高的参考价值。

2022-06-16 上传

2024-10-20 上传

2023-05-15 上传

2019-06-18 上传

2023-12-11 上传

2023-09-27 上传

2019-08-09 上传

Law-Yao

- 粉丝: 422

- 资源: 4

最新资源

- Learning Perl_5th

- pv金典 操作系统 详细介绍

- 软件评测复习知识点(小颖)

- UML 精華第三版(uml 教程)

- Design_and_implementation_of_zero-copy_data_path_for_efficient_file_transmission

- WIN CE 5.0说明书

- SUN认证JAVA程序员考试大纲

- 知道怎么测试手机的JAVA性能

- COM Specification(COM规范)

- 软件设计模式简单介绍

- 单片机电阻电容在线测试

- MCS51单片机与键盘显示器微型打印机接口

- 单元测试,对需要单元测试的人有帮助

- 专家系统外壳的数据库设计

- 完美程式设计指南--一部超级经典的参考书。不能错过

- 电信计费系统oracle操作手册.doc