统一框架:多视角多类别目标位姿估计新方法

136 浏览量

更新于2024-06-20

收藏 1.12MB PDF 举报

"多视角多类别目标位姿估计的统一框架"

本文主要探讨的是在目标位姿估计领域中,如何建立一个能够处理多种类别物体、适应多视角情况的统一框架。位姿估计,尤其是六自由度(6-DoF)位姿估计,对于机器人操作、导航、增强现实和自动驾驶等众多应用至关重要。当前的方法尽管众多,但在处理大量对象时的可扩展性和准确性仍有待提升。

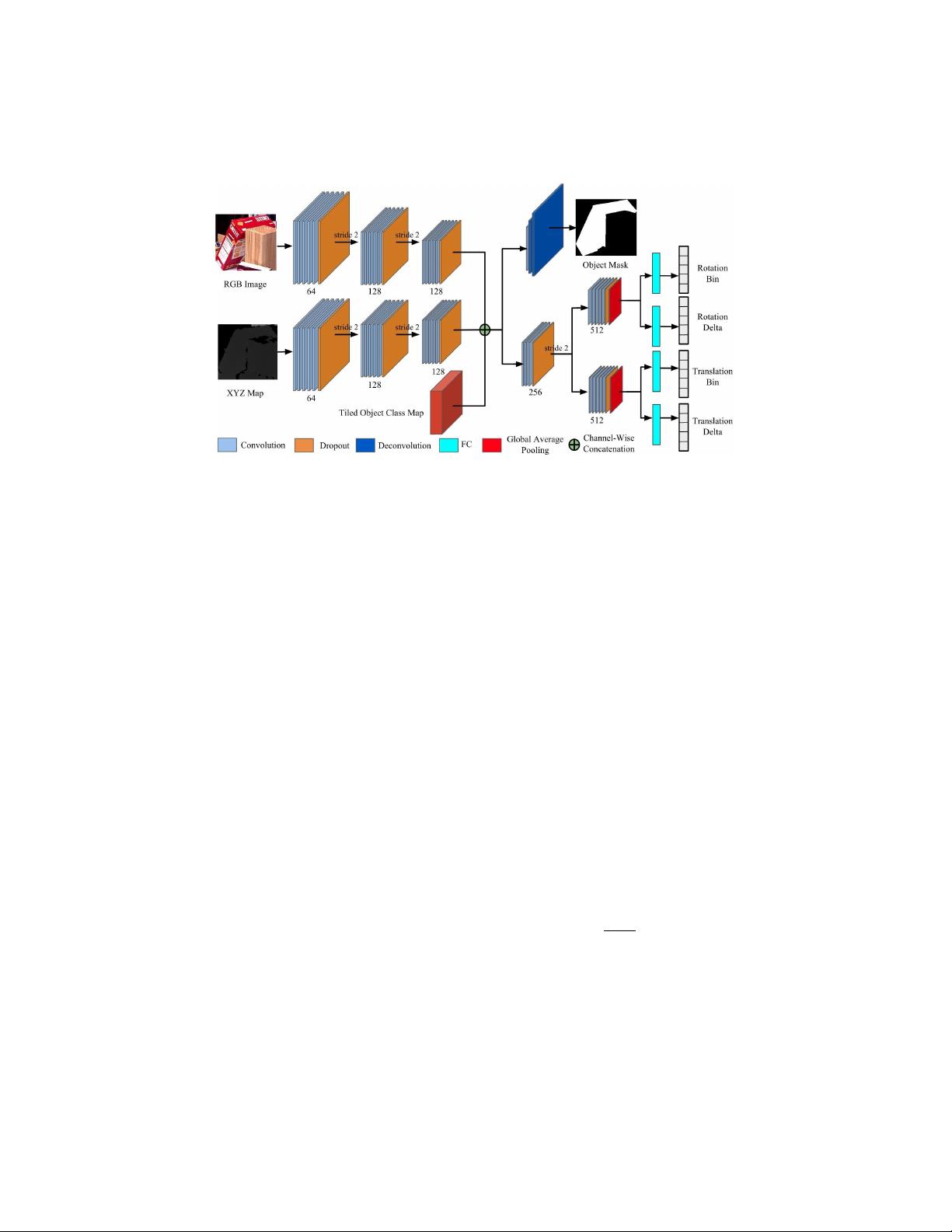

作者提出了一种新的可扩展框架,这个框架结合了深度卷积神经网络(CNN)和三维特殊欧氏群(SE(3))的均匀镶嵌理论,用于同时进行分类和姿态估计。他们设计的网络结构允许网络学习区分姿态的特征,同时解决了单视图估计中的歧义问题,通过一个多视图框架来提供更准确的结果。

在这个框架中,他们创新性地采用了“类先验融合”的策略,接收来自检测系统的对象图像和类别标签,以此减少网络规模随对象数量增加而增加的问题。这种方法与以往的每个对象单独训练网络或者每个对象类与一个输出分支关联的方式不同,它只有一个共享的输出流,大大提高了效率和准确性。

为了验证框架的有效性,他们在三个大规模基准数据集——YCB-Video、JHUScene-50和ObjectNet-3D上进行了评估,结果显示,他们的方法在性能上达到了或超过了现有的先进方法。这些基准数据集包含了各种复杂背景和大量不同对象的场景,为模型的鲁棒性提供了严格的测试。

关键词如“物体姿态估计”、“多视角识别”和“深度学习”揭示了研究的重点。在介绍部分,作者指出,虽然已经有许多方法尝试利用深度CNN的能力来提升位姿估计,但如何处理大量对象和保持高精度仍然是关键挑战。他们的方法通过创新网络设计和多视图融合策略,成功地解决了这些问题。

这项工作为多类别、多视角的目标位姿估计提供了一个高效且准确的解决方案,对于推动相关领域的技术进步具有重要意义。

410 浏览量

104 浏览量

2019-08-18 上传

2021-05-13 上传

2021-09-18 上传

2021-03-04 上传

2021-04-03 上传

2019-08-16 上传

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- ES管理利器:ES Head工具详解

- Layui前端UI框架压缩包:轻量级的Web界面构建利器

- WPF 字体布局问题解决方法与应用案例

- 响应式网页布局教程:CSS实现全平台适配

- Windows平台Elasticsearch 8.10.2版发布

- ICEY开源小程序:定时显示极限值提醒

- MATLAB条形图绘制指南:从入门到进阶技巧全解析

- WPF实现任务管理器进程分组逻辑教程解析

- C#编程实现显卡硬件信息的获取方法

- 前端世界核心-HTML+CSS+JS团队服务网页模板开发

- 精选SQL面试题大汇总

- Nacos Server 1.2.1在Linux系统的安装包介绍

- 易语言MySQL支持库3.0#0版全新升级与使用指南

- 快乐足球响应式网页模板:前端开发全技能秘籍

- OpenEuler4.19内核发布:国产操作系统的里程碑

- Boyue Zheng的LeetCode Python解答集