深度学习的高效方法与硬件

需积分: 10 141 浏览量

更新于2024-07-19

收藏 8MB PDF 举报

"cs231n_2017_lecture15.pdf"

这篇文档主要探讨了深度学习的高效方法和硬件支持,由Song Han在2017年5月25日在斯坦福大学发表。内容涉及深度学习如何改变我们的生活,以及与之相关的挑战,特别是模型大小和运行速度的问题。

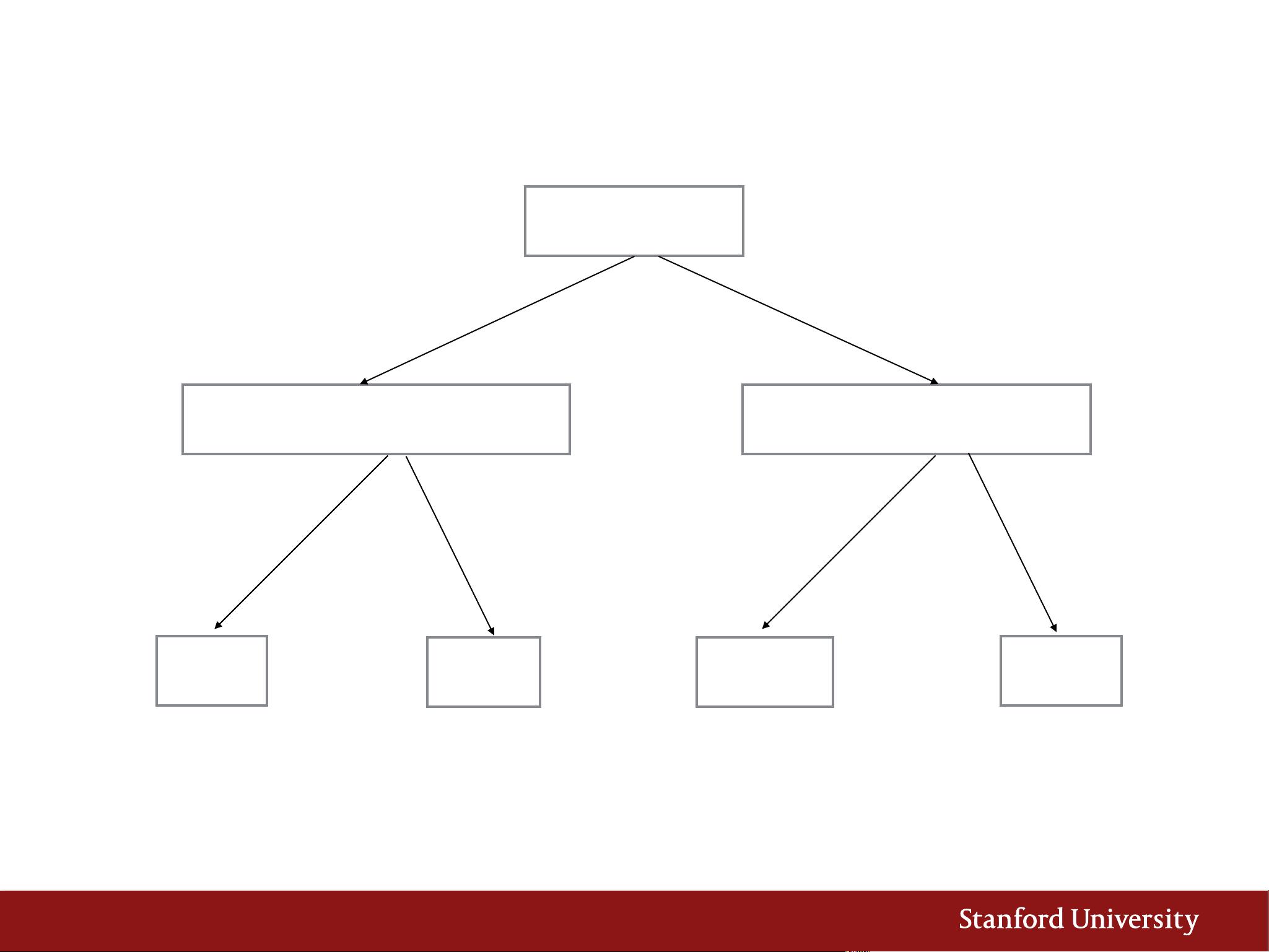

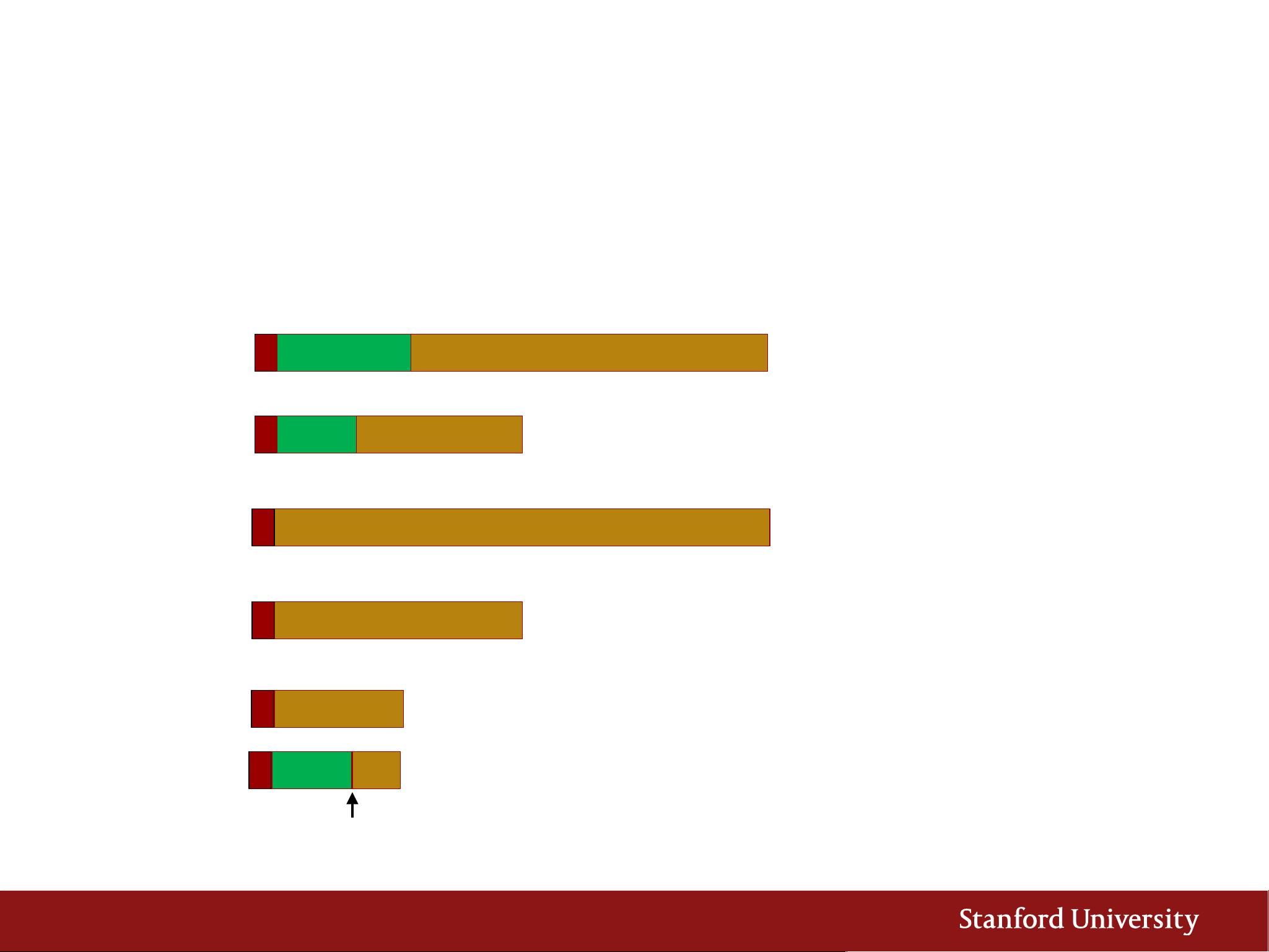

深度学习已经在多个领域产生了深远影响,如自动驾驶汽车、智能机器人、机器翻译以及围棋游戏的人工智能AlphaGo。图像识别和语音识别是深度学习的重要应用,自2012年以来,模型的复杂度和性能有了显著提升。例如,AlexNet在2012年的ImageNet比赛中以其8层结构和1.4GFLOP(浮点运算次数)实现了约16%的错误率,而2015年的ResNet有152层,虽然计算量达到22.6GFLOP,但错误率降低到约3.5%,表明模型的规模和复杂度与性能之间存在正相关关系。

随着模型的不断增大,训练和部署这些模型变得越来越具有挑战性。例如,微软和百度等公司在分发大型模型时面临着通过空中更新的困难。这提出了第一个挑战:模型大小。大型模型不仅占用更多存储空间,而且在设备间传输时可能需要更长时间,这对实时应用来说是个问题。

第二个挑战是速度。深度学习模型的运行速度直接影响用户体验,特别是在移动设备上。文档中提到了一个例子,展示了一个模型的错误率随着运行时间的增加而逐渐降低,强调了快速响应的重要性。对于实时服务,如语音识别,快速准确的反馈至关重要,而长时间的处理会导致延迟,影响用户体验。

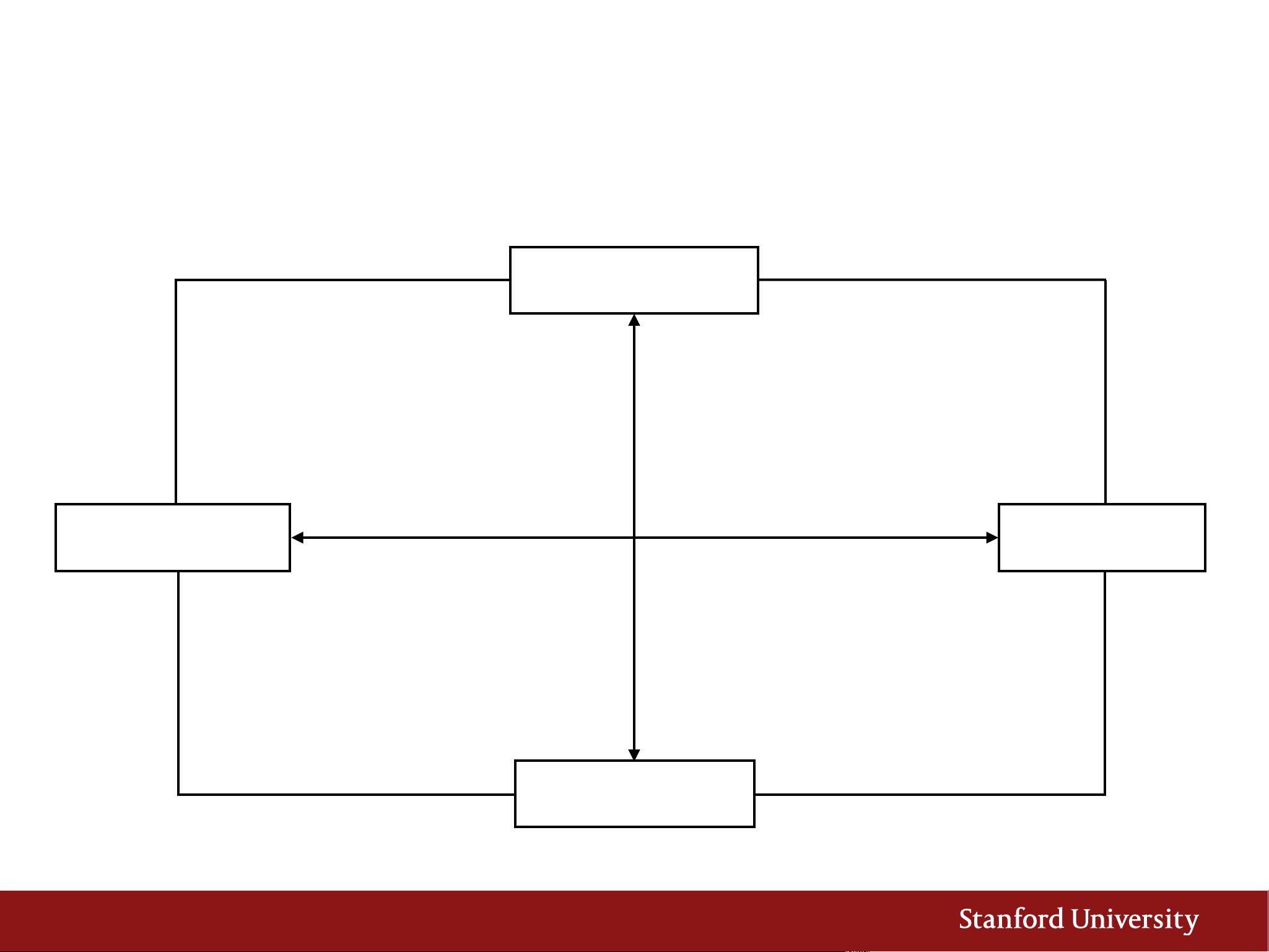

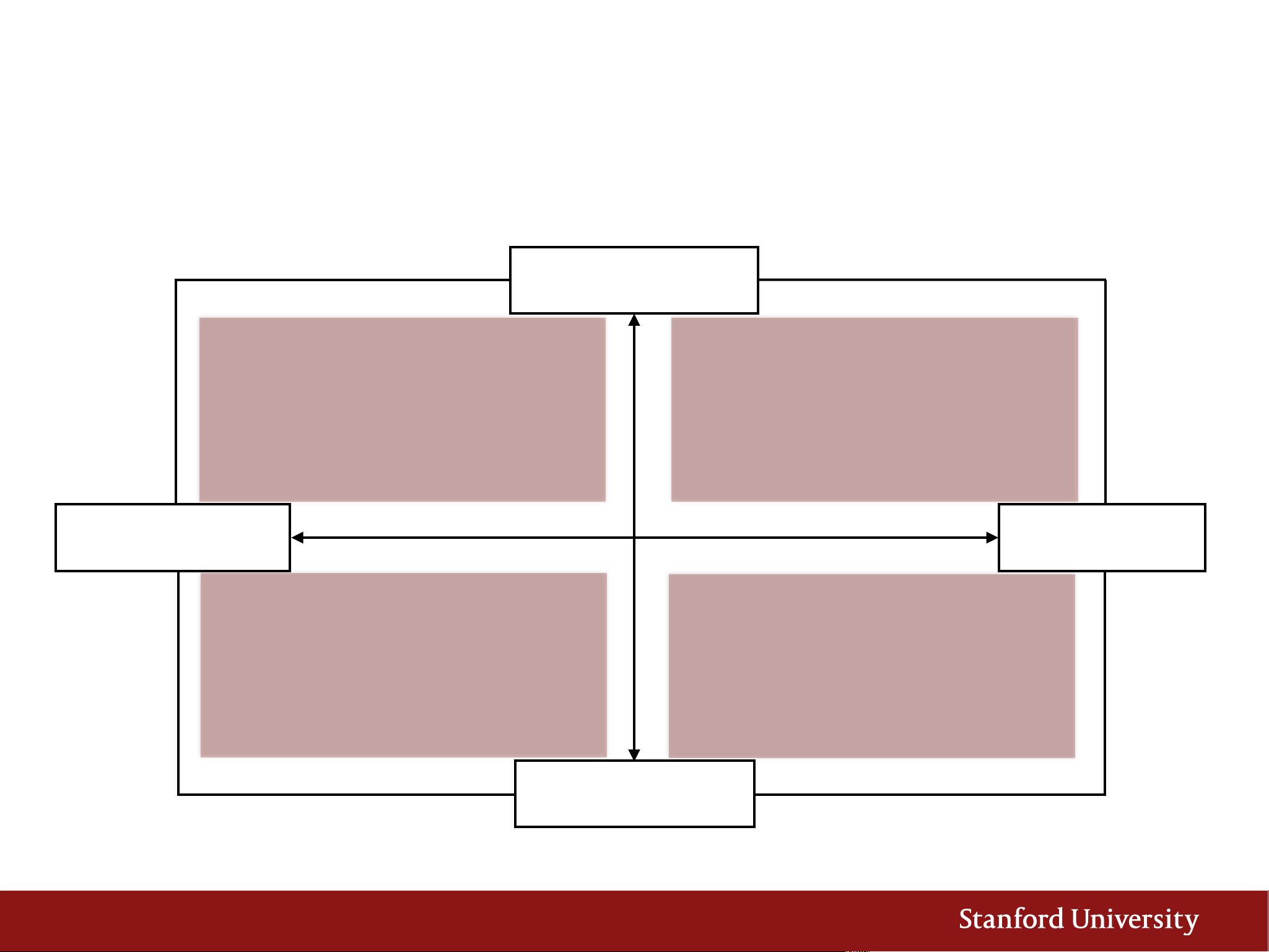

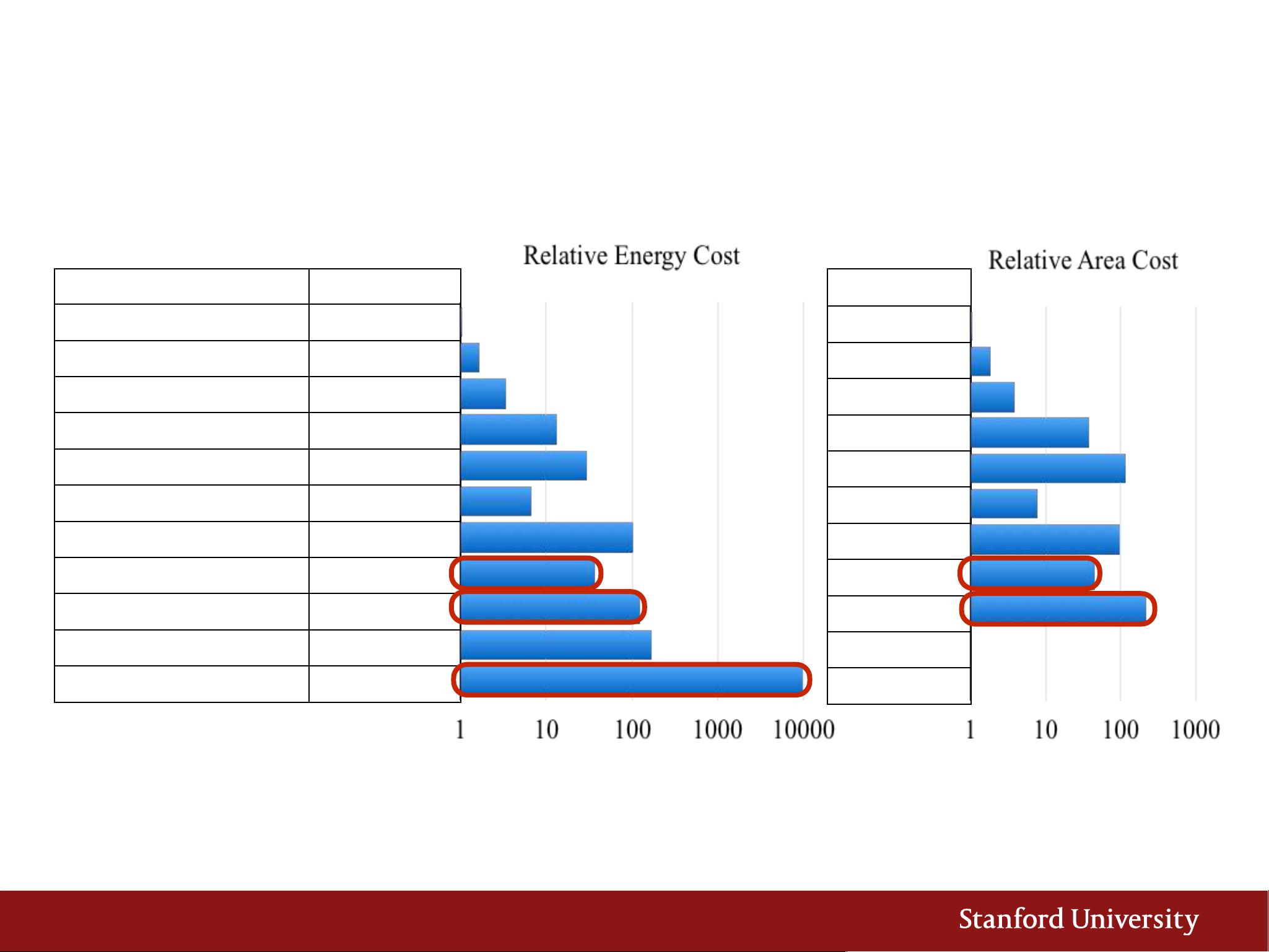

为了应对这些挑战,研究者和工程师正在开发更高效的深度学习方法和硬件。这可能包括优化的算法设计,如更有效的卷积结构、量化技术以减少模型大小,以及专门针对深度学习任务的硬件加速器,如GPU、TPU(张量处理单元)等。这些创新旨在减少计算需求,提高能效,同时保持或提高模型性能,使得深度学习能够在资源受限的设备上实现。

深度学习的发展依赖于不断进步的算法优化和硬件加速,以解决模型大小和运行速度这两个核心问题。随着技术的进步,我们期望看到更小、更快的深度学习模型被广泛应用于各种实际场景,继续推动人工智能领域的边界。

2018-01-24 上传

2018-01-24 上传

2023-06-11 上传

2023-06-11 上传

2023-06-12 上传

2023-07-29 上传

2023-02-07 上传

2023-06-06 上传

2023-07-28 上传

ShawDa

- 粉丝: 50

- 资源: 17

最新资源

- 新型智能电加热器:触摸感应与自动温控技术

- 社区物流信息管理系统的毕业设计实现

- VB门诊管理系统设计与实现(附论文与源代码)

- 剪叉式高空作业平台稳定性研究与创新设计

- DAMA CDGA考试必备:真题模拟及章节重点解析

- TaskExplorer:全新升级的系统监控与任务管理工具

- 新型碎纸机进纸间隙调整技术解析

- 有腿移动机器人动作教学与技术存储介质的研究

- 基于遗传算法优化的RBF神经网络分析工具

- Visual Basic入门教程完整版PDF下载

- 海洋岸滩保洁与垃圾清运服务招标文件公示

- 触摸屏测量仪器与粘度测定方法

- PSO多目标优化问题求解代码详解

- 有机硅组合物及差异剥离纸或膜技术分析

- Win10快速关机技巧:去除关机阻止功能

- 创新打印机设计:速释打印头与压纸辊安装拆卸便捷性