深度学习与计算机视觉:模型效率与硬件优化

需积分: 9 196 浏览量

更新于2024-07-17

收藏 7.94MB PDF 举报

“Lecture15.pdf 是斯坦福大学李飞飞教授关于计算机视觉深度学习的一份PPT,重点讨论了深度学习的效率优化方法和硬件需求。内容涵盖深度学习如何改变我们的生活,如自动驾驶、智能机器人、机器翻译等应用,并通过AlexNet和ResNet等模型展示了图像识别和语音识别的进步。随着模型的增大,面临模型大小和速度的挑战。”

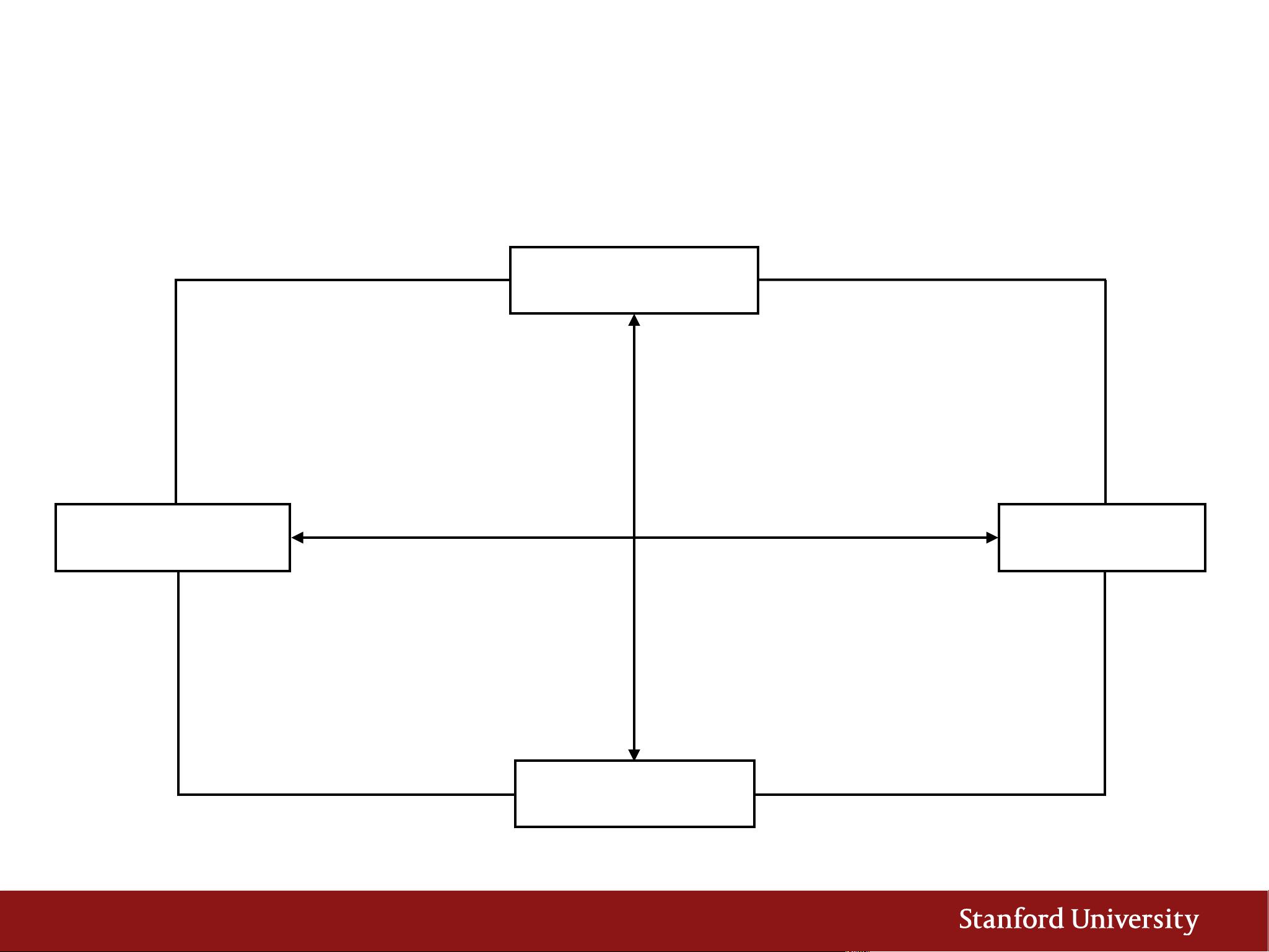

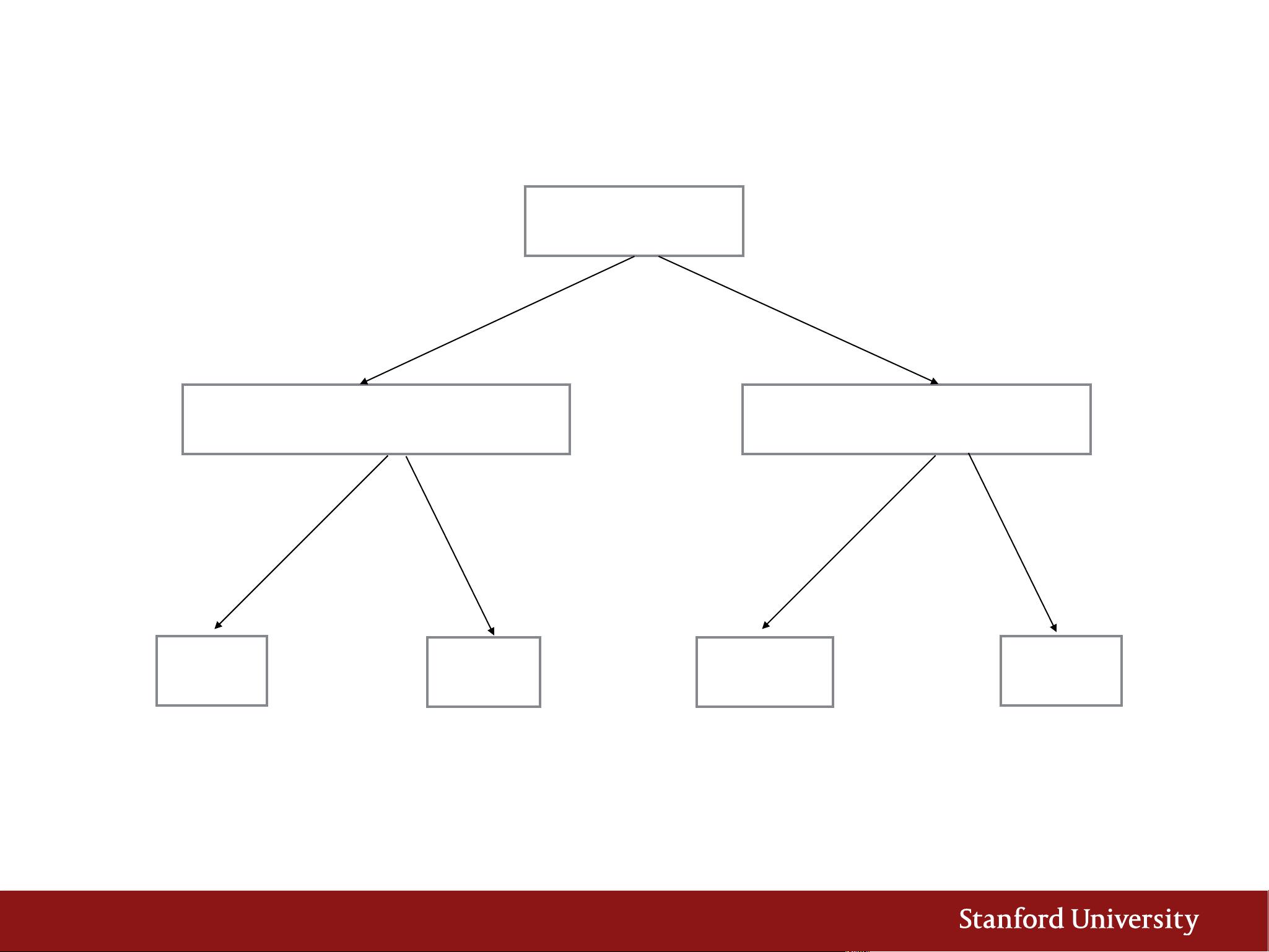

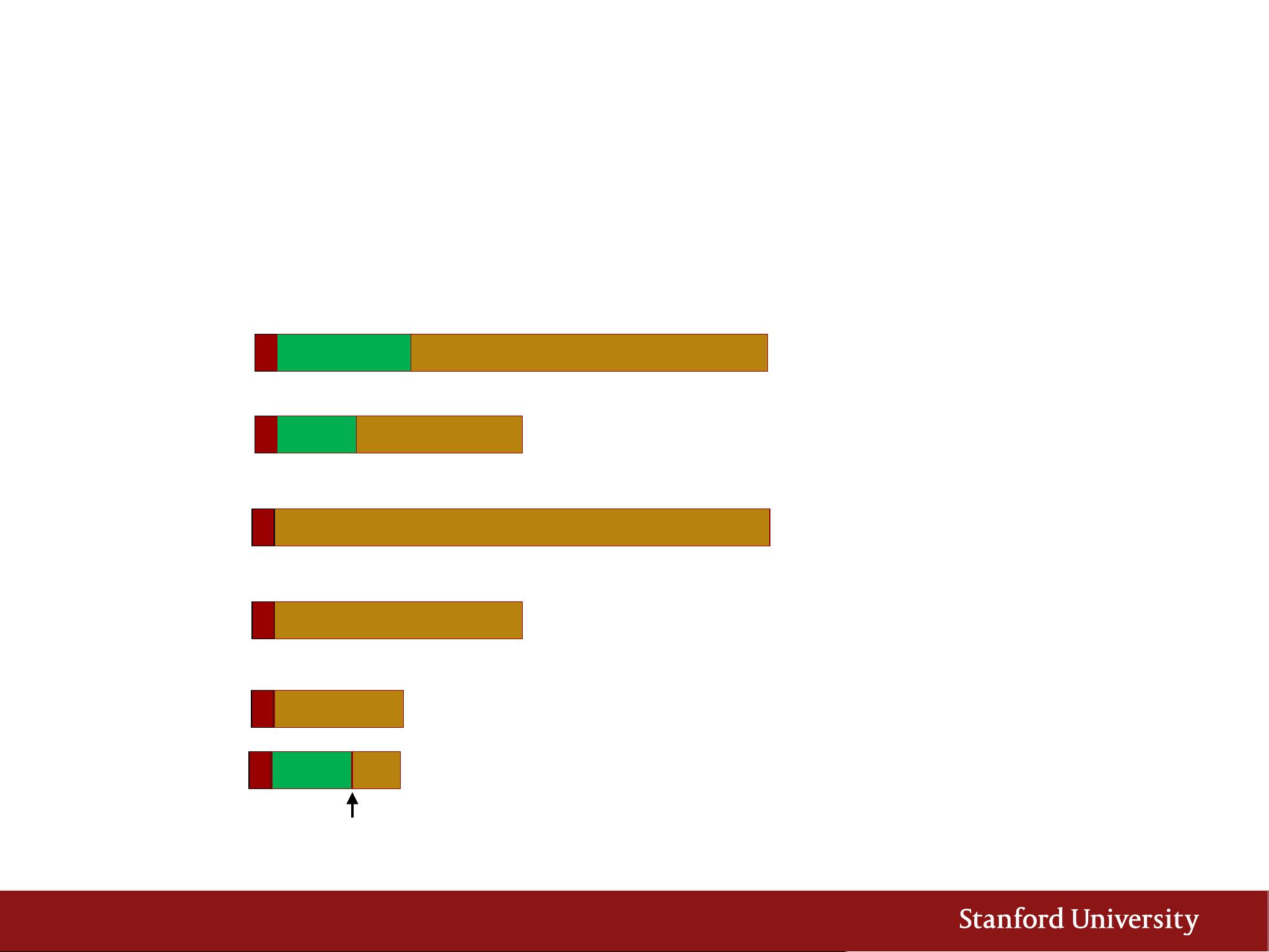

本文主要讨论了深度学习在计算机视觉领域的应用和发展,以及由此带来的硬件和效率问题。首先,深度学习正在深刻地改变我们的生活,它在自动驾驶汽车、智能机器人、机器翻译等领域发挥着重要作用,其中图像识别和语音识别是两个关键的应用领域。AlexNet在2012年的突破性成果显著降低了图像识别错误率,而2015年的ResNet则进一步加深了网络结构,尽管计算量增加(152层,22.6GFLOP),但错误率降低至约3.5%,这表明模型复杂度的提升带来了性能的改进。

然而,模型的不断增大也带来了问题。以微软和百度为例,大型模型的分布和更新成为难题,特别是对于需要通过无线更新的移动设备来说。这提出了第一个挑战:模型大小。随着模型参数数量的增加,存储和传输成本也随之上升。

第二个挑战在于速度。例如,训练一个模型可能需要从几天到几周的时间,这不仅消耗大量计算资源,而且延长了产品迭代周期。为了应对这些挑战,研究者们正在寻找更高效的方法来优化深度神经网络,比如减少计算操作(FLOPs)而不牺牲性能。例如,DeepSpeech1到DeepSpeech2的进化,虽然训练操作量增加了10倍,但错误率却显著降低,表明优化技术能够有效提高模型的训练效率。

这份PPT探讨了深度学习在计算机视觉领域的进步,以及在实际应用中面临的模型大小和运行速度的挑战。为了适应这种发展趋势,研究人员需要继续开发更高效的算法和硬件解决方案,以支持更大、更复杂的模型,并确保它们能在各种设备上快速准确地运行。

2018-01-24 上传

2023-03-27 上传

2019-11-28 上传

2020-07-27 上传

2020-08-21 上传

VisCMSHI

- 粉丝: 1

- 资源: 1

最新资源

- Chausie提供了可自定义的视图容器,用于管理内容页面之间的导航。 :猫:-Swift开发

- DianMing.rar_android开发_Java_

- Mockito-with-Junit:与Junit嘲笑

- recycler:[只读] TYPO3核心扩展“回收者”的子树拆分

- 分析:是交互式连续Python探查器

- emeth-it.github.io:我们的网站

- talaria:TalariaDB是适用于Presto的分布式,高可用性和低延迟时间序列数据库

- lexi-compiler.io:一种多语言,多目标的模块化研究编译器,旨在通过一流的插件支持轻松进行修改

- 实时WebSocket服务器-Swift开发

- EMIStream_Sales_demo.zip_技术管理_Others_

- weiboSpider:新浪微博爬虫,用python爬取新浪微博数据

- Vue-NeteaseCloud-WebMusicApp:Vue高仿网易云音乐,基本实现网易云所有音乐,MV相关功能,转变更新到第二版,仅用于学习,下面有详细教程

- asciimatics:一个跨平台的程序包,可进行类似curses的操作,外加更高级别的API和小部件,可创建文本UI和ASCII艺术动画

- Project_4_Java_1

- csv合并js

- containerd-zfs-snapshotter:使用本机ZFS绑定的ZFS容器快照程序