掌握深度学习(6):LSTM原理与应用

需积分: 0 155 浏览量

更新于2024-06-30

1

收藏 1.75MB PDF 举报

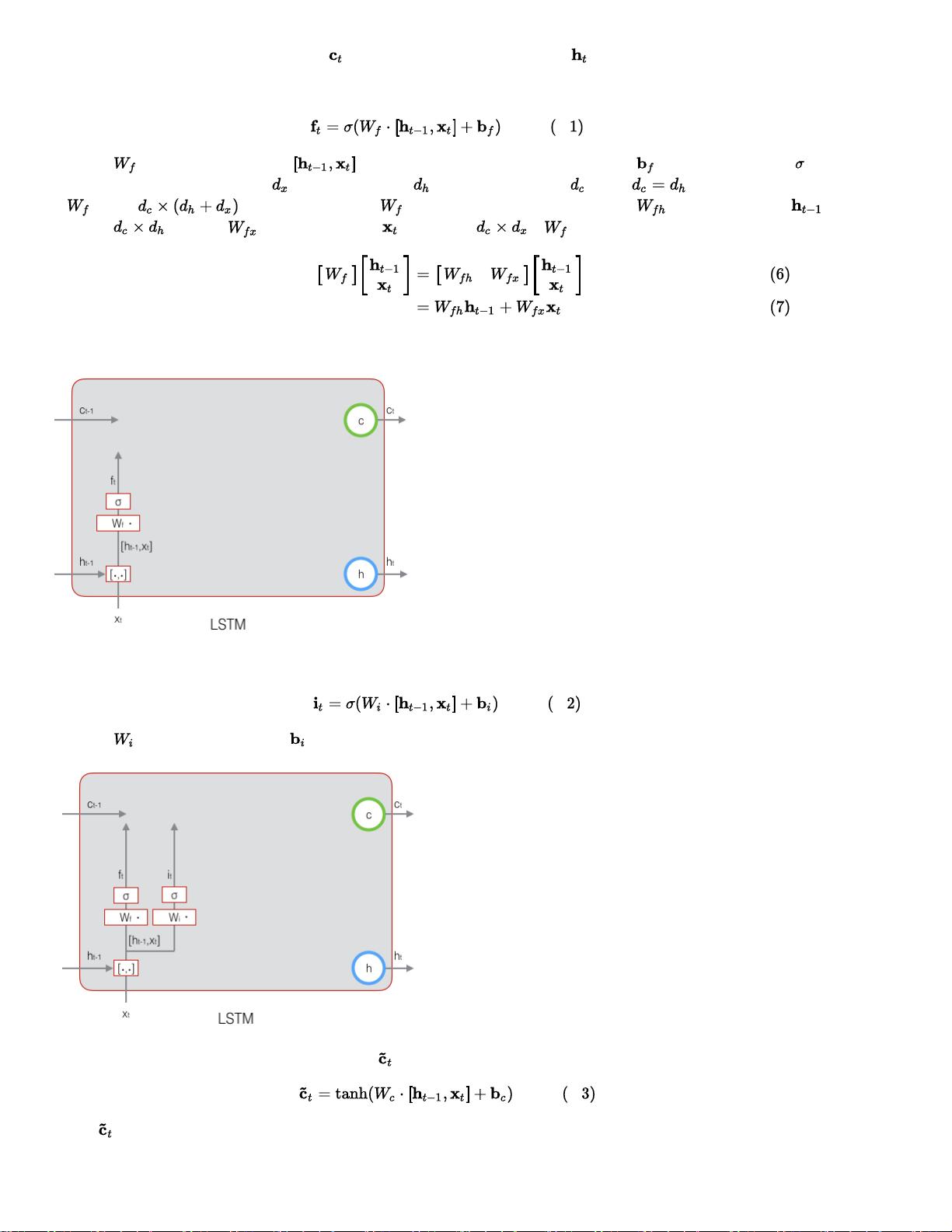

在"零基础入门深度学习(6) - 长短时记忆网络(LSTM)1"这篇文章中,作者深入浅出地探讨了深度学习中的一个重要组成部分——长短时记忆网络(LSTM)。LSTM是一种特殊的循环神经网络(RNN),针对传统RNN在处理长序列数据时存在的“长期依赖”问题进行优化。

1. 前向计算:LSTM的核心在于其内部结构,包括细胞状态(cell state)和门控机制(gates,如输入门、遗忘门和输出门)。在前向计算阶段,每个神经元的输出值不再仅仅是简单的加权和,而是通过这些门控机制控制信息的流动,有效地避免了梯度消失或爆炸的问题,使得网络能够捕捉到长期依赖的信息。

2. 反向传播:不同于标准RNN,LSTM的反向传播更为复杂。由于引入了门控机制,需要计算每个门的误差项,这些误差项会被用来更新每个权重的梯度,以便在反向传播过程中调整网络参数,使得网络逐渐适应数据的特性。

3. 梯度计算与权重更新:LSTM的梯度计算涉及到链式法则的应用,对每个门的激活函数和权重进行偏微分,以求得梯度。这些梯度被用于使用优化算法(如随机梯度下降)来更新权重,以最小化损失函数,从而提升模型的性能。

4. 应用广泛性:LSTM因其在解决长序列依赖问题上的优势,已经在诸如语音识别、文本生成(如图片描述)、自然语言处理等领域取得了显著的成功。它在处理序列数据时,能够记住并利用先前的信息,这对于很多任务来说至关重要。

5. 学习曲线挑战:尽管LSTM的结构复杂,学习过程可能比传统的RNN更耗时和计算资源,但它所带来的性能提升使得这种复杂性是值得的。通过逐步理解LSTM的工作原理和训练方法,开发者可以更好地应对复杂的数据处理场景。

这篇文章作为深度学习系列的一部分,旨在帮助编程者从零开始掌握深度学习技术,即使没有深厚的数学背景,也能通过实践和代码理解关键概念。通过本文的学习,读者将能够理解LSTM在解决深度学习问题中的独特作用,并为进一步研究其他类型的深度神经网络打下坚实的基础。

142 浏览量

121 浏览量

1112 浏览量

180 浏览量

422 浏览量

213 浏览量

199 浏览量

834 浏览量

1172 浏览量

XiZi

- 粉丝: 733

- 资源: 325

最新资源

- webwork2guide.pdf

- 身份认证技术分析(论文)

- birt报表参数使用

- 高质量的c++c编程指南

- Flex 3 Cookbook

- BCM5228 10/100BASE-TX/FX Transceiver

- ActionScript 3.0 Cookbook 中文版

- The International Reference Alphabet

- 你必须知道的495个C语言问题(内含完整章节,PDF格式)

- SQL Server 使用方法

- 清华大学信号与系统课件

- lingoziliao

- Advanced 3D Game Programming With Directx 9.0.pdf

- C程序设计 谭浩强 清华大学出版社

- eclipse插件开发指南

- javaeye月刊2008年6月 总第4期.pdf