理解BP神经网络:算法原理与实践解析

需积分: 0 135 浏览量

更新于2024-08-04

收藏 317KB DOCX 举报

"数据挖掘系列(9)——BP神经网络算法与实践 1"

BP神经网络是一种广泛应用的人工神经网络模型,特别是在数据挖掘和深度学习领域。它的全称是反向传播(Backpropagation)神经网络,是通过反向传播误差来调整网络中权重和偏置的算法。本篇文章将详细介绍BP神经网络的结构、工作原理以及实践中的应用。

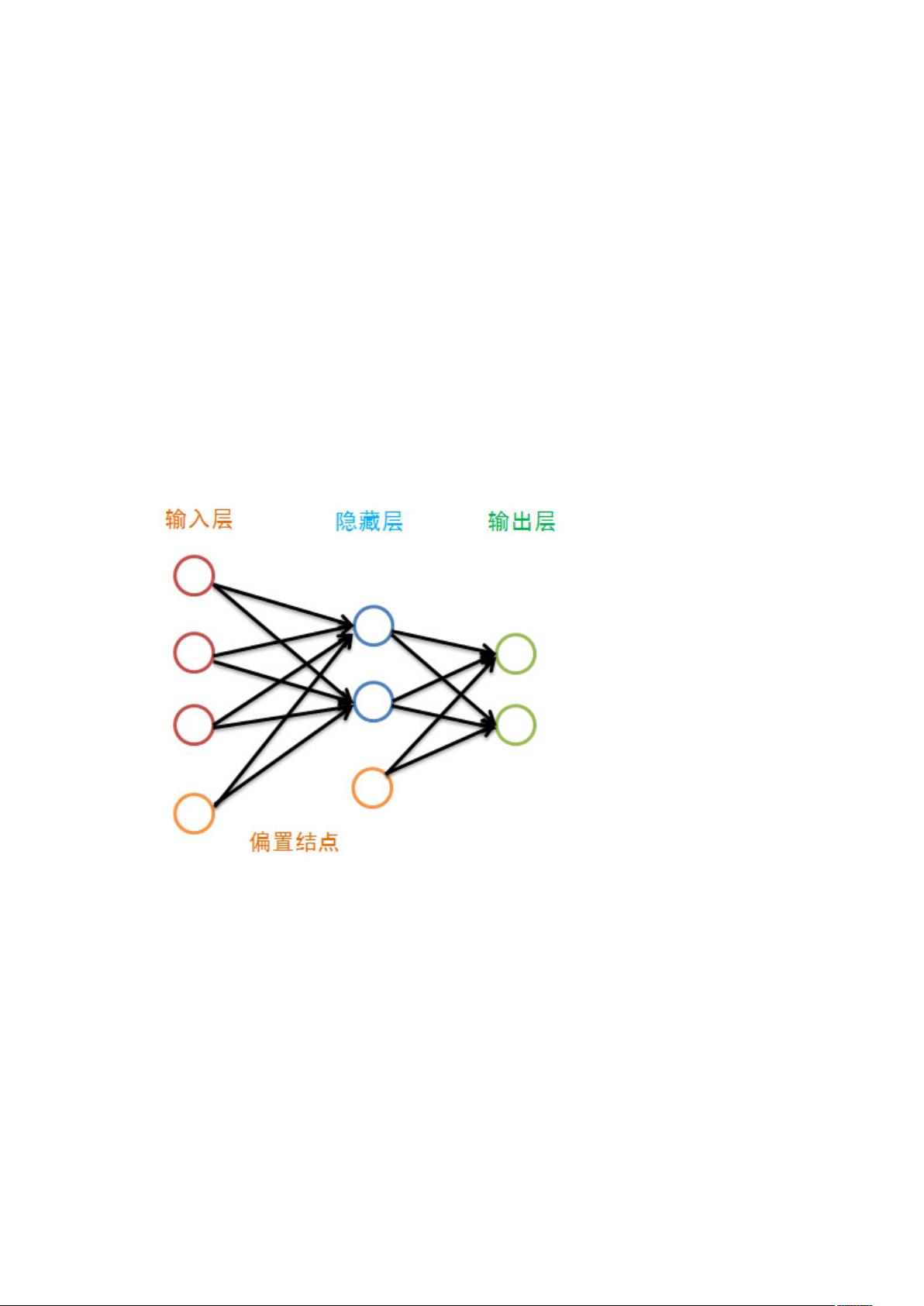

BP神经网络的结构由输入层、隐藏层和输出层组成。输入层接收原始数据,隐藏层处理信息,而输出层则给出网络的预测结果。每一层都包含多个神经元,除了输入层外,每个神经元都有一个偏置值,这个偏置值使得神经元能够对未被训练数据直接表示的特征进行反应。在网络中,相邻层的神经元之间存在权重连接,这些权重在训练过程中会被不断更新以优化网络性能。

在BP神经网络中,权重Wij是从上一层神经元到下一层神经元的连接强度,通常初始化为[-1,1]区间内的随机值。输入层的神经元没有输入值,它们的输出值直接等于输入数据的特征值。对于非输入层的神经元,其输入值是上一层所有神经元输出值的加权和加上偏置,然后经过一个非线性激活函数(如sigmoid或ReLU)转换为输出值。

训练BP神经网络的过程分为两个阶段:前向传输和反向传播。

前向传输(Feed-Forward)是指从输入层开始,通过网络将输入数据逐层传递,计算每个神经元的输出。这个过程涉及到将输入数据乘以权重,加上偏置,然后通过激活函数得到每个神经元的激活值。

反向传播(Backpropagation)是训练的关键步骤,它根据预测输出与实际目标的差异(即误差)来调整权重和偏置。误差通过网络从输出层反向传播回输入层,每层的权重和偏置都会根据误差的梯度进行微调,以减小网络的总误差。这个过程使用了链式法则来计算每个权重的梯度,进而进行更新。

在实践中,BP神经网络通常使用批量梯度下降法或者随机梯度下降法进行迭代优化,直到网络达到预设的停止条件(如达到最大迭代次数、损失函数收敛等)。此外,为了避免网络过拟合,还可以使用正则化、早停策略或者dropout技术。

BP神经网络是一种强大的工具,能够学习复杂的数据模式,并在分类、回归和其他任务中展现出优秀的性能。随着深度学习的发展,多层的BP神经网络(即深度神经网络)已经成为解决许多复杂问题的首选方法。然而,BP网络也存在一些挑战,例如梯度消失和梯度爆炸问题,这些问题在设计深度网络时需要特别注意。尽管如此,BP神经网络及其变种仍然是当前数据挖掘和机器学习领域的核心算法之一。

2090 浏览量

226 浏览量

点击了解资源详情

123 浏览量

2021-09-25 上传

2021-07-14 上传

110 浏览量

2021-09-27 上传

2021-09-26 上传

高工-老罗

- 粉丝: 26

- 资源: 314

最新资源

- CPLD设计实例.pdf

- head-first-design-patterns

- 计算机组成原理课后习题答案

- Linux 新手管理员指南

- Chapter9_E2

- 通用工资管理体系的设计与实现

- microsoft-visual-c-2008-step-by-step

- Chapter9_E1

- SPRING开发指南

- 网络之路 第二期--QoS专题讨论.pdf

- 2009考研英语核心词汇.doc

- SAM7X_Schematics_korea,韩国设计的AT91SAM7X256/128的开发板原理图

- Delphi-for-NET-Developers-Guide

- jQuery入门ppt

- 俄罗斯方块的原理以及arm实现

- SQLServer2008BI解决方案特点

已收录资源合集

已收录资源合集