最小二乘行动者-评论家方法解决连续动作空间问题

105 浏览量

更新于2024-08-26

收藏 512KB PDF 举报

"本文介绍了一种名为最小二乘行动者-评论家(Least Square Actor-Critic, LSAC)的方法,该方法应用于解决强化学习中的连续动作空间问题。传统的强化学习算法常常通过离散化处理来解决连续动作空间,但在缺乏先验信息的情况下,这种方法可能效果不佳或完全失效。LSAC算法采用函数逼近器来近似表示值函数和策略,并利用最小二乘法在线动态地求解这些参数。这种算法被应用到小车平衡杆问题和mountain car问题上,并与CALC(连续行动者-评论家学习自动机)和eNAC(episodic Natural Actor-Critic)算法进行了对比,显示出在解决连续动作空间问题上的有效性和优越性能。"

本文详细探讨了强化学习领域的一个关键挑战,即如何处理具有连续动作空间的问题。传统的强化学习算法,如Q-learning和SARSA,通常需要将连续的动作空间离散化,以便于计算和优化策略。然而,离散化过程可能会导致信息损失,尤其是在没有合适先验信息的情况下,算法效率和准确性都会受到影响。

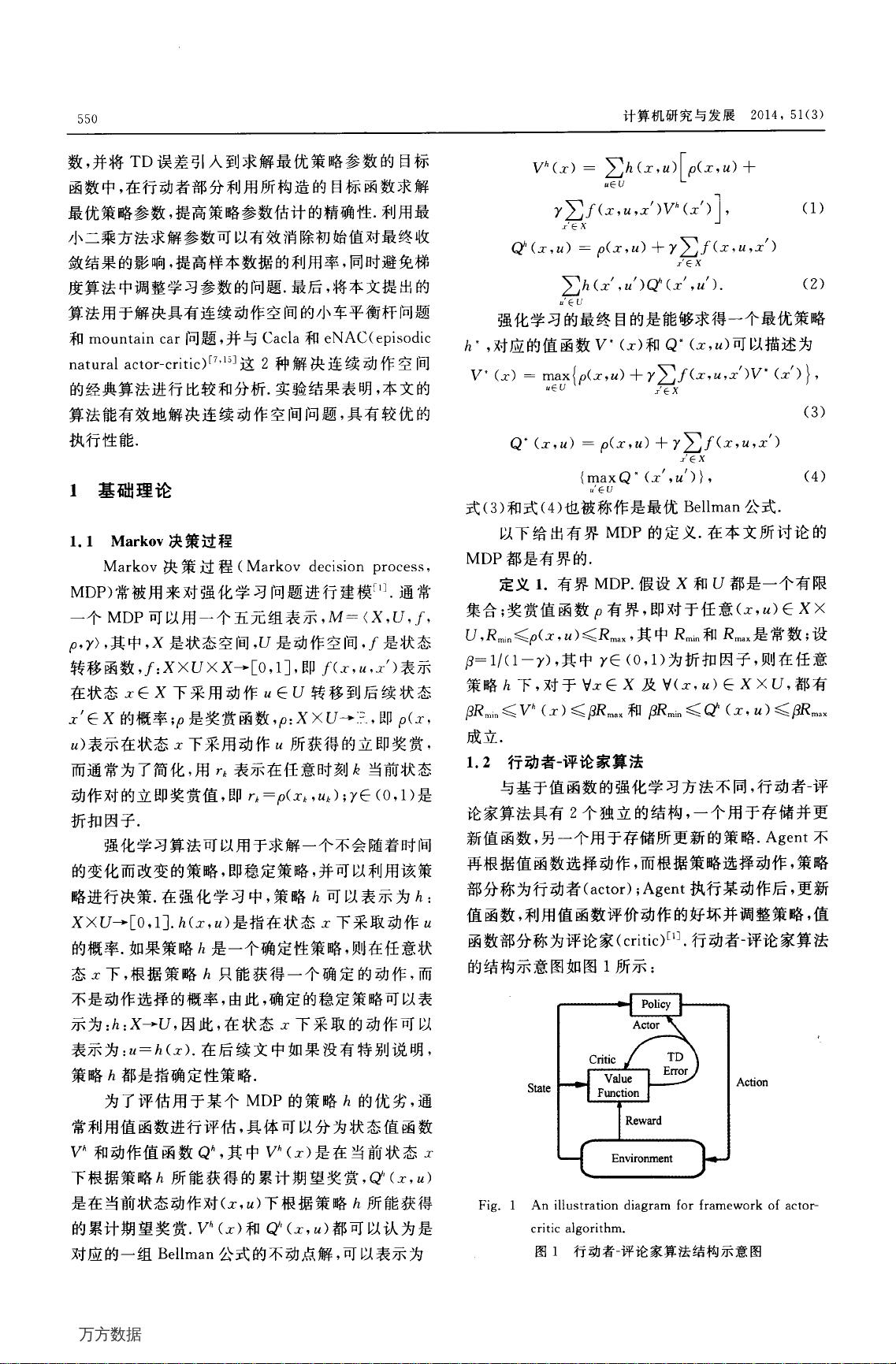

最小二乘行动者-评论家(LSAC)算法提供了一种新的解决方案。它不依赖于动作空间的离散化,而是采用函数逼近器,如神经网络,来近似表示策略函数(演员)和价值函数(评论家)。通过最小二乘法,算法能够在线地更新这两个函数的参数,使得策略参数的调整基于价值函数的反馈。这种设计使得LSAC能够在不断学习过程中优化策略,无需预先知道动作空间的具体结构。

在实际应用中,LSAC被应用于两个经典的强化学习问题:小车平衡杆问题和mountain car问题。这两个问题都涉及到控制一个物理系统,使其在连续的动作空间中达到目标状态。实验结果证明,LSAC能够有效地找到解决问题的策略,其性能优于CALC和eNAC算法。这表明LSAC算法在处理连续动作空间的强化学习任务时,具有较好的泛化能力和适应性。

LSAC算法为解决连续动作空间的强化学习问题提供了一个有前途的方法,它通过函数逼近和在线学习避免了离散化的需要,从而提高了算法在复杂环境中的表现。这一工作对于强化学习领域的理论研究和实际应用都有着重要的意义,为未来解决更多复杂的控制问题提供了新的思路。

2019-07-22 上传

2013-11-26 上传

2024-07-27 上传

2023-08-06 上传

2023-09-19 上传

2023-06-12 上传

2023-05-10 上传

2023-05-12 上传

2023-09-11 上传

皮卡丘穿皮裤

- 粉丝: 187

- 资源: 955

最新资源

- 李兴华Java基础教程:从入门到精通

- U盘与硬盘启动安装教程:从菜鸟到专家

- C++面试宝典:动态内存管理与继承解析

- C++ STL源码深度解析:专家级剖析与关键技术

- C/C++调用DOS命令实战指南

- 神经网络补偿的多传感器航迹融合技术

- GIS中的大地坐标系与椭球体解析

- 海思Hi3515 H.264编解码处理器用户手册

- Oracle基础练习题与解答

- 谷歌地球3D建筑筛选新流程详解

- CFO与CIO携手:数据管理与企业增值的战略

- Eclipse IDE基础教程:从入门到精通

- Shell脚本专家宝典:全面学习与资源指南

- Tomcat安装指南:附带JDK配置步骤

- NA3003A电子水准仪数据格式解析与转换研究

- 自动化专业英语词汇精华:必备术语集锦