Java实现网页爬虫实战教程

108 浏览量

更新于2024-09-02

收藏 465KB PDF 举报

Java实现网页爬虫的示例讲解深入探讨了如何利用Java语言构建一个基本的网络爬虫,用于数据抓取和分析。本文档旨在帮助读者理解爬虫的工作原理,提供了一个从单网页数据抓取到多网页遍历、多线程优化的实践指南。

1. **爬虫原理**

- 网络爬虫是一种自动化工具,常用于搜索引擎、竞品分析、舆情监控和市场研究等场景,通过模拟用户行为抓取网站上的数据。

- 执行流程包括选择种子网页、内容提取、链接抓取、存储和重复遍历未访问的页面,遵循深度优先或广度优先策略(推荐广度优先)。

2. **数据提取与分析**

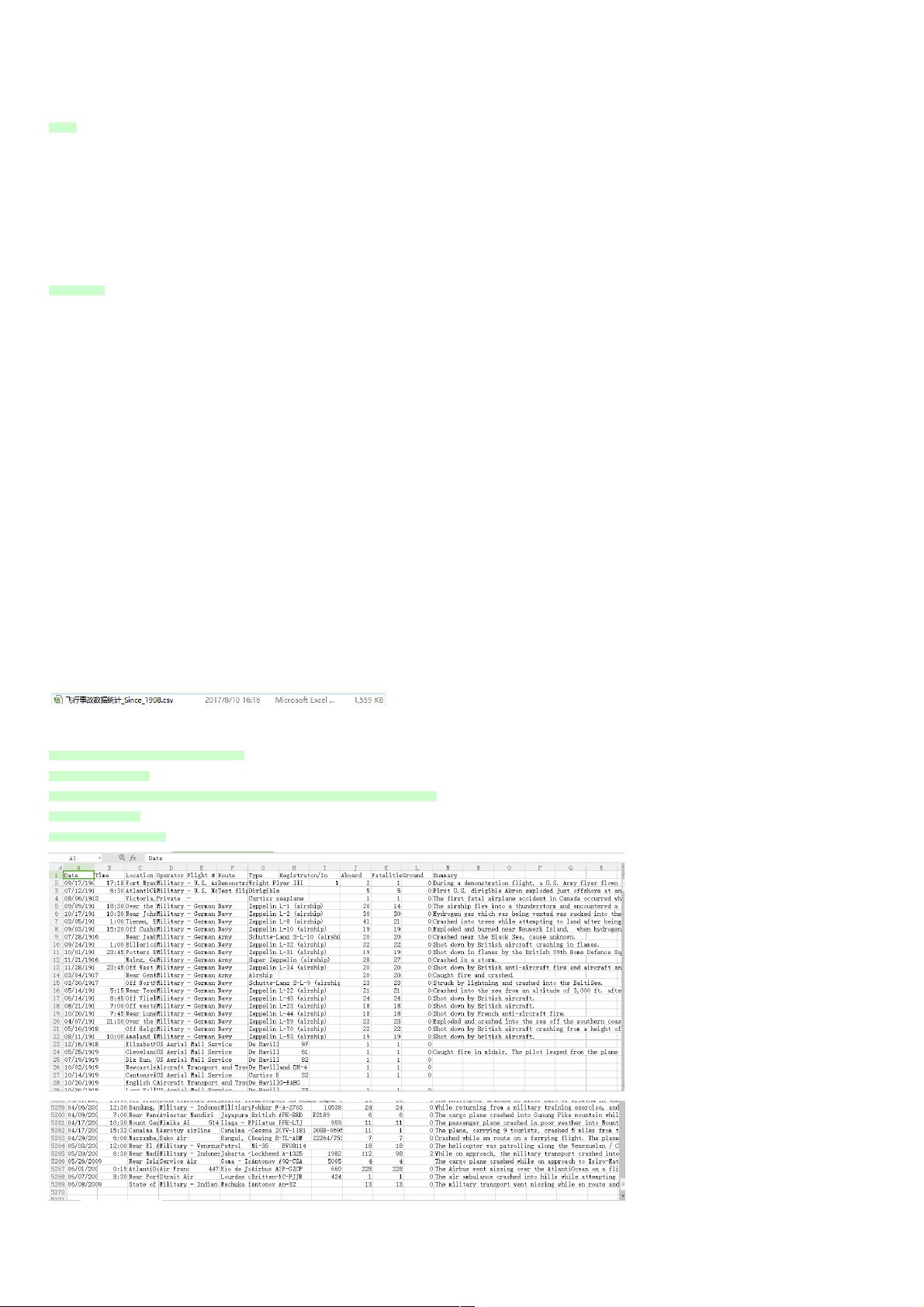

- 作者以飞机事故数据为例,该数据集包含时间、地点、驾驶员信息等12列,共5268条记录。

- 数据分析目标包括:

- 年份内事故次数最多的统计

- 不同时间段事故发生的频率

- 死亡人数最多的年份

- 幸存率最高的数据记录

3. **代码实现**

- 代码示例展示了`com.plane`包下的类,使用Java IO和日期解析库来处理数据。通过`FileReader`和`BufferedReader`读取文件,`SimpleDateFormat`用于日期格式化,`HashMap`或`List`用于存储统计结果。

4. **关键技术点**

- `URL`和`URLConnection`用于建立和管理网络连接,获取HTML内容。

- `BeautifulSoup`或`Jsoup`这样的库用于解析HTML文档,提取所需数据。

- 使用正则表达式(RegEx)进行字符串匹配和提取链接。

- 多线程处理(例如`ExecutorService`或`Thread`)提高爬取效率,避免阻塞。

- 避免频繁抓取导致的服务器压力,遵循robots.txt规则,设置合理的抓取间隔。

5. **总结**

- 实现网页爬虫不仅需要扎实的Java基础,还要了解网页结构和数据抓取策略。随着项目规模扩大,可能还需要考虑动态加载、反爬虫机制、数据清洗和存储等问题。

通过这篇教程,读者可以掌握Java编程下网页爬虫的基本实现步骤和常见应用场景,为实际项目开发打下坚实的基础。

195 浏览量

419 浏览量

487 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

2012-12-04 上传

weixin_38685521

- 粉丝: 4

- 资源: 935

最新资源

- pip-chill:更轻松的“点冻结”

- 实存帐存对比表DOC

- jquery.page分页控件.zip

- sql-q:JDBC 模板

- 数据结构

- ange-button

- stable-baselines:稳定基线的镜子

- 电子功用-太阳能电池板激光刻划系统及刻划方法

- 材料调拨管理方法DOC

- ut-ussd

- NewRepo:创建一个空白仓库

- galgebra:SymPy的符号几何AlgebraCalculus软件包

- 在 C# 中使用 MATLAB 结构体和 Builder NE:“MATLAB 艺术”帖子的代码 - 展示了如何在 MATLAB 和 C# 之间传递结构体。-matlab开发

- mysql-8.0.18-winx64.zip

- js特效脚本含源码和说明迅雷网七屏flash广告轮换

- 电子功用-带有市电互补功能的太阳能模块化嵌入式控制器