Pytorch卷积理解:Input Shape灵活性与实验解析

131 浏览量

更新于2024-08-30

1

收藏 150KB PDF 举报

在PyTorch中,卷积层(Conv2d)是深度学习模型中处理图像数据的重要组件,用于提取特征并减少数据的维度。卷积层的定义如下:

```python

class torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True)

```

其中,`in_channels` 表示输入通道数,即输入图像的每个像素通道数量,例如RGB图像通常有3个通道。`out_channels` 是输出通道数,也就是卷积后每个像素会生成的新特征数量。`kernel_size` 是卷积核的大小,通常是一个元组,如(3, 3)表示3x3的卷积核。

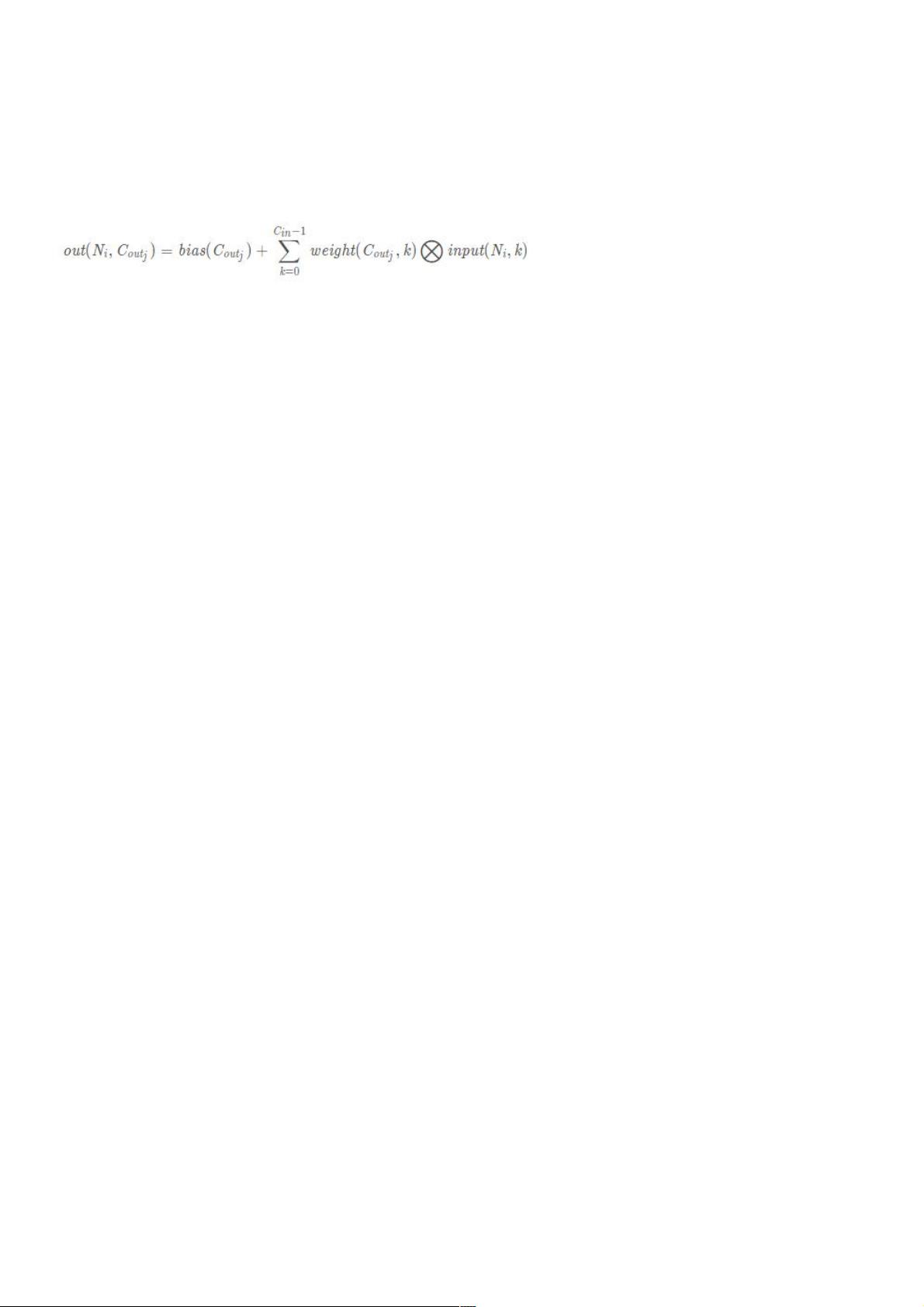

值得注意的是,尽管PyTorch的Conv2d函数在文档中并未明确指定`input_shape`,但其内部逻辑确实依赖于输入数据的维度。当我们在构建网络时,实际上已经隐含地假设了输入数据的形状遵循 `(N, C_in, H, W)` 的格式,其中 `N` 是批量大小,`C_in` 是输入通道数,`H` 和 `W` 是图像的高度和宽度。

当你实例化一个卷积层,如 `self.conv1 = nn.Conv2d(1, 6, 5)`,虽然没有直接指定输入图像的具体尺寸,但层的构造函数会根据`in_channels`自动调整预期的输入数据。这意味着你可以传递不同大小的`H`和`W`值,只要它们与`in_channels`和`kernel_size`相匹配,且满足卷积操作的边界条件(如填充(padding)和步长(stride))。

例如,如果你的`input_shape`是 `(1, 1, 28, 28)`,这表示单通道的28x28像素图像,然后使用一个3x3的卷积核,可能需要设置适当的padding为1(使得输出尺寸不变),因为3+2*1=5,可以保持输出和输入相同的高度和宽度。

在实践中,网络结构的设计者通常会在训练之前确定好输入图像的确切尺寸,以确保数据能够正确地馈送到卷积层。虽然理论上讲,PyTorch的Conv2d层可以在没有预定义输入尺寸的情况下工作,但在实际应用中,为了代码的清晰性和效率,最好还是提供明确的输入形状。此外,对于最大池化层(如`F.max_pool2d()`)和全连接层(如`nn.Linear()`),也需要考虑到它们对输入维度的要求,以便将数据展平成一维向量供后续处理。

在`Net`类中,你展示了如何创建一个简单的卷积神经网络,包括两次卷积、两次最大池化以及两个全连接层。`num_flat_features`方法用于将四维张量展平为二维张量,以适应全连接层的输入需求。这个例子展示了如何在实际网络架构中整合卷积层,并确保输入尺寸的适配性。

2020-09-18 上传

2023-09-01 上传

2023-09-25 上传

2023-09-04 上传

2023-08-20 上传

点击了解资源详情

点击了解资源详情

2023-09-21 上传

2023-09-03 上传

weixin_38672794

- 粉丝: 5

- 资源: 924

最新资源

- CSS+DIV常用方法说明

- 《深入浅出Ext+JS》样章.pdf

- sudo应用的详细阐述

- sql金典.pdf sql金典.pdf

- tomcat配置手册

- webwork开发指南

- Ajax In Action 中文版

- 数据挖掘论文.。。。。

- Visual Studio 2008 可扩展性开发4:添加新的命令.doc

- Visual Studio 2008 可扩展性开发3:Add-In运行机制解析(下).doc

- Visual Studio 2008 可扩展性开发3:Add-In运行机制解析(上).doc

- 蚁群分区算法C#实现

- Visual Studio 2008 可扩展性开发2:Macro和Add-In初探

- C、C++高质量编程指导

- BIND9 管理员参考手册

- MiniGUI用户手册