HDFS详解:架构、操作与容错机制漫画解析

版权申诉

101 浏览量

更新于2024-07-11

收藏 1.06MB DOCX 举报

HDFS(Hadoop Distributed File System)是Apache Hadoop项目的重要组成部分,它是一种专为大规模分布式计算而设计的分布式文件系统。作为谷歌GFS理念的延伸,HDFS旨在提供高容错性和高吞吐量,使得在海量数据存储和处理场景中能够有效地运行。

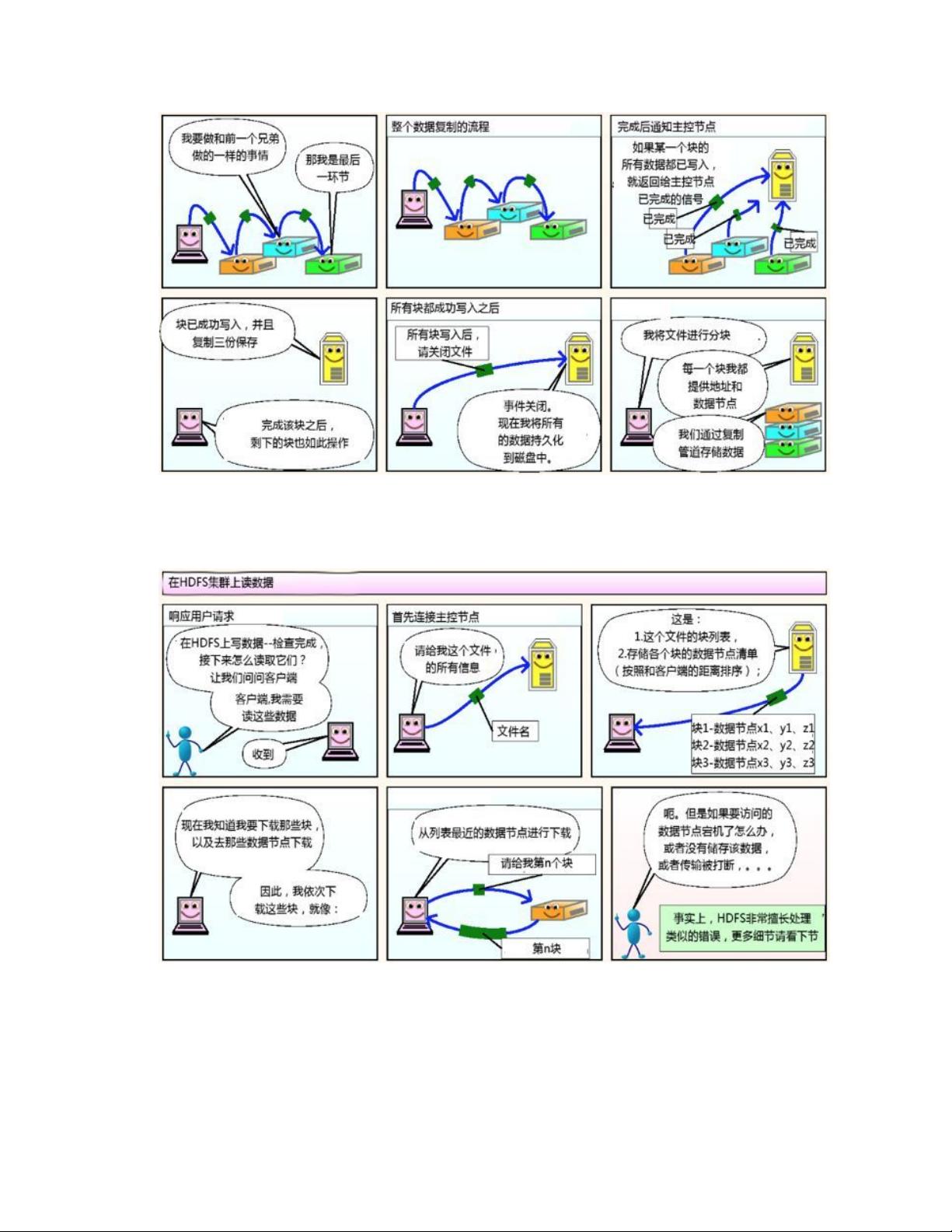

HDFS的核心在于其架构的可靠性和效率。首先,我们来看一下HDFS的工作流程。当用户执行写入操作时,数据会被分割成多个数据块(通常为64MB),这些块被分布式存储在DataNodes上,同时NameNode负责管理这些节点和文件系统的命名空间,包括权限控制。写入过程中,客户端会与NameNode交互,获取存储位置,而实际的数据块写入由DataNodes负责,这样既实现了负载均衡又增加了冗余备份,提高了系统的可靠性。

读操作同样依赖于NameNode的协调。客户端首先向NameNode请求文件块的地址,然后连接到存储对应块的DataNodes。HDFS通过副本机制来确保数据的一致性,通常每个块都会有多个副本,以防止单点故障。

关于容错性,HDFS通过以下机制处理可能遇到的问题:节点故障时,其他DataNodes仍能继续服务,因为它们持有文件的副本;通信问题可能导致NameNode和DataNodes之间的信息交换中断,但EditLog记录下所有操作日志,可以在NameNode恢复时进行回滚或修复;数据损坏可以通过DataNodes之间的校验和机制发现并恢复。

HDFS架构主要包括NameNode、DataNode和SecondaryNameNode三个关键组件。NameNode是主控节点,负责文件系统的全局状态,包含FsImage和EditLog两部分,前者用于持久化元数据,后者记录操作历史。DataNode负责存储实际的数据块,并与NameNode保持心跳,以实现故障检测和数据均衡。SecondaryNameNode作为NameNode的备份,负责定期合并EditLog和FsImage,从而保持系统的完整性和一致性。

HDFS的设计原则是简单、高效和容错。它通过将数据分布在多个节点上、使用复制策略以及维护详细的元数据,使得大数据处理变得可行,是Apache Hadoop生态系统中的基石,对于现代分布式计算和大数据应用至关重要。理解HDFS的工作机制对于从事后端架构和大数据开发的工程师来说是不可或缺的知识。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-02-25 上传

2020-03-02 上传

2020-01-16 上传

2020-05-02 上传

bingbingbingduan

- 粉丝: 0

- 资源: 7万+

最新资源

- Angular实现MarcHayek简历展示应用教程

- Crossbow Spot最新更新 - 获取Chrome扩展新闻

- 量子管道网络优化与Python实现

- Debian系统中APT缓存维护工具的使用方法与实践

- Python模块AccessControl的Windows64位安装文件介绍

- 掌握最新*** Fisher资讯,使用Google Chrome扩展

- Ember应用程序开发流程与环境配置指南

- EZPCOpenSDK_v5.1.2_build***版本更新详情

- Postcode-Finder:利用JavaScript和Google Geocode API实现

- AWS商业交易监控器:航线行为分析与营销策略制定

- AccessControl-4.0b6压缩包详细使用教程

- Python编程实践与技巧汇总

- 使用Sikuli和Python打造颜色求解器项目

- .Net基础视频教程:掌握GDI绘图技术

- 深入理解数据结构与JavaScript实践项目

- 双子座在线裁判系统:提高编程竞赛效率