深度学习基础:卷积神经网络与图像处理

72 浏览量

更新于2024-08-30

收藏 1.25MB PDF 举报

"卷积神经网络在计算机视觉中的应用,以及图像的基本表示方法"

卷积神经网络(Convolutional Neural Network, CNN)是机器学习领域,特别是计算机视觉中至关重要的模型。CNN的设计灵感来源于生物视觉系统,其核心在于卷积层,能够有效地捕获图像中的空间关系和特征。在深入理解CNN如何处理图像之前,我们需要先了解图像的基本表示方式。

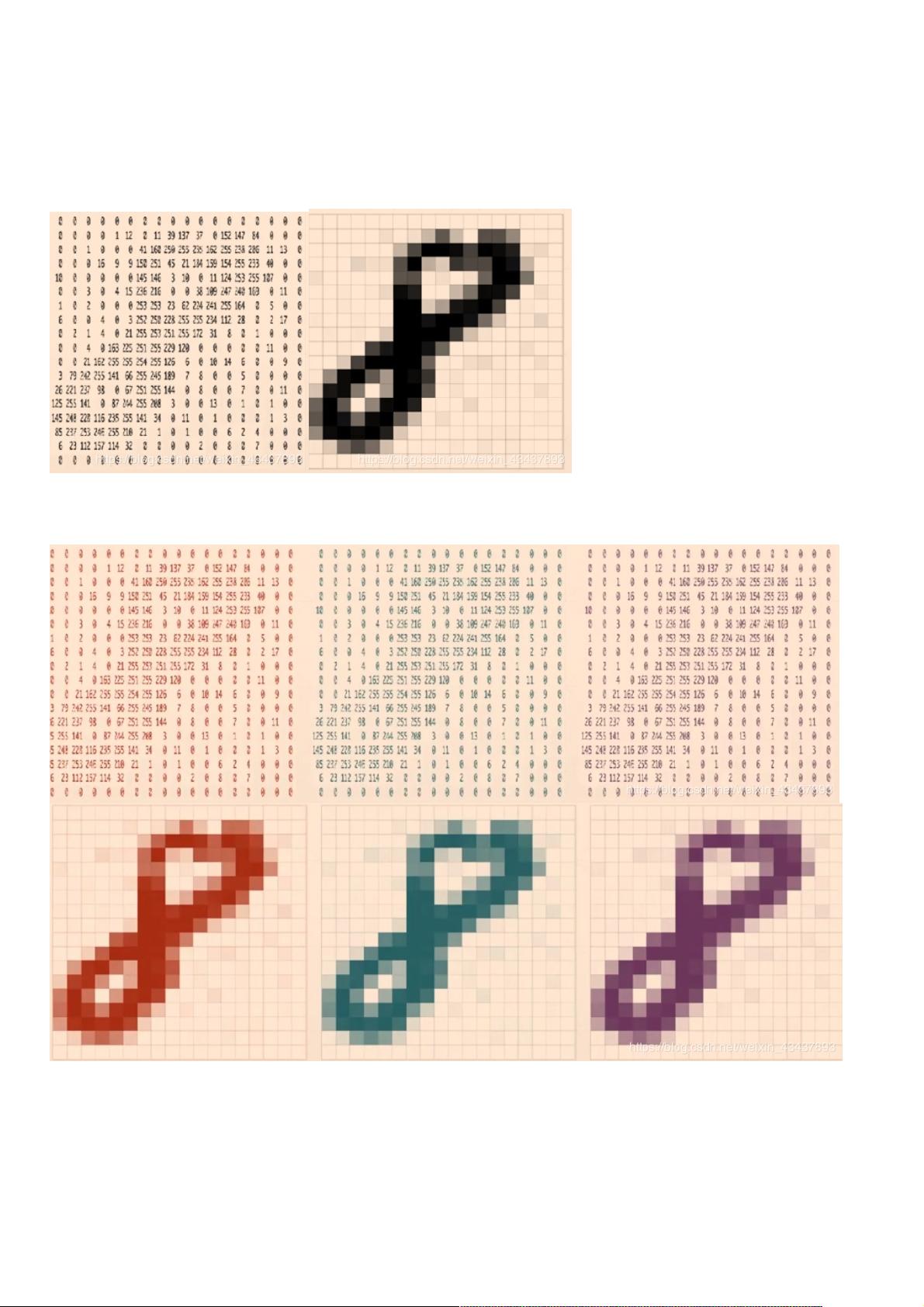

图像通常以二维矩阵的形式存在,对于单通道(如黑白图像)的MNIST数据集,其矩阵大小为28x28,每个元素代表对应像素的灰度值。灰度值范围通常在0到255之间,0表示白色,255表示黑色。在深度学习实践中,为了简化计算,通常会将这些值归一化到0到1之间。例如,通过除以255可以将原始值映射到这个范围内。

对于彩色图像,如RGB图像,每个像素由红、绿、蓝三个通道的值组成,每个通道也是一个0到255的灰度值。同样,这些值在处理前也会被归一化。在计算机内存中,彩色图像的数据结构是三个28x28矩阵的堆叠,分别对应RGB三个颜色通道。

在处理具有位置相关性的数据,如图像,传统的全连接网络(Fully Connected Network, FCN)并不适用,因为FCN将所有输入连接到每个神经元,忽略了输入的空间结构。相反,CNN使用卷积层来保留位置信息。卷积层通过滤波器(或称卷积核)对输入图像进行扫描,滤波器在图像上滑动并计算卷积,生成特征图。每个滤波器捕捉特定的特征,如边缘、纹理或颜色,这样就可以在不同位置识别出相同的模式。

卷积层之后通常会跟一个激活函数,如ReLU (Rectified Linear Unit),引入非线性,使得网络能够学习更复杂的模式。除了卷积层,CNN还包括池化层(Pooling Layer),用于减小特征图的尺寸,降低计算复杂度,并保持关键特征;批量归一化(Batch Normalization)层,加速训练过程,使模型更稳定;以及全连接层,用于分类或回归任务。

一个简单的CNN架构可能包括输入层(不计算在内,仅作为数据输入)、一个或多个卷积层、池化层,然后是全连接层,最后是输出层。隐藏层的数量可以根据任务的复杂性来调整,更多的隐藏层可以学习更复杂的表示,但也会增加模型的复杂性和训练时间。

总结来说,卷积神经网络通过其独特的结构和操作,如卷积、池化和激活函数,有效地处理图像数据,提取特征,并在诸如图像分类、物体检测等计算机视觉任务中展现出强大的性能。

2022-05-04 上传

2023-07-25 上传

2024-05-21 上传

2018-08-23 上传

2021-03-31 上传

2018-01-03 上传

2024-09-05 上传

weixin_38605604

- 粉丝: 3

- 资源: 853

最新资源

- 新代数控API接口实现CNC数据采集技术解析

- Java版Window任务管理器的设计与实现

- 响应式网页模板及前端源码合集:HTML、CSS、JS与H5

- 可爱贪吃蛇动画特效的Canvas实现教程

- 微信小程序婚礼邀请函教程

- SOCR UCLA WebGis修改:整合世界银行数据

- BUPT计网课程设计:实现具有中继转发功能的DNS服务器

- C# Winform记事本工具开发教程与功能介绍

- 移动端自适应H5网页模板与前端源码包

- Logadm日志管理工具:创建与删除日志条目的详细指南

- 双日记微信小程序开源项目-百度地图集成

- ThreeJS天空盒素材集锦 35+ 优质效果

- 百度地图Java源码深度解析:GoogleDapper中文翻译与应用

- Linux系统调查工具:BashScripts脚本集合

- Kubernetes v1.20 完整二进制安装指南与脚本

- 百度地图开发java源码-KSYMediaPlayerKit_Android库更新与使用说明