无监督时间建模:双向多速率视频重建

PDF格式 | 760KB |

更新于2025-01-16

| 47 浏览量 | 举报

“双向多速率重建视频时间模型是悉尼科技大学的研究者提出的一种无监督的时间建模方法,旨在解决视频领域缺乏足够标记数据的问题,特别是对于时间信息的建模。该模型称为多速率视觉递归模型(MVRM),通过训练不同间隔的剪辑帧来学习处理运动速度变化的能力。”

在视频分析中,时间信息的准确捕捉是至关重要的。早期的手工特征如密集轨迹(DT)和改进的密集轨迹(iDT)虽然能捕获视频运动结构,但因为光流计算的高昂成本和提取效率低而受到限制。随着深度学习的发展,深度视觉特征在图像分类和检测任务上表现出了优于传统手工特征的效能,但在视频表示学习方面仍然存在挑战。

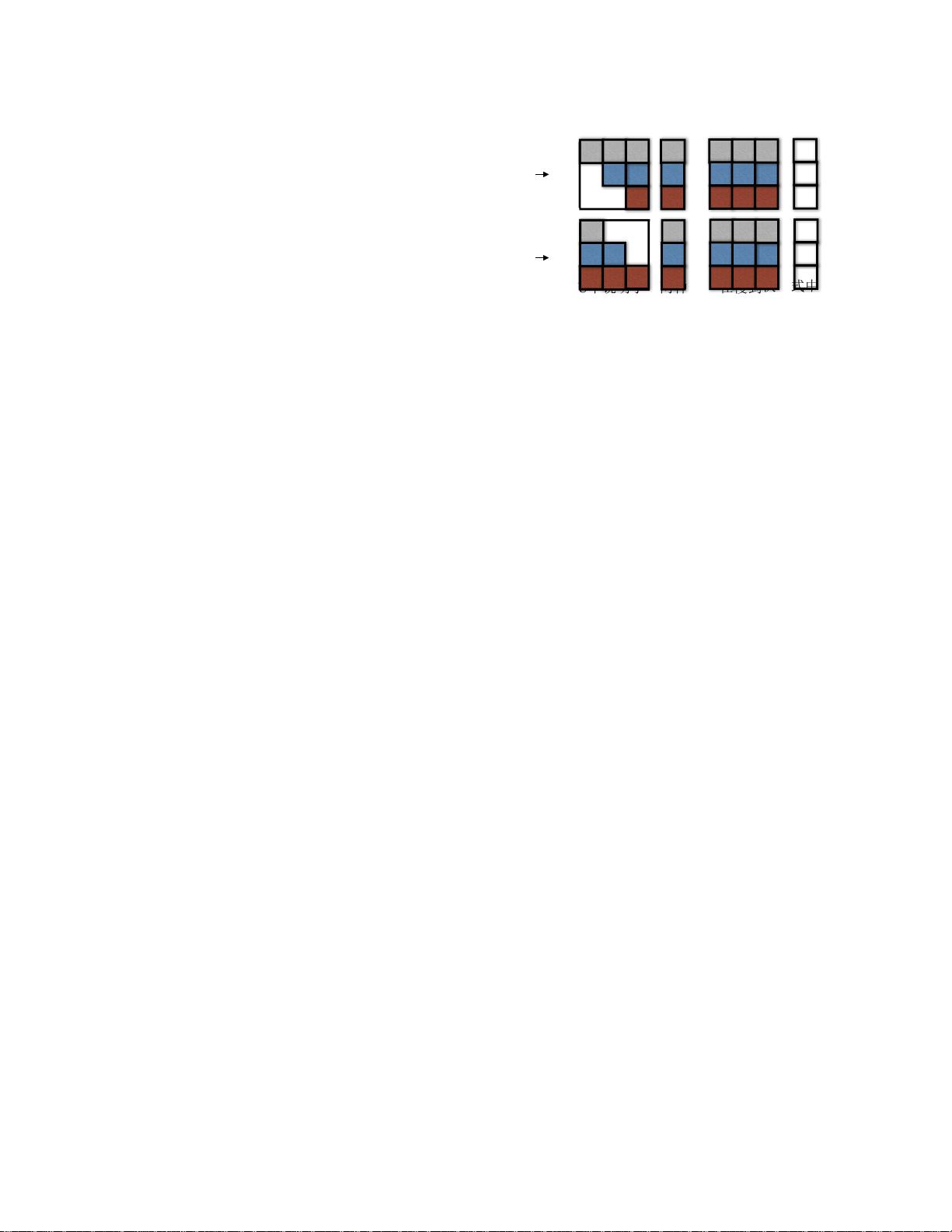

双向多速率重建视频时间模型(MVRM)的创新之处在于其无监督学习策略,能够从未修剪的视频中学习时间信息。考虑到运动速度的变化,模型通过编码不同间隔的帧来适应这种变化。例如,快速运动的场景可能需要更高的帧采样率,而静态或慢速运动的场景则可以使用较低的采样率(如图1所示)。这种方法使得学习到的模型更加灵活,能够更好地处理各种运动速度的情况。

MVRM的核心在于利用过去和未来相邻片段作为时间上下文,重建两个时间跨(现在→过去和现在→未来),这模拟了时间的双向流动。模型通过向后重建和前向重建的双向招募策略来实现这一目标,从而捕获不同时间点的视频信息。

该方法在实际应用中展示了优秀的性能,尤其是在复杂事件检测和视频字幕生成这两个具有挑战性的任务上。在MEDTest-13数据集上,对于事件检测,MVRM实现了最佳单一特征,相比现有方法提高了10.4%的表现。同时,在YouTube2Text数据集的全部评估指标上,MVRM也达到了视频字幕生成的最优效果。

双向多速率重建视频时间模型是一种有效的视频理解工具,通过无监督学习和多速率框架,能够在缺乏标注数据的情况下捕捉和建模时间信息,提高视频分析的准确性和效率。这一方法为未来视频理解和处理技术的发展提供了新的思路。

相关推荐

cpongm

- 粉丝: 6

最新资源

- Saber仿真下的简化Buck环路分析与TDsa扫频

- Spring框架下使用FreeMarker发邮件实例解析

- Cocos2d捕鱼达人路线编辑器开发指南

- 深入解析CSS Flex布局与特性的应用

- 小学生加减法题库自动生成软件介绍

- JS颜色选择器示例:跨浏览器兼容性

- ios-fingerprinter:自动化匹配iOS配置文件与.p12证书

- 掌握移动Web前端高效开发技术要点

- 解决VS中OpenGL程序缺失GL/glut.h文件问题

- 快速掌握POI技术,轻松编辑Excel文件

- 实用ASCII码转换工具:轻松实现数制转换与查询

- Oracle ODBC补丁解决数据源配置问题

- C#集成连接器的开发与应用

- 电子书制作教程:你的文档整理助手

- OpenStack计费监控:使用collectd插件收集统计信息

- 深入理解SQL Server 2008 Reporting Services