14745

0

将整体学习问题部分监督[19]。在处理视频的无监督异常检

测时,我们利用了视频相对于静态图像更丰富的信息和异常

事件相对于正常事件更少的事实[8,29,51,

67],并试图以结构化的方式利用这种领域知识。为此,我

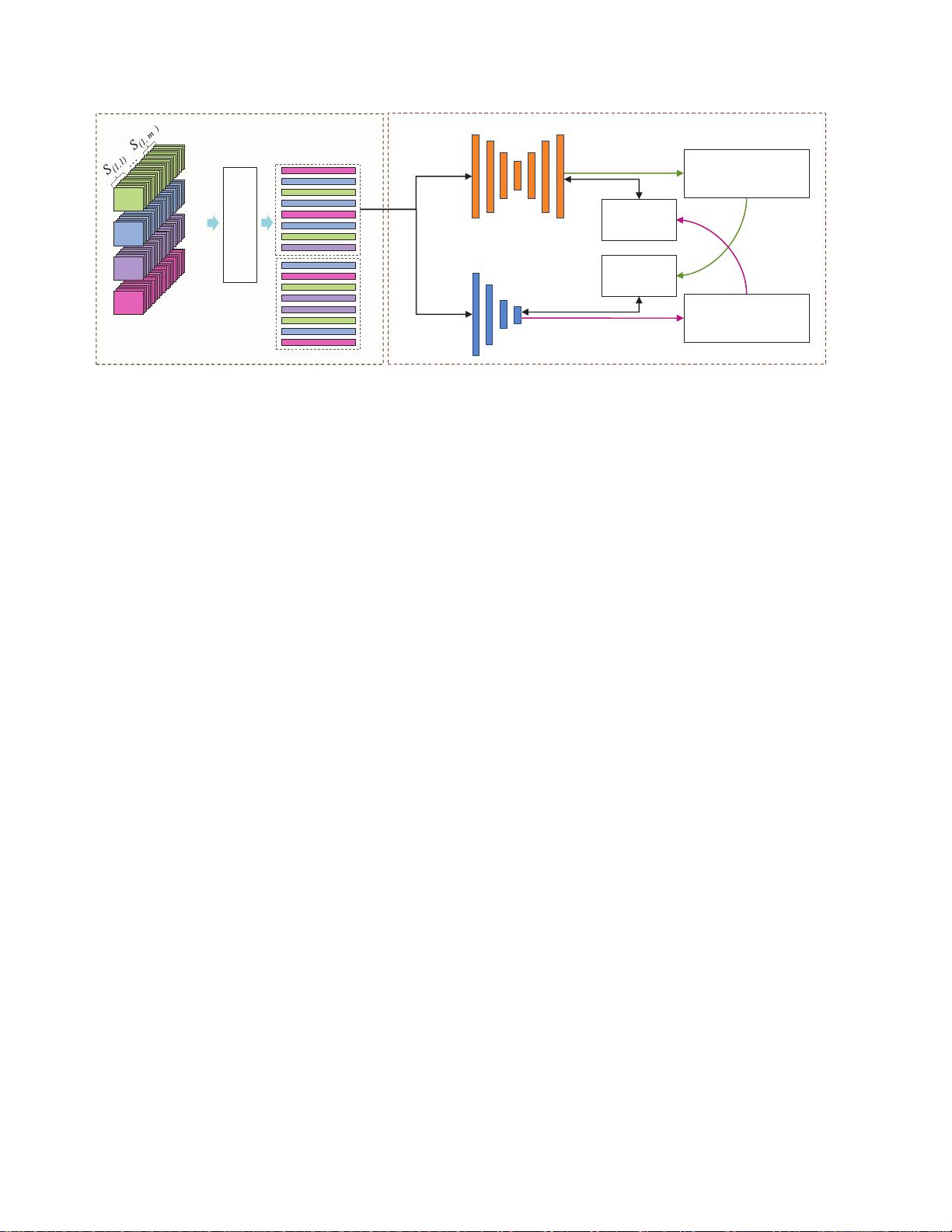

们提出了一种生成协作学习(GCL)方法,它以无标签视频

作为输入,并学习预测帧级异常分数预测作为输出。所提出

的GCL包括两个关键组件,一个生成器和一个判别器,它们

以相互合作的方式进行训练,以提高异常检测性能。生成器

不仅重构丰富可用的正常表示,还通过使用一种新颖的负学

习(NL)方法扭曲可能的高置信度异常表示。相反,判别器

估计实例为异常的概率。对于无监督异常检测,我们从生成

器创建伪标签,并使用这些标签来训练判别器。在下一步中

,我们从经过训练的判别器的版本创建伪标签,然后使用这

些标签来改进生成器。整个系统以交替的方式进行训练,在

每次迭代中,生成器和判别器都通过相互合作得到改进。贡

献。我们提出了一种能够在复杂的监控场景中定位异常事件

而不需要标记的训练数据的异常检测方法。据我们所知,我

们的方法是第一个在完全无监督模式下解决监控视频异常检

测的严格尝试。提出了一种新颖的生成协作学习(GCL)框

架,包括生成器、判别器和交叉监督。通过使用一种新颖的

负学习方法,强制生成器网络不重构异常。在两个大规模复

杂异常事件检测数据集UCF-Crime和ShanghaiTech上进行

了大量实验,结果显示我们的方法在基线和现有的无监督方

法以及OCC方法上都取得了可见的增益。

0

2.相关工作

0

异常检测是图像[7,16,39]和视频[49,50,64,67,

69]领域中广泛研究的问题。我们回顾了视频异常检测的不

同监督模式和相互学习策略。一类分类异常检测(OCC)。

OCC方法已经在包括医学诊断[58]、网络安全[11]、监控安

全系统[20,29,32,

64]和工业检测[5]等各种异常检测问题中得到应用。其中一

些方法使用手工设计的特征[3,31,38,55,

71],而其他方法使用使用预训练模型提取的深度特征[42,

47]。随着生成模型的出现,许多方法

0

提出了多种方法来学习正常数据表示[12,35,36,43-45,61,

62,

64]。OCC方法在避免对异常测试输入进行良好重构方面具

有挑战性。这个问题归因于OCC方法在训练时只使用正常类

数据,可能会得到一个有效的分类器边界,该边界在包含正

常数据的同时排除异常数据[64]。为了解决这个限制,一些

研究人员最近提出了伪监督方法,其中使用正常训练数据生

成伪异常实例[1,

64]。弱监督异常检测。使用视频级二进制注释来训练能够

预测帧级异常分数的弱监督分类器[40,50,52,65,67,69,

74]。视频级标签以这样的方式提供,即正常标记的视频完

全正常,而异常标记的视频包含正常和异常内容,没有关于

时间位置的任何信息(图1)。无监督异常检测。使用无标

签训练数据的异常检测方法在文献中非常稀少。根据图1所

示的命名方式,文献中的大多数无监督方法实际上属于OCC

类别。例如,MVTecAD[5]基准确保训练数据只是正常的,

因此其评估协议是OCC,继承这个假设的方法本质上也是一

类分类器[6,

12]。与这些算法相反,我们提出的GCL方法能够从无标签

训练数据中学习,而不假设任何正常性。以视频形式的训练

数据符合关于异常检测的几个重要属性,例如,异常事件比

正常事件更少,事件通常在时间上保持一致。我们从这些线

索中得到启发,以完全无监督的方式进行训练。教师学生网

络。我们提出的GCL与知识蒸馏的教师学生(TS)框架有一

些相似之处[18]。GCL与TS框架的不同之处主要在于其目标

不是知识蒸馏。此外,我们的生成器生成带有噪声的标签,

而我们的判别器对噪声相对鲁棒,清除这些标签,而在TS框

架中不是这种情况。相互学习(ML)。GCL框架与ML算法[

73]也有一些相似之处。然而,GCL的两个组成部分学习不

同类型的信息,并通过交叉监督进行训练,而ML算法使用

的是监督学习。此外,在GCL中,每个网络的输出通过阈值

处理产生伪标签。在ML中,队伍学习使每个成员的分布相

匹配,而在GCL中,每个成员试图从其他成员生成的伪标签

中学习。使用无标签训练数据的无监督模式下的队伍相互学

习尚未被探索。