单目视频无监督学习深度与自我运动估计框架

PDF格式 | 1.85MB |

更新于2025-01-16

| 69 浏览量 | 举报

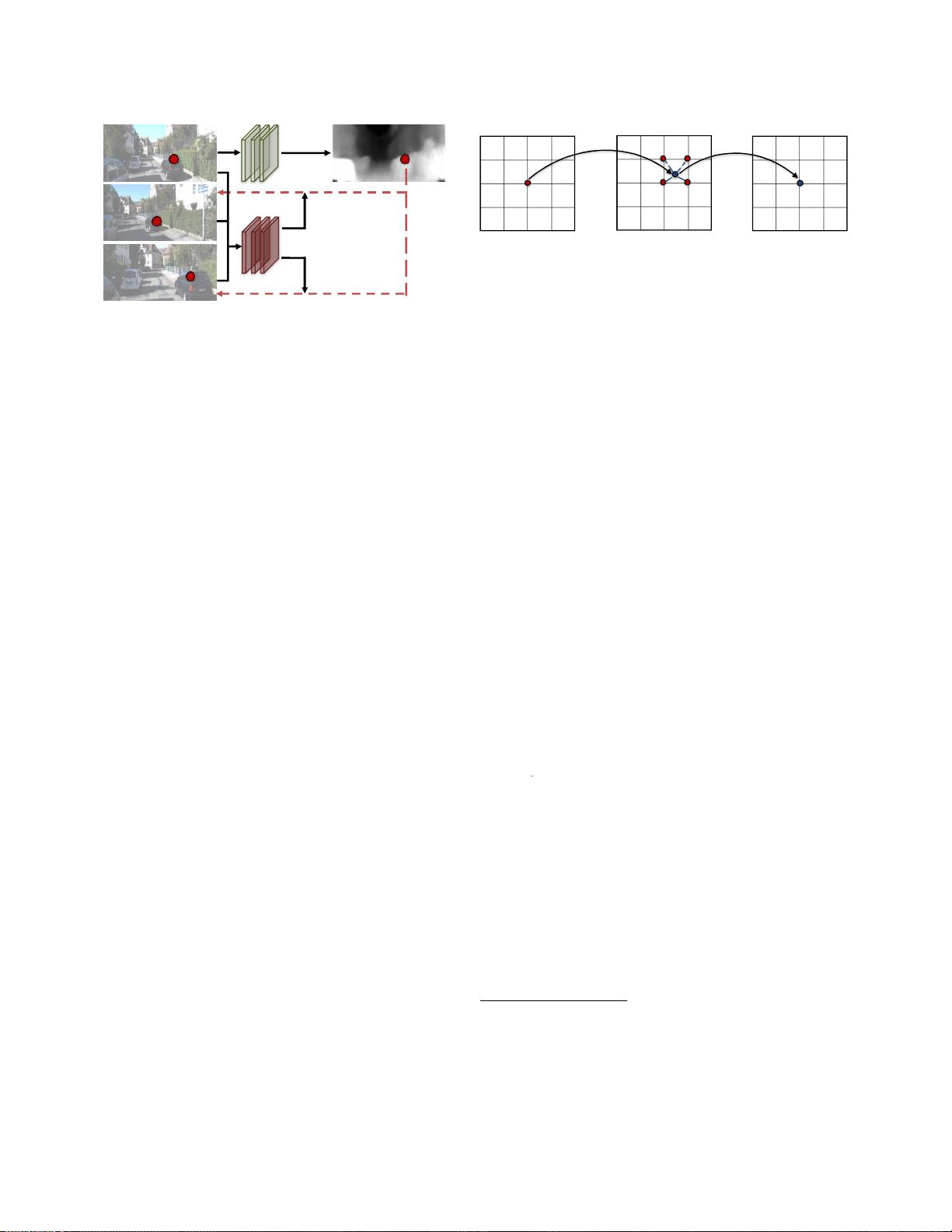

"本文探讨了一个无监督学习框架,该框架专注于使用单眼视频序列估计深度和自我运动。研究由加州大学伯克利分校和谷歌的研究人员共同完成,提出的方法无需任何预先标注的数据,仅依赖单目视频进行训练。该方法结合了单视图深度和多视图姿态网络,通过视图合成损失进行优化,使得网络在训练过程中相互耦合,但在测试时可以独立运行。实验结果显示,该方法在KITTI数据集上表现优秀,深度预测精度提高了10%,并且在相似的输入条件下优于传统的SLAM系统。"

文章的核心知识点包括:

1. 无监督学习:与以往依赖于标记数据的方法不同,该框架创新性地采用无监督学习,仅用未标注的单目视频就能训练模型,从而估计深度和相机运动。

2. 单视图深度和多视图姿态网络:模型由两个部分组成,一部分预测单视图深度,另一部分估计多视图的相机姿态。这两个部分在训练时共享视图合成损失,但在实际应用中可以独立运作。

3. 视图合成损失:作为监督信号,视图合成损失使网络能够通过计算的深度和姿态将相邻视图扭曲到目标视图,以此来优化网络性能。

4. 端到端学习:整个模型的训练过程是端到端的,直接从输入像素映射到相机的6-DoF变换矩阵估计和底层场景的深度图。

5. 实际应用与效果验证:在KITTI数据集上的实验表明,该方法在单目深度预测上超越了其他单目深度方法,同时在与SLAM系统的比较中也表现出优越性,证明了其在实际场景中的有效性和实用性。

6. 人类视觉启发:研究灵感来源于人类如何通过观察和移动来理解环境,通过大量的视觉经验形成对世界的结构化理解。模型试图模拟这一过程,通过预测相机运动和场景结构来解释观察到的图像序列。

7. 应用场景:这种技术有潜力应用于自动驾驶、机器人导航、增强现实等领域,帮助系统更好地理解和预测周围环境。

该研究对于推动无监督学习在计算机视觉领域的应用,尤其是在深度估计和运动估计方面,具有重要意义。通过减少对标注数据的依赖,这种方法为未来更高效、更广泛的学习模型提供了可能。

相关推荐

407 浏览量

cpongm

- 粉丝: 6

最新资源

- 初学者入门必备!Visual C++开发的连连看小程序

- C#实现SqlServer分页存储过程示例分析

- 西门子工业网络通信例程解读与实践

- JavaScript实现表格变色与选中效果指南

- MVP与Retrofit2.0相结合的登录示例教程

- MFC实现透明泡泡效果与文件操作教程

- 探索Delphi ERP框架的核心功能与应用案例

- 爱尔兰COVID-19案例数据分析与可视化

- 提升效率的三维石头制作插件

- 人脸C++识别系统实现:源码与测试包

- MishMash Hackathon:Python编程马拉松盛事

- JavaScript Switch语句练习指南:简洁注释详解

- C语言实现的通讯录管理系统设计教程

- ASP.net实现用户登录注册功能模块详解

- 吉时利2000数据读取与分析教程

- 钻石画软件:从设计到生产的高效解决方案