通过合成来自与I

i

相似的其他视频的帧来合成

I

i

帧

,然后将合成的帧与

I

j

进行

比较以进行对比学习。

假设我们有一个神经网络特征提取器要学习,我

们提取图像

帧

Ii

的特征表示

为qi

,

并且提取来自其他视

频的帧的表示为U

=

u1

,

u2

,

…

嗯

。 给定这些表

示,我们计算q

i

和U

之间的相似性

,并

将其归一化为

概率分布。我们使用该概率分布来重新加权和组合

特征

U

作为帧

Ii

的新特征表示(与

Ii

更相似的帧将具有

更大的权重)。 我们称

这个新特征为

Ii

的软最近

邻。然后,我们

用这个新的表示和

Ij

的特征(来自

与

Ii

相同的视频的不同帧)形成训练数据的正对。

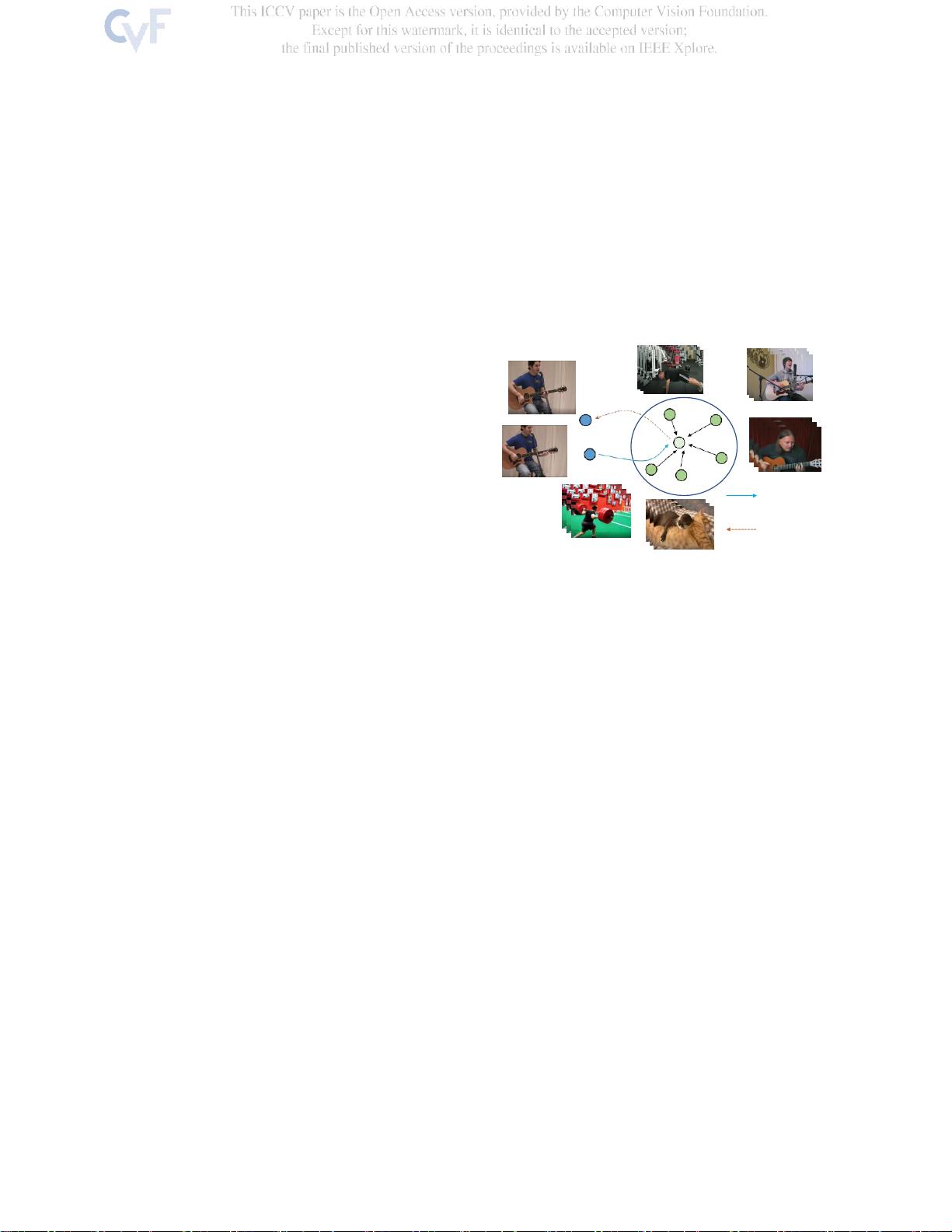

如图

1

所示, 该过程经历从视频中的一个帧

Ii

开

始、

通过匹配来自其他视频的帧来向前搜索、

以及

在第一视频中向后检索帧

Ij

的循环。 我们

称这个

过程为

周期一致性对比学习

。直观地,强制执行这样

的周期一致性可以显式地

将具有相似结构的视频帧推

得更近,从而

导致语义的自然聚类。

我 们 在 未 标 记的 视 频 数 据 集 随 机 相 关 视 频 视 图

(R2V2)[21]上执行所提出的自监督表示学习,并将

学习的表示转移到各种下游任务,包括视觉对象跟

踪,图像分类和动作识别。我们强调我们的目标是使

用时间信号来学习 用于视频级识别任务之外的多个

应用的通用图像级表示。我们在多个国家的最先进的

approaches显着改善。我们还进行了广泛的消融研究的

不同组成部分和我们的方法的设计选择。

我们的贡献包括:(i)一个新的跨视频周期一致的

对比学习目标,探索跨视频关系,超越以前的图像内

和视频内不变学习;(ii)所提出的损失强制来自相同

类别(类似视觉结构)的图像表示更接近,而不明确

地生成伪标签;(iii)学习的图像表示在包括对象跟

踪、图像分类和动作识别的多个下游任务中实现了显

著的改进。

2.

相关工作

对比学习。自监督对比学习方法[23,16,66,29,

45,3,28,57,79,9,26,41,10,8]试图通过形

成正对和负对来学习不同变换下的图像表示,并使正

对的表示具有高相似性,负对具有低相似性。生成正

对的典型方式是执行人工

在单个图像实例上的cial数据增强。例如,Chenet al.[9]

介绍了一种具有不同类型增强的对比学习基线,包括

随机裁剪,调整大小,颜色失真,高斯模糊

等

。He等

人[26]提出了MoCo,其引入动量网络来编码大量负样

本的队列在这项工作中,我们建立我们的模型的基础

上的MoCo框架。然而,我们提出了一个新的目标,而

不是通过增强相同的图像来学习正对,它可以在视频

中找到正对的样本,用于图像表示的对比学习。

从视频中学习自监督图像表示。超越从单个图像学

习[15,13,48,14,73,19,56],视频自然地为对

象提供时间信息和多视点,其已被广泛用作表征学习

中的自我监督信号[22,1,33,61,47,46,42,

62,40 ,7,64,35 , 46,46 , 47,47,47,47,

47,47,47,47,47,47,47,47,47,47,47,

47,47,47,47,47,47,47,47,47,47,47,

47,47,47,47,47,47,47,47,47,47,47,

47,47,47,47,47,47,47,47,47,47,47,

47,47,47,47,4 52]。

例如,Wang和Gupta [61]使用跟踪来提供监督信号,

该监督信号使跟踪的补丁的特征表示相似。最近的作

品[21,49,32,69]进一步扩展了对比学习框架下视

频帧之间的相似性学习已经示出了具有视点不变性的

图像表示我们的工作是由这些以前的作品的动机,超

越视点不变性,学习使用积极的对跨视频可能会导致

图像表示与更高层次的语义。虽然对比学习也已应用

于 使 用 3D ConvNets 进 行 动 作 识 别 的 视 频 表 示 学 习

[35,24,37,5,51,59,25,34,43],但我们强调

我们的工作重点是学习除动作识别之外的多个任务的

通用图像表示,包括视觉跟踪和图像分类。

周期一致性学习我们的工作受到不同计算机视觉应

用中的周期一致性学习的影响,包括3D场景理解[31,

74,20,21]。

72]、图像对准和平移[75,77,76,78],以及

视频中的时空对齐[4, 63,39,17,60, 32, 50,

38]。例如,Wanget al. [63]提出在时间上执行前向和后

向 跟 踪 以 实 现 用 于 学习 时 间 对 应 的 周 期 一 致 性 。

Dwibedi等人[17]制定了一个时间周期一致性损失,其

将帧从一个视频对准到另一个视频。 一对视频,并

在视频帧对齐任务中实现了良好的性能。在这两部作

品的基础上,Pu- rushwalkam

等人

。[50]提出在视频中

跟踪对象块并同时跨视频对齐它们。虽然这些结果令

人鼓舞,但从视频对学习的两种方法[17,50]都需要

人类注释者在小规模视频的训练中提供地面实况对

(视频级)。在本文中,我们建议