3D-LaneNet:端到端3D车道检测的深度学习方法

PDF格式 | 1.26MB |

更新于2025-01-16

| 168 浏览量 | 举报

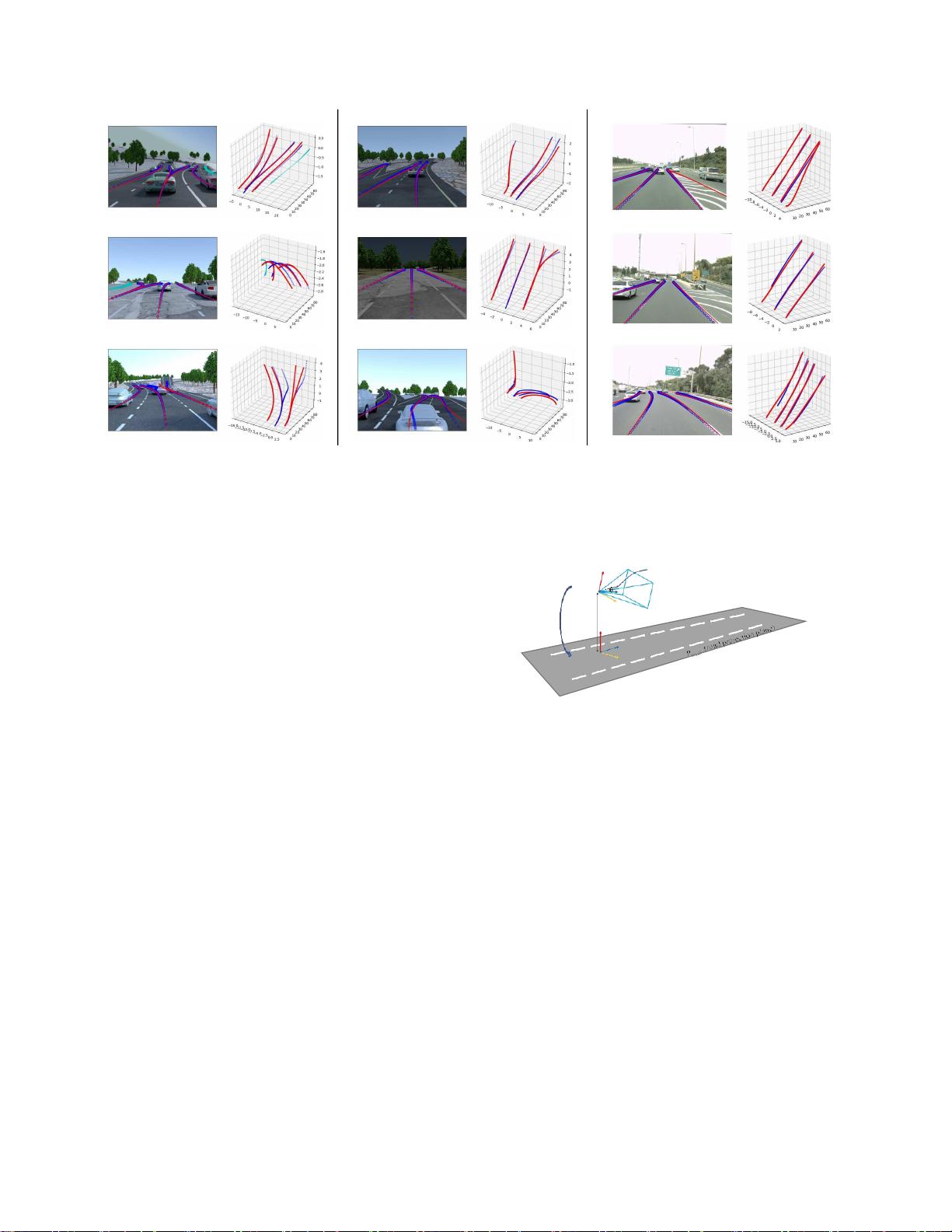

"3D-LaneNet是一个深度学习网络架构,设计用于从单张图像中直接预测3D车道的布局。该网络创新性地结合了网络内反向透视映射(IPM)和基于锚点的车道表示,解决了自动驾驶中3D车道检测的问题。3D-LaneNet的目标是在图像域中检测出车道线,并将其转换为3D空间中的曲线,从而提供准确的车道位置信息。这种方法相比传统的基于图像的检测和简单的3D投影,能更好地处理复杂的道路情况,如车道合并和分叉。

1. 网络架构与技术亮点

- 网络内反向透视映射(IPM):这是一种将常规图像视图与顶视图信息相结合的技术,它促进了不同视角间的信息流,有助于网络理解道路的几何结构。

- 基于锚点的车道表示:3D-LaneNet借鉴了目标检测中的锚点机制,每列输出代表一个车道,将车道检测问题转化为一个检测任务,减少了对聚类和离群值剔除等后处理步骤的依赖。

2. 应用场景与挑战

- 3D车道检测:对于自动驾驶汽车来说,准确估计3D车道位置至关重要,因为它直接影响车辆的路径规划和安全行驶。

- 复杂情况处理:3D-LaneNet设计考虑了实际道路上可能出现的复杂情况,如车道合并、分叉以及非平坦地面,提高了检测的鲁棒性和准确性。

3. 数据集与评估

- 3D车道数据集:为了训练和验证模型,创建了两个新的3D车道数据集,一个合成数据集和一个真实世界数据集,提供了丰富的场景变化和挑战。

- 基准测试:同时,3D-LaneNet还在传统的tuSimple车道检测基准上进行了测试,以与现有方法进行对比,展示其性能。

4. 相关技术比较

- 离线预映射与实时感知:离线解决方案依赖于预先生成的地图,而3D-LaneNet采用实时感知,无需精确的主机定位,简化了部署和维护。

- 单目深度估计:受到单目深度估计方法的启发,3D-LaneNet直接预测3D信息,避免了传统方法因假设平坦地面和固定车道宽度而导致的误差。

总结来说,3D-LaneNet是自动驾驶领域的一个重要进展,它提供了一种直接、高效的方法来处理3D车道检测问题,增强了自动驾驶车辆的环境理解和导航能力。"

相关推荐

cpongm

- 粉丝: 6

最新资源

- DeepFreeze密码移除工具6.x版本使用教程

- MQ2烟雾传感器无线报警器项目解析

- Android实现消息推送技术:WebSocket的运用解析

- 利用jQuery插件自定义制作酷似Flash的广告横幅通栏

- 自定义滚动时间选择器,轻松转换为Jar包

- Python环境下pyuvs-rt模块的使用与应用

- DLL文件导出函数查看器 - 查看DLL函数名称

- Laravel框架深度解析:开发者的创造力与学习资源

- 实现滚动屏幕背景固定,提升网页高端视觉效果

- 遗传算法解决0-1背包问题

- 必备nagios插件压缩包:实现监控的关键

- Asp.Net2.0 Data Tutorial全集深度解析

- Flutter文本分割插件flutter_break_iterator入门与实践

- GD Spi Flash存储器的详细技术手册

- 深入解析MyBatis PageHelper分页插件的使用与原理

- DELPHI实现斗地主游戏设计及半成品源码分析