3DCrowdNet:针对野外拥挤场景的3D人体网格估计

58 浏览量

更新于2025-01-16

收藏 13.77MB PDF 举报

"本文介绍了3DCrowdNet,这是一种专门针对野外拥挤场景进行3D人体网格学习和估计的方法,旨在克服现有技术在处理此类复杂环境时的局限性。"

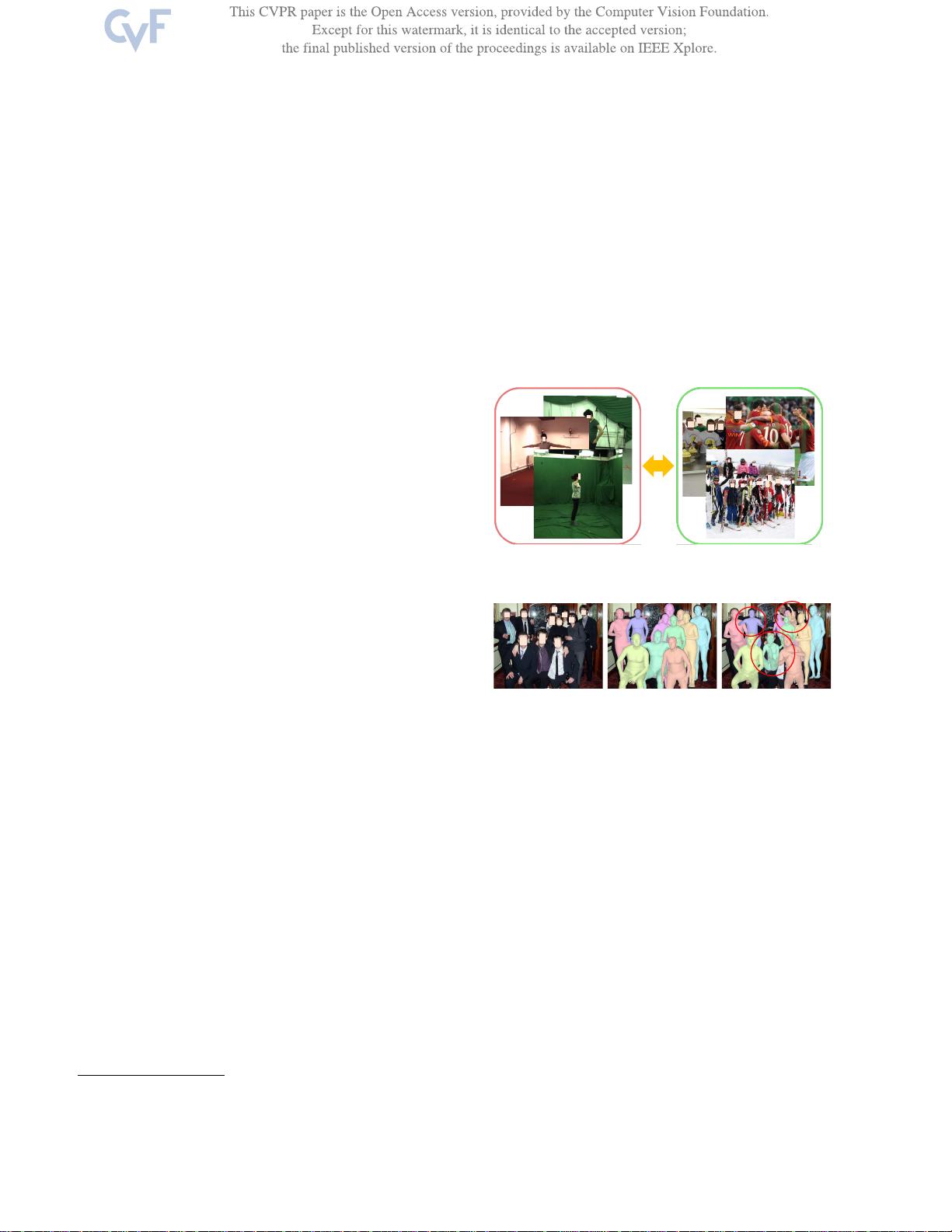

在3D人体网格估计领域,尽管已经取得了显著的进步,但在处理野外环境中的拥挤场景时,现有方法常常遇到困难。这主要归因于两个关键问题:一是训练数据与测试数据间的域差异,运动捕捉数据集虽能提供精确的3D标签,但缺乏对拥挤情况的覆盖;二是处理特征时的平均化策略,导致目标人物的特征与背景或其他人物的特征混淆。

3DCrowdNet通过创新策略解决了这些问题。首先,它不再依赖运动捕捉数据集进行训练,从而减少了域差的影响。其次,它引入了一种基于关节的回归器,该回归器通过在目标关节位置采样特征,然后回归人体模型参数,保持了目标人物的空间激活,有效地区分了目标人物与其他人物的特征。

这一方法的核心在于,3DCrowdNet学会了以目标为中心的特征表示,能够有效地过滤掉邻近人物的无关特征。通过在多个基准测试上的定量和定性评估,3DCrowdNet证明了其在处理野外拥挤场景时的稳健性。

在实际应用中,如异常行为检测和人员重新识别,3D人体网格的准确估计至关重要,尤其是在有遮挡的拥挤环境中。3DCrowdNet的出现为解决这个问题提供了一个新的视角和解决方案。通过其公开的代码,研究者和开发者可以进一步探索和利用这种方法,提高在复杂环境下的3D人体网格估计性能。

3DCrowdNet是一项重要的学术研究成果,它不仅揭示了现有技术在处理拥挤场景时的不足,还提出了一种新的、有效的解决策略,为未来在类似领域的研究奠定了基础。通过3DCrowdNet,我们有望在现实世界的应用中看到更准确的人体网格估计,特别是在人群密集的场景下。

2023-09-11 上传

278 浏览量

177 浏览量

2024-11-04 上传

2024-11-01 上传

2024-11-07 上传

309 浏览量

118 浏览量

2024-11-01 上传

cpongm

- 粉丝: 6

最新资源

- Openaea:Unity下开源fanmad-aea游戏开发

- Eclipse中实用的Maven3插件指南

- 批量查询软件发布:轻松掌握搜索引擎下拉关键词

- 《C#技术内幕》源代码解析与学习指南

- Carmon广义切比雪夫滤波器综合与耦合矩阵分析

- C++在MFC框架下实时采集Kinect深度及彩色图像

- 代码研究员的Markdown阅读笔记解析

- 基于TCP/UDP的数据采集与端口监听系统

- 探索CDirDialog:高效的文件路径选择对话框

- PIC24单片机开发全攻略:原理与编程指南

- 实现文字焦点切换特效与滤镜滚动效果的JavaScript代码

- Flask API入门教程:快速设置与运行

- Matlab实现的说话人识别和确认系统

- 全面操作OpenFlight格式的API安装指南

- 基于C++的书店管理系统课程设计与源码解析

- Apache Tomcat 7.0.42版本压缩包发布