深度学习驱动的RGB相机转RGB-D:连续深度估计与不确定性处理

PDF格式 | 4.28MB |

更新于2025-01-16

| 122 浏览量 | 举报

RGB→D传感:单目深度不确定性的深度学习估计方法

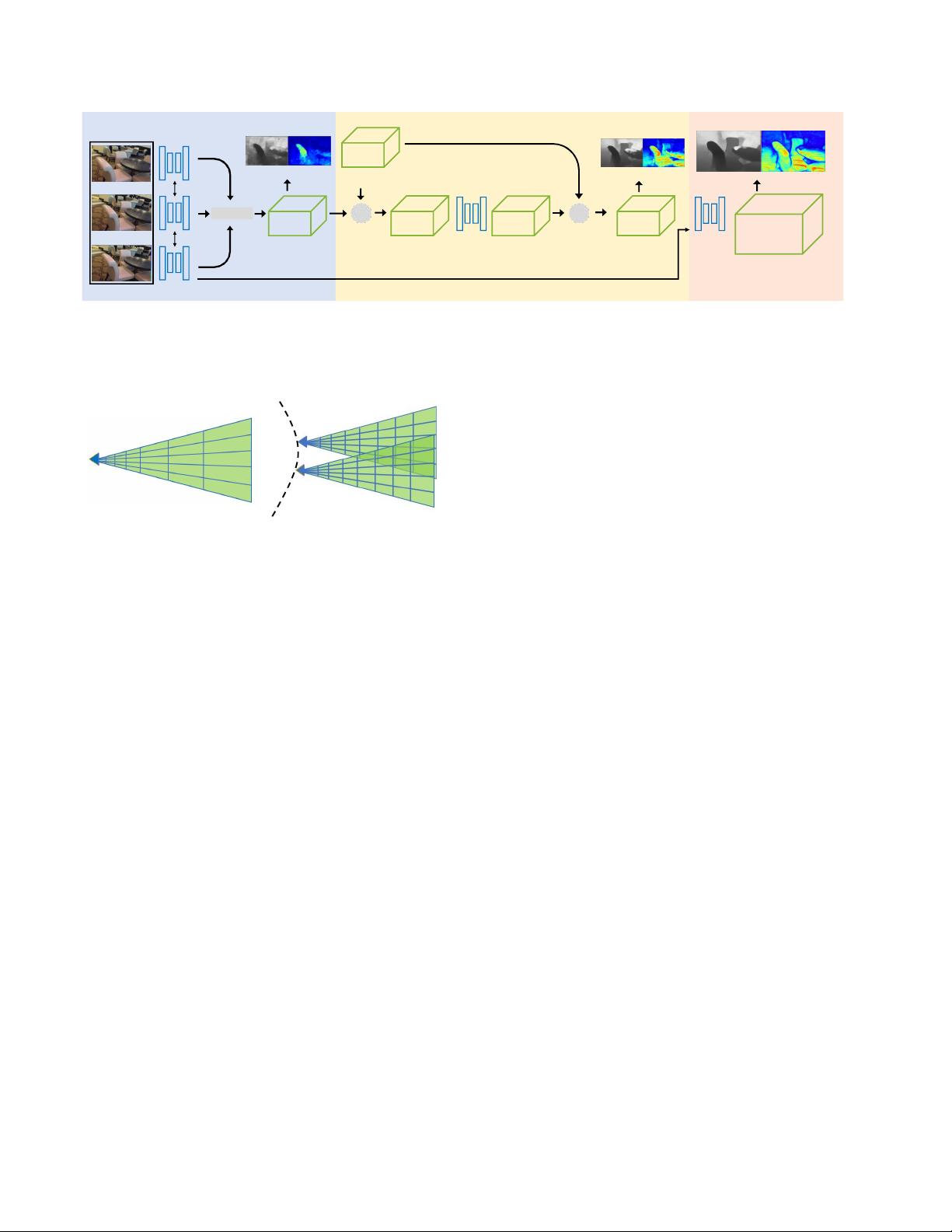

深度学习在计算机视觉领域的应用日益广泛,尤其是在三维重建和场景理解方面,传统的有源深度传感器如飞行时间相机和LiDAR虽然能提供密集的深度信息,但它们存在诸多局限性,如有限的操作范围、低空间分辨率、高能耗和传感器干扰。为克服这些问题,本文提出了一种创新的深度学习技术,旨在从单目视频流中实时估计每个像素的深度及其不确定性。

不同于传统的深度学习方法,该研究不再仅关注单一深度值的估计,而是采用深度概率分布的方式,这样可以为每个输入帧提供三维深度的概率分布量。这种方法运用了贝叶斯滤波框架,通过连续处理多个输入帧,逐步降低深度不确定性,提高精度、鲁棒性和时间稳定性。这种处理方式使得RGB相机能够模拟RGB-D相机的功能,实现更加准确、稳定和可扩展的深度感知。

与其他现有工作相比,该方法在深度估计的准确性和泛化能力上有所突破,能够在保持高效的同时解决单目方法的尺度模糊和漂移问题,以及立体和多视图方法的对应难题和高计算成本。实验结果证明,该方法的输出可以直接用于经典的RGB-D三维扫描方法,用于构建三维场景模型,显著提升了三维重建的质量和效率。

总结来说,本文的工作主要贡献在于提出了一种深度学习驱动的单目深度估计框架,它不仅能提供精确的深度估计,还提供了深度的不确定性信息,这对于增强现实、自动驾驶等对实时三维感知要求高的应用场景具有重要意义。通过结合深度学习的模型能力和单目视觉的优势,该方法有望推动RGB-D传感技术的发展,进一步拓展计算机视觉在更多领域的应用。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 初学者入门必备!Visual C++开发的连连看小程序

- C#实现SqlServer分页存储过程示例分析

- 西门子工业网络通信例程解读与实践

- JavaScript实现表格变色与选中效果指南

- MVP与Retrofit2.0相结合的登录示例教程

- MFC实现透明泡泡效果与文件操作教程

- 探索Delphi ERP框架的核心功能与应用案例

- 爱尔兰COVID-19案例数据分析与可视化

- 提升效率的三维石头制作插件

- 人脸C++识别系统实现:源码与测试包

- MishMash Hackathon:Python编程马拉松盛事

- JavaScript Switch语句练习指南:简洁注释详解

- C语言实现的通讯录管理系统设计教程

- ASP.net实现用户登录注册功能模块详解

- 吉时利2000数据读取与分析教程

- 钻石画软件:从设计到生产的高效解决方案