视频弱监督下人机交互检测:挑战与方法

PDF格式 | 975KB |

更新于2025-01-16

| 62 浏览量 | 举报

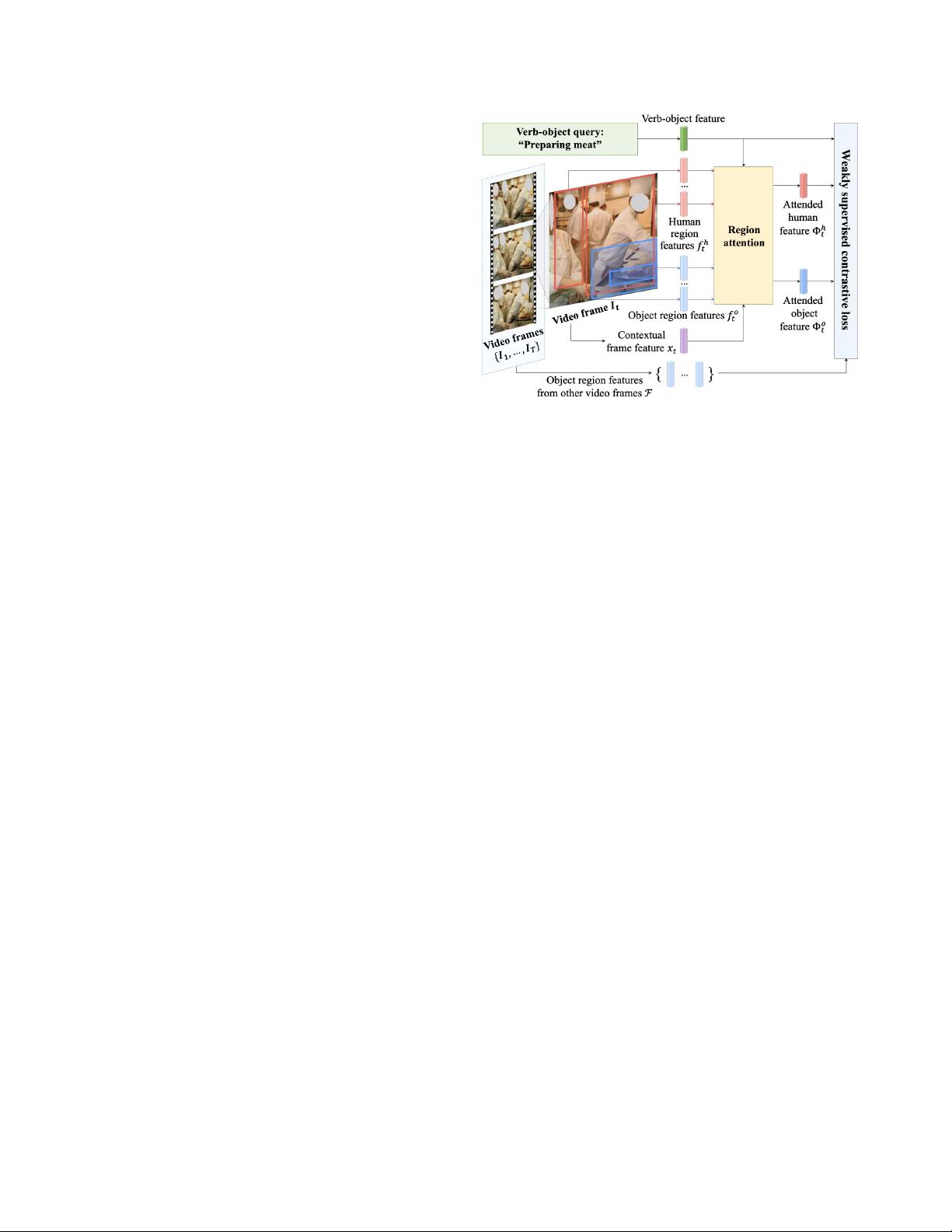

本文探讨了弱监督学习在视频中人机交互检测任务中的应用及面临的挑战。传统的任务,如在静止图像中识别人与物体的交互,通常依赖于密集的边界框标注数据。然而,视频交互检测更为复杂,因为系统需要在连续的帧中准确识别和定位人物以及互动对象,而这些信息在弱监督条件下通常是缺失的。

作者提出了一种新颖的解决策略,即引入对比性弱监督训练损失,它通过结合视频中的时空区域与动作和对象词汇,促使模型理解移动对象在不同时间点的视觉特征。这种方法有助于模型在没有明确边界框标注的情况下学习人机交互的模式。为了构建一个适合该任务的数据集,研究人员设计了一种半自动标注流程,从与视频相关的句子标题中提取人机交互的线索,从而创建了一个包含超过6500个带有交互注释的视频库。

相较于传统的强监督学习方法,弱监督学习的优势在于降低了标注成本,但这也带来了显著的挑战,例如识别的不准确性,以及对模型泛化能力的要求。模型必须能够处理各种类型的交互,而且在面对未见过的交互行为时能自我适应。因此,本文的工作不仅关注技术实现,也着重于评估模型在弱监督环境下的性能提升,并证明了在无边界框监督的基准上取得了有意义的进步。

本文的研究为视频人机交互检测这一领域开辟了新的可能性,展示了弱监督学习如何在实际场景中克服数据标注的限制,推动了计算机视觉技术向着更高效、实用的方向发展。同时,它也提出了未来研究的方向,即如何进一步优化算法,提高模型在复杂和动态交互环境下的性能。

相关推荐

cpongm

- 粉丝: 6

最新资源

- Openaea:Unity下开源fanmad-aea游戏开发

- Eclipse中实用的Maven3插件指南

- 批量查询软件发布:轻松掌握搜索引擎下拉关键词

- 《C#技术内幕》源代码解析与学习指南

- Carmon广义切比雪夫滤波器综合与耦合矩阵分析

- C++在MFC框架下实时采集Kinect深度及彩色图像

- 代码研究员的Markdown阅读笔记解析

- 基于TCP/UDP的数据采集与端口监听系统

- 探索CDirDialog:高效的文件路径选择对话框

- PIC24单片机开发全攻略:原理与编程指南

- 实现文字焦点切换特效与滤镜滚动效果的JavaScript代码

- Flask API入门教程:快速设置与运行

- Matlab实现的说话人识别和确认系统

- 全面操作OpenFlight格式的API安装指南

- 基于C++的书店管理系统课程设计与源码解析

- Apache Tomcat 7.0.42版本压缩包发布