构建高效半监督学习模型:8个挑战与解决方案的终极指南

发布时间: 2024-11-19 17:27:08 阅读量: 2 订阅数: 3

# 1. 半监督学习模型概述

在当今数据驱动的时代,机器学习模型已经成为了技术发展的重要支柱。尽管监督学习方法在许多领域取得了巨大成功,但在现实生活中,获取大量标注数据往往代价昂贵且耗时。半监督学习作为一种机器学习范式,它的出现解决了这个难题。半监督学习综合利用了标注数据和未标注数据,不仅提高了学习效率,也降低了对大量标注数据的依赖。本章将对半监督学习模型进行概述,探索其核心概念、优势以及在现实世界中的应用场景。

```mermaid

graph LR

A[未标注数据] -->|模型学习| B[半监督学习模型]

C[少量标注数据] -->|辅助学习| B

B --> D[提升预测准确性]

```

- **未标注数据**:大量的未标注数据用于捕捉数据的底层分布。

- **少量标注数据**:少量的标注数据提供关键信息,帮助模型理解任务目标。

- **模型**:结合两种数据进行学习,提高模型性能。

半监督学习在很多领域显示了它的优势,比如图像识别、自然语言处理等。它不仅能够提升模型的准确度,还能在标注资源匮乏的情况下,实现高效的模型训练和优化。接下来的章节我们将深入探讨半监督学习的核心理论,以及如何构建和应用半监督学习模型。

# 2. 半监督学习的核心理论

### 2.1 无监督与监督学习的融合

#### 2.1.1 理解无监督学习

无监督学习是机器学习的一个分支,它涉及发现数据中的模式或结构,但无需预先标记的数据。在无监督学习中,算法试图识别隐藏在未标记数据中的结构,通常旨在揭示数据的底层分布。常见的无监督学习算法包括聚类算法(如K-means、层次聚类)、关联规则学习(如Apriori算法)以及降维技术(如PCA、t-SNE)。

例如,K-means聚类算法旨在将数据点划分为K个簇,每个簇内的数据点相似度高,而不同簇间的数据点相似度低。降维技术如PCA则通过线性变换将原始数据映射到较低维的空间中,同时尽可能保留数据的特征。

```python

from sklearn.cluster import KMeans

from sklearn.decomposition import PCA

# 示例代码:使用K-means聚类

data = [[...]] # 假设data是需要进行聚类的特征数据

kmeans = KMeans(n_clusters=3) # 假设我们要将数据分成3个簇

kmeans.fit(data)

labels = kmeans.predict(data)

# 示例代码:使用PCA进行降维

pca = PCA(n_components=2) # 假设我们要将数据降到2维

reduced_data = pca.fit_transform(data)

```

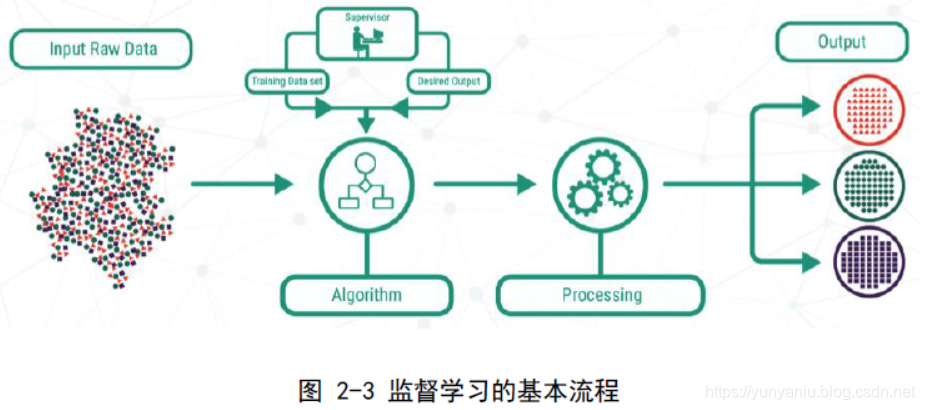

#### 2.1.2 理解监督学习

监督学习是机器学习的另一个重要分支,它涉及利用标记的训练数据来训练模型,模型的目标是能够对未见过的数据做出准确的预测。在监督学习中,算法通常学习输入和输出之间的关系,以便于对新的输入实例进行预测或分类。

分类和回归是监督学习中最常见的任务。分类任务旨在预测离散的标签,而回归任务则预测连续的值。支持向量机(SVM)、随机森林、梯度提升机(GBM)和神经网络是常见的监督学习算法。

```python

from sklearn.ensemble import RandomForestClassifier

# 示例代码:使用随机森林进行分类

data = [[...]] # 假设data是特征数据,target是对应的标签

target = [...] # 对应的分类标签

rfc = RandomForestClassifier(n_estimators=100)

rfc.fit(data, target)

# 使用模型进行预测

predictions = rfc.predict(some_new_data)

```

#### 2.1.3 融合机制与理论框架

半监督学习的核心在于将无监督学习和监督学习的优势结合起来,以解决数据标记成本高昂的问题。在这种学习模式下,无监督学习被用来发现数据的内在结构,同时监督学习被用于利用有限的标记数据来训练预测模型。

一个典型的融合机制是利用无监督学习对数据空间进行划分,然后在这些划分的基础上应用监督学习算法。例如,可以首先通过聚类算法将数据分成多个簇,然后在每个簇上使用监督学习算法,用少量的标签数据训练分类器。

### 2.2 标注数据的稀缺性问题

#### 2.2.1 标注数据的重要性

标注数据在监督学习中起到决定性作用,因为模型是通过这些数据来学习输入和输出之间的映射关系。准确的标注可以提高模型的预测精度,减少模型的泛化误差。然而,获取高质量的标注数据通常需要大量的时间和成本,特别是在专业领域或需要专业知识的任务中。

标注数据的质量直接影响到模型的性能,因此确保数据的准确性和一致性是监督学习中的一个关键步骤。此外,标注数据量的多少也会影响到模型的学习能力,特别是在数据集较小时,模型可能出现过拟合现象。

#### 2.2.2 数据稀缺性的影响

数据稀缺性导致的主要问题在于,当可用于训练的数据量有限时,模型可能无法充分捕捉到数据的多样性和复杂性,从而影响其泛化能力。当模型在训练集上表现良好,但在测试集上表现不佳时,就发生了过拟合。过拟合表明模型对于训练数据的特定噪声也进行了学习,而无法推广到未见过的数据。

在数据稀缺的情况下,通常需要考虑采用正则化技术、集成学习方法、或者使用半监督学习等策略来缓解过拟合,提升模型的泛化能力。

#### 2.2.3 数据增强技术的应对策略

数据增强技术是处理标注数据稀缺问题的一种有效策略。通过数据增强,可以在不显著改变原始数据含义的前提下,人为地增加数据集的大小和多样性。对于图像数据,数据增强包括旋转、缩放、裁剪、颜色变换等。对于文本数据,可以通过同义词替换、回译等方式进行数据增强。

```python

from imgaug import augmenters as iaa

# 示例代码:使用imgaug库进行图像数据增强

seq = iaa.Sequential([

iaa.Fliplr(0.5), # 水平翻转概率为0.5

iaa.GaussianBlur(sigma=(0, 0.5)), # 高斯模糊,sigma为0到0.5之间的随机值

])

images_augmented = seq.augment_images(original_images) # original_images是原始图像数据

```

数据增强技术能够在一定程度上缓解因数据稀缺性造成的过拟合问题,使得模型能够更好地泛化到未见过的数据上。然而,数据增强技术也有其局限性,它可能会引入不合理的数据变化,从而导致学习到错误的模式。

### 2.3 半监督学习的算法原理

#### 2.3.1 自训练与协同训练方法

自训练是一种迭代的半监督学习方法,其中模型首先使用有限的标记数据进行训练,然后使用该模型对未标记数据进行预测,并将预测置信度最高的那些未标记数据及其预测标签加入到训练集中。这个过程会不断迭代,直到满足某个停止条件。

协同训练是一种基于多个视角或特征集的半监督学习方法,其中每个视角训练一个分类器,这些分类器分别对未标记数据进行预测,并相互提供额外的标签信息。它通常要求数据能够根据不同的特征集被分成多个视图,并且每个视图能独立地学习到有效的分类器。

#### 2.3.2 图模型与图卷积网络

图模型是一种表示数据关系的强有力工具,其中节点代表数据实例,边表示数据实例之间的关系。在半监督学习中,图模型可以用来表示数据点之间的相似性,从而利用未标记数据来传播标签信息。

图卷积网络(GCN)是基于图模型的一种深度学习框架,它能够直接在图结构上进行卷积操作。GCN通过图卷积层来聚合节点的邻居信息,并更新节点的特征表示,使得节点的表示能够集成其邻居的信息,这对于处理半监督学习任务非常有效。

```python

import torch

import torch.nn.functional as F

from torch_geometric.nn import GCNConv

# 示例代码:使用PyTorch和PyTorch Geometric定义图卷积网络

class GCN(torch.nn.Module):

def __init__(self):

super(GCN, self).__init__()

self.conv1 = GCNConv(in_channels, 16)

self.conv2 = GCNConv(16, num_classes)

def forward(self, data):

x, edge_index = data.x, data.edge_index

x = self.conv1(x, edge_index)

x = F.relu(x)

x = F.dropout(x, training=self.training)

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)

# 假设data是包含特征、边索引和标签的图数据

model = GCN()

model.train()

out = model(data)

```

#### 2.3.3 伪标签技术与熵最小化

伪标签技术是一种半监督学习中常用的启发式方法,它利用模型对未标记数据进行预测,并给预测置信度高的未标记数据赋予标签,这些标签随后被用作训练数据。在多次迭代后,这种方法通常能够提高模型的性能。

熵最小化是一种准则,用于指导半监督学习算法的选择标签。该方法通过最小化模型对未标记数据的预测输出的熵,鼓励模型给出更加确定的预测。当模型对某个未标记数据的预测结果具有较低的不确定性时,意味着模型对该数据的了解较为清晰,因此可认为其预测是可靠的。

在实践中,熵最小化通常和伪标签技术相结合使用,形成一个交互的过程,逐步提升模型的性能。

在这一章节中,我们从理论上探讨了半监督学习的核心机制和算法,为下一章中深入讨论如何实际构建半监督学习模型打下了基础。

# 3. 构建半监督学习模型的实践步骤

## 3.1 数据预处理与特征工程

### 3.1.1 数据清洗与规范化

在半监督学习模型构建的初期,数据预处理尤为重要。首先,我们需要进行数据清洗,去除无效或错误的数据记录,如重复、缺失值或异常值。这些数据问题若不处理,将严重影响模型训练的效率和准确性。数据规范化是将数据统一到一个合理的尺度上,常用的方法包括归一化和标准化,以消除不同特征之间的尺度差异,使模型训练更加稳定和高效。

以下是Python代码示例,展示了如何使用`pandas`库进行数据清洗:

```python

import pandas as pd

# 加载数据

df = pd.read_csv('data.csv')

# 检查缺失值

missing_values = df.isnull().sum()

# 删除含有缺失值的行

df_clean = df.dropna()

# 数据归一化

from sklearn.preprocessing import MinMaxScaler

scaler = MinMaxScaler()

df_normalized = pd.DataFrame(scaler.fit_transform(df_clean), columns=df_clean.columns)

```

在这段代码中,我们首先导入`pandas`库,用于数据处理。然后使用`read_csv`函数加载数据集,并通过`isnull()`方法检查数据中的缺失值。接着,使用`dropna()`方法删除含有缺失值的行。最后,使用`sklearn.preprocessing`中的`MinMaxScaler`进行归一化处理。

### 3.1.2 特征选择与降维技术

特征选择和降维技术对于提高模型性能和降低计算成本至关重要。选择与问题高度相关的特征可以减少噪声和冗余,提升模型的泛化能力。常用的方法包括基于过滤的方法(例如卡方检验、互信息法)、基于包装的方法(例如递归特征消除)和基于模型的方法(例如使用决策树的特征重要性)。

以下是一段使用主成分分析(PCA)进行降维的Python代码:

```python

from sklearn.decomposition import PCA

import numpy as np

# 假设X已经是一个预处理过的特征矩阵

X_pca = PCA(n_components=0.95).fit_transform(X)

# 解释的方差比例

explained_variance = PCA(n_components=0.95).explained_variance_ratio_

```

在这段代码中,我们使用`PCA`函数来减少特征的数量,参数`n_components`设置为0.95,意味着我们保留了95%的方差信息。然后,我们用`explained_variance_ratio_`属性查看保留了多少信息。

## 3.2 算法实现与调优

### 3.2.1 算法选择与框架搭建

选择合适的算法对于半监督学习模型的成功至关重要。半监督学习领域常用算法包括自训练(Self-Training)、协同训练(Co-Training)、图模型(如标签传播算法Label Propagation)和图卷积网络(Graph Convolutional Networks)。每种算法都有其适用场景,因此需要根据实际问题来选择。

搭建算法框架时,推荐使用`scikit-learn`这样的机器学习库,因为它提供了丰富的算法和易于使用的接口。下面是一个使用`scikit-learn`框架搭建自训练算法的示例:

```python

from sklearn.semi_supervised import LabelSpreading

# 假设X_train_unlabeled为未标注数据特征矩阵,y_train为有标签数据标签

label_spread = LabelSpreading(kernel='knn')

label_spread.fit(X_train_unlabeled, y_train)

```

### 3.2.2 超参数调优与交叉验证

超参数是机器学习模型外部的参数,通常不会在模型训练过程中自动调整,但对模型性能影响巨大。为了获得最优性能,需要进行超参数调优。常用的方法包括网格搜索(Grid Search)、随机搜索(Random Search)和贝叶斯优化(Bayesian Optimization)。

交叉验证是一种评估模型泛化能力的方法。常见的交叉验证类型包括K折交叉验证,它将数据集分成K个小组,轮流将其中1个小组作为验证集,其余K-1个小组作为训练集,进行K次模型训练与验证,最后取平均效果作为评估指标。

下面使用`GridSearchCV`进行超参数调优的代码:

```python

from sklearn.model_selection import GridSearchCV

# 假设使用随机森林作为基础模型

rf = RandomForestClassifier()

# 设置超参数网格

param_grid = {'n_estimators': [10, 50, 100], 'max_depth': [None, 10, 20, 30]}

# 使用网格搜索配合交叉验证

grid_search = GridSearchCV(estimator=rf, param_grid=param_grid, cv=5)

grid_search.fit(X_train_unlabeled, y_train)

# 输出最佳参数

print(f"Best parameters: {grid_search.best_params_}")

```

## 3.3 模型评估与验证

### 3.3.1 度量标准与评价指标

模型评估和验证是半监督学习流程中不可或缺的一步,正确的评估指标能帮助我们理解模型的优劣。对于分类问题,常用的评价指标包括准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1分数(F1 Score)和ROC-AUC(Area Under the Receiver Operating Characteristic Curve)。选择合适的评估指标对模型的评价至关重要,特别是当数据集不平衡时,我们需要侧重考虑如F1分数这样能够综合反映模型性能的指标。

以下是一个使用`scikit-learn`计算多种评价指标的示例:

```python

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, roc_auc_score

# 预测结果

y_pred = model.predict(X_test)

# 计算各种指标

accuracy = accuracy_score(y_test, y_pred)

precision = precision_score(y_test, y_pred, average='macro')

recall = recall_score(y_test, y_pred, average='macro')

f1 = f1_score(y_test, y_pred, average='macro')

roc_auc = roc_auc_score(y_test, y_pred)

# 输出结果

print(f"Accuracy: {accuracy}")

print(f"Precision: {precision}")

print(f"Recall: {recall}")

print(f"F1 Score: {f1}")

print(f"ROC-AUC: {roc_auc}")

```

### 3.3.2 模型泛化能力的测试

模型泛化能力测试是指检查模型在未知数据上的性能。交叉验证是测试泛化能力的一个常用方法。另一个常用的方法是使用独立的测试集进行测试。测试集应该从未参与模型训练和调优的过程中,以确保评估结果的公正性。

为了验证模型的泛化能力,可以将数据集分为训练集和测试集:

```python

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

```

以上代码通过`train_test_split`函数将数据集分为训练集和测试集。`test_size`参数指定了测试集的大小,而`random_state`确保了每次分割的可复现性。之后,可以在训练集上训练模型,并在测试集上进行验证。

总结,构建半监督学习模型的实践步骤包括了数据预处理、特征工程、算法实现和调优、模型评估和验证等关键环节。通过这些步骤,可以搭建起一个既稳定又高效的学习模型,用以处理标注数据稀缺的复杂问题。

# 4. 应对半监督学习中的挑战

## 4.1 对抗标注噪声

### 标注噪声的影响分析

在半监督学习中,标注噪声指的是错误的或不一致的标签,这些噪声会误导模型学习错误的模式,进而影响模型的性能。这种噪声可能来源于数据集本身的错误,或者是在数据收集和标注过程中的不准确性。例如,在图像识别任务中,一个本应被标注为“猫”的图片被错误地标记为“狗”,这样的错误会使得模型难以正确区分猫和狗。

为了减少标注噪声的负面影响,研究人员和工程师需要开发和采用特定的算法来识别和校正这些错误。这通常涉及到构建噪声鲁棒性学习方法,如使用对抗训练(adversarial training)、噪声标签模型(noise label model)以及基于集成的学习方法来增强模型对噪声的鲁棒性。

### 噪声鲁棒性学习方法

噪声鲁棒性学习方法旨在增强半监督学习模型对标注错误的容忍度。下面介绍两种噪声鲁棒性学习方法:

#### 对抗训练

对抗训练是一种强化模型鲁棒性的方法,通过对训练样本添加对抗扰动来模拟噪声。这种方法迫使模型学习到更加健壮的特征表示,对小的扰动具有不变性。在对抗训练中,通常使用梯度下降法来不断微调模型的权重,同时生成对抗性例子来测试模型的鲁棒性。

#### 噪声标签模型

噪声标签模型是另一类处理标注噪声的方法,它允许模型在训练过程中自动学习标签的可靠性。这类模型通常引入额外的参数或变量来表示每个标注的可信度,或者通过概率建模来直接对噪声标签进行建模。通过这种方式,模型可以学习依赖于更可靠标签的数据点,同时减少对噪声标签的依赖。

### 代码示例与逻辑分析

以下是一个简单的对抗训练的代码示例,用于演示如何在神经网络模型中集成对抗噪声。这个例子使用了PyTorch框架:

```python

import torch

import torch.nn as nn

import torch.optim as optim

class AdversarialNoise(nn.Module):

def __init__(self, model):

super(AdversarialNoise, self).__init__()

self.model = model

# 添加对标签进行扰动的层

self.adversarial_layer = nn.Linear(model.classifier.in_features, model.classifier.out_features)

def forward(self, inputs, labels):

# 计算原始输出

output = self.model(inputs)

# 添加对抗扰动

noise = torch.normal(0, 0.1, (labels.size(0), labels.size(1)))

labels += noise

labels = labels.clamp(0, 1) # 防止梯度爆炸

# 对扰动后的标签进行分类

adversarial_output = self.model.classifier(labels)

return output, adversarial_output

# 假设已经有一个训练好的模型

model = AdversarialNoise(pretrained_model)

# 定义优化器和损失函数

optimizer = optim.Adam(model.parameters())

criterion = nn.CrossEntropyLoss()

# 训练过程(简化伪代码)

for inputs, labels in training_data_loader:

optimizer.zero_grad()

output, adversarial_output = model(inputs, labels)

loss = criterion(output, labels) + criterion(adversarial_output, labels)

loss.backward()

optimizer.step()

```

在上述代码中,我们首先定义了一个名为`AdversarialNoise`的模块,它继承自`nn.Module`。在这个模块中,我们为模型添加了一个特殊的层`adversarial_layer`,用于在前向传播过程中添加对抗扰动。在训练循环中,我们通过为真实标签添加随机噪声来创建对抗标签,并计算模型在这些对抗标签上的输出,同时计算原始标签上的输出。最后,我们通过两个损失函数的组合来优化模型参数。

## 4.2 处理类别不平衡问题

### 类别不平衡的挑战

在半监督学习中,类别不平衡是一个常见的问题,尤其是在涉及异常检测或罕见事件预测的应用中更为普遍。类别不平衡指的是数据集中各个类别的样本数相差悬殊,这种不平衡会导致模型倾向于预测多数类,从而降低少数类识别的准确性。

这种不平衡可能源于真实世界的数据分布不均,或者是因为收集和标注过程中的偏差。举个例子,在欺诈检测任务中,非欺诈案例可能会远远多于欺诈案例,如果模型没有适当的处理,它将无法有效地识别出欺诈行为。

### 平衡策略与过采样技术

为了缓解类别不平衡问题,研究者们开发出了多种策略。其中,平衡策略和过采样技术是两种比较常见的方法。

#### 平衡策略

平衡策略主要是指在训练过程中调整不同类别样本的权重,以确保模型对每个类别都有相等的重视程度。这可以通过重新采样数据集,使得每个类别都有相同数量的样本,或者在计算损失时为每个类别的样本分配不同的权重来实现。例如,在损失函数中引入类别权重参数`class_weights`,可以使得模型更加关注那些较少的类别。

#### 过采样技术

过采样技术旨在增加少数类的样本数量,使其与多数类的样本数量相平衡。最简单的过采样方法是随机复制少数类的样本,但这会导致过拟合问题。为了避免这个问题,研究人员提出了更复杂的方法,如使用SMOTE(Synthetic Minority Over-sampling Technique)技术,通过在少数类的样本之间插值来合成新的样本。

### 代码示例与逻辑分析

以下是一个简单的平衡策略的代码示例,展示了如何在损失函数中实现类别权重的动态调整:

```python

class BalancedCrossEntropyLoss(nn.Module):

def __init__(self, weights=None):

super(BalancedCrossEntropyLoss, self).__init__()

self.weights = weights if weights is not None else None

def forward(self, logits, labels):

# 如果没有提供权重,则默认每个类别的权重为1

if self.weights is None:

class_weights = torch.ones(logits.shape[1])

else:

class_weights = self.weights

# 计算加权的交叉熵损失

loss = nn.CrossEntropyLoss(weight=class_weights)(logits, labels)

return loss

# 假设有一个类别权重的列表

class_weights = [1.0, 3.0] # 假设类别0的权重为1,类别1的权重为3

# 实例化损失函数

loss_function = BalancedCrossEntropyLoss(weights=class_weights)

# 假设logits和labels是模型输出和真实标签

# logits = ...

# labels = ...

# 计算损失

loss = loss_function(logits, labels)

```

在这段代码中,我们定义了一个名为`BalancedCrossEntropyLoss`的损失函数类,它继承自`nn.Module`。在这个类中,我们可以在初始化时传入类别权重列表`weights`,并在`forward`方法中根据这些权重计算加权的交叉熵损失。如果未提供权重,则默认每个类别的权重为1,意味着没有平衡策略。使用这个损失函数可以有效地调整模型在训练过程中的类别不平衡问题。

## 4.3 提高模型的可解释性

### 解释性AI的重要性

随着机器学习模型变得越来越复杂,其内部决策过程也变得越来越难以理解。在半监督学习中,模型往往需要处理更大量的数据和更复杂的特征,这就对模型的可解释性提出了更高的要求。解释性AI(Explainable AI, XAI)旨在解决这个问题,它使得模型的预测和决策过程能够被人类理解。这对于提高用户信任、确保公平性、透明性和可审计性至关重要。

### 可解释性方法与工具

为了提高模型的可解释性,研究人员开发了一系列方法和工具。这些方法通常分为模型特定的方法和模型无关的方法。

#### 模型特定的方法

模型特定的方法通常设计用于可解释的模型,如决策树或线性模型。这类方法通过可视化决策过程或提供特征重要性的度量来帮助理解模型的行为。例如,在决策树中,可以通过可视化树结构来跟踪从根到叶的决策路径。

#### 模型无关的方法

模型无关的方法可以应用于任何类型的模型,包括深度学习模型。这类方法包括局部可解释模型-不透明模型(LIME)和特征重要性分析。LIME通过在模型的局部区域内拟合一个可解释的模型来预测原模型的行为,从而提供对模型行为的洞察。

### 代码示例与逻辑分析

以下是一个使用LIME对深度学习模型进行可解释性分析的简单示例。我们将使用`lime`库中的Python实现来解释模型在单个预测上的决策。

首先安装lime库:

```bash

pip install lime

```

然后使用LIME解释图像识别模型的代码示例:

```python

import numpy as np

import lime

import lime.lime_image

from keras.applications import vgg16

from keras.preprocessing.image import load_img, img_to_array

# 加载预训练的模型

model = vgg16.VGG16()

model.summary()

# 加载并预处理图像

img_path = 'path_to_image.jpg'

img = load_img(img_path, target_size=(224, 224))

img_array = img_to_array(img)

img_array = np.expand_dims(img_array, axis=0)

img_array = vgg16.preprocess_input(img_array)

# 使用LIME进行解释

explainer = lime.lime_image.LimeImageExplainer()

explanation = explainer.explain_instance(img_array[0].astype('double'),

model.predict,

top_labels=3,

hide_color=0,

num_samples=1000)

# 可视化第一个预测的解释结果

temp, mask = explanation.get_image_and_mask(explanation.top_labels[0],

positive_only=False,

num_features=10,

hide_rest=False)

img_boundry = np.min(explanation.get_image_and_mask(explanation.top_labels[0],

positive_only=False,

num_features=10,

hide_rest=False,

only_bounding_box=True))

# 显示图像和解释覆盖

import matplotlib.pyplot as plt

from skimage.segmentation import mark_boundaries

plt.imshow(mark_boundaries(temp / 2 + 0.5, mask))

plt.show()

```

在这个示例中,我们首先加载了一个预训练的VGG16模型,并对我们要分析的图像进行加载和预处理。随后,我们实例化了LIME解释器,并使用`explain_instance`方法来解释模型对特定图像的预测结果。最后,我们可视化了LIME的解释结果,并通过`mark_boundaries`将解释覆盖的区域标记在原始图像上。这个可视化可以让我们看到哪些图像区域对模型预测的贡献最大,进而增加了对模型行为的理解。

通过上述代码和逻辑分析,我们可以看到LIME在提高深度学习模型可解释性方面的应用。这样的工具对于调试复杂模型、提高用户对模型的信任以及遵守相关法规(比如GDPR中的“解释权”条款)是非常重要的。

# 5. 半监督学习模型的进阶应用案例

半监督学习不仅在理论上具有吸引力,在实际应用中也能发挥巨大的作用。本章节将探讨半监督学习模型在三个主要领域中的应用案例,分别是语音识别系统、图像分类与识别任务和自然语言处理。通过具体案例分析,我们会看到半监督学习如何克服实际问题,并在应用中提升模型的性能。

## 5.1 语音识别系统中的应用

### 5.1.1 语音识别背景与需求

语音识别技术是将人类的语音信号转化为机器可读的文本数据。由于人类语言的复杂性,如口音、语速、音调等的多样性,导致语音识别系统需要处理的数据量巨大且复杂。传统的监督学习方法在标注成本和泛化能力上面临挑战,而半监督学习由于其对标注数据的需求较低,成为了解决这一问题的一个有效途径。

### 5.1.2 半监督学习在语音识别中的作用

在语音识别系统中,半监督学习可以辅助系统在有限的标注数据上学习更多的语音模式。一个典型的例子是,半监督学习可以结合大量未标注的语音数据和少量标注数据,使用自训练或协同训练的方法来提高识别的准确度和鲁棒性。

```python

# 示例:半监督学习在语音识别中的伪代码

def semi_supervised_speech_recognition(unlabeled_data, labeled_data, model):

# 初始化模型参数

model.initialize_parameters()

# 部分标注数据用于训练

model.train(labeled_data)

# 利用当前模型标注未标注数据

pseudo_labels = model.predict(unlabeled_data)

# 将伪标签数据和少量标注数据结合用于进一步训练

combined_data = merge_data(labeled_data, pseudo_labels)

model.train(combined_data)

# 最终模型应用于语音识别

return model.predict(test_data)

# 使用示例

# 假设已经准备好未标注数据和少量标注数据

# 假设已经有训练好的半监督学习模型

labeled_speech = load_data('labeled_speech.wav')

unlabeled_speech = load_data('unlabeled_speech.wav')

model = load_model('semi_supervised_model')

recognized_text = semi_supervised_speech_recognition(unlabeled_speech, labeled_speech, model)

print(recognized_text)

```

## 5.2 图像分类与识别任务

### 5.2.1 半监督学习在图像处理中的挑战

图像识别和分类任务中,半监督学习面临两大挑战:大量的图像数据难以全部人工标注,以及标注数据的质量参差不齐。半监督学习通过结合少量标注数据和大量未标注数据,可以有效地扩展模型的训练集并提高模型性能。

### 5.2.2 案例分析:高效的图像分类模型

以半监督学习为理论基础,研究人员设计了高效的图像分类模型。在一些模型中,无监督学习部分用于学习数据的分布特性,而监督学习部分则专注于在标注数据上训练分类器。然后将两者结合,使用伪标签技术进一步优化分类结果。

```mermaid

graph LR

A[未标注图像数据] -->|特征学习| B(无监督学习模型)

C[标注图像数据] -->|分类训练| D(监督学习模型)

B -->|生成伪标签| E[伪标注数据]

E -->|结合| D

D -->|最终模型训练| F[高效的图像分类模型]

```

## 5.3 自然语言处理

### 5.3.1 NLP中的半监督学习应用

在自然语言处理(NLP)领域,半监督学习的应用非常广泛,包括文本分类、情感分析、机器翻译等。尤其是在处理文本数据时,标注数据相对稀缺,但大量未标注的文本数据却容易获得。半监督学习能够从这些未标注数据中提取有用信息,辅助训练过程,以达到更好的处理效果。

### 5.3.2 实际案例:情感分析与语言模型

例如,在情感分析中,半监督学习可以利用无标注的评论数据来构建情感倾向的分布模型,然后结合标注的评论来优化分类器。此外,半监督学习也用于提升语言模型的性能,通过自训练的方式,语言模型能够更好地理解未标注文本数据中的语义信息。

```python

# 示例:半监督学习在情感分析中的伪代码

def semi_supervised_sentiment_analysis(unlabeled_data, labeled_data, model):

# 初始化模型参数

model.initialize_parameters()

# 用少量标注数据训练模型

model.train(labeled_data)

# 使用训练好的模型为未标注数据生成伪标签

pseudo_labels = model.predict_and_label(unlabeled_data)

# 结合标注数据和伪标注数据进行再训练

model.retrain(pseudo_labels)

# 应用于新的文本数据进行情感分析

return model.analyze_sentiment(new_data)

# 使用示例

labeled_reviews = load_data('labeled_reviews.csv')

unlabeled_reviews = load_data('unlabeled_reviews.csv')

model = load_model('semi_supervised_model')

new_reviews = load_data('new_reviews.csv')

predicted_sentiments = semi_supervised_sentiment_analysis(unlabeled_reviews, labeled_reviews, model)

for review, sentiment in zip(new_reviews, predicted_sentiments):

print(f"Review: {review} | Sentiment: {sentiment}")

```

通过这些应用案例的分析,我们可以看到半监督学习在处理大规模、高维度和复杂的数据集时展现出来的强大能力。在未来的AI研究与实际应用中,半监督学习仍将扮演重要的角色。

0

0