半监督学习的未标注数据利用法:专家级指南

发布时间: 2024-11-19 17:53:29 阅读量: 33 订阅数: 40

高效利用无标注数据:自监督学习简述.rar

# 1. 半监督学习概述

半监督学习作为机器学习的一个重要分支,近年来受到了业界的广泛关注。它结合了监督学习和非监督学习的优势,主要应用于标注数据稀缺而未标注数据丰富的场景。本章将从半监督学习的概念和重要性入手,为读者提供一个全面的入门指南。

## 1.1 半监督学习的定义和重要性

半监督学习是一种介于监督学习和非监督学习之间的学习方式,其核心思想是在有限的标注数据中利用未标注数据来提高模型的性能。由于标注数据通常获取成本较高,如何有效利用大量的未标注数据成为了一个值得研究的课题。半监督学习的优势在于能够以较小的成本获取更好的学习效果,这对于许多实际应用领域都具有非常重要的意义。

## 1.2 半监督学习的应用领域

半监督学习在自然语言处理(NLP)、计算机视觉(CV)、语音识别等多个领域都展现出了巨大的应用潜力。通过半监督学习,可以在只有少量标注样本的情况下,训练出能够处理大规模数据的模型,从而大幅提升算法的性能。例如,在医疗图像分析中,获取大量标注数据的成本极高,半监督学习的方法可以有效地减轻标注成本,并通过模型学习识别出疾病的特征。

随着数据量的激增,尤其是在深度学习的推动下,半监督学习的方法日益成熟,未来在工业界和学术界的使用前景非常广阔。接下来的章节,我们将深入探讨半监督学习的理论基础、实践方法、评估优化策略及在实际问题中的应用。

# 2. 半监督学习的理论基础

## 2.1 半监督学习的基本概念

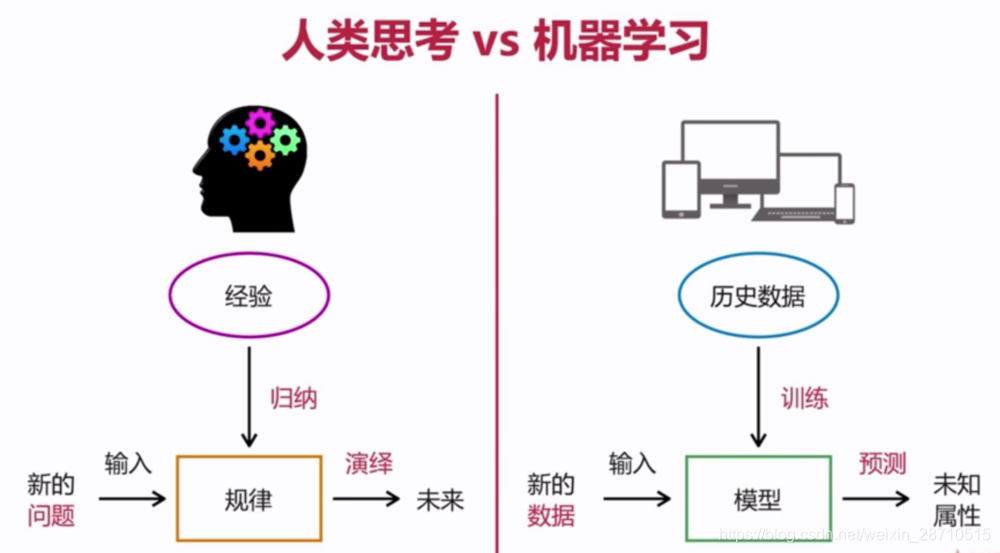

### 2.1.1 监督学习与非监督学习的对比

在深度学习和机器学习的领域中,学习过程主要被分为监督学习和非监督学习两大类,半监督学习则位于它们之间,试图利用监督学习的精度和非监督学习的灵活性来解决数据标注成本高昂的问题。

监督学习依赖于标注的数据集,这些数据集包含了输入和对应输出的标签。模型通过学习输入和输出之间的映射关系,来预测未见过数据的标签。然而,在许多现实世界的应用中,获取这样的标注数据集是昂贵的,甚至不可能实现。

非监督学习则不依赖于标注数据,它致力于发现数据本身的结构,比如聚类、降维等。非监督学习可以处理未标注的大规模数据集,但通常无法像监督学习那样提供精确的预测。

半监督学习试图结合这两种方法的优点,它利用少量的标注数据和大量的未标注数据。其核心思想是认为未标注数据中隐含着结构信息,通过挖掘这些信息,可以提高学习模型的性能。

### 2.1.2 半监督学习的假设和方法论

半监督学习的一个关键假设是“流形假设”,它认为高维数据其实位于一个低维流形上。因此,相邻的数据点在流形上应该具有相似的标签。基于这个假设,半监督学习尝试通过探索未标注数据中的局部结构来推断标签信息。

方法论上,半监督学习涵盖了多种技术,包括自训练(Self-training)、图模型(Graph-based models)、多视图学习(Multi-view learning)等。这些方法通常需要解决的问题是,如何在模型的指导下挑选最合适的未标注样本来进行标注,以及如何利用未标注数据增强模型的泛化能力。

## 2.2 半监督学习的关键理论

### 2.2.1 自训练方法

自训练方法是一种迭代的半监督学习技术,它使用已有的标注样本来训练一个基础分类器。然后,该分类器被用于对未标注数据进行预测。分类器认为那些预测置信度较高的未标注样本是可靠的,并将它们加入到训练集中。这个过程会反复进行,直到满足某些停止条件。

自训练方法的关键在于如何从大量的未标注数据中选择最可靠的样本。这需要分类器在预测时具有一定的置信度,并且能够准确地识别出那些容易被模型错误分类的样本,避免引入噪声。

```python

import numpy as np

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

# 假设 X_labeled 是已标注数据的特征,y_labeled 是对应的标签

# 假设 X_unlabeled 是未标注数据的特征

# 初始化模型

model = LogisticRegression()

# 使用已标注数据训练模型

model.fit(X_labeled, y_labeled)

# 使用模型对未标注数据进行预测,并选取置信度最高的数据

probabilities = model.predict_proba(X_unlabeled)

predictions = np.argmax(probabilities, axis=1)

confidence_scores = np.max(probabilities, axis=1)

threshold = 0.9 # 设置一个置信度阈值

selected_indices = np.where(confidence_scores >= threshold)[0]

# 假设我们有足够的资源和方式来标注这些被选中的数据

# 然后将它们加入到训练集中进行下一轮迭代

```

### 2.2.2 图模型方法

图模型方法将数据表示为图结构,其中节点代表样本,边代表样本间的相似度。图模型方法试图在这个图上找到数据分布的平滑性,即相似的节点应当有相似的标签。这种方法依赖于图论中的优化算法,例如标签传播算法(Label Propagation)。

标签传播算法的核心是迭代更新未标注节点的标签,直到达到一个稳定的标签分布。算法的关键在于如何定义节点间的关系以及如何高效地进行迭代更新。

### 2.2.3 多视图学习

多视图学习是半监督学习的一个分支,它处理的是具有多个不同特征表示的数据。例如,一个文档可以同时从内容和结构的角度来观察。多视图学习假设不同的视图包含互补的信息,通过联合建模可以提高学习效率。

多视图学习的一个核心问题是如何有效整合这些信息。通常的做法是将学习过程分解为多个步骤,每个步骤聚焦于单个视图,最终再将结果合并。这种方法可以提高模型的泛化能力,同时处理多源数据。

## 2.3 半监督学习的优势和挑战

### 2.3.1 数据利用率提升

半监督学习最大的优势之一在于它显著提高了数据利用率。在现实世界中,标注数据往往成本高昂,获取不易。而半监督学习则允许模型在有限的标注数据基础上,借助未标注数据进行学习,从而提升了整体的数据使用效率。

利用未标注数据,半监督学习可以挖掘出数据的深层结构和潜在规律,这通常是监督学习无法做到的。在实践中,合理运用半监督学习,可以在不增加标注成本的情况下提升模型性能。

### 2.3.2 模型泛化能力增强

由于半监督学习结合了标注数据的精确指导和未标注数据的丰富信息,因此通常能够训练出泛化能力更强的模型。未标注数据的多样性有助于模型捕捉到数据的真实分布,减少了过拟合的风险。

泛化能力的增强意味着模型在处理未见过的数据时,能够更加稳健和准确。这对于那些训练数据相对稀缺的应用场景尤为重要,比如生物信息学、罕见事件检测等。

### 2.3.3 实际应用中的挑战

尽管半监督学习有其优势,但在实际应用中也面临一些挑战。最直接的挑战是未标注数据的质量。如果未标注数据中包含噪声或与标注数据分布差异较大,可能会对模型的训练造成干扰。

另一个挑战是模型选择和超参数调整。半监督学习通常涉及更复杂的模型结构和参数空间,如何高效地寻找最优的模型配置是一个需要解决的问题。

在下面的章节中,我们将进一步深入探讨如何有效利用未标注数据,并通过实践展示半监督学习算法的应用。我们将重点分析在实际问题中应用半监督学习时,所面临的挑战以及优化策略。

# 3. 未标注数据的有效利用

## 3.1 未标注数据的获取和预处理

获取和预处理未标注数据是半监督学习中至关重要的一步。与标注数据相比,未标注数据往往更容易获得,并且数量庞大。但是,如何有效地从这些数据中提取有用信息,并将其转化为模型训练过程中的价值,需要一系列的策略和方法。

### 3.1.1 数据集的构建和管理

在实际应用中,构建一个数据集首先需要确定数据来源。对于未标注数据而言,我们可以从公开数据集、互联网抓取、日志文件、实时数据流等多种途径获取。获取数据后,接下来的任务是进行数据筛选、组织和管理。

数据筛选的目的是去除不相关或低质量的数据,确保数据集的质量。筛选过程中,可以使用数据清洗技术来移除无效、重复或错误的样本。数据组织则是要合理地对数据进行分组和标记,以便于后续的分析和处理。

```python

import pandas as pd

# 读取数据集

data = pd.read_csv("raw_data.csv")

# 数据筛选示例:去除缺失值大于3的行

data_clean = data.dropna(thresh=len(data.columns) - 3)

# 数据分组示例:按某一列进行分组

grouped_data = data_clean.groupby("category_column")

```

### 3.1.2 数据清洗与特征工程

数据清

0

0