伪标签技术在半监督学习中的应用:理论与实践

发布时间: 2024-11-19 17:58:48 阅读量: 33 订阅数: 40

# 1. 伪标签技术概述

在机器学习和人工智能领域,伪标签技术是一个重要的研究方向,它在半监督学习模型中扮演着桥梁角色。伪标签技术利用少量的标注数据和大量的未标注数据,通过算法为未标注数据打上“伪标签”,从而扩展训练集,提高模型性能。本章将简要介绍伪标签技术的基本原理和应用,为后续章节深入讨论打下基础。

# 2. 半监督学习的理论基础

## 2.1 半监督学习简介

### 2.1.1 半监督学习的定义和重要性

半监督学习是一种结合了有标签数据和无标签数据进行学习的方法。它在机器学习中占有重要地位,因为有标签数据的获取往往需要大量的专家知识和劳动,成本高昂,而无标签数据则相对容易获得。半监督学习的核心思想是利用无标签数据中蕴含的丰富信息来辅助有标签数据的学习过程,以此提升学习算法的性能。

半监督学习的重要性体现在以下几个方面:

1. **成本效益**:半监督学习能够减少对大量标签数据的依赖,降低标注成本。

2. **性能提升**:在某些情况下,即使无标签数据不提供任何直接的监督信息,但通过合适的算法仍然能够提高学习模型的泛化能力。

3. **数据利用率**:半监督学习充分利用了数据集中的所有可用信息,包括大量未标注的数据,这使得数据的利用率最大化。

### 2.1.2 半监督学习与监督学习、无监督学习的对比

半监督学习与监督学习、无监督学习是机器学习领域中的三大主要学习范式,它们之间存在着本质的区别和联系:

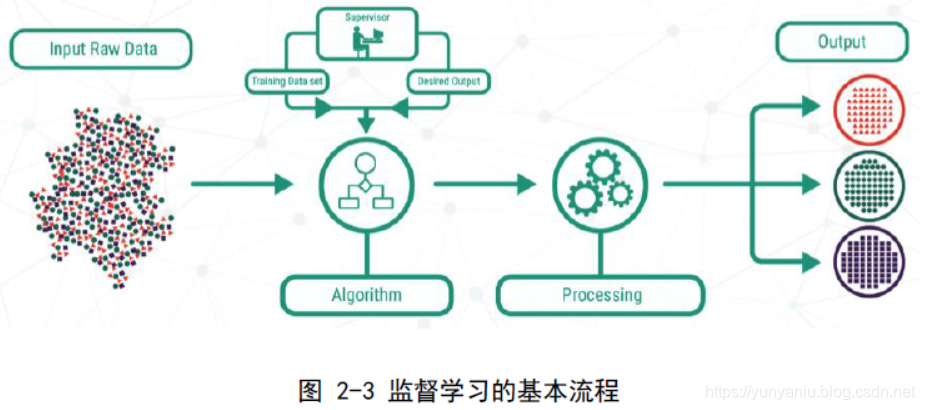

1. **监督学习**:监督学习依赖于大量的有标签数据进行训练,每一笔数据都有明确的标签,模型的目标是学习到数据和标签之间的映射关系。这种方法的效果直接受到标签质量的影响,但在数据获取上成本较大。

2. **无监督学习**:与监督学习相对,无监督学习处理的是无标签数据,其目标是发现数据中的结构或者模式。无监督学习在处理数据挖掘、聚类等问题上非常有用,但由于缺乏标签,模型的解释性和精确性通常不如监督学习。

3. **半监督学习**:结合了有标签和无标签数据,利用无标签数据的丰富性,辅助有标签数据的学习过程。半监督学习能有效地结合两种学习方式的优势,同时降低对大量标签数据的依赖。

从应用的角度来看,半监督学习在多种场景下都有潜在的应用价值。例如,在自然语言处理领域,标签数据的获取相对困难和昂贵,而无标签的文本数据却非常丰富。在这种情况下,采用半监督学习技术能够有效地提升模型的性能。

## 2.2 伪标签技术的基本概念

### 2.2.1 伪标签的生成机制

伪标签技术是一种特殊的半监督学习方法,其核心思想是在无标签数据上生成“伪标签”,然后将这些带有伪标签的数据与有标签数据一起用于训练模型。伪标签的生成通常依赖于当前的模型预测。

伪标签的生成机制包含以下几个步骤:

1. **模型训练**:使用有标签数据训练一个初步的模型。

2. **预测无标签数据**:利用训练好的模型对无标签数据进行预测,生成每个数据的类别概率分布。

3. **生成伪标签**:根据一定的阈值,将概率最高的类别作为伪标签赋予无标签数据。

伪标签的生成过程可以看作是一个“自学习”的过程,模型通过不断地利用自己的预测结果来扩展训练集,以此提高学习效率。

### 2.2.2 伪标签在半监督学习中的作用

在半监督学习框架中,伪标签的作用至关重要。伪标签可以看作是模型对无标签数据的理解和解释,使得无标签数据也参与到模型训练的过程中。伪标签的引入,将原本只能通过少量有标签数据学习的过程,转变成能够利用大量无标签数据的过程。

伪标签在半监督学习中的作用主要体现在:

1. **增强模型的泛化能力**:通过伪标签,模型能够学习到更加广泛的数据分布,从而提升模型的泛化能力。

2. **缓解标签稀缺的问题**:伪标签技术提供了一种途径,使得即使在标签数据稀缺的情况下,也能够进行有效的学习。

伪标签技术的成功应用依赖于伪标签的质量和模型的鲁棒性。如果伪标签的质量不高,错误的标签信息可能会误导模型的学习过程,导致性能下降。因此,如何提升伪标签的质量成为半监督学习领域研究的重要课题。

## 2.3 半监督学习的关键算法

### 2.3.1 自训练算法

自训练算法是一种常见的半监督学习方法,它属于伪标签技术的一种实现方式。自训练算法的基本流程如下:

1. **初始模型训练**:使用所有可用的有标签数据对初始模型进行训练。

2. **生成伪标签**:利用训练好的模型对无标签数据进行分类预测,并生成伪标签。

3. **迭代过程**:将带有伪标签的无标签数据作为训练集的一部分,并重新训练模型,然后重复生成伪标签和模型训练的过程。

自训练算法的关键在于如何确保伪标签的质量和正确性,以及如何平衡有标签数据和带有伪标签的无标签数据在模型训练中的权重。

### 2.3.2 多视图学习

多视图学习是针对具有多个视角(特征)的数据集的一种半监督学习方法。在多视图学习框架下,同一数据点在不同的视图中可能具有不同的特征表示,而每个视图可能揭示数据的不同方面。

多视图学习的算法通常采用以下步骤:

1. **视图选择和特征提取**:根据数据的特性选择合适的视图,对每个视图进行特征提取。

2. **单视图学习**:在每个视图上分别进行监督学习或半监督学习,得到各自的预测结果。

3. **结果融合**:通过某种策略将各个视图的预测结果进行融合,以得到最终的预测结果。

多视图学习通过整合不同视图提供的信息,增强模型的学习能力,尤其适用于那些从单一视角难以获得准确预测结果的任务。

### 2.3.3 半监督支持向量机

半监督支持向量机(S3VM)是支持向量机(SVM)在半监督学习领域的扩展。SVM是一种强大的监督学习方法,广泛应用于分类和回归问题。S3VM的基本思想是,在SVM的基础上,利用无标签数据来寻找最优的决策边界。

S3VM的算法流程包含:

1. **初始模型训练**:使用有标签数据训练一个基本的SVM模型。

2. **利用无标签数据**:通过SVM模型的决策函数对无标签数据进行分类,并选择一些置信度高的无标签数据点。

3. **构建新的训练集**:将选定的无标签数据点以及它们的预测标签加入到原始训练集中,构建新的训练集。

4. **重新训练模型**:使用新的训练集再次训练SVM模型,以优化决策边界。

半监督支持向量机的关键在于如何合理地选取和利用无标签数据,以辅助有标签数据提高分类性能。

通过对半监督学习理论基础的深入了解,我们可以看到半监督学习在处理大规模无标签数据时的重要作用,以及伪标签技术在其中的核心地位。在接下来的章节中,我们将深入探讨伪标签技术的实现原理,进一步理解其在半监督学习中的应用。

# 3. 伪标签技术的实现原理

## 3.1 伪标签的生成过程

### 3.1.1 确定生成伪标签的数据集

在开始伪标签生成之前,首先需要从大规模未标注数据中选择合适的数据集。选择数据集的标准包括数据的多样性、代表性以及数据的质量。通常使用聚类算法将未标注数据分组,优先选择每个簇中的核心样本作为生成伪标签的对象。

例如,在图像识别任务中,可以利用k-means聚类算法对未标注图像进行分组,然后选择每个簇中的中心点图像作为数据集。

### 3.1.2 选择合适的模型进行预测

选定数据集后,接下来需要选择一个基础模型进行预测。选择模型时,应考虑模型的泛化能力和已有的标注数据量。一般而言,深度学习模型因其强大的特征提取能力而被广泛使用。

以图像分类为例,可以使用预训练的卷积神经网络(CNN)模型,如ResNet或VGG,在有限的标注数据上进行微调,然后用它来预测选定数据集的伪标签。

### 3.1.3 伪标签的置信度评估

伪标签不是绝对可靠的,其置信度评估至关重要。评估方法包括计算模型对未标注样本预测的概率值,

0

0