【迁移学习的挑战与机遇】:跨领域差异的七大克服策略

发布时间: 2024-11-19 19:07:43 阅读量: 39 订阅数: 38

YOLOv8:迁移学习的强大实践

# 1. 迁移学习的理论基础与重要性

## 1.1 迁移学习简介

迁移学习是一种机器学习范式,它利用一个任务领域中学到的知识,来解决另一个相关但不同的领域中的问题。这种方式尤其在数据稀缺或成本高昂的任务中尤为重要,能够显著减少所需的训练样本数量,加快模型的收敛速度。

## 1.2 迁移学习的理论基础

理论基础主要涉及归纳偏差、领域自适应和多任务学习。归纳偏差确保了模型不会过拟合于训练数据;领域自适应解决了源域和目标域之间存在的分布差异问题;多任务学习则允许模型在一个统一的框架下学习多个相关任务,共享知识和特征表示。

## 1.3 迁移学习的重要性

在现实世界的应用中,数据的获取往往成本高、耗时长,迁移学习通过利用现有的丰富数据源,提高了学习效率,缩短了开发周期。对于那些数据不足的领域,如医疗影像分析、自然语言处理等,迁移学习能够有效提升模型的性能和泛化能力,因而具有极高的实用价值和研究意义。

# 2. 领域适应性的核心问题

## 2.1 数据分布差异的分析

### 2.1.1 概念与度量方法

领域适应性关注的核心问题是不同领域间数据分布的差异性。这些差异可能来源于数据采集环境、设备、时间等多种因素。为了量化和分析这些差异,通常会采用一些度量方法。

**JS散度(Jensen-Shannon Divergence)**是一种常用的数据分布相似度度量方法,它是KL散度(Kullback–Leibler Divergence)的对称版本。JS散度度量了两个概率分布之间的相似性,其值越小表示分布越相似。

代码展示如何使用Python计算JS散度:

```python

import numpy as np

from scipy.stats import entropy

def js_divergence(P, Q):

"""计算JS散度"""

M = 0.5 * (P + Q)

return 0.5 * (entropy(P, M) + entropy(Q, M))

P = np.array([0.2, 0.3, 0.5])

Q = np.array([0.1, 0.4, 0.5])

print("JS散度:", js_divergence(P, Q))

```

以上代码块首先导入了numpy和scipy.stats模块,然后定义了一个计算JS散度的函数。该函数计算两个概率分布P和Q的JS散度,返回结果输出。在实际应用中,P和Q往往是由数据样本的概率估计得到。

**最大均值差异(Maximum Mean Discrepancy, MMD)**是另一种有效的度量方法,它基于再生核希尔伯特空间(RKHS)理论,能够捕捉数据分布之间的非线性特征。MMD越小,表示两个分布越相似。

### 2.1.2 影响因素与案例解析

领域适应性的挑战之一是识别并理解造成数据分布差异的根本原因。在机器学习中,这些差异可能会影响模型的泛化能力,导致性能下降。为了更好地理解这些差异,研究者们通常会从以下因素入手进行分析:

- **传感器差异**:不同传感器采集的数据具有不同的噪声和特征分布。

- **时间跨度**:随着时间推移,数据分布可能发生变化。

- **环境变化**:例如,室内与室外环境,或者不同地理位置的数据。

案例解析可以帮助我们更具体地理解数据分布差异的影响。例如,考虑一个图像识别的应用场景,其中一个领域是野外拍摄的照片集,另一个领域是用不同相机在室内拍摄的照片集。由于光照条件、背景噪声等因素的不同,两个领域的数据分布会有显著的差异。在没有适当的领域适应策略下,从野外领域学习得到的模型在室内领域中的表现可能会大打折扣。

## 2.2 模型泛化能力的挑战

### 2.2.1 泛化能力的定义与重要性

泛化能力是指模型对未见过数据的预测能力。在迁移学习中,泛化能力尤其重要,因为模型需要在新的领域中工作,而该领域的数据可能与训练数据的分布不同。

**模型的泛化误差**通常由两部分组成:偏差(bias)和方差(variance)。偏差反映了模型对训练数据的拟合程度,而方差则体现了模型在不同数据子集上的表现差异。一个具有高泛化能力的模型应该同时具有低偏差和低方差。

泛化能力的重要性体现在以下几个方面:

- **稳定性**:一个具有高泛化能力的模型在面对数据变化时更加稳健。

- **适应性**:能够快速适应新的数据分布。

- **可靠性**:在实际应用中,模型能够给出可靠的预测。

### 2.2.2 泛化能力的提升策略

为了提升模型的泛化能力,研究者和工程师通常会采取以下策略:

- **数据增强(Data Augmentation)**:通过对训练数据进行各种变换来增加其多样性,从而减少过拟合。

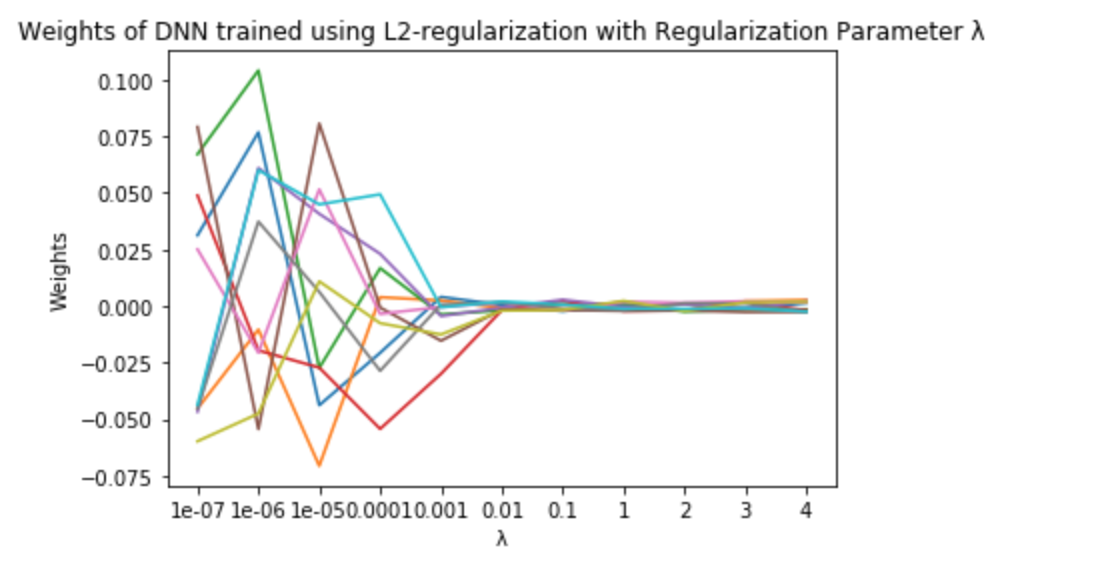

- **正则化(Regularization)**:包括L1和L2正则化等方法,通过惩罚复杂模型来控制过拟合。

- **集成学习(Ensemble Learning)**:结合多个模型的预测结果来减少方差。

- **交叉验证(Cross Validation)**:一种评估泛化能力的技术,通过分割数据集进行多次模型训练和测试。

以**数据增强**为例,可以通过旋转、缩放、裁剪或添加噪声等方式来生成新的训练样本。这些技术可以在不显著增加数据收集成本的情况下,显著提高模型的泛化能力。

## 2.3 迁移学习中的选择性迁移

### 2.3.1 选择性迁移的概念

在迁移学习中,并非所有的特征或知识都是有价值的或应当被迁移的。选择性迁移是指有选择性地迁移与目标任务相关的特征或参数,而忽视那些不相关或有噪声的部分。这种方法特别适用于源领域和目标领域存在较大差异的情况。

选择性迁移的关键是找出哪些部分对目标任务有正向贡献,哪些可能会干扰模型的学习。这可以通过特征选择算法、注意力机制等技术实现。

### 2.3.2 如何实现选择性迁移

实现选择性迁移的一种常见方法是**基于注意力的迁移**。在这种方法中,通过引入注意力机制,模型可以学习到哪些特征是重要的,从而在迁移过程中给予这些特征更多的关注。

具体操作上,可以使用一个注意力网络对源领域的特征进行加权,然后将加权后的特征迁移到目标领域。通过训练注意力网络,模型能够识别出与目标任务相关的特征,并放大这些特征的重要性。

代码示例:

```python

import torch

import torch.nn as nn

class AttentionModule(nn.Module):

def __init__(self):

super(AttentionModule, self).__init__()

self.attention = nn.Sequential(

nn.Linear(in_features, hidden_features),

nn.ReLU(),

nn.Linear(hidden_features, out_features),

nn.Softmax(dim=-1) # 对输出进行Softmax操作,获取注意力权重

)

def forward(self, x):

# x为源领域的特征输入

return x * self.attention(x)

in_features = 512

hidden_features = 256

out_features = 512

attention_module = AttentionModule()

source_features = torch.randn(10, in_features) # 模拟的源领域特征

attention_weighted_features = attention_module(source_features)

```

在这个代码块中,我们首先定义了一个名为`AttentionModule`的注意力模块,它由全连接层和ReLU激活函数组成。注意力权重通过Softmax函数计算得到,确保了权重总和为1。接着,我们通过一个模拟的输入张量`source_features`展示了如何使用这个模块进行前向传播。注意力模块通过学习输入特征的重要性,输出了加权后的特征张量`attention_weighted_features`。这一步骤展示了如何在迁移学习中应用注意力机制来实现选择性迁移。

# 3. 克服跨领域差异的策略

## 3.1 基于领域自适应的方法

### 3.1.1 领域自适应的基本原理

领域自适应(Domain Adaptation, DA)是迁移学习中的一种关键技术,目的是在源领域和目标领域存在差异时,通过某种方式将源领域的知识迁移到目标领域,以减少领域间差异对模型泛化能力的影响。其基本原理是假设源领域和目标领域在某种隐含特征空间中存在相似性,而迁移学习的目标就是找到这种相似性并加以利用。

领域自适应通常分为以下几种类型:

- **无监督领域自适应(Unsupervised Domain Adaptation, UDA)**:源领域有标记数据而目标领域没有或很少标记数据。例如,在图像识别任务中,有一个大规模标注好的源领域数据集(如ImageNet),而目标领域的数据集标注成本很高,需要未标注数据。

- **半监督领域自适应(Semi-supervised Domain Adaptation)**:

0

0