视觉SLAM算法进展:在AR、地图与导航中的应用探索

PDF格式 | 2.03MB |

更新于2025-01-16

| 23 浏览量 | 举报

"视觉SLAM算法及其在AR、地图、定位和寻路中的应用☆

视觉SLAM(Simultaneous Localization and Mapping,即同时定位与地图构建)算法是计算机视觉领域的一个关键技术,它利用摄像头捕获的图像数据来估计设备在未知环境中的位置,并重建周围环境的结构。在增强现实(AR)中,vSLAM扮演着至关重要的角色,通过精确的定位和环境映射,将虚拟元素无缝融合到真实世界中,为用户创造沉浸式的互动体验。

传统的SLAM系统常常依赖于GPS或激光雷达(LIDAR)等传感器,但视觉SLAM的优势在于相机的广泛可用性、成本效益以及丰富的环境信息获取能力。例如,颜色、纹理和外观等信息对于环境理解和场景重建至关重要。随着技术的发展,视觉SLAM已经应用于各种设备,包括人形机器人、无人机、自动驾驶汽车、月球车、水下机器人以及医疗设备如内窥镜。

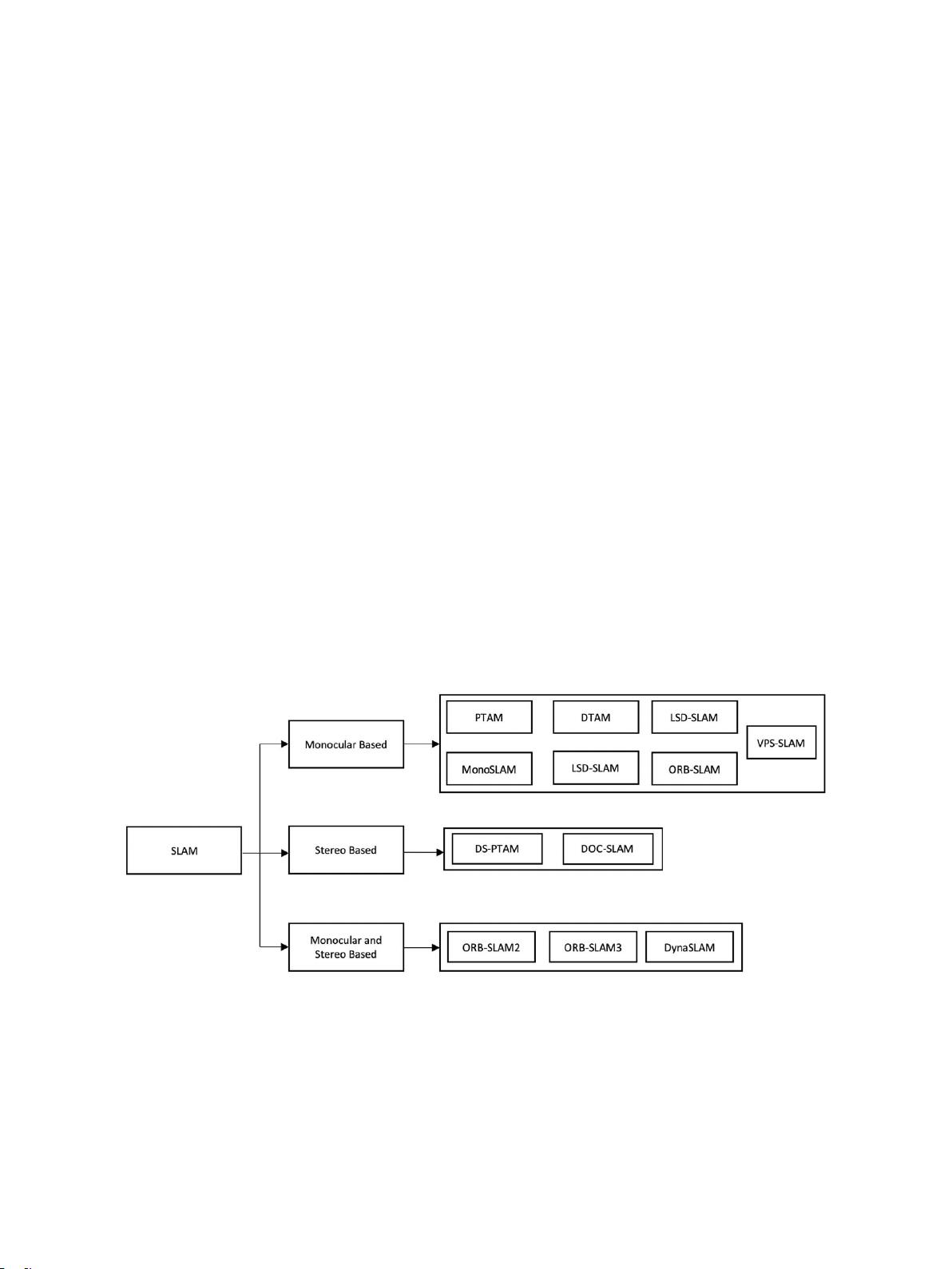

视觉SLAM主要分为三类:单目、立体和RGB-D。单目SLAM仅依赖单个摄像头,而立体SLAM利用两台或更多摄像头来实现三维空间的定位。RGB-D SLAM则结合了彩色图像和深度信息,提供更为准确的三维重建。经典的vSLAM算法包括MonoSLAM、PTAM、PTAM-Dense、DTAM和ORB-SLAM等,但它们大多针对静态环境设计,对动态环境的适应性仍有待提高。

动态环境中的移动物体对SLAM系统的性能构成挑战,因为它们可能导致跟踪错误和定位不准。因此,研究者们一直在努力改进SLAM算法,使其能更好地处理动态场景中的运动物体。这涉及到目标检测、运动分割、建图策略等复杂问题的解决,以确保系统鲁棒性和精度。

在AR应用中,vSLAM不仅用于定位和映射,还涉及环境理解,例如识别地标、追踪用户视线和手势,以及在实时交互中保持虚拟对象的稳定。在地图制作中,SLAM可以创建高精度的室内地图,这对于导航和寻路系统至关重要,特别是在GPS信号无法覆盖的地方,如大型建筑物内部或地下区域。

近年来,随着深度学习技术的发展,视觉SLAM也逐渐融入了机器学习的元素,如使用神经网络进行特征提取和建图优化,以提高性能。同时,硬件的进步,如嵌入式计算平台和高性能摄像头,也为视觉SLAM的实时处理和高效运行提供了更强的支撑。

视觉SLAM算法在AR、地图、定位和寻路等领域展现出广阔的应用前景,但同时也面临着动态环境适应、计算效率和实时性等技术挑战。未来的研究将继续聚焦于这些问题的解决,以推动视觉SLAM技术的进一步发展和广泛应用。"

相关推荐

cpongm

- 粉丝: 6

最新资源

- 深入解析JavaWeb中Servlet、Jsp与JDBC技术

- 粒子滤波在视频目标跟踪中的应用与MATLAB实现

- ISTQB ISEB基础级认证考试BH0-010题库解析

- 深入探讨HTML技术在hundeakademie中的应用

- Delphi实现EXE/DLL文件PE头修改技术

- 光线追踪:探索反射与折射模型的奥秘

- 构建http接口以返回json格式,使用SpringMVC+MyBatis+Oracle

- 文件驱动程序示例:实现缓存区读写操作

- JavaScript顶盒技术开发与应用

- 掌握PLSQL: 从语法到数据库对象的全面解析

- MP4v2在iOS平台上的应用与编译指南

- 探索Chrome与Google Cardboard的WebGL基础VR实验

- Windows平台下的IOMeter性能测试工具使用指南

- 激光切割板材表面质量研究综述

- 西门子200编程电缆PPI驱动程序下载及使用指南

- Pablo的编程笔记与机器学习项目探索