PointAugment:点云分类的自动增强框架

139 浏览量

更新于2025-01-16

收藏 1.3MB PDF 举报

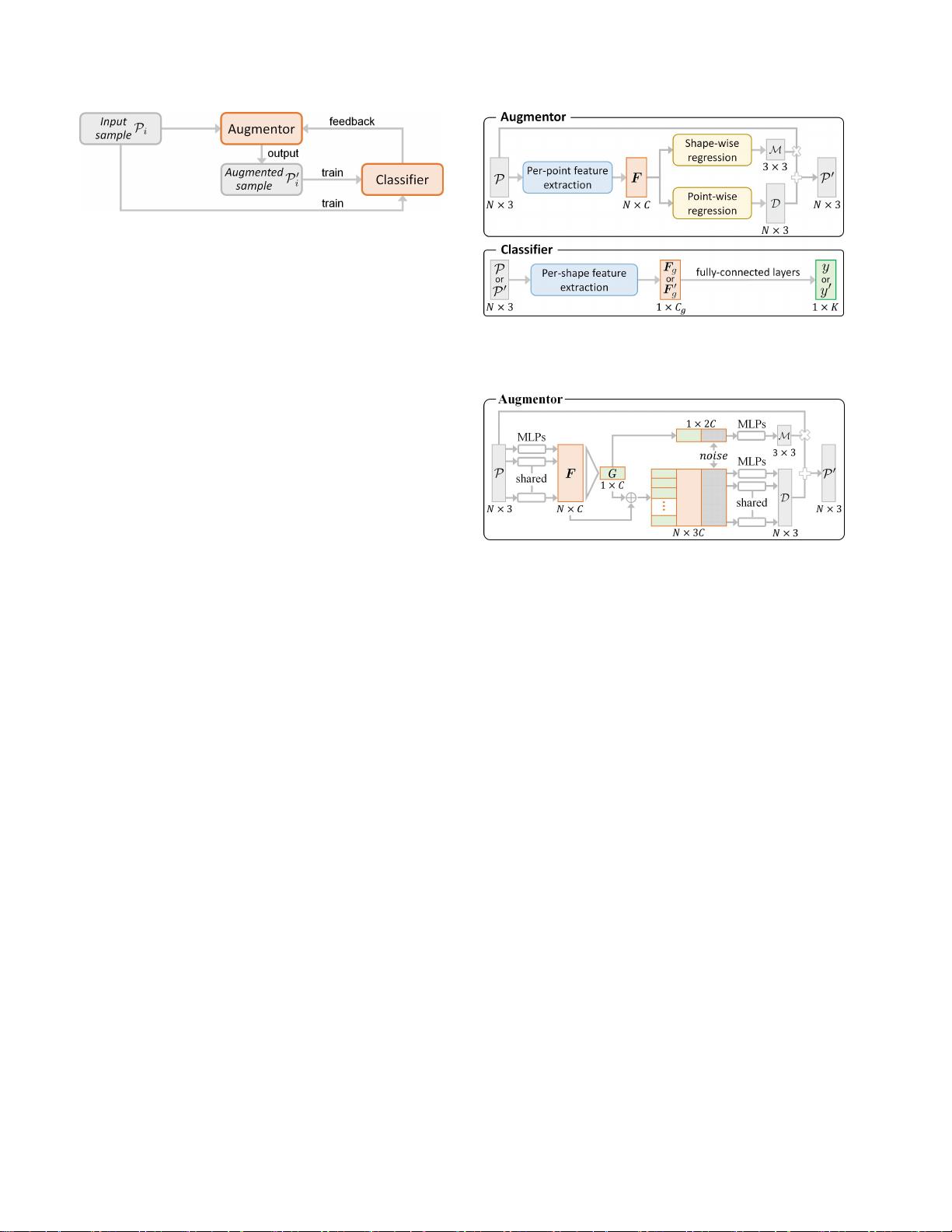

"PointAugment是一种自动增强框架,专门针对点云分类任务,旨在通过自动优化和增强训练数据,提升深度神经网络的泛化能力。该框架采用了对抗学习策略,能够根据分类网络的需求动态生成增强样本。同时,PointAugment包含了一个可学习的点增强函数,实现了形状变换和逐点位移,以增加数据多样性。通过精细设计的损失函数,PointAugment能够适应分类器的学习进度。研究表明,PointAugment在多个代表性网络上提高了点云分类的准确性,尤其是在ModelNet40等数据集上表现显著。与传统仅在预定义范围内随机扰动输入点云的增强策略相比,PointAugment能够更有效地避免过拟合,提升网络性能。"

点云分类中的自动增强方法是解决3D数据集有限数量和多样性问题的关键技术。由于3D点云数据集(如ModelNet40)相对于2D图像数据集(如ImageNet和MSCOCO)来说,样本量较小且多样性有限,这可能导致深度学习模型过拟合,降低其泛化能力。传统的数据增强方法,如随机旋转、缩放和抖动,虽然有效,但可能无法充分利用整个增强空间,并且没有考虑网络训练的反馈。

PointAugment通过引入对抗学习策略,将数据增强与网络训练过程结合起来,使得增强器能够根据分类网络的需求自适应地生成增强样本。这种方法的优势在于,它可以动态调整增强策略,以优化网络性能,避免因固定增强导致的训练不足问题。

此外,PointAugment引入了一个可学习的点增强函数,这个函数能够执行形状变换和逐点位移,从而更加灵活地改变点云结构,增加数据的多样性和复杂性。配合精心设计的损失函数,PointAugment能够更好地利用分类器的学习进度,逐步优化增强策略,进一步提升模型的泛化性能。

实验结果显示,PointAugment在多个点云分类网络上表现出色,显著提高了分类准确率,证明了该方法的有效性。通过自动增强和联合优化,PointAugment为点云分类任务提供了更强大、更适应性强的数据增强工具,有助于推动3D深度学习领域的进步。

2133 浏览量

113 浏览量

176 浏览量

2022-11-30 上传

307 浏览量

482 浏览量

379 浏览量

125 浏览量

113 浏览量

cpongm

- 粉丝: 6

最新资源

- 计算机组成原理期末试题及答案(2011参考)

- 均值漂移算法深入解析及实践应用

- 掌握npm与yarn在React和pg库中的使用

- C++开发学生信息管理系统实现多功能查询

- 深入解析SIMATIC NET OPC服务器与PLC的S7连接技术

- 离心式水泵原理与Matlab仿真教程

- 实现JS星级评论打分与滑动提示效果

- VB.NET图书馆管理系统源码及程序发布

- C#实现程序A监控与自动启动机制

- 构建简易Android拨号功能的应用开发教程

- HTML技术在在线杂志中的应用

- 网页开发中的实用树形菜单插件应用

- 高压水清洗技术在储罐维修中的关键应用

- 流量计校正方法及操作指南

- WinCE系统下SD卡磁盘性能测试工具及代码解析

- ASP.NET学生管理系统的源码与数据库教程