大规模数据集 Kinetics:推动行动识别的边界

122 浏览量

更新于2025-01-16

收藏 962KB PDF 举报

"本文探讨了行动识别技术,特别是基于新模型和大规模动力学数据集的研究。研究者们提出了一个名为I3D的双流膨胀3D卷积神经网络(ConvNet),该模型在Kinetics数据集上进行预训练后,显著提升了在HMDB-51和UCF-101这两个较小基准数据集上的动作分类性能。"

在行动识别领域,传统的数据集如UCF-101和HMDB-51由于样本量有限,往往限制了模型的性能提升。 Kinetics数据集的出现解决了这个问题,它包含400个人类动作类别,每个类别超过400个剪辑,全部来源于真实且具有挑战性的YouTube视频,为模型提供了丰富的学习素材。

作者们分析了当前的架构在Kinetics数据集上的表现,并发现尽管许多方法在现有小规模基准上表现相近,但在大规模数据集上进行预训练能够显著提升模型的泛化能力。他们提出的新模型I3D,是基于2D ConvNet的膨胀版本,将二维滤波器和池化扩展至三维,使模型能够学习到视频中的时空特征。这种设计允许I3D在保持与成功ImageNet架构设计兼容的同时,利用其参数进行训练。

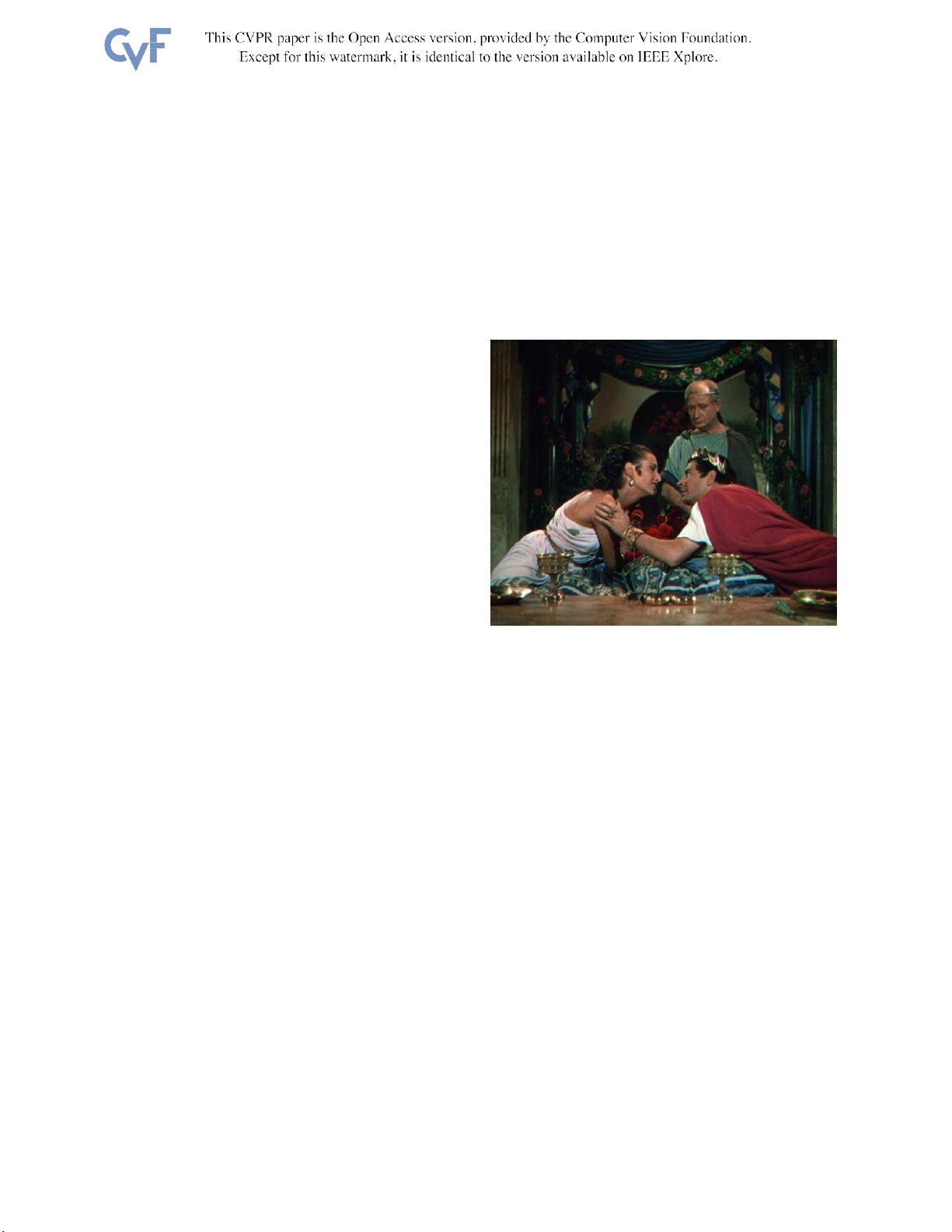

I3D模型在预训练后,在HMDB-51上达到了80.2%的准确率,UCF-101上达到了97.9%,这标志着在行动识别领域的重大进步。这个结果表明,利用像Kinetics这样的大规模数据集进行预训练,可以有效提升模型对视频理解的能力,尤其是在处理单帧图像可能模糊不清的动作时。

此外,研究还指出ImageNet挑战对深度学习的发展产生了深远影响,预训练模型的特征可以广泛应用于其他任务,如PASCAL VOC的分类和检测。随着深度架构的不断优化,如AlexNet到VGG-16的改进,也推动了相关任务性能的提升。I3D模型的成功进一步证实了这一趋势,即通过在大规模视频数据集上预训练,可以提升模型在行动识别等视频分析任务上的性能。

总结来说,本文强调了大规模数据集对于提升行动识别模型性能的重要性,并提出了一种创新的3D卷积神经网络结构,该结构在Kinetics数据集上的预训练能够显著增强模型在其他小型基准数据集上的动作分类效果。这为未来在视频理解和动作识别领域的研究提供了新的方向和可能。

2474 浏览量

点击了解资源详情

点击了解资源详情

2024-06-20 上传

167 浏览量

133 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 6

最新资源

- Verilog实现的Xilinx序列检测器设计教程

- 九度智能SEO优化软件新版发布,提升搜索引擎排名

- EssentialPIM Pro v11.0 便携修改版:全面个人信息管理与同步

- C#源代码的恶作剧外表答题器程序教程

- Weblogic集群配置与优化及常见问题解决方案

- Harvard Dataverse数据的Python Flask API教程

- DNS域名批量解析工具v1.31:功能提升与日志更新

- JavaScript前台表单验证技巧与实例解析

- FLAC二次开发实用论文资料汇总

- JavaScript项目开发实践:Front-Projeto-Final-PS-2019.2解析

- 76云保姆:迅雷云点播免费自动升级体验

- Android SQLite数据库增删改查操作详解

- HTML/CSS/JS基础模板:经典篮球学习项目

- 粒子群算法优化GARVER-6直流配网规划

- Windows版jemalloc内存分配器发布

- 实用强大QQ机器人,你值得拥有