动态优化池化: DynOPool提升深度网络性能

PDF格式 | 789KB |

更新于2025-01-16

| 28 浏览量 | 举报

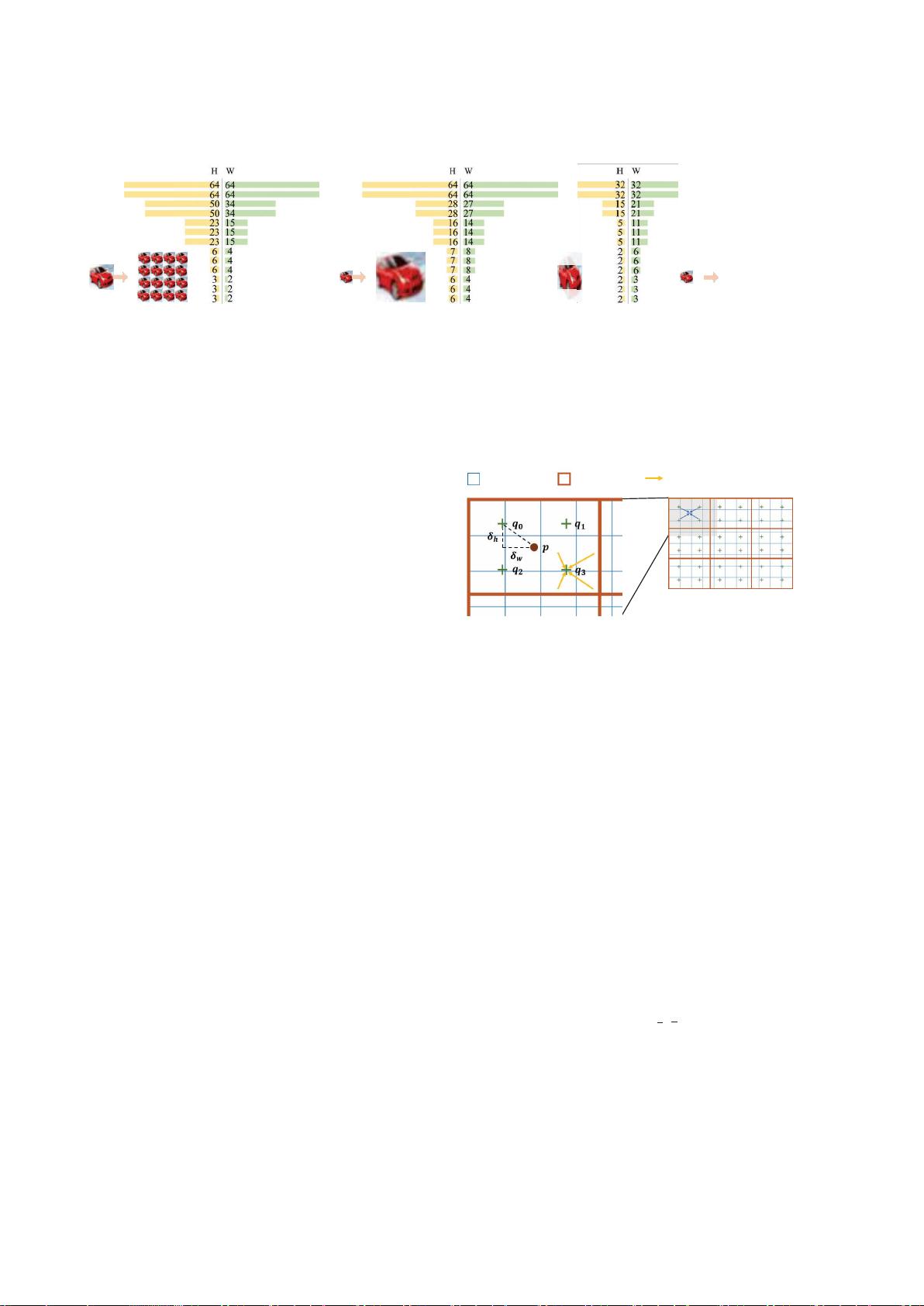

DynOPool是一种创新的动态优化池化模块,它旨在解决传统神经网络中池化操作固定接受域所带来的次优问题。池化在深度学习中扮演着关键角色,通过聚合局部特征来控制模型复杂性和提升性能。然而,当前的池化操作通常依赖于预设的超参数,如感受野大小和形状,这些往往不能适应所有场景,可能导致对不同尺度物体的识别效果不佳。

DynOPool的核心贡献在于它引入了一个端到端学习的过程,允许网络自适应地调整池化操作的比例因子,从而动态地优化接收域的大小和形状。这不仅提高了特征映射的效率,还使得深层网络能够以最合适的尺度观察输入图像,增强其表达能力和泛化能力。此外,该模块可以无缝融入深度神经网络中的任意嵌入式层,只需极低的额外成本即可实现。

为控制模型的复杂性,DynOPool引入了额外的计算成本限制损失项,这样可以在保持性能的同时,避免过度拟合或不必要的计算开销。这种设计既考虑了模型的精度,也兼顾了效率,使得模型能够在资源有限的情况下仍能展现出优秀的表现。

实验证明,通过整合DynOPool的学习模块,模型在图像分类和语义分割等多个任务上显著优于现有的基线算法,特别是在处理不同尺度物体和场景时,展现出了更好的适应性和泛化能力。因此,DynOPool为深度学习模型提供了一种有效且灵活的池化优化策略,有助于推动深度学习在更多领域的广泛应用。

相关推荐

cpongm

- 粉丝: 6

最新资源

- 武汉大学数字图像处理课程课件精要

- 搭建个性化知识付费平台——Laravel开发MeEdu教程

- SSD7练习7完整解答指南

- Android中文API合集第三版:开发者必备指南

- Python测试自动化实践:深入理解更多测试案例

- 中国风室内装饰网站模板设计发布

- Android情景模式中音量定时控制与铃声设置技巧

- 温度城市的TypeScript实践应用

- 新版高通QPST刷机工具下载支持高通CPU

- C++实现24点问题求解的源代码

- 核电厂水处理系统的自动化控制解决方案

- 自定义进度条组件AMProgressView用于统计与下载进度展示

- 中国古典红木家具网页模板免费下载

- CSS定位技术之Position-master解析

- 复选框状态持久化及其日期同步技术

- Winform版HTML编辑器:强大功能与广泛适用性