48

46

44

42

40

38

10

1

10

2

10

3

10

4

10

5

时间[s]

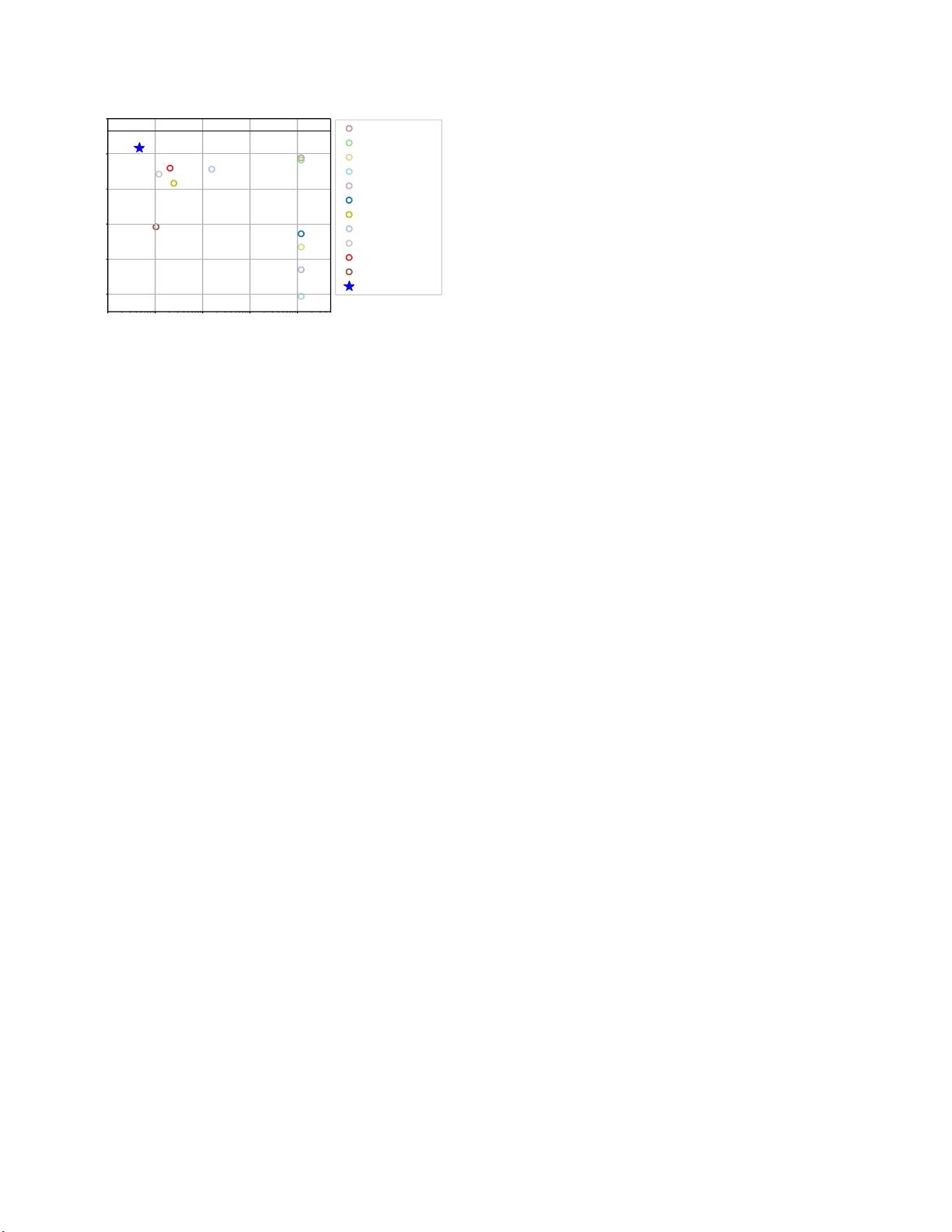

图1:在NATS-Bench [5]的ImageNet 16 - 120上的平均

测试准确度与时间[s]X轴为对数标度。基于训练的方

法的准确性和时间来自原始的NATS-Bench论文[5]。

可以为其他数据集绘制类似的图,为了空间起见,这

里省略了这些图。

didates 为了解决这个问题,研究界最近一直专注于采

用代理来在初始化时对架构进行评分[21,2,1],从

而避免繁重而缓慢的训练阶段,即使在有限的硬件资

源下也能实现一致的加速。然而,到目前为止提出的

无训练NAS算法与基于训练的方法不具有竞争力,并

且通常也不考虑包括硬件驱动的约束(诸如模型占用

空间和FLOP)的机会。

本文弥合了这一差距,并提供了一个自定义约束进

化论的方法,名为FreeREA,利用最佳组合的指标,

作为代理模型的准确性。我们展示了我们使用的指标

如何有效地替代模型训练,从而能够在短短几分钟的

搜索中自动识别高性能模型。我们在两个流行的小模

型NAS基准测试上测试了我们的解决方案,并展示了

我们的方法在无约束情况下如何优于最先进的方法我

们还首次采用免培训方法,在受限场景中进行了实

验,为未来的工作设定了非常有竞争力的基线。

总之,本文提出了以下贡献的最新技术:

1.

用于模型排名的无训练度量的优化组合,其可以

完全替代NAS算法中的训练阶段;

2.

一种改进的进化搜索算法,充分利用排名策略,

在几分钟的搜索时间内识别出非常准确的模型;

3.

一些实验来证明无训练方法如何有效地取代基于

训练的方法。

NAS方法,即使在硬件受限的环境中。

2.

相关工作

神经架构 搜索首先 在[37]中引 入, 其中采用 具有

LSTM [11]控制器的强化学习方法REIN-FORCE [33]来

生 成高 性能 神 经网 络 。整 个搜 索 使用 了 超过 800个

GPU,历时28天,总计22400个GPU小时,需要对超过

12k个不同架构进行部分(35个epochs)训练。在这项

开创性的工作之后,研究界专注于开发更有效的方法

[22,6,25,17],目的是减轻NAS算法的巨大计算需

求。

在这个方向上的第一次尝试集中在参数共享[22,

6,17],其中新发现的架构从先前发现的架构继承其

权重。虽然[22]仍然采用强化学习方法,但NAS文献

中出现了另外两种搜索范式:微分搜索和进化。第一

个[17,6]从目的出发,使整个搜索可微,以便可以通

过梯度下降算法进行优化,从而导致显著的加速w.r.t.

原始方法[37]。另一方面,基于进化的策略实现起来

非常简单,并且自然地允许从父代继承参数,但性能

较低[18,26]。在REA [25]中,作者实现了一种规则化

的锦标赛选择搜索算法,该算法被证明是第一个能够

超越人工构建架构的基于进化的NAS。但这些方法并

不能完全解决核心问题,还需要对成千上万的候选人

进行培训和评估。

出于这个原因,研究界最近专注于采用指标来在初

始化时对不同的架构进行评分,完全避免了训练和评

估阶段,这构成了NAS算法的真正瓶颈。提出的第一

个度量标准是线性区域(NASWOT)[21],它测量架

构的表达能力,并允许在几秒钟内搜索竞争候选者。

然而,这些网络仍然不如标准NAS算法所发现的网络

准确。因此,这种方法的使用仅限于经典搜索的初始

化。后来,GA-NINASWOT [34]采用了线性区域和遗

传算法,而EPE-NAS

[20]提出了对基本指标的改进。然而,这些方法都没

有表现出与基于培训的方法相竞争的能力从NASWOT

[21]中获得灵感,

[2]作者将线性区域的变化与神经切核(NTK)度量[12]

相结合,以在搜索中对候选者的可训练性进行编码由

于NTK计算的复杂性,NASI [27]提出了一种