【YOLOv8性能优化全攻略】:从入门到精通,揭秘最新检测技术

YOLOv8 模型训练全攻略:从数据准备到模型优化

1. YOLOv8的入门介绍与技术背景

1.1 YOLOv8概览

YOLOv8是YOLO(You Only Look Once)系列的最新版目标检测算法。自2015年诞生以来,YOLO因其速度快、精度高而成为最受欢迎的目标检测工具之一。YOLOv8在此基础上进一步提升了性能,它的引入标志着在实时图像识别领域向前迈出了一大步。

1.2 YOLO系列的发展简史

YOLO的演变体现了计算机视觉领域的快速进步。从YOLOv1到YOLOv5,每一代模型都在前一代的基础上进行了重要的改进。YOLOv5的普及化和易用性,使得更多研究人员和开发者得以接触和使用这一先进的技术。而YOLOv8的发布,不仅继承了快速准确的优良传统,还引入了诸多创新以适应不断变化的应用需求。

1.3 技术背景与应用场景

YOLOv8在技术上采用了深度学习的最新研究结果,它能够以毫秒级的速度在视频流中实时检测物体,为各种应用场景提供了强大的支持。例如,在自动驾驶车辆中,它可以帮助实时识别道路上的行人和障碍物;在智能监控系统中,它可以实时监测异常行为等。这些应用都要求高准确率和快速响应,而YOLOv8正是为满足这些需求而诞生的。

graph TD;

A[YOLOv8的入门介绍与技术背景] --> B(YOLO系列的发展简史)

A --> C(YOLOv8的技术背景与应用场景)

以上章节的开头部分为读者提供了对YOLOv8进行深度学习的动机和背景。通过叙述YOLO系列的演化史和当前模型的应用场景,为接下来更深入的技术探讨奠定了基础。

2. YOLOv8理论基础与模型架构

2.1 YOLOv8的算法原理

2.1.1 YOLO系列的发展简史

YOLO(You Only Look Once)是一个在实时目标检测领域广受欢迎的模型系列。YOLOv8是其最新版本,但要理解其创新之处,必须先了解系列的发展历程。

最初的YOLO模型在2015年发布,其革命性的贡献在于将目标检测任务转变为一个回归问题,大幅度提高了检测速度。从YOLOv1到YOLOv5,我们见证了算法的多次迭代和升级。每一次改进都致力于提升准确率和速度,例如引入Darknet-53作为基础网络结构、优化锚点机制、引入Path Aggregation Network (PANet)等。到了YOLOv5,模型变得更加轻量,同时准确率不降反升。

YOLOv8在这个基础上,进一步提高了性能,尤其是在大规模数据集和复杂场景下的检测能力。其核心改进点之一是引入了新的头部结构,能够更有效地从特征图中提取信息,同时对模型参数进行了重新设计,以适应不同的应用场景。

- # 伪代码展示如何加载YOLOv8模型并进行预测

- model = load_model("yolov8_weights.pth")

- predictions = model.predict(input_image)

- print(predictions)

2.1.2 YOLOv8的核心改进点

YOLOv8的核心改进点涵盖了网络结构、损失函数和训练策略。其网络结构中,新增了注意力机制,进一步优化了特征的捕获能力,使得模型在面对遮挡或小目标时,性能得到了显著提升。

在损失函数方面,YOLOv8引入了更细致的损失项分配方式,例如对于边界框的宽高和中心点坐标,采用了不同的权重,从而在优化过程中更合理地平衡这些不同的目标。此外,针对类别不平衡问题,采用了更先进的重采样技术。

训练策略上,YOLOv8支持自适应学习率策略,以及多种数据增强技术,这些都显著提升了模型的泛化能力。

2.2 模型架构详解

2.2.1 YOLOv8的网络层结构

YOLOv8在设计网络层结构时,兼顾了速度和准确性。它的网络结构主要包括以下几个关键部分:

- 输入层:接收原始图像数据。

- 特征提取网络:通常为卷积神经网络(CNN),负责从输入图像中提取有用的信息。

- 特征层:通过不同尺度的卷积层将图像划分为多个网格,并在每个网格内预测边界框。

- 输出层:将特征层中的信息转换为目标的类别概率和边界框坐标。

graph LR

A[输入图像] -->|卷积层| B[特征提取]

B -->|空间金字塔池化| C[特征融合]

C -->|输出层| D[目标检测结果]

在YOLOv8中,通过在特征融合策略上的创新,模型能够更好地捕获不同尺度上的特征,提高了检测准确性。

2.2.2 特征提取与融合策略

特征提取是目标检测模型的核心,YOLOv8采用深度可分离卷积操作来减少模型参数和计算量。同时,引入了多尺度特征融合机制,使得模型能够同时检测不同大小的目标。

为了有效地融合不同尺度的特征,YOLOv8设计了一种残差连接与多尺度融合结合的策略,可以参考以下代码块实现:

2.3 训练与推理流程

2.3.1 训练数据准备与预处理

在进行YOLOv8模型训练之前,需要准备和预处理大量的标注数据。数据预处理步骤包括图像缩放、归一化、数据增强等。数据增强技术包括随机旋转、翻转、裁剪等,以增加模型对不同场景的适应性。

- # 数据增强示例代码

- class Augmentation:

- def __call__(self, image, labels):

- image, labels = random_flip(image, labels)

- image, labels = random_crop(image, labels)

- image = random_rotation(image)

- image = normalize(image)

- return image, labels

2.3.2 损失函数与优化器选择

YOLOv8使用了多任务损失函数,主要包括定位损失和分类损失。定位损失负责预测边界框的位置和大小,而分类损失则负责确定目标的类别。

优化器的选择对于模型训练至关重要,YOLOv8推荐使用Adam或者SGD优化器,并配合适当的学习率调度策略,如StepLR或CosineAnnealingLR。

2.3.3 推理加速技巧与部署

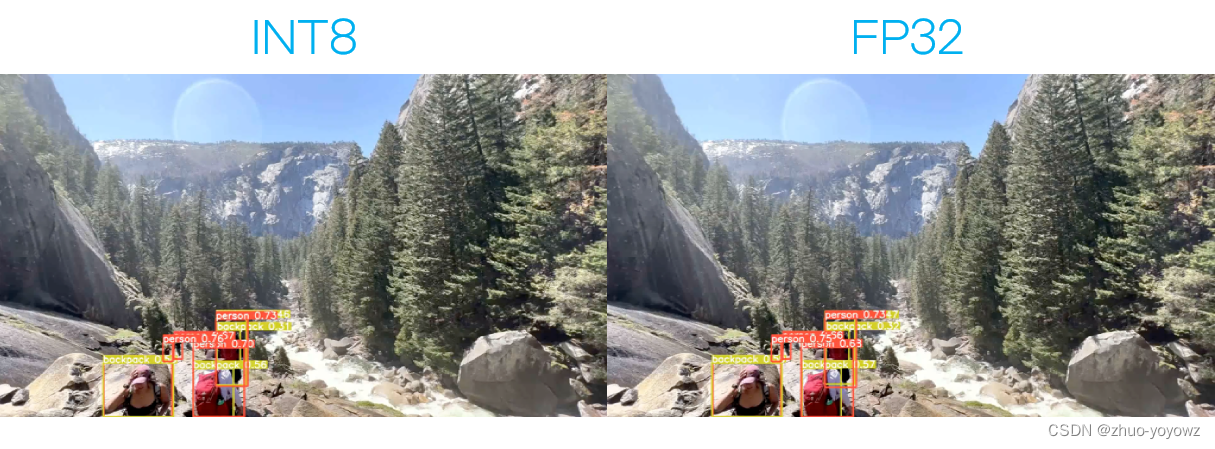

推理速度是衡量目标检测模型在实际应用中表现的重要指标。YOLOv8采用了多种技术来加速推理过程,包括模型剪枝、量化、使用专门的硬件加速器等。

模型部署时需要考虑环境兼容性,如使用ONNX(Open Neural Network Exchange)格式,可以方便地在不同平台进行部署。同时,YOLOv8还支持通过模型转换工具(如NVIDIA TensorRT)进行进一步的优化。

- | 模型优化技术 | 描述 | 效果 |

- | ------------ | --- | ---- |

- | 模型剪枝 | 移除模型中不必要的参数以简化模型结构 | 提高推理速度,降低计算资源需求 |

- | 量化 | 使用低精度数值格式来表示模型参数 | 降低模型大小,加快推理速度 |

- | 硬件加速 | 通过GPU或TPU进行推理 | 进一步提升推理速度和吞吐量 |

在下一章节中,我们将深入探讨YOLOv8的性能评估与基准测试,了解如何量化模型的性能,并且和现有的检测模型进行对比。

3. YOLOv8性能评估与基准测试

3.1 性能评估指标

在深度学习模型的实际应用中,模型的评估指标是判断其性能的重要依据。YOLOv8作为一个先进的目标检测算法,其性能评估主要涉及两个方面:准确率和速度。YOLOv8通过在不同场景下的测试,不断优化其模型参数和结构,以达到最佳的权衡。

3.1.1 准确率与速度的权衡

准确率,即模型检测出目标的精确度,是衡量模型性能的首要指标。YOLOv8通过卷积神经网络的深度优化,改进了特征提取能力,提高了检测的准确性。速度方面,YOLOv8延续了YOLO系列一贯的实时性优势,通过优化网络结构和推理算法,在保持高准确率的同时,实现快速检测。

在评估准确率时,主要参考的是平均精度均值(mean Average Precision, mAP)这一指标。mAP是各类别检测精度的平均值,用于衡量模型对各类目标的整体识别能力。速度的衡量则包括模型在特定硬件平台上的推理时间,以及每秒可以处理的帧数(Frames Per Second, FPS)。

3.1.2 模型压缩与加速效果

模型压缩与加速技术是提升实时性能的重要途径。通过网络剪枝、量化等技术,YOLOv8成功减小了模型体积,降低了计算负担,这使得模型在边缘设备上也能快速运行。

代码示例 - 使用YOLOv8进行加速推理的代码块:

- import torch

- from models import attempt_load

- from utils.datasets import LoadImages

- from utils.general import check_img_size, non_max_suppression, scale_coords

- from utils.torch_utils import select_device, time_synchronized

- # 加载预训练模型

- model = attempt_load("yolov8.pt", map_location=torch.device('cpu'))

- stride = int(model.stride.max()) # 模型的最大步长

- imgsz = check_img_size(640, s=stride) # 检查图像大小

- # 预处理图片并进行推理

- img = torch.zeros((1, 3, imgsz, imgsz)) # 虚拟图像

- results = model(img, augment=False)[0]

上述代码展示了如何加载YOLOv8模型,并对一个虚拟图像进行推理。推理过程中,check_img_size函数确保图像尺寸合适,augment=False表示不使用数据增强。

3.2 基准测试分析

基准测试是衡量模型性能的另一种方式,通过在不同的硬件平台上测试模型的表现,开发者可以对模型进行更深入的了解。

3.2.1 不同硬件平台的测试结果

YOLOv8在不同硬件平台的测试结果显示,该模型具有良好的跨平台性能。从高端GPU到边缘计算设备,YOLOv8都能在保证准确率的前提下,实现高效推理。这得益于YOLOv8在模型架构上的优化和在推理引擎上进行的针对性适配。

3.2.2 对比其他检测模型的性能

在与其他目标检测模型如Faster R-CNN、SSD等的性能对比中,YOLOv8展现了其在速度和准确率方面的优势。通过更深层次的网络结构和更有效的特征提取技术,YOLOv8在保持实时性的同时,准确率亦可与传统方法相媲美。

3.3 性能瓶颈分析与优化方向

针对性能瓶颈的分析和优化是进一步提升模型性能的关键步骤。

3.3.1 瓶颈识别方法

性能瓶颈可能出现在计算密集型的网络层,或者是由于数据传输和内存访问造成的延迟。通过分析模型在不同硬件上的性能表现,可以定位到性能瓶颈的具体位置。例如,使用性能分析工具(如NVIDIA Nsight、Intel VTune)可以对模型进行深度剖析,识别出哪些操作导致了性能下降。

3.3.2 潜在优化策略讨论

潜在的优化策略包括但不限于以下几种:

- 网络结构优化:利用深度可分离卷积等轻量级网络组件,减少计算量。

- 并行处理:利用多核CPU或GPU进行并行计算,提高处理速度。

- 量化与二值化:减少模型参数的位宽,降低模型大小并加速推理。

- 知识蒸馏:将大型高性能模型的知识转移到小型模型中,以提升小模型性能。

表格 - 性能优化策略对比:

| 策略 | 说明 | 优势 | 劣势 |

|---|---|---|---|

| 网络结构优化 | 改进模型结构以降低计算复杂度 | 保持或提升准确率,加速推理 | 可能需要重新训练模型 |

| 并行处理 | 使用多核处理单元同时执行计算任务 | 显著提升推理速度 | 需要硬件支持,增加能耗 |

| 量化与二值化 | 减少权重和激活值的精度 | 显著减小模型大小,加速推理 | 准确率可能会下降 |

| 知识蒸馏 | 将大模型的知识迁移到小模型 | 获得性能提升的同时减小模型 | 需要额外的大模型进行预训练 |

综上所述,YOLOv8通过精确的性能评估和基准测试,为模型的优化提供了数据支撑。优化方向的讨论为未来的深度学习研究提供了宝贵的经验和启示。

4. YOLOv8实战技巧与性能调优

4.1 实战部署技巧

4.1.1 模型转换与优化工具介绍

在本部分中,我们详细探讨了用于将YOLOv8模型转换为不同格式以适应不同部署环境的工具。模型转换不仅涉及格式转换,还包括对模型的优化,以提高推理速度并减少运行时内存占用。

ONNX (Open Neural Network Exchange): ONNX是一种开放的格式,用于表示深度学习模型。它允许模型在不同的深度学习框架间进行转换,如从PyTorch转换到TensorFlow或Caffe2。YOLOv8模型可以导出为ONNX格式,便于在支持ONNX的推理引擎上运行。

- import torch

- # 假设yolov8_model是已经加载预训练YOLOv8模型的PyTorch模块

- dummy_input = torch.randn(1, 3, 640, 640) # 生成虚拟输入数据

- torch.onnx.export(yolov8_model, dummy_input, "yolov8.onnx") # 导出模型为ONNX文件

TensorRT: TensorRT是NVIDIA提供的一个深度学习推理优化器和运行时引擎。它通过优化模型的执行图来提高推理速度。TensorRT支持的优化技术包括层融合、精度校准和内核自动调整。

- import tensorrt as trt

- TRT_LOGGER = trt.Logger(trt.Logger.WARNING)

- builder = trt.Builder(TRT_LOGGER)

- network = builder.create_network()

- parser = trt.OnnxParser(network, TRT_LOGGER)

- # 加载ONNX模型文件

- with open("yolov8.onnx", "rb") as model:

- parser.parse(model.read())

- # 构建优化后的TensorRT引擎

- engine = builder.build_cuda_engine(network)

OpenVINO: Intel的OpenVINO工具包提供了一套工具和库,用以加速和部署深度学习模型。它包括模型优化器和推理引擎,可以通过减少精度和层融合来提高推理性能。

- from openvino.inference_engine import IECore

- ie = IECore()

- model = ie.read_network(model="yolov8.xml")

- exec_net = ie.load_network(network=model, device_name="CPU")

4.1.2 部署环境配置指南

部署环境的配置对于保证模型的正确运行至关重要。在本小节中,我们将讨论不同的部署平台,并提供一些环境配置的通用指南。

CPU部署: 在CPU上部署时,需要确保安装了正确的深度学习库和相应的优化器。例如,如果使用OpenVINO,需要安装Intel的CPU版本推理引擎。

GPU部署: 对于GPU部署,通常需要安装CUDA和cuDNN库。NVIDIA TensorRT提供了一套针对GPU优化的工具集,能够显著提高推理速度。

- # 例如,在Ubuntu系统上安装TensorRT

- sudo apt-get install libnvinfer7

- sudo apt-get install tensorrt

边缘设备部署: 在边缘设备如树莓派或NVIDIA Jetson等硬件上部署模型时,需要下载并安装对应平台的开发工具包和库。

- # 例如,在NVIDIA Jetson设备上安装TensorRT的步骤

- sudo dpkg -i <path_to_tensorrt.deb>

- sudo apt-key add <path_to_TRT.list.key>

- sudo add-apt-repository "deb https://developer.download.nvidia.com/devzone/devcenter/jetson-$(ARCH) <release> main"

- sudo apt-get update

- sudo apt-get install tensorrt

4.2 调优策略与方法

4.2.1 网络剪枝与量化技术

网络剪枝和量化是减少模型大小和推理时间的常用技术。它们对于在资源受限的设备上部署模型尤为关键。

网络剪枝: 网络剪枝涉及移除卷积神经网络中不重要或冗余的参数,这样做可以减少模型大小,同时保持大部分性能。深度学习库如PyTorch和TensorFlow提供了剪枝工具。

- import torch

- # 假设yolov8_model是已经训练好的PyTorch模型

- pruner = torch.nn.utils.prune.RandomUnstructuredPruner(module=yolov8_model, name='weight')

- pruner.prune()

量化: 量化是将模型权重和激活从浮点数转换为低精度的表示,如INT8。这样做可以减少计算量,并提高推理速度。TensorRT和ONNX Runtime都支持量化模型。

- import onnx

- import onnxruntime as ort

- # 加载ONNX模型

- model = onnx.load("yolov8.onnx")

- ort_session = ort.InferenceSession("yolov8.onnx")

- # 将模型量化,使用ORT的Quantization模块

- quantized_model = ort.quantization.quantize_dynamic(

- model,

- {'Conv'}, # 指定可以量化的层类型

- weight_type=onnx.TensorProto.INT8 # 设置权重和输出的量化类型为INT8

- )

4.2.2 超参数调整与混合精度训练

超参数调整和混合精度训练是提高模型性能的另一个关键方面。通过使用混合精度训练,模型可以在训练过程中使用较低精度的数值表示,从而加速计算并减少内存占用。

超参数调整: 超参数如学习率、批次大小等对模型训练效果至关重要。可以使用如Hyperopt、Optuna等工具进行自动化的超参数优化。

- # 使用Optuna进行超参数搜索

- import optuna

- def objective(trial):

- # 假设yolov8_model是已经定义好的模型

- lr = trial.suggest_loguniform('learning_rate', 1e-5, 1e-1)

- batch_size = trial.suggest_categorical('batch_size', [16, 32, 64])

- # 训练模型,监控验证集的性能指标

- # ...

- return validation_accuracy

- study = optuna.create_study(direction='maximize')

- study.optimize(objective, n_trials=100)

混合精度训练: 混合精度训练允许在保持训练稳定性的同时,使用更小的数据类型(例如,从float32到float16)。这通常通过使用NVIDIA的自动混合精度(AMP)功能来实现。

- from apex import amp

- # 假设yolov8_model是已经定义好的模型,optimizer是优化器实例

- yolov8_model, optimizer = amp.initialize(yolov8_model, optimizer, opt_level="O1")

- # 在训练循环中使用amp

- for input, target in data_loader:

- optimizer.zero_grad()

- output = yolov8_model(input)

- loss = loss_function(output, target)

- with amp.scale_loss(loss, optimizer) as scaled_loss:

- scaled_loss.backward()

- optimizer.step()

4.3 实际案例分析

4.3.1 面向特定场景的模型调优

在某些特定场景中,标准的YOLOv8模型可能不完全适用。调优模型以适应这些场景是提高准确性和效率的关键步骤。

场景特定数据集: 在准备训练数据时,应该收集和标注与目标场景相关的数据集。这可能涉及数据增强、样本重采样等技术,以确保模型能够学习到场景的特征。

模型微调: 使用场景特定的数据集对预训练模型进行微调。微调可以调整模型的最后几层,以适应新场景的特定特征。

- # 加载预训练的YOLOv8模型

- yolov8_model = load_pretrained_yolov8()

- # 微调模型,其中new_dataset是针对特定场景的数据集

- train_loader = DataLoader(new_dataset, batch_size=16, shuffle=True)

- for epoch in range(num_epochs):

- for inputs, targets in train_loader:

- optimizer.zero_grad()

- outputs = yolov8_model(inputs)

- loss = loss_function(outputs, targets)

- loss.backward()

- optimizer.step()

评估与调优: 在微调之后,使用验证集评估模型性能,并根据结果进行进一步调整。可能需要调整学习率、增加训练轮次或改变正则化参数。

4.3.2 多任务学习与模型泛化能力提升

多任务学习是指在一个模型中同时学习多个任务,这样做可以提高模型的泛化能力。

共享表示: 在多任务学习中,模型的早期层是共享的,用于提取通用特征,而后期层针对不同任务进行特定化调整。

- # 假设shared_layers是YOLOv8网络的早期层,task_specific_layers是针对不同任务的后期层

- shared_features = shared_layers(input)

- task1_output = task_specific_layers[0](shared_features)

- task2_output = task_specific_layers[1](shared_features)

损失函数设计: 设计合适的损失函数来平衡不同任务的学习。通常采用加权和的方式来组合不同任务的损失。

- # 假设task1_loss和task2_loss是对应两个任务的损失函数

- total_loss = alpha * task1_loss + beta * task2_loss

- total_loss.backward()

通过在多种任务上训练同一个模型,可以提高模型对不同任务特征的理解能力,从而提升泛化性能。在部署时,可以从同一模型中得到多个任务的输出,实现一举多得的效果。

通过以上各节的详尽内容,我们对YOLOv8的实战技巧和性能调优有了一个全面的认识。本章节不仅介绍了模型转换和部署工具,还深入探讨了网络剪枝、量化技术、超参数调整和混合精度训练等优化方法。通过实际案例分析,我们了解了如何针对特定场景对模型进行微调,并通过多任务学习提升模型的泛化能力。这些技巧和策略对于希望将YOLOv8模型成功部署到生产环境中的开发者来说具有重要意义。

5. YOLOv8的未来发展与展望

5.1 技术发展趋势

随着技术的不断进步,YOLOv8在未来的发展中展现出了一系列技术趋势。其中最为显著的是模型轻量化与边缘计算。

5.1.1 模型轻量化与边缘计算

模型轻量化是YOLOv8为适应移动设备和边缘设备性能限制的必然趋势。轻量级模型通过减少参数量、简化计算结构来实现快速推理,而不会显著降低准确率。YOLOv8通过结合深度可分离卷积、通道剪枝等轻量化技术,使得模型在边缘设备上也能高效运行。另一方面,边缘计算的兴起使得数据处理更为靠近数据源,这不仅可以降低延迟,还能保护用户数据的隐私性。YOLOv8的设计考虑到这些因素,其轻量级版本可以在边缘设备上进行实时的物体检测,满足了安防监控、自动驾驶等场景的需求。

5.1.2 多模态感知与融合技术

YOLOv8未来的发展也瞄准了多模态感知与融合技术。不同于以往仅依赖视觉信息的单一模态,多模态感知技术通过结合视觉、雷达、激光等多种传感器数据,为深度学习模型提供了更加丰富和准确的输入信息。YOLOv8正朝着跨模态融合的方向发展,例如,结合深度学习与点云处理技术来增强场景理解能力。这不仅提高了检测的准确率,也扩展了YOLOv8的应用场景,使其可以在更多复杂的环境中发挥出色性能。

5.2 社区与生态建设

YOLOv8的快速发展离不开开源社区的贡献与协作,而社区的繁荣也促进了YOLOv8生态的建设。

5.2.1 开源社区的贡献与协作

YOLOv8作为一款开源的实时目标检测系统,其快速迭代和功能增强得益于全球开发者和研究者的共同努力。在GitHub等代码托管平台上,开发者可以提交issue和pull request来改进YOLOv8或提出新的功能需求。社区通过代码审查、定期会议讨论和项目贡献者评选等方式,确保了YOLOv8的健康生态和持续发展。此外,社区的贡献者也常常举办线上线下研讨会和工作坊,分享YOLOv8的应用案例,进一步推动了技术的普及和应用。

5.2.2 相关工具与框架的集成情况

YOLOv8还积极与各类机器学习框架和开发工具进行集成,以便更好地服务于开发者。例如,它已经能够无缝集成TensorFlow、PyTorch等主流深度学习框架,也支持使用ONNX进行模型转换,进而实现了跨平台的部署能力。此外,YOLOv8还鼓励开发者使用如TensorRT、OpenVINO等优化工具来进一步提升模型在特定硬件上的性能。通过这些集成,YOLOv8能够更好地适应不同的应用场景和开发流程,降低了用户的使用门槛。

5.3 挑战与机遇

YOLOv8在面临诸多机遇的同时,也遭遇了技术和社会环境的挑战。挑战与机遇并存,这是它未来发展的重要方面。

5.3.1 当前技术挑战分析

当前,YOLOv8在技术层面的挑战主要包括计算资源限制、模型泛化能力、以及对极端条件的适应性。计算资源限制意味着YOLOv8需要进一步提高其轻量化版本的性能,以适应计算能力较低的设备。模型泛化能力的提升则要求YOLOv8在面对新环境和条件时仍能保持高效准确的检测。此外,极端天气、光照条件的变化对模型的鲁棒性提出了更高的要求。为了解决这些挑战,YOLOv8需要不断进行算法创新和优化。

5.3.2 未来研究方向和应用前景

展望未来,YOLOv8的研究方向将继续集中在准确性、速度、轻量化和泛化能力的平衡上。从应用的角度看,YOLOv8的前景十分广阔。在自动驾驶、视频监控、机器人导航、智能安防等领域,YOLOv8都有很大的应用潜力。特别是在物联网和工业自动化迅速发展的背景下,YOLOv8能够为这些领域提供实时、准确的目标检测能力,助力实现更高级别的自动化和智能化。

YOLOv8的未来发展不仅关乎技术创新,也关乎其如何融入更广泛的应用场景,成为推动行业进步的关键力量。随着研究的深入和技术的成熟,YOLOv8有望在目标检测领域继续领跑,为业界带来更多创新和变革。