【矩阵分解:破解问题的7种武器】:案例分析,教你如何巧妙运用

发布时间: 2024-12-06 12:33:48 阅读量: 17 订阅数: 27

利用Verilog实现四阶矩阵求逆

参考资源链接:[《矩阵论》第三版课后答案详解](https://wenku.csdn.net/doc/ijji4ha34m?spm=1055.2635.3001.10343)

# 1. 矩阵分解的基本概念与重要性

在数据科学和机器学习的领域中,矩阵分解技术是一种强大的数学工具,它将一个复杂的矩阵转换成两个或多个矩阵的乘积,旨在揭示数据的潜在结构和减少数据的维度。矩阵分解在解决推荐系统、图像压缩、模式识别等问题上发挥着重要作用,它是数据分析和处理的核心技术之一。

矩阵分解的应用范围非常广泛,不仅限于传统的线性代数问题,而且在统计学、信号处理、计算机视觉等多个领域中都扮演了关键角色。随着技术的不断进步,矩阵分解技术也在不断发展,其算法复杂度降低,应用范围也日益扩大。

矩阵分解之所以重要,是因为它能够通过将原始数据集中的复杂关系简化为几个更易于管理的组成部分来增强我们对数据的理解。这种降维的技术对于处理高维数据集,如图像和视频,是必不可少的,因为它能够显著减少计算成本并提高处理效率。

在接下来的章节中,我们将详细介绍几种矩阵分解的类型,如奇异值分解(SVD)、主成分分析(PCA)和非负矩阵分解(NMF),并探讨它们在不同领域中的应用和实践。通过学习这些内容,读者将能够更好地掌握矩阵分解的原理以及如何将这些技术应用于实际问题中。

# 2. 奇异值分解(SVD)

## 2.1 SVD的理论基础

### 2.1.1 分解过程的数学原理

奇异值分解(Singular Value Decomposition,SVD)是线性代数中一种矩阵分解技术,它能够将任意一个矩阵分解为三个特定的矩阵乘积形式。对于一个 \( m \times n \) 的矩阵 \( A \),其SVD分解可以表示为:

\[ A = U \Sigma V^T \]

其中,

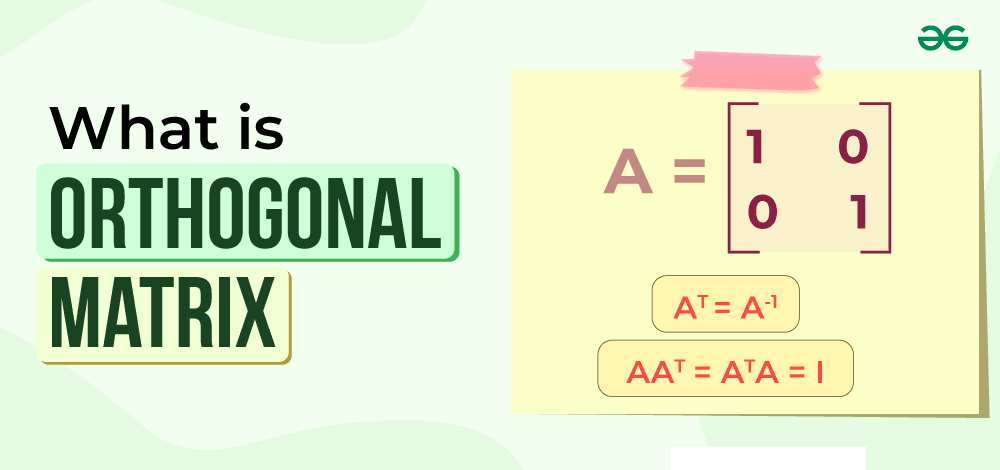

- \( U \) 是一个 \( m \times m \) 的正交矩阵,其列向量 \( u_i \) 形成了一个标准正交基,基向量对应于 \( A \) 的左奇异向量。

- \( \Sigma \) 是一个 \( m \times n \) 的对角矩阵,其对角线上的元素 \( \sigma_i \) 称为奇异值,按从大到小排列,描述了 \( A \) 的奇异值性质。

- \( V \) 是一个 \( n \times n \) 的正交矩阵,其列向量 \( v_i \) 也构成一个标准正交基,对应于 \( A \) 的右奇异向量。

矩阵 \( A \) 的每个奇异值都是其非负平方根的特征值,而对应的左、右奇异向量是这些特征值对应的特征向量。

### 2.1.2 SVD在数据分析中的应用

奇异值分解在数据分析领域有着广泛的应用。例如,在处理含有噪声的数据时,SVD可以通过降维提高数据的信噪比。SVD能够揭示数据中的潜在结构,常常被用于特征提取和数据压缩。

在统计学中,SVD被用于主成分分析(PCA),通过寻找数据的主成分来简化数据集,去除冗余信息。在推荐系统中,SVD用于用户-物品评分矩阵的分解,以预测用户的喜好。

## 2.2 SVD的实践操作

### 2.2.1 使用Python进行SVD操作

Python中有多个库支持矩阵分解,其中包括NumPy和SciPy。以下是使用NumPy实现SVD的一个简单示例:

```python

import numpy as np

# 创建一个矩阵

A = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 执行奇异值分解

U, Sigma, VT = np.linalg.svd(A)

# 打印结果

print("U 矩阵:\n", U)

print("Sigma 对角矩阵:\n", np.diag(Sigma))

print("V^T 矩阵:\n", VT)

```

该代码块首先创建了一个三维矩阵 \( A \),然后使用 `np.linalg.svd` 函数进行奇异值分解,最后打印分解得到的矩阵 \( U \), \( \Sigma \) 和 \( V^T \)。

### 2.2.2 SVD在推荐系统中的案例

在推荐系统中,SVD常被用来处理用户-物品评分矩阵 \( R \)。通过分解这个矩阵,我们可以得到用户和物品的隐因子,以此构建一个预测模型。以下是一个简化的例子:

```python

from scipy.sparse.linalg import svds

# 假设有一个用户-物品评分矩阵

# 这里用一个简单的二维数组代替

R = np.array([

[5, 3, 0],

[4, 0, 2],

[0, 1, 4],

])

# 使用SVD分解

# 参数k表示只取前k大的奇异值和对应的奇异向量

U, Sigma, VT = svds(R, k=2)

# 这里输出的U和VT需要转置以获得正确的维度

U = np.matrix(U).T

VT = np.matrix(VT)

# 使用U, Sigma和VT重建评分矩阵

R重建 = np.dot(np.dot(U, np.diag(Sigma)), VT)

print("原始评分矩阵:\n", R)

print("重建后的评分矩阵:\n", R重建.toarray())

```

在这个例子中,我们使用了SciPy库的 `svds` 函数来执行部分SVD分解,参数 `k` 指定了我们希望保留的奇异值的数量。接着,我们重建了原始的用户-物品评分矩阵 \( R \)。

### 2.2.3 SVD在图像压缩中的应用实例

SVD在图像处理领域的一个应用是图像压缩。通过只保留那些最大的奇异值和对应的奇异向量,我们可以得到一个近似矩阵,该矩阵在视觉上与原始图像相似,但数据量更小。以下是一个使用Python进行图像压缩的示例:

```python

import cv2

import numpy as np

# 读取一张图片

image = cv2.imread('example.jpg', cv2.IMREAD_GRAYSCALE)

# 将图片转换为浮点型矩阵

image_float = np.float32(image)

# 执行SVD分解

U, Sigma, VT = np.linalg.svd(image_float, full_matrices=False)

# 假设我们只保留最大的k个奇异值

k = 100

Sigma = np.diag(Sigma[:k])

# 重建图像

U_k = U[:, :k]

VT_k = VT[:k, :]

image_approx = np.dot(U_k, np.dot(Sigma, VT_k))

# 将结果转换为整数格式,并显示原始和压缩后的图片

image_approx = np.clip(image_approx, 0, 255).astype(np.uint8)

cv2.imshow('Original Image', image)

cv2.imshow('Compressed Image', image_approx)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

该代码块首先读取一张图片,然后将其转换为灰度图像,执行SVD分解,并只保留最大的100个奇异值重建图像。最后显示原始图片和压缩后的图片。

## 2.3 SVD的进阶技巧

### 2.3.1 理解奇异值的经济意义

在SVD中,奇异值代表了数据矩阵的“经济意义”,它们可以被看作数据变化的“力量”大小。一个大的奇异值表示它能够解释数据中的重要变化;而一个相对较小的奇异值意味着它对应的变化不太重要,可能只是噪声。利用这个特性,SVD可以帮助我们识别数据中的主要成分和噪声。

### 2.3.2 降维与数据压缩的方法

通过保留最大的奇异值和对应的奇异向量,我们可以进行有效的降维和数据压缩。降维可以去除数据中的噪声和冗余,而数据压缩则减少了存储和传输数据所需的资源。

这种通过SVD的降维策略通常用于数据预处理,特别是当数据集中的特征维度非常高时。保留的奇异值和奇异向量能够保持大部分的有用信息,而舍去的部分通常是影响较小的噪声,从而达到压缩数据的目的。在机器学习模型中,这一步骤可以帮助提高模型的性能和减少计算成本。

# 3. 主成分分析(PCA)

## 3.1 PCA的理论框架

### 3.1.1 PCA的数学推导

主成分分析(PCA)是一种统计方法,通过正交变换将一组可能相关的变量转换成一组线性不相关的变量,这些新变量称为主成分。PCA的数学推导涉及特征值分解,其核心思想是最大化数据的方差。

假设有一组数据集 $X$,其中包含 $n$ 个样本,每个样本有 $m$ 个特征。我们可以表示为一个 $n \times m$ 的矩阵。PCA的目标是找到一个 $m \times k$ 的变换矩阵 $W$,其中

0

0