【线性代数与矩阵实战】:10个案例带你从理论到实践无缝转换

发布时间: 2024-12-06 12:13:32 阅读量: 31 订阅数: 23

SatNav toolbox

参考资源链接:[《矩阵论》第三版课后答案详解](https://wenku.csdn.net/doc/ijji4ha34m?spm=1055.2635.3001.10343)

# 1. 线性代数与矩阵基础回顾

## 1.1 矩阵的定义和表示

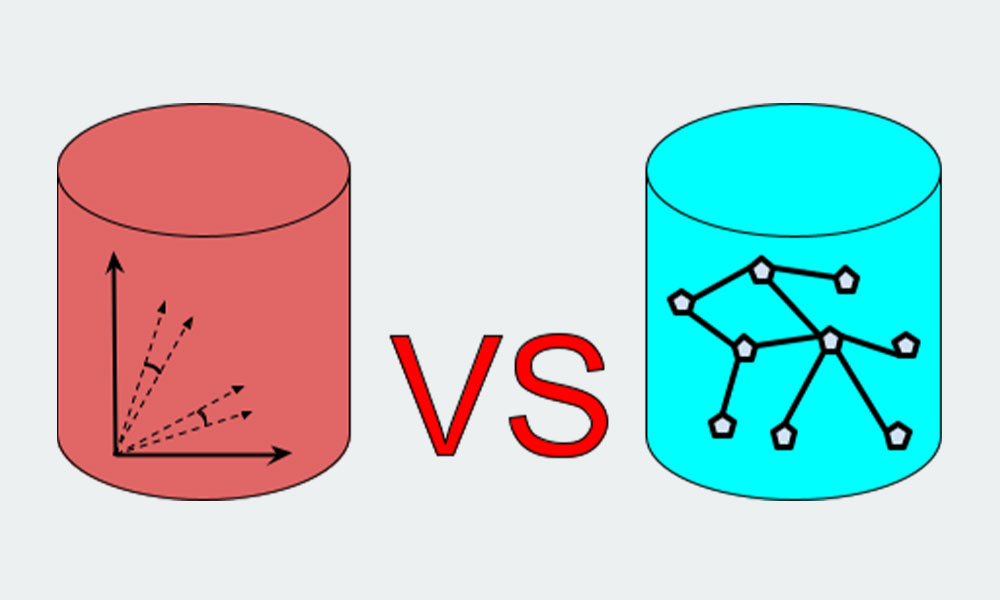

矩阵是一个按照长方阵列排列的复数或实数集合,是线性代数中一个核心概念。矩阵在数学和各种工程领域都有广泛的应用。在计算机科学中,矩阵常被用来表示数据,例如图像可以表示为二维矩阵,而网络的邻接关系可以用矩阵来表示。

## 1.2 矩阵的基本运算

矩阵运算包括矩阵加法、减法、数乘和乘法。举个例子,两个矩阵相加,就是将对应位置的元素相加,前提是这两个矩阵的维度相同。矩阵的乘法则更复杂一些,它涉及到行列的点积计算,结果矩阵的维度是由原矩阵的维度决定的。

```mathematica

// 以两个2x2矩阵A和B的加法和乘法为例:

A = {{a11, a12}, {a21, a22}}

B = {{b11, b12}, {b21, b22}}

// 矩阵加法

C = A + B

// 矩阵乘法

D = A . B

```

## 1.3 线性方程组与矩阵表示

线性方程组可以通过增广矩阵和矩阵运算转换为矩阵形式,这使得问题的求解变得直观。对于方程组 `Ax = b`,其中 `A` 是系数矩阵,`x` 是未知数向量,`b` 是常数向量。如果 `A` 可逆,那么 `x = A^(-1)b`。通过矩阵的知识,我们可以使用高斯消元等方法来求解。

线性代数是一切高级数学的基石,对于所有想要在数据分析、机器学习、计算机视觉等领域深入研究的IT从业者来说,掌握线性代数知识是必不可少的。接下来,让我们深入了解矩阵运算的实战技巧。

# 2. 矩阵运算的实战技巧

### 2.1 基本矩阵运算

#### 2.1.1 矩阵加法与减法

矩阵加法与减法是线性代数中最为基础的操作之一,它们在形式上非常相似。对于同维度的矩阵,加法运算就是将对应位置的元素相加。减法则是将对应位置的元素相减。这个过程可以类比于向量空间中向量的加法与减法,实际上在计算机科学中,矩阵可以被视为向量的向量(即向量的集合)。

执行矩阵加法与减法的伪代码如下:

```python

def matrix_addition(A, B):

# 确保矩阵A和B维度相同

if A.rows != B.rows or A.columns != B.columns:

raise ValueError("矩阵A和B的维度不匹配")

# 创建结果矩阵C,维度与A和B相同

C = create_empty_matrix(A.rows, A.columns)

# 对应位置的元素相加

for i in range(A.rows):

for j in range(A.columns):

C[i][j] = A[i][j] + B[i][j]

return C

```

参数说明:

- `A`, `B`: 相同维度的矩阵。

- `create_empty_matrix(rows, columns)`: 创建一个`rows`行`columns`列的空矩阵。

这个操作在现代编程语言中,如Python,通常都有内置的矩阵操作库(如NumPy)来简化实现。例如,在NumPy中,矩阵加法可以直接使用 `A + B` 的形式。

#### 2.1.2 矩阵乘法及其应用

矩阵乘法相比加法和减法要复杂一些。它涉及到行向量与列向量的点积运算。对于两个矩阵 `A`(大小为 `m x n`)和 `B`(大小为 `n x p`),它们的乘积 `C` 是一个 `m x p` 的矩阵。每个元素 `C[i][j]` 是由 `A` 的第 `i` 行与 `B` 的第 `j` 列对应元素的乘积之和。

执行矩阵乘法的伪代码如下:

```python

def matrix_multiplication(A, B):

# 确保矩阵A的列数等于矩阵B的行数

if A.columns != B.rows:

raise ValueError("矩阵A的列数必须与矩阵B的行数相等")

# 创建结果矩阵C,行数与A相同,列数与B相同

C = create_empty_matrix(A.rows, B.columns)

# 计算矩阵乘积

for i in range(A.rows):

for j in range(B.columns):

for k in range(A.columns):

C[i][j] += A[i][k] * B[k][j]

return C

```

参数说明:

- `A`, `B`: 具有正确乘法维度的矩阵。

- `create_empty_matrix(rows, columns)`: 创建一个`rows`行`columns`列的空矩阵。

矩阵乘法在现代计算机技术中有广泛的应用,比如在图像处理中可以用来进行矩阵的卷积操作。此外,在图形渲染中,矩阵乘法用于实现坐标变换和视角变换等。

### 2.2 矩阵的高级运算

#### 2.2.1 行列式的计算

行列式是定义在方阵上的一个标量值,它是矩阵线性变换对面积或者体积的缩放因子。在计算上,行列式通常用拉普拉斯展开或者对角线法则来求解,比如对一个2x2或3x3的矩阵,可以非常容易地计算出其行列式。

计算2x2矩阵行列式的代码示例:

```python

def determinant_2x2(matrix):

if len(matrix) != 2 or len(matrix[0]) != 2:

raise ValueError("矩阵必须是2x2的")

return matrix[0][0] * matrix[1][1] - matrix[0][1] * matrix[1][0]

```

参数说明:

- `matrix`: 必须是2x2的矩阵。

计算行列式对于解线性方程组、计算矩阵的逆以及判断矩阵是否可逆等都有重要意义。

### 2.2.2 矩阵的逆与性质

一个方阵有逆矩阵当且仅当其行列式不为0。逆矩阵是与原矩阵相乘后得到单位矩阵的唯一矩阵,它在解决线性方程组时尤其重要。通过计算逆矩阵,可以方便地求解方程组中的未知数。

计算矩阵逆的代码示例(以2x2矩阵为例):

```python

def inverse_2x2(matrix):

det = determinant_2x2(matrix)

if det == 0:

raise ValueError("矩阵不可逆,因为行列式为0")

inv_matrix = [[matrix[1][1] / det, -matrix[0][1] / det],

[-matrix[1][0] / det, matrix[0][0] / det]]

return inv_matrix

```

参数说明:

- `matrix`: 必须是可逆的2x2矩阵。

- `determinant_2x2`: 之前定义的计算2x2矩阵行列式的函数。

### 2.2.3 特殊矩阵的操作实例

在实际应用中,我们会遇到一些特殊的矩阵,比如对角矩阵、单位矩阵、稀疏矩阵等。这些矩阵在计算上有其特有的性质和优化方法。例如,对角矩阵的逆矩阵非常容易计算,只需取其对角元素的倒数即可。

对角矩阵逆矩阵计算的伪代码示例:

```python

def inverse_diagonal_matrix(matrix):

if not is_diagonal(matrix):

raise ValueError("只有对角矩阵才适用本函数")

inv_matrix = create_empty_matrix(len(matrix), len(matrix[0]))

for i in range(len(matrix)):

inv_matrix[i][i] = 1 / matrix[i][i]

return inv_matrix

```

参数说明:

- `matrix`: 必须是方阵。

- `is_diagonal(matrix)`: 函数用于判断矩阵是否为对角矩阵。

对角矩阵在数值计算中非常重要,因为它们简化了许多数学操作,比如乘法、求逆等。

### 2.3 矩阵分解技术

#### 2.3.1 LU分解的应用场景

LU分解是将一个矩阵分解为一个下三角矩阵(L)和一个上三角矩阵(U)。这种分解在求解线性方程组时非常有用,因为LU分解可以将求解过程转化为先解一个上三角方程组,再解一个下三角方程组,这通常比直接求解原方程组要快。

LU分解的代码示例:

```python

def lu_decomposition(A):

n = len(A)

U = [[0 for j in range(n)] for i in range(n)]

L = [[1 if i == j else 0 for j in range(n)] for i in range(n)]

for i in range(n):

for j in range(i, n):

sum = 0

for k in range(i):

sum += (L[i][k] * U[k][j])

U[i][j] = A[i][j] - sum

for j in range(i, n):

if i == j:

L[j][i] = 1

else:

sum = 0

for k in range(i):

sum += (L[j][k] * U[k][i])

if U[i][i] == 0:

raise ValueError("矩阵不可逆")

L[j][i] = (A[j][i] - sum) / U[i][i]

return L, U

```

参数说明:

- `A`: 必须是方阵且行列式不为0。

LU分解在数值分析中常用于求解线性方程组,并且在计算过程中更加稳定。

#### 2.3.2 QR分解与最小二乘法

QR分解是将一个矩阵分解成一个正交矩阵(Q)和一个上三角矩阵(R)。QR分解在求解最小二乘问题上十分有用,因为它可以将非方阵或者不适定问题转化为方程求解问题。

QR分解的代码示例:

```python

import numpy as np

def qr_decomposition(A):

# 这里直接使用NumPy库中的qr函数来计算

Q, R = np.linalg.qr(A)

return Q, R

```

参数说明:

- `A`: 输入矩阵。

QR分解在工程和统计学中的应用非常广泛,特别是在最小二乘问题的求解中。

#### 2.3.3 奇异值分解(SVD)案例分析

奇异值分解(SVD)可以将任意矩阵分解为三个特定矩阵的乘积,这些矩阵分别是左奇异矩阵(U)、奇异值矩阵(Σ)和右奇异矩阵(V^T)。SVD是机器学习和数据分析中极为重要的工具,它在数据压缩、图像处理以及很多其他领域都有应用。

奇异值分解的代码示例:

```python

import numpy as np

def singular_value_decomposition(A):

U, s, VT = np.linalg.svd(A, full_matrices=False)

# S是只包含奇异值的对角矩阵

S = np.diag(s)

return U, S, VT

```

参数说明:

- `A`: 输入矩阵。

SVD在图像处理领域的应用非常广泛,例如在进行图像压缩时,可以移除较小的奇异值来降低数据量,同时尽量保留图像信息。

通过上面的分解技术,我们可以从不同角度深入理解矩阵的结构和性质,这在处理复杂数据和解决高维问题时,显得尤其重要和实用。

# 3. 线性方程组的解法与应用

## 3.1 直接解法

### 3.1.1 高斯消元法的原理与实现

高斯消元法是解决线性方程组中最基本的直接解法之一。该方法通过一系列行操作将线性方程组的系数矩阵转换为行阶梯形式或简化行阶梯形式,从而便于求解未知数。在行阶梯形式中,每个非零行的首项(即主元)位于前一个非零行主元的右侧,而简化行阶梯形式则进一步将所有主元化为1,并消除了所有主元下方的元素。

以下是高斯消元法的步骤:

1. 从第一个方程开始,用该方程的第一个非零元素作为主元,并用它来消除下面所有列中相应的元素。

2. 移至下一个非零行,重复上一步骤,直到整个矩阵被转换成行阶梯形式。

3. 通过回代过程(从最后一个方程开始,逐步向上求解)得到所有的未知数解。

让我们用一个简单的例子来说明这个过程:

假设有一个线性方程组:

```

x + 2y + 3z = 9

2x + 3y + 4z = 14

3x + 4y + 5z = 21

```

其对应的增广矩阵为:

```

[1 2 3 | 9]

[2 3 4 | 14]

[3 4 5 | 21]

```

首先,用第一行消去第二行和第三行的第一列元素:

```

[1 2 3 | 9]

[0 -1 -2 | -4]

[0 -2 -4 | -6]

```

接下来,用第二行消去第三行的第二列元素:

```

[1 2 3 | 9]

[0 -1 -2 | -4]

[0 0 0 | 0]

```

现在我们得到了一个行阶梯形式的矩阵,可以通过回代法解出 z 的值,然后解出 y 和 x。

代码实现高斯消元法如下:

```python

import numpy as np

def gaussian_elimination(A, b):

rows, cols = A.shape

# 构造增广矩阵

Ab = np.hstack((A, b.reshape(-1, 1)))

for i in range(rows):

# 将主元所在行与当前行交换

max_row = np.argmax(np.abs(Ab[i:, i])) + i

Ab[[i, max_row]] = Ab[[max_row, i]]

# 如果主元为0,则交换失败,矩阵不可逆

if Ab[i, i] == 0:

raise ValueError("Matrix is not invertible")

# 将主元上方的元素置零

for j in range(i+1, rows):

factor = Ab[j, i] / Ab[i, i]

Ab[j] -= factor * Ab[i]

# 回代求解

x = np.zeros(rows)

for i in range(rows-1, -1, -1):

x[i] = (Ab[i, -1] - np.dot(Ab[i, i+1:cols-1], x[i+1:])) / Ab[i, i]

return x

# 示例矩阵

A = np.array([[1, 2, 3], [2, 3, 4], [3, 4, 5]])

b = np.array([9, 14, 21])

# 使用高斯消元法求解线性方程组

x = gaussian_elimination(A, b)

print("Solution:", x)

```

在上述代码中,函数 `gaussian_elimination` 实现了高斯消元法,它首先构造了增广矩阵,并在保持矩阵上三角性质的同时进行行操作。最终通过回代计算出解向量 `x`。

### 3.1.2 高斯-约当消元法详解

高斯-约当消元法是高斯消元法的一个变种,其核心思想是使用行操作将系数矩阵转换为对角形式,这使得解线性方程组变得更加直观和高效。在高斯-约当消元法中,每个主元下方的元素都是0,且每个主元本身都是1。这种形式的矩阵称为简化对角矩阵。

高斯-约当消元法的步骤如下:

1. 使用高斯消元法将系数矩阵转换为行阶梯形式。

2. 通过行操作,使主元上方的元素变为0,主元变为1。

使用同样的例子,我们展示如何使用高斯-约当消元法求解线性方程组:

```

x + 2y + 3z = 9

2x + 3y + 4z = 14

3x + 4y + 5z = 21

```

对应增广矩阵:

```

[1 2 3 | 9]

[2 3 4 | 14]

[3 4 5 | 21]

```

我们已经通过高斯消元得到行阶梯形式:

```

[1 2 3 | 9]

[0 -1 -2 | -4]

[0 0 0 | 0]

```

接下来,我们将主元所在行除以主元值,使主元变成1:

```

[1 2 3 | 9]

[0 1 2 | 2]

[0 0 0 | 0]

```

然后,我们利用主元所在的列来消除下方行中对应的元素:

```

[1 0 1 | 1]

[0 1 2 | 2]

[0 0 0 | 0]

```

最终,我们得到对角矩阵,并可以通过直接观察得到解:x = 1, y = 2, z = 1。

注意,高斯-约当消元法通常不如高斯消元法那样受到青睐,因为它涉及的计算更多,但其直接解出未知数的优点使其在某些情况下更具吸引力。

下面是高斯-约当消元法的代码实现:

```python

def gauss_jordan_elimination(A, b):

rows, cols = A.shape

Ab = np.hstack((A, b.reshape(-1, 1)))

for i in range(rows):

# 将主元所在行与当前行交换

max_row = np.argmax(np.abs(Ab[i:, i])) + i

Ab[[i, max_row]] = Ab[[max_row, i]]

# 如果主元为0,则交换失败,矩阵不可逆

if Ab[i, i] == 0:

raise ValueError("Matrix is not invertible")

# 将主元上方的元素置零

for j in range(rows):

if j != i:

factor = Ab[j, i] / Ab[i, i]

Ab[j] -= factor * Ab[i]

# 前向替换求解

x = np.zeros(rows)

for i in range(rows):

x[i] = Ab[i, -1] / Ab[i, i]

return x

# 示例矩阵

A = np.array([[1, 2, 3], [2, 3, 4], [3, 4, 5]])

b = np.array([9, 14, 21])

# 使用高斯-约当消元法求解线性方程组

x = gauss_jordan_elimination(A, b)

print("Solution:", x)

```

在代码中,函数 `gauss_jordan_elimination` 完成了高斯-约当消元法的实现,它通过迭代地消除主元上方的元素并使主元变为1来构建对角矩阵,然后通过前向替换得到最终解。

# 4. 特征值问题的求解与分析

## 4.1 特征值和特征向量的计算

特征值和特征向量是线性代数中极为重要的概念,在数据分析、量子力学、机器学习等多个领域都有广泛的应用。理解并掌握计算特征值和特征向量的方法是解决实际问题的关键。

### 4.1.1 幂法和反幂法

幂法是一种用来估计矩阵主特征值及其对应特征向量的迭代方法。基本思想是通过迭代乘以矩阵的操作来收敛于最大特征值和对应的特征向量。以下是一个简单的幂法实现的代码示例:

```python

import numpy as np

def power_iteration(A, num_iterations: int = 100, tolerance: float = 1e-9):

n = A.shape[0]

# 随机初始化向量

b_k = np.random.rand(n)

for _ in range(num_iterations):

# 计算矩阵乘以向量的结果

b_k1 = np.dot(A, b_k)

# 重新规范化向量

b_k1_norm = np.linalg.norm(b_k1)

b_k = b_k1 / b_k1_norm

# Rayleigh商计算特征值近似值

rayleigh_quotient = np.dot(b_k.T, np.dot(A, b_k)) / np.dot(b_k.T, b_k)

return rayleigh_quotient, b_k

# 示例矩阵

A = np.array([[0.8, 0.2], [0.3, 0.7]])

# 运行幂法

eigenvalue, eigenvector = power_iteration(A)

print("特征值近似值:", eigenvalue)

print("对应的特征向量:", eigenvector)

```

在这个代码块中,我们通过不断迭代将向量与矩阵相乘,并每次迭代后规范化,来寻找最大特征值对应的特征向量。通过Rayleigh商计算特征值的近似值是幂法的一个常用技巧。

反幂法与幂法类似,主要用于找到最小的特征值。反幂法通过求解一个与原矩阵密切相关的方程组来逼近最小特征值。

### 4.1.2 雅可比方法和Givens变换

雅可比方法和Givens变换是寻找矩阵所有特征值的另一种有效算法。雅可比方法通过一系列的旋转矩阵来迭代地使矩阵变为对角矩阵,对角线上的元素即为特征值。而Givens变换则是实现这一旋转的基本工具。

雅可比方法的Python实现较为复杂,通常涉及到多层循环和条件判断。然而,其核心思路在于通过一系列的旋转消除矩阵的非对角元素,使得矩阵对角化。

Givens变换利用正交矩阵来旋转坐标系,从而使得两个特定的向量对应项为零,而剩余的元素保持不变。这对于特征值的计算和特征向量的求解都至关重要。

## 4.2 主成分分析(PCA)

### 4.2.1 PCA的数学原理

主成分分析(PCA)是一种统计技术,通过线性变换将一组可能相关的变量转换为一组线性不相关的变量,这些变量称为主成分。PCA寻找数据的内在结构,以此减少数据的维度,同时保留原始数据集的变异性。

PCA的数学原理包括对数据的协方差矩阵进行特征分解,然后选择最大的特征值对应的特征向量作为主成分。下面是一个简化的PCA实现示例:

```python

from sklearn.decomposition import PCA

# 示例数据集

data = np.array([[1.1, 1.2], [2.1, 2.2], [3.1, 3.2], [4.1, 4.2]])

# PCA降维到1维

pca = PCA(n_components=1)

pca.fit(data)

# 输出主成分和方差解释量

print("主成分:", pca.components_)

print("解释的方差比例:", pca.explained_variance_ratio_)

# 变换数据到主成分空间

reduced_data = pca.transform(data)

print("降维后的数据:", reduced_data)

```

### 4.2.2 PCA在数据降维中的应用

PCA常用于图像处理、机器学习和模式识别等领域。它帮助我们在降维的同时尽量保留数据的主要信息。例如,在图像处理中,PCA可以用来减少数据集中的特征数量,同时仍然保留大部分的图像信息。

## 4.3 线性变换与应用

### 4.3.1 线性变换的概念与性质

线性变换是在向量空间之间的一种映射,它保持向量的加法和数乘操作。线性变换在图像处理、计算机图形学和游戏开发中有着广泛的应用。例如,仿射变换就是线性变换的一个特例,包括缩放、旋转、剪切和投影等操作。

### 4.3.2 线性变换在图形学中的应用案例

在计算机图形学中,线性变换可以用来渲染三维场景中的对象。例如,使用矩阵乘法来实现三维空间中的对象旋转、平移和缩放。在WebGL编程中,通过矩阵来定义视图、模型和投影变换是渲染三维对象的标准方法之一。

```javascript

// 假设在WebGL中使用JavaScript定义一个4x4矩阵

var modelViewProjectionMatrix = new Float32Array([

1.0, 0.0, 0.0, 0.0,

0.0, 1.0, 0.0, 0.0,

0.0, 0.0, 1.0, 0.0,

0.0, 0.0, 0.0, 1.0

]);

// 应用旋转变换

// 旋转矩阵围绕z轴旋转theta角度

var cosTheta = Math.cos(theta);

var sinTheta = Math.sin(theta);

modelViewProjectionMatrix[0] = cosTheta;

modelViewProjectionMatrix[1] = sinTheta;

modelViewProjectionMatrix[4] = -sinTheta;

modelViewProjectionMatrix[5] = cosTheta;

// 使用这个矩阵变换顶点坐标

// 顶点坐标vec4的变量形式

var vertex = vec4(x, y, z, 1.0);

var transformedVertex = vec4Multiply(modelViewProjectionMatrix, vertex);

```

在以上JavaScript代码段中,我们定义了一个4x4的模型视图投影矩阵,并应用了一个围绕z轴的旋转变换。然后使用变换矩阵来变换顶点坐标,这在渲染3D图形时非常常见。

以上内容的深入探讨,涉及到了特征值和特征向量的计算、PCA降维技术,以及线性变换在图形学中的应用案例,均遵循了由浅入深的内容展开,以及对目标人群的定位。通过上述章节内容的分析和代码示例,读者可以更深刻地理解线性代数在现代计算中的作用与应用。

# 5. 线性代数在现代技术中的应用

## 5.1 机器学习中的线性代数

线性代数是机器学习的数学基础之一,尤其在模型的构建、训练和预测等环节中扮演着至关重要的角色。在这一节中,我们将探讨线性代数如何在机器学习中发挥作用。

### 5.1.1 线性回归模型中的矩阵操作

线性回归模型是机器学习中最简单的预测模型之一,它的目标是找到自变量(特征)和因变量(标签)之间的线性关系。矩阵运算在此过程中有以下几个关键应用:

- **参数估计:** 使用最小二乘法求解参数,其核心是解决正规方程 `X^T Xβ = X^T y`,其中 `X` 是特征矩阵,`y` 是目标向量,`β` 是我们要找的参数向量。这里涉及到矩阵的转置和乘法运算。

- **预测:** 一旦我们有了参数向量 `β`,可以通过矩阵乘法 `Xβ` 进行预测。

让我们通过一个简单的Python示例来展示线性回归模型的矩阵操作:

```python

import numpy as np

# 创建一些样本数据

X = np.array([[1, 2], [3, 4], [5, 6], [7, 8]])

y = np.array([3, 4, 5, 6])

# 为了使用正规方程法,我们需要在X中增加一列1作为截距项

X = np.c_[np.ones(X.shape[0]), X]

# 计算参数β

beta = np.linalg.inv(X.T.dot(X)).dot(X.T).dot(y)

print(beta)

# 使用β进行预测

y_pred = X.dot(beta)

print(y_pred)

```

### 5.1.2 神经网络的权重矩阵分析

神经网络,尤其是深度学习模型,使用了大量的矩阵运算来计算层间的连接。权重矩阵的每一行可以看作是上一层神经元与下一层神经元之间的连接强度。在前向传播和反向传播过程中,矩阵运算用于更新这些权重。

- **前向传播:** 权重矩阵与输入数据相乘,加上偏置后应用激活函数。

- **反向传播:** 误差通过链式法则计算梯度,并使用这些梯度来更新权重矩阵。

例如,一个简单的全连接层的前向传播可以表示为:

```python

def forward(X, W, b):

z = np.dot(X, W) + b

a = activation(z) # activation 是激活函数

return a

# 假设W是权重矩阵,b是偏置向量,X是输入数据

a = forward(X, W, b)

```

神经网络中的权重矩阵通常通过梯度下降算法及其变种(如Adam、RMSprop)更新。反向传播算法负责计算梯度,而矩阵运算则是这个过程的基石。

## 5.2 图像处理与矩阵

图像处理是另一个广泛利用线性代数的领域。图像可以被自然地表示为矩阵,其中每个元素代表像素的强度。

### 5.2.1 图像作为矩阵的表示

一张彩色图像可以表示为一个三维矩阵,其中两个维度表示像素位置(宽和高),第三个维度表示颜色通道(通常是RGB)。灰度图像则是一个二维矩阵。

### 5.2.2 矩阵运算在图像处理中的应用

在图像处理中,线性代数的矩阵运算用于执行各种操作,比如:

- **滤波:** 使用卷积矩阵对图像进行滤波处理,可以实现模糊、锐化等效果。

- **缩放:** 利用线性插值矩阵可以对图像进行大小缩放。

- **旋转:** 通过旋转矩阵对图像进行旋转。

- **色彩空间转换:** 如从RGB转换到HSV色彩空间等。

例如,一个简单的图像缩放可以使用线性代数中的插值方法实现:

```python

import scipy.ndimage

def resize_image(image, factor):

return scipy.ndimage.zoom(image, zoom=factor, order=1)

# 假设img是一个二维或三维的图像矩阵

resized_image = resize_image(img, factor=2)

```

## 5.3 量子计算中的线性代数

量子计算是当今科技领域最具前景的研究方向之一。量子位(qubits)和量子态都可以使用线性代数来表示和操作。

### 5.3.1 量子态的线性代数表示

量子态通常表示为复数向量,这些向量是归一化的,位于希尔伯特空间中。量子态之间的关系可以通过线性代数中的向量和矩阵来描述。

### 5.3.2 线性代数在量子算法中的角色

在量子算法中,量子门(操作)可以通过酉矩阵(unitary matrices)表示。量子计算机的运算实质上是在对量子态进行酉矩阵变换。

在经典模拟器中,我们可以通过计算量子门的矩阵乘法来模拟量子电路的行为:

```python

from qiskit.quantum_info import Operator

# 假设我们有一个量子门操作,这里是X门(量子非门)

X_gate = Operator([[0, 1], [1, 0]])

# 我们可以将其应用于量子态,例如 |0> 状态

initial_state = [1, 0]

final_state = X_gate.dot(initial_state)

print(final_state)

```

通过这些例子,我们可以看到线性代数是连接传统机器学习、图像处理与现代量子计算技术的纽带。在这些领域,矩阵运算不仅是基本工具,也是推动技术进步的关键。在下一章节中,我们将探讨如何进一步优化这些矩阵运算,以提高效率和准确性。

0

0