C++编译器优化高级技巧:向量化和并行计算,性能的突破点

发布时间: 2024-10-21 13:15:54 阅读量: 35 订阅数: 46

C++性能优化:编译器优化、代码与算法优化及并行处理

# 1. C++编译器优化概述

在现代软件开发中,编译器优化是提升程序性能的关键一环。C++编译器优化通常涉及多个方面,包括基本的代码重构、死代码消除、循环优化等。优化的核心目的是减少执行时间、降低资源消耗并提高程序的响应速度。本章将对C++编译器优化进行概述,帮助开发者理解其基本原理,并为后续的深入讨论打下基础。

编译器优化通常分为两个层面:前端优化和后端优化。前端优化更多关注源代码级别的改进,比如循环展开和函数内联;而后端优化则主要关注目标代码的生成,涉及指令选择、寄存器分配等。开发者在编写代码时可能不会直接触及这些概念,但了解它们将有助于我们写出更易于编译器优化的代码。

```c++

// 示例代码块

// 编译器可能识别并优化循环中的加法操作

for (int i = 0; i < size; ++i) {

sum += array[i];

}

```

在上述例子中,编译器能够通过循环优化技术来减少指令的总数,从而加速循环执行。优化的实际效果和编译器的具体实现以及目标硬件平台紧密相关。为了充分利用编译器优化,开发者需要具备相关知识,以便在代码编写阶段就考虑优化的可能性。本章将为读者提供这一知识基础,从而为后续章节中更为深入的编译器优化技术奠定基础。

# 2. 向量化技术的理论与实践

## 2.1 向量化技术基础

### 2.1.1 向量化概念解析

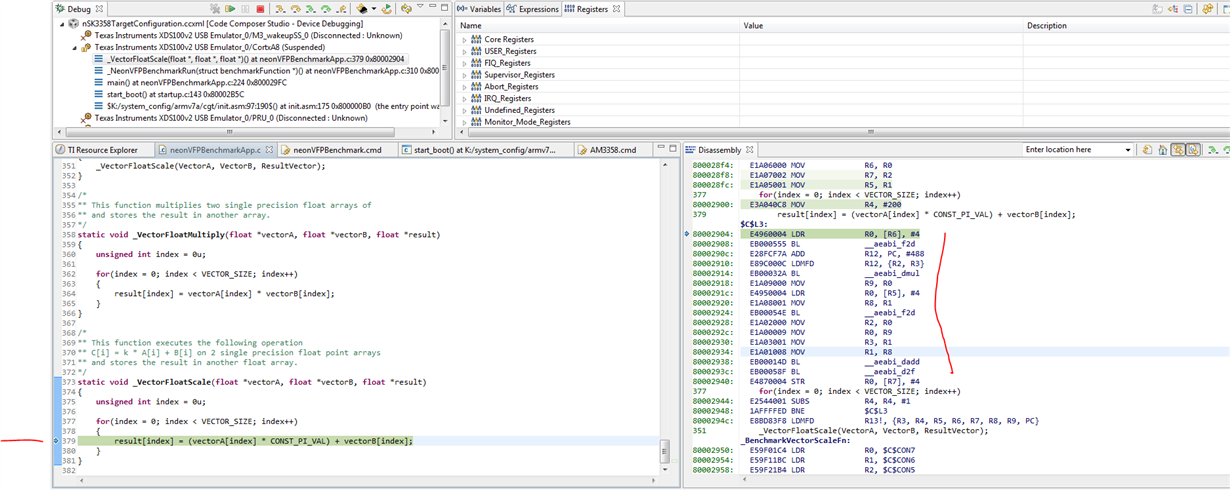

向量化是一种利用现代处理器的SIMD(单指令多数据)指令集来加速数据处理的技术。这种技术允许单个指令对多个数据点执行相同的操作,极大地提升了程序在处理大型数据集时的性能。在C++中,向量化可以应用于各种数值计算密集型的任务,比如矩阵乘法、图像处理和机器学习算法。

与传统逐个处理数据的方法相比,向量化通过减少循环迭代次数和利用专门的硬件加速指令来实现性能的提升。在多核处理器和GPU上,向量化可以有效地将工作负载分配给可用的计算单元。

### 2.1.2 硬件支持与SIMD指令集

现代CPU和GPU都配备了支持向量化操作的硬件功能。SIMD指令集如Intel的AVX、AVX2、AVX-512和ARM的Neon等,为向量化编程提供了基础支持。这些指令集在硬件级别实现了对向量化操作的优化,能够处理128位、256位甚至512位宽的数据包。

开发者可以在C++中通过内嵌汇编代码或者使用编译器支持的向量化特性来利用这些指令集。随着硬件的进步,向量化技术变得越来越重要,因为硬件厂商在设计新处理器时会不断增加对并行计算的支持。

## 2.2 向量化编程技术

### 2.2.1 编译器自动向量化

编译器的自动向量化功能可以在无需开发者直接编写SIMD代码的情况下,自动将某些循环转换为向量化操作。这一功能依赖于编译器的优化算法,其能够识别可以向量化的代码区域并应用相应的指令集。

为了使编译器能够更好地进行自动向量化,开发者需要保证代码遵循特定的准则,比如循环中不包含依赖项和分支跳转。自动向量化的工作很大程度上取决于编译器的能力以及源代码的特性。

### 2.2.2 手动向量化操作

手动向量化涉及到直接使用SIMD指令集编程。尽管这种方法提供了对性能的完全控制,但它需要开发者具备对特定硬件架构的深入了解。手动向量化可以通过内嵌汇编代码或者使用编译器的向量扩展功能(例如Intel的Intrinsics)来实现。

手动向量化能够实现更细粒度的优化,但同时也增加了代码的复杂性和维护成本。因此,开发者需要权衡自动向量化与手动向量化之间的优劣。

### 2.2.3 向量化优化案例分析

让我们考虑一个简单的数组求和的函数,首先展示其原始实现:

```c++

void sum_arrays(float* a, float* b, float* c, size_t n) {

for (size_t i = 0; i < n; ++i) {

c[i] = a[i] + b[i];

}

}

```

在C++11及以上版本,可以使用`std::transform`和`std::plus`来重写此函数:

```c++

#include <algorithm>

#include <vector>

#include <iterator>

std::vector<float> sum_arrays(const std::vector<float>& a, const std::vector<float>& b) {

std::vector<float> c(a.size());

std::transform(a.begin(), a.end(), b.begin(), c.begin(), std::plus<float>());

return c;

}

```

如果编译器支持并能够自动向量化上述代码,那么它将对性能有显著提升。然而,对于更复杂的操作或者特定的硬件平台,可能需要手动向量化,比如使用Intel的Intrinsics:

```c++

#include <immintrin.h>

void sum_arrays_simd(float* a, float* b, float* c, size_t n) {

__m256 va, vb, vc;

size_t i;

for (i = 0; i <= n - 8; i += 8) {

va = _mm256_loadu_ps(&a[i]);

vb = _mm256_loadu_ps(&b[i]);

vc = _mm256_add_ps(va, vb);

_mm256_storeu_ps(&c[i], vc);

}

for (; i < n; ++i) {

c[i] = a[i] + b[i];

}

}

```

这段代码使用了AVX指令集对8个浮点数进行并行加法。需要注意的是,手动向量化通常需要更多的调试工作以及对平台特异性的处理。

## 2.3 向量化编程实践

### 2.3.1 循环向量化技巧

循环向量化是向量化技术中最常见的应用。在循环中,每次迭代处理的数据需要能够独立于其它迭代,不产生数据依赖。这意味着循环体内的操作必须是可交换的,且没有副作用。

一个典型的循环向量化技巧是将循环展开。循环展开可以减少迭代次数,这样就有更多的机会利用SIMD指令集来处理数据。然而,这种方法可能会使代码变得更复杂,并需要开发者手动管理循环的边界情况。

### 2.3.2 数据对齐与内存访问模式

为了利用SIMD指令集进行高效的数据处理,数据必须按照特定的对齐方式存储在内存中。大多数SIMD指令集要求数据对齐到16字节或32字节边界。这意味着,为了向量化,数据可能需要在使用前进行重新对齐。

内存访问模式也对性能有着极大的影响。连续内存访问可以最大化利用缓存,并提高数据预取的效果。开发者在设计数据结构和算法时,应尽可能考虑数据的内存布局。

### 2.3.3 性能测试与结果分析

性能测试是验证向量化优化效果的必要手段。开发者可以通过基准测试来测量优化前后的性能变化。测试工具如Google Benchmark、Intel VTune等可以用来进行精确的性能分析。

在分析结果时,开发者应关注执行时间的减少、CPU使用率的提升以及缓存命中率的变化。性能测试结果不仅提供量化的指标,而且还能帮助开发者发现潜在的瓶颈和优化点。

在本章节中,我们详细探讨了向量化技术的理论基础,实践技巧,以及如何进行性能测试与分析。在下一章中,我们将转向并行计算技术,这是另一种提升程序性能的重要手段。

# 3. 并行计算的理论与实践

在本章中,我们将深入探讨并行计算的理论基础,并通过实践案例分析来阐述如何在现代多核处理器上进行有效的并行编程。我们将从并行计算的基本原理讲起,逐步过渡到具体的多线程编程技术,最后通过并行编程实践来展示如何实现算法的优化,并对性能结果进行分析。

## 3.1 并行计算原理

并行计算的核心在于同时使用多个计算资源解决计算问题,以缩短求解时间。本节将从并行计算模型和线程与进程的概念两个方面展开。

### 3.1.1 并行计算模型

并行计算模型提供了一种理论框架,用于指导如何将复杂的计算任务分解成可以在多个处理单元上并行执行的部分。常见的并行计算模型包括数据并行、任务并行和流水线并行。数据并行强调对大规模数据集进行相同的操作,而任务并行侧重于将不同任务分配给不同的处理器执行。流水线并行则涉及将一个复杂的处理过程分成若干阶段,每个阶段由不同的处理器处理。每种模型都有其适用场景和优缺点,理解这些模型是设计高效并行算法的关键。

### 3.1.2 线程与进程的概念

在并行计算中,线程是操作系统能够进行运算调度的最小单位,而进程则是系统进行资源分配和调度的一个独立单位。每个进程可以包含一个或多个线程,线程之间共享进程的资源,但也有自己的执行栈和程序计数器。在并行编程中,合理地创建和管理线程是提高程序性能和响应速度的关键。通过创建多个线程,可以在多核处理器上同时执行多个任务,从而提升程序的执行效率。

## 3.2 多线程编程技术

C++11标准引入了强大的多线程库,为编写并行程序提供了丰富的工具。在本节中,我们将讨论如何利用这些工具进行有效的多线程编程。

### 3.2.1 C++11中的线程库

C++11标准中引入了`<thread>`, `<mutex>`, `<condition_variable>`等头文件,提供了创建线程、同步机制和条件变量等基本功能。我们可以利用这些组件构建复杂的并行算法。例如,使用`std::thread`来创建新的线程,并通过`std::mutex`和`std::lock_guard`等实现线程间的同步。

```cpp

#include <thread>

#include <iostream>

#include <mutex>

std::mutex mtx; // 用于同步的互斥锁

int counter = 0;

void function_1() {

for (int i = 0; i < 10000; ++i) {

std::lock_guard<std::mutex> lock(mtx); // 上锁

++counter;

}

}

void function_2() {

for (int i = 0; i < 10000; ++i) {

```

0

0